信息论与编码理论习题 答案 LG GROUP system office room 【LGA16H-LGYY-LGUA8Q8-LGA162】

第二章 信息量和熵 八元编码系统,码长为3,第一个符号用于同步,每秒1000个码字,求它的信息速 率。 解:同步信息均相同,不含信息,因此 每个码字的信息量为 2?8log =2?3=6 bit 因此,信息速率为 6?1000=6000 bit/s 掷一对无偏骰子,告诉你得到的总的点数为:(a) 7; (b) 12。问各得到多少信息 量。 解:(1) 可能的组合为 {1,6},{2,5},{3,4},{4,3},{5,2},{6,1} )(a p =366=6 1 得到的信息量 =) (1 log a p =6log = bit (2) 可能的唯一,为 {6,6} )(b p =361 得到的信息量=) (1 log b p =36log = bit 经过充分洗牌后的一副扑克(52张),问: (a) 任何一种特定的排列所给出的信息量是多少? (b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量? 解:(a) )(a p =! 521 信息量=) (1 log a p =!52log = bit (b) ? ??????花色任选种点数任意排列 13413!13 )(b p =13 52134!13A ?=1352 13 4C 信息量=1313 52 4log log -C = bit 随机掷3颗骰子,X 表示第一颗骰子的结果,Y 表示第一和第二颗骰子的点数之和, Z 表示3颗骰子的点数之和,试求)|(Y Z H 、)|(Y X H 、),|(Y X Z H 、 )|,(Y Z X H 、)|(X Z H 。

各章参考答案 2.1. (1)4.17比特 ;(2)5.17比特 ; (3)1.17比特 ;(4)3.17比特 2.2. 1.42比特 2.3. (1)225.6比特 ;(2)13.2比特 2.4. (1)24.07比特; (2)31.02比特 2.5. (1)根据熵的可加性,一个复合事件的平均不确定性可以通过多次实验逐步解除。如果我们使每次实验所获得的信息量最大。那么所需要的总实验次数就最少。用无砝码天平的一次称重实验结果所得到的信息量为log3,k 次称重所得的信息量为klog3。从12个硬币中鉴别其中的一个重量不同(不知是否轻或重)所需信息量为log24。因为3log3=log27>log24。所以在理论上用3次称重能够鉴别硬币并判断其轻或重。每次实验应使结果具有最大的熵。其中的一个方法如下:第一次称重:将天平左右两盘各放4枚硬币,观察其结果:①平衡 ②左倾 ③右倾。ⅰ)若结果为①,则假币在未放入的4枚币,第二次称重:将未放入的4枚中的3枚和已称过的3枚分别放到左右两盘,根据结果可判断出盘中没有假币;若有,还能判断出轻和重,第三次称重:将判断出含有假币的三枚硬币中的两枚放到左右两盘中,便可判断出假币。ⅱ)若结果为②或③即将左盘中的3枚取下,将右盘中的3枚放到左盘中,未称的3枚放到右盘中,观察称重砝码,若平衡,说明取下的3枚中含假币,只能判出轻重,若倾斜方向不变,说明在左、右盘中未动的两枚中其中有一枚为假币,若倾斜方向变反,说明从右盘取过的3枚中有假币,便可判出轻重。 (2)第三次称重 类似ⅰ)的情况,但当两个硬币知其中一个为假,不知为哪个时, 第三步用一个真币与其中一个称重比较即可。 对13个外形相同的硬币情况.第一次按4,4,5分别称重,如果假币在五个硬币的组里,则鉴 别所需信息量为log10>log9=2log3,所以剩下的2次称重不能获得所需的信息. 2.6. (1)215 log =15比特; (2) 1比特;(3)15个问题 2. 7. 证明: (略) 2.8. 证明: (略) 2.9. 31)(11= b a p ,121 )(21=b a p , 121 )(31= b a p , 61)()(1312= =b a b a p p , 241)()()()(33233222= ===b a b a b a b a p p p p 。 2.10. 证明: (略) 2.11. 证明: (略)

1. 有一个马尔可夫信源,已知p(x 1|x 1)=2/3,p(x 2|x 1)=1/3,p(x 1|x 2)=1,p(x 2|x 2)=0,试画出该信源的香农线图,并求出信源熵。 解:该信源的香农线图为: 1/3 ○ ○ 2/3 (x 1) 1 (x 2) 在计算信源熵之前,先用转移概率求稳定状态下二个状态x 1和 x 2 的概率)(1x p 和)(2x p 立方程:)()()(1111x p x x p x p =+)()(221x p x x p =)()(2132x p x p + )()()(1122x p x x p x p =+)()(222x p x x p =)(0)(2131x p x p + )()(21x p x p +=1 得4 3 1)(=x p 4 12)(=x p 马尔可夫信源熵H = ∑∑- I J i j i j i x x p x x p x p )(log )()( 得 H=0.689bit/符号 2.设有一个无记忆信源发出符号A 和B ,已知4 341)(.)(= =B p A p 。求: ①计算该信源熵; ②设该信源改为发出二重符号序列消息的信源,采用费诺编码方法,求其平均信息传输速率; ③又设该信源改为发三重序列消息的信源,采用霍夫曼编码方法,求其平均信息传输速率。 解:①∑- =X i i x p x p X H )(log )()( =0.812 bit/符号 ②发出二重符号序列消息的信源,发出四种消息的概率分别为 用费诺编码方法 代码组 b i BB 0 1 BA 10 2 AB 110 3 AA 111 3 无记忆信源 624.1)(2)(2 ==X H X H bit/双符号 平均代码组长度 2B =1.687 bit/双符号 B X H R )(22==0.963 bit/码元时间 ③三重符号序列消息有8个,它们的概率分别为 用霍夫曼编码方法 代码组 b i BBB 64 27 0 0 1 BBA 64 9 0 )(6419 1 110 3

一填空题 1、平均自信息为 表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。 平均互信息 表示从Y 获得的关于每个X 的平均信息量,也表示发X 前后Y 的平均不确定性减少的量,还表示通信前 后整个系统不确定性减少的量。 2、最大离散熵定理为:离散无记忆信源,等概率分布时熵最大,最大熵值为。 3、香农公式为 为保证足够大的信道容量,可采用(1)用频带换信噪比; (2)用信噪比换频带。 4、只要,当N 足够长时,一定存在一种无失真编码。 5、当R <C 时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。 6、1948年,美国数学家 香农 发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。 7.人们研究信息论的目的是为了 高效、可靠、安全 地交换和利用各种各样的信息。 8.信息的 可度量性 是建立信息论的基础。 9.统计度量 是信息度量最常用的方法。 10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用 随机矢量 描述。 11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为 其发生概率对数的负值 。 12、自信息量的单位一般有 比特、奈特和哈特 。 13、必然事件的自信息是 0 。 14、不可能事件的自信息量是 ∞ 。 15、两个相互独立的随机变量的联合自信息量等于 两个自信息量之和 。 16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量 趋于变小 。 17、离散平稳无记忆信源X 的N 次扩展信源的熵等于离散信源X 的熵的 N 倍 。 18、离散平稳有记忆信源的极限熵,=∞H )/(lim 121-∞→N N N X X X X H 。 19、对于n 元m 阶马尔可夫信源,其状态空间共有 n m 个不同的状态。 20、一维连续随即变量X 在[a ,b]区间内均匀分布时,其信源熵为 log2(b-a ) 。

第一章 信息、消息、信号的定义?三者的关系? 通信系统的模型?各个主要功能模块及作用? 第二章 信源的分类? 自信息量、条件自信息量、平均自信息量、信源熵、不确定度、条件熵、疑义度、噪声熵、联合熵、互信息量、条件互信息量、平均互信息量以及相对熵的概念?计算方法? 冗余度? 具有概率为)(x i p 的符号x i 自信息量:)(log )(x x i i p I -= 条件自信息量:)(log )( y x y x i i i i p I -= 平均自信息量、平均不确定度、信源熵:∑-=i i i x x p p X H )(log )()( 条件熵:)(log ),()(),()(y x y x y x y x j i j ij i j i j ij i p p I p Y X H ∑∑-== 联合熵:),(log ),(),(),()(y x y x y x y x j i j ij i j i j ij i p p I p Y X H ∑∑-== 互信息:) ()(log )()() ()(log ),();(y x y x y x y x y y x j i j i j ij i j i j j ij i p p p p p p p Y X I ∑∑= = 熵的基本性质:非负性、对称性、确定性 2.3 同时掷出两个正常的骰子,也就是各面呈现的概率都为1/6,求: (1) “3和5同时出现”这事件的自信息; (2) “两个1同时出现”这事件的自信息; (3) 两个点数的各种组合(无序)对的熵和平均信息量; (4) 两个点数之和(即2, 3, … , 12构成的子集)的熵; (5) 两个点数中至少有一个是1的自信息量。 解:(1) bit x p x I x p i i i 170.418 1 log )(log )(18 1 61616161)(=-=-== ?+?= (2) bit x p x I x p i i i 170.536 1 log )(log )(361 6161)(=-=-== ?=

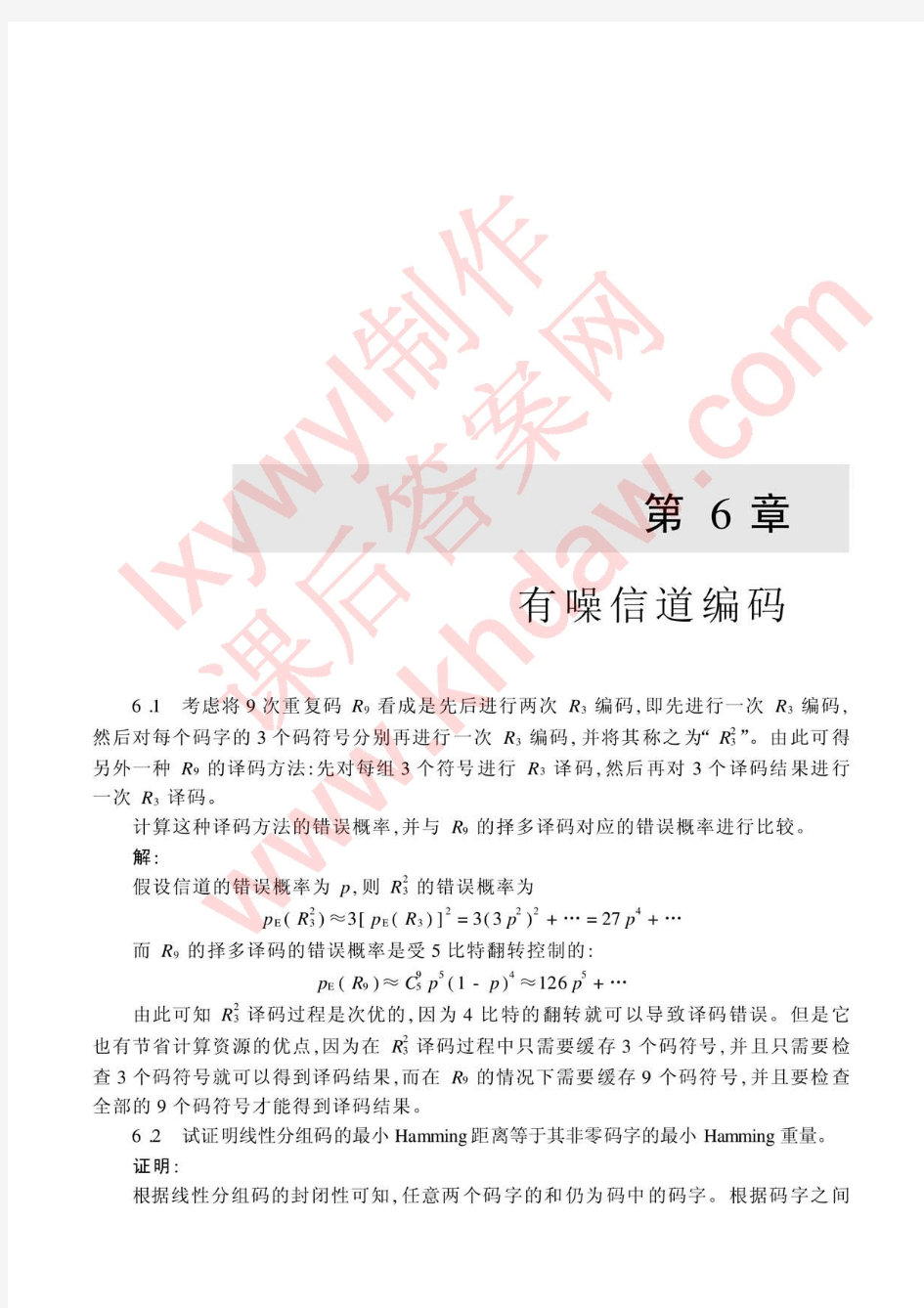

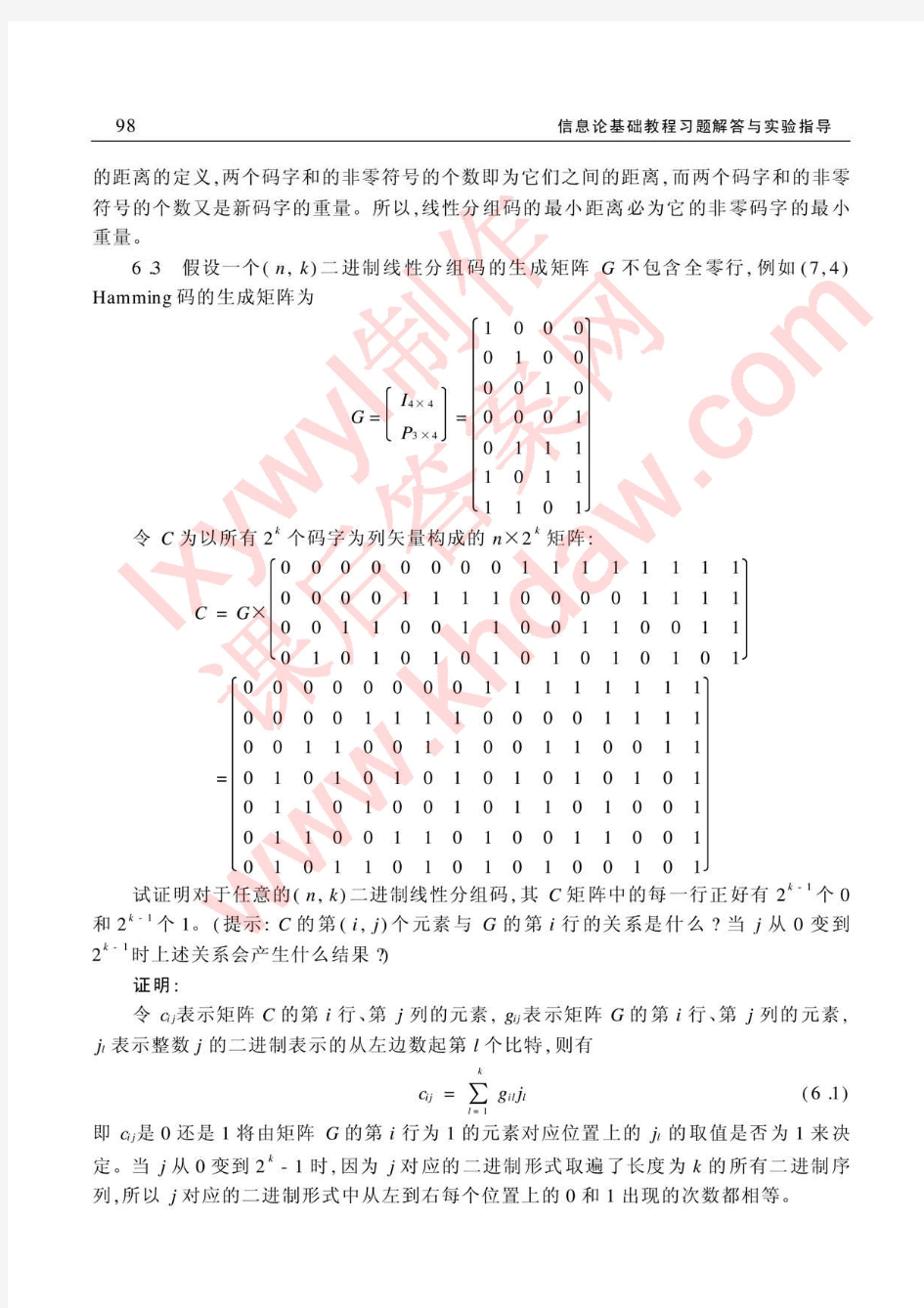

一、填空题 1.设信源X 包含4个不同离散消息,当且仅当X 中各个消息出现的概率为___Pi=1/4___时,信源熵达到最大值,为__2bit_,此时各个消息的自信息量为____2bit_______。 2.如某线性分组码的最小汉明距dmin=4,则该码最多能检测出___3_____个随机错,最多能 纠正___INT__个随机错。 3.克劳夫特不等式是唯一可译码___存在___的充要条件。 4.平均互信息量I(X;Y)与信源熵和条件熵之间的关系是_I (X :Y )=H (X )-H (X/Y ) 5.__信源__编码的目的是提高通信的有效性,_信道_编码的目的是提高通信的可靠性,__ 加密__编码的目的是保证通信的安全性。 6.信源编码的目的是提高通信的 有效性 ,信道编码的目的是提高通信的 可靠性 ,加密 编码的目的是保证通信的 安全性 。 7.设信源X 包含8个不同离散消息,当且仅当X 中各个消息出现的概率为__1/8_____时,信 源熵达到最大值,为___3bit/符号_________。 8.自信息量表征信源中各个符号的不确定度,信源符号的概率越大,其自信息量越__小____。 9.信源的冗余度来自两个方面,一是信源符号之间的_相关性__,二是信源符号分布的 __不均匀性___。 10.最大后验概率译码指的是 译码器要在已知r 的条件下找到可能性最大的发码Ci 作为移 码估值 。 11.常用的检纠错方法有__前向纠错__、反馈重发和混合纠错三种。 二、单项选择题 1.下面表达式中正确的是( A )。 A. ∑=j i j x y p 1)/( B.∑=i i j x y p 1)/( C.∑=j j j i y y x p )(),(ω D.∑=i i j i x q y x p )(),( 2.彩色电视显像管的屏幕上有5×105 个像元,设每个像元有64种彩色度,每种彩度又有 16种不同的亮度层次,如果所有的彩色品种和亮度层次的组合均以等概率出现,并且各个 组合之间相互独立。每秒传送25帧图像所需要的信道容量( C )。 A. 50106 B. 75106 C. 125106 D. 250106

《信息论基础》试卷第1页 《信息论基础》试卷答案 一、填空题(共25分,每空1分) 1、连续信源的绝对熵为 无穷大。(或()()lg lim lg p x p x dx +∞-∞ ?→∞ --?? ) 2、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到 1 。 3、无记忆信源是指 信源先后发生的符号彼此统计独立 。 4、离散无记忆信源在进行无失真变长编码时,码字长度是变化的。根据信源符号的统计特性,对概率大的符号用 短 码,对概率小的符号用 长 码,这样平均码长就可以降低,从而提高 有效性(传输速率或编码效率) 。 5、为了提高系统的有效性可以采用 信源编码 ,为了提高系统的可靠性可以采用 信道编码 。 6、八进制信源的最小熵为 0 ,最大熵为 3bit/符号 。 7、若连续信源输出信号的平均功率为1瓦特,则输出信号幅度的概率密度函数为 高斯分布(或()0,1x N 2 2 x - )时,信源具有最大熵,其值为 0.6155hart(或 1.625bit 或 1lg 22 e π)。 8、即时码是指 任一码字都不是其它码字的前缀 。 9、无失真信源编码定理指出平均码长的理论极限值为 信源熵(或H r (S)或()lg H s r ),此 时编码效率为 1 ,编码后的信息传输率为 lg r bit/码元 。 10、一个事件发生的概率为0.125,则自信息量为 3bit/符号 。 11、信源的剩余度主要来自两个方面,一是 信源符号间的相关性 ,二是 信源符号概率分布的不均匀性 。 12、m 阶马尔可夫信源的记忆长度为 m+1 ,信源可以有 q m 个不同的状态。 13、同时扔出一对均匀的骰子,当得知“两骰子面朝上点数之和为2”所获得的信息量为 lg36=5.17 比特,当得知“面朝上点数之和为8”所获得的信息量为 lg36/5=2.85 比特。 14.在下面空格中选择填入的数学符号“=,≥,≤,>”或“<” H(XY) = H(Y)+H(X ∣Y) ≤ H(Y)+H(X)

信息论与编码理论习题解 第二章-信息量和熵 解: 平均每个符号长为:154 4.0312.032= ?+?秒 每个符号的熵为9183.03log 3 1 23log 32=?+?比特/符号 所以信息速率为444.34 15 9183.0=?比特/秒 解: 同步信号均相同不含信息,其余认为等概, 每个码字的信息量为 3*2=6 比特; 所以信息速率为600010006=?比特/秒 解:(a)一对骰子总点数为7的概率是 36 6 所以得到的信息量为 585.2)366(log 2= 比特 (b) 一对骰子总点数为12的概率是36 1 所以得到的信息量为 17.536 1 log 2= 比特 解: (a)任一特定排列的概率为 ! 521 ,所以给出的信息量为 58.225! 521 log 2 =- 比特 (b) 从中任取13张牌,所给出的点数都不相同的概率为 1352 13 13 521344!13C A =? 所以得到的信息量为 21.134 log 1313 52 2=C 比特. 解:易证每次出现i 点的概率为 21 i ,所以

比特比特比特比特比特比特比特398.221 log 21)(807.1)6(070.2)5(392.2)4(807.2)3(392.3)2(392.4)1(6,5,4,3,2,1,21 log )(26 12=-==============-==∑ =i i X H x I x I x I x I x I x I i i i x I i 解: 可能有的排列总数为 27720! 5!4!3! 12= 没有两棵梧桐树相邻的排列数可如下图求得, Y X Y X Y X Y X Y X Y X Y X Y 图中X 表示白杨或白桦,它有???? ??37种排法,Y 表示梧桐树可以栽 种的位置,它有???? ??58种排法,所以共有???? ??58*???? ??37=1960种排法保证没有 两棵梧桐树相邻,因此若告诉你没有两棵梧桐树相邻时,得到关于树排列的信息为1960log 27720log 22-= 比特 解: X=0表示未录取,X=1表示录取; Y=0表示本市,Y=1表示外地; Z=0表示学过英语,Z=1表示未学过英语,由此得

[例2.1.4 条件熵] 已知X ,Y }1,0{∈,XY 构成的联合概率为:p(00)=p(11)=1/8,p(01)=p(10)=3/8,计算条件熵H(X/Y)。 解: 根据条件熵公式: ∑∑==-=m j n i j i j i y x p y x p Y X H 112)/(log )()/( )() ()/(j j i j i y p y x p y x p = 首先求∑==2 1 )()(i j i j y x p y p ,有

) /(406 .0243log 8341log 8 1 ) 1/1(log )11() 0/1(log )10()1/0(log )01()0/0(log )00()/(, 4 3 )1/0()0/1() 1/1(41 2/18/1)0()00()0()00()0/0()0/0(2 1 )1()1(8 1 83)10()00()0()0(22222211111212111symbol bit p p p p p p p p Y X H p p p y p y x p p p y x p p y p p c y x p y x p y p p =???? ??--=-----============== ===+==+====从而有: 同理可求得[例2.1.5]将已知信源? ?? ???=? ??? ??5.05 .0)(21 x x X P X 接到下图所示的信道上,求在该信道上传输的平均互信息量I(X;Y)、疑义度H(X/Y)、噪声熵H(Y/X)和联合熵H(XY)。 1 x 0.98 1 y 0.02 0.2 2x 0.8 2 y

《信息论基础》答案 一、填空题(本大题共10小空,每小空1分,共20分) 1.按信源发出符号所对应的随机变量之间的无统计依赖关系,可将离散信源分为有记忆信源和无记忆信源两大类。 2.一个八进制信源的最大熵为3bit/符号 3.有一信源X ,其概率分布为1 23x x x X 1 11P 244?? ?? ? =?? ????? ,其信源剩余度为94.64%;若对该信源进行十次扩展,则每十个符号的平均信息量是 15bit 。 4.若一连续消息通过放大器,该放大器输出的最大瞬间电压为b ,最小瞬时电压为a 。若消息从放大器中输出,则该信源的绝对熵是∞;其能在每个自由度熵的最大熵是log (b-a )bit/自由度;若放大器的最高频率为F ,则单位时间内输出的最大信息量是 2Flog (b-a )bit/s. 5. 若某一 信源X ,其平均功率受限为16w ,其概率密度函数是高斯分布时,差熵的最大值为 1 log32e 2 π;与其熵相等的非高斯分布信源的功率为16w ≥ 6、信源编码的主要目的是提高有效性,信道编码的主要目的是提高可靠性。 7、无失真信源编码的平均码长最小理论极限制为信源熵(或H(S)/logr= H r (S))。 8、当R=C 或(信道剩余度为0)时,信源与信道达到匹配。 9、根据是否允许失真,信源编码可分为无失真信源编码和限失真信源编码。 10、在下面空格中选择填入数学符号“,,,=≥≤?”或“?” (1)当X 和Y 相互独立时,H (XY )=H(X)+H(X/Y)。 (2)假设信道输入用X 表示,信道输出用Y 表示。在无噪有损信道中,H(X/Y)> 0, H(Y/X)=0,I(X;Y) 一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p u u =, ()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。 解:状态图如下 状态转移矩阵为: 1/21/2 01/302/31/32/30p ?? ?= ? ??? 设状态u 1,u 2,u 3稳定后的概率分别为W 1,W 2、W 3 由1231WP W W W W =??++=?得1231132231231 112331223 231W W W W W W W W W W W W ?++=???+=???=???++=? 计算可得1231025925625W W W ?=??? =?? ?=?? 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =,(0|11)p =,(1|00)p =, (1|11)p =,(0|01)p =,(0|10)p =,(1|01)p =,(1|10)p =。画出状态图,并计算各状态 的稳态概率。 解:(0|00)(00|00)0.8p p == (0|01)(10|01)0.5p p == (0|11)(10|11)0.2p p == (0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p == (1|01)(11|01)0.5p p == (1|11)(11|11)0.8p p == (1|10)(01|10)0.5p p == 2.5 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 解: 设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5 已知:在女大学生中有75%是身高160厘米以上的 即:bit x y p 75.0)/(11= 求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15 .075 .025.0log )()/()(log )/(log )/(11111111=?-=-=-= 2.7 设有一离散无记忆信源,其概率空间为123401233/81/41/41/8X x x x x P ====???? = ? ????? (1)求每个符号的自信息量 (2)信源发出一消息符号序列为{202 120 130 213 001 203 210 110 321 010 021 032 011 223 210},求该序列的自信息量和平均每个符号携带的信息量 解:12 2118 ()log log 1.415()3 I x bit p x === 同理可以求得233()2,()2,()3I x bit I x bit I x bit === 因为信源无记忆,所以此消息序列的信息量就等于该序列中各个符号的信息量之和 就有:123414()13()12()6()87.81I I x I x I x I x bit =+++= 平均每个符号携带的信息量为 87.81 1.9545 =bit/符号 2.13 有两个二元随机变量X 和Y ,它们的联合概率为 并定义另一随机变量Z = XY (一般乘积),试计算: (1) H(X), H(Y), H(Z), H(XZ), H(YZ)和H(XYZ); Chap1思考题与习题参考答案 1.1 信息论与编码技术研究的主要内容是什么? 信息论是一门应用概率论、随机过程、数理统计和近代代数的方法,来研究广义的信息传输、提取和处理系统中一般学科。编码技术研究的主要内容是如何既可靠又有效地传输信息。 1.2 简述信息理论与编码技术的发展简史。 1948年香农在贝尔系统技术杂志上发表了两篇有关“通信的数学理论”的文章。在这两篇论文中,他用概率论测度和数理统计的方法系统地讨论了通信的基本问题,得出了及格重要而带有普遍意义的结论,并由此奠定了现代信息论的基础。 从1948年开始,信息论的出现引起了一些有名的数学家如柯尔洛夫、A.Feinstein、J.Wolfowitz等人的兴趣,他们将香农已得到的数学结论做了进一步的严格论证和推广,使这一理论具有更为坚实的数学基础。 在研究香农信源编码定理的同时,另外一部分科学家从事寻找最佳编码(纠错码)的研究工作,并形成一门独立的分支——纠错码理论。 1959年香农发表了“保真度准则下的离散信源编码定理”,首先提出了率失真函数及率失真信源编码定理。从此,发展成为信息率失真编码理论。 香农1961年的论文“双路通信信道”开拓了网络信息论的研究。 现在,信息理论不仅在通信、计算机以及自动控制等电子学领域中得到直接的应用,而且还广泛地渗透到生物学、医学、生理学、语言学、社会学、和经济学等领域。 1.3 简述信息与消息、信号的定义以及三者之间的关系。 信息就是事物运动的状态和方式,就是关于事物运动的千差万别的状态和方式的知识。 用文字、符号、数据、语言、音符、图像等能够被人们感觉器官所感知的形式,把客观物质运动和主观思维活动的状态表达出来成为消息。 把消息变换成适合信道传输的物理量,这种物理量称为信号。 它们之间的关系是:消息中包含信息,是信息的载体;信号携带消息,是消息的运载工具。 1.4 简述一个通信系统包括的各主要功能模块及其作用。 通信系统主要分成下列五个部分: (1)信息源。信源是产生消息和消息序列的源。 (2)编码器。编码是把消息变换成信号的措施。 (3)信道。信道是指通信系统把载荷消息的信号从甲地传到乙地的媒介。 (4)译码器。译码就是把信道输出的编码信号(已叠加了干扰)进行反变换。 (5)信宿。信宿是消息传送的对象,即接收消息的人或机器。 1.5 你有没有接触与考虑过信息与信息的测度问题,你如何理解这些问题? 略。 1.6 什么是事物的不确定性?不确定性如何与信息的测度发生关系? 由于主、客观事物运动状态或存在状态是千变万化的、不规则的、随机的。所以在通信以前,收信者存在“疑义”和“不知”,即不确定性。 重庆邮电大学2007/2008学年2学期 《信息论基础》试卷(期末)(A卷)(半开卷) 一、填空题(本大题共10小空,每小空1分,共20分) 1.按信源发出符号所对应的随机变量之间的无统计依赖关系,可将离散信源分为有记忆信源和无记忆信源两大类。 2.一个八进制信源的最大熵为3bit/符号 3.有一信源X,其概率分布为 123 x x x X 111 P 244 ?? ?? ? = ?? ? ?? ?? ,其信源剩余度为94.64%;若对该信源进行十次扩展,则 每十个符号的平均信息量是 15bit。 4.若一连续消息通过放大器,该放大器输出的最大瞬间电压为b,最小瞬时电压为a。若消息从放大器中输出,则该信源的绝对熵是∞;其能在每个自由度熵的最大熵是log(b-a)bit/自由度;若放大器的最高频率为F,则单位时间内输出的最大信息量是 2Flog(b-a)bit/s. 5. 若某一信源X,其平均功率受限为16w,其概率密度函数是高斯分布时,差熵的最大值为1 log32e 2 π;与其 熵相等的非高斯分布信源的功率为16w ≥ 6、信源编码的主要目的是提高有效性,信道编码的主要目的是提高可靠性。 7、无失真信源编码的平均码长最小理论极限制为信源熵(或H(S)/logr= H r(S))。 8、当R=C或(信道剩余度为0)时,信源与信道达到匹配。 9、根据是否允许失真,信源编码可分为无失真信源编码和限失真信源编码。 10、在下面空格中选择填入数学符号“,,, =≥≤?”或“?” (1)当X和Y相互独立时,H(XY)=H(X)+H(X/Y)。 (2)假设信道输入用X表示,信道输出用Y表示。在无噪有损信道中,H(X/Y)> 0, H(Y/X)=0,I(X;Y) 第二章 信息量与熵 2、2 八元编码系统,码长为3,第一个符号用于同步,每秒1000个码字,求它的信息速率。 解:同步信息均相同,不含信息,因此 每个码字的信息量为 2?8log =2?3=6 bit 因此,信息速率为 6?1000=6000 bit/s 2、3 掷一对无偏骰子,告诉您得到的总的点数为:(a) 7; (b) 12。问各得到多少信息量。 解:(1) 可能的组合为 {1,6},{2,5},{3,4},{4,3},{5,2},{6,1} )(a p =366=6 1 得到的信息量 =)(1log a p =6log =2、585 bit (2) 可能的唯一,为 {6,6} )(b p =36 1 得到的信息量=)(1log b p =36log =5、17 bit 2、4 经过充分洗牌后的一副扑克(52张),问: (a) 任何一种特定的排列所给出的信息量就是多少? (b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量? 解:(a) )(a p =! 521 信息量=) (1log a p =!52log =225、58 bit (b) ???????花色任选 种点数任意排列 13413!13 )(b p =1352 134!13A ?=135213 4C 信息量=1313524log log -C =13、208 bit 2、9 随机掷3颗骰子,X 表示第一颗骰子的结果,Y 表示第一与第二颗骰子的点数之与,Z 表 示3颗骰子的点数之与,试求)|(Y Z H 、)|(Y X H 、),|(Y X Z H 、)|,(Y Z X H 、)|(X Z H 。 解:令第一第二第三颗骰子的结果分别为321,,x x x ,1x ,2x ,3x 相互独立,则 1x X =,21x x Y +=,321x x x Z ++= )|(Y Z H =)(3x H =log 6=2、585 bit )|(X Z H =)(32x x H +=)(Y H =2?(361log 36+362log 18+363log 12+364log 9+365log 536)+36 6log 6 =3、2744 bit )|(Y X H =)(X H -);(Y X I =)(X H -[)(Y H -)|(X Y H ] 而)|(X Y H =)(X H ,所以)|(Y X H = 2)(X H -)(Y H =1、8955 bit 或)|(Y X H =)(XY H -)(Y H =)(X H +)|(X Y H -)(Y H 而)|(X Y H =)(X H ,所以)|(Y X H =2)(X H -)(Y H =1、8955 bit ),|(Y X Z H =)|(Y Z H =)(X H =2、585 bit )|,(Y Z X H =)|(Y X H +)|(XY Z H =1、8955+2、585=4、4805 bit 4.1 当率失真函数R (D )取什么值的时候,表示不允许有任何失真。 解:当D=0时,表示不允许有任何失真,此时R (D )= H (X ), 即R max ((D )= H (X ) 4.2 说明信源在不允许失真时,其信息率所能压缩到的极限值是什么?当允许信源存在一定的失真时,其信息率所能压缩到的极限值又是什么? 解:不允许失真时,信息率压缩极限值R (D )= H (X );不允许失真时,信息率压缩极限值 R (D )= 0 4.3 在例4.8中,当允许D= 0.5δ时,请问每个信源符号至少需要几个二进制符号来对其编码? 解:因为二元信源率失真函数: ? ?? ??-=a D H p H D R )()( 其中a = 1(汉明失真), 所以二元信源率失真函数为: )()()(D H p H D R -= 当D= 2 P 时 []symbol nat p p p p p p p p p H p H p R /21ln 212ln 2)1ln()1(ln 2)(2?? ??????? ??-??? ??-++--+-=??? ??-=??? ?? 4.4 给定信源分布??????)(q X X = ??????2 5.025.05.0x 321x x ,失真测度矩阵[d]=?? ?? ? ?????011302120,求率失真 函数R (D )。 解:定义域: D min =0×0.5+0×0.25+0×0.25=0 D max =min{2×0.25+1×0.25,2×0.5+1×0.25,1×0.5+3×0.25}=0.75 值域: R (D min )= -0.5log0.5-0.25log0.25-0.25log0.25=0.45 R (D max )= 0 4.5 给定二元信源??? ???)(q X X = ??????5.05.0x x 21, 失真测度矩阵为[d]=?? ? ???00αα,求率失真函数R(D)。 解: 021 021),(min )(202121),()(min min min max =?+?=== ?+?===∑∑i j i j i i j i i j j y x d x p D a a y x d x p D D 因为二元等概信源率失真函数: ?? ? ??-=a D H n D R ln )( 3-1 设有一离散无记忆信源,其概率空间为12()0.60.4X x x P x ???? =? ??? ???? ,信源发出符号通过一干扰信道,接收符号为12{,}Y y y =,信道传递矩阵为516 61344P ???? =? ?????? ? ,求: (1)信源X 中事件1x 和2x 分别含有的自信息量; (2)收到消息j y (j =1,2)后,获得的关于i x (i =1,2)的信息量; (3)信源X 和信宿Y 的信息熵; (4)信道疑义度(/)H X Y 和噪声熵(/)H Y X ; (5)接收到消息Y 后获得的平均互信息量(;)I X Y 。 解:(1)12()0.737,() 1.322I x bit I x bit == (2)11(;)0.474I x y bit =,12(;) 1.263I x y bit =-,21(;) 1.263I x y bit =-, 22(;)0.907I x y bit = (3)()(0.6,0.4)0.971/H X H bit symbol == ()(0.6,0.4)0.971/H Y H bit symbol == (4)()(0.5,0.1,0.1,0.3) 1.685/H XY H bit symbol == (/) 1.6850.9710.714/H X Y bit symbol =-= (/)0.714/H Y X bit symbol = (5)(;)0.9710.7140.257/I X Y bit symbol =-= 3-2 设有扰离散信道的输入端是以等概率出现的A 、B 、C 、D 四个字母。该信道的正 确传输概率为0.5,错误传输概率平均分布在其他三个字母上。验证在该信道上每个字母传输的平均信息量为0.21比特。 证明:信道传输矩阵为: 信息论与编码理论习题答案全解 第二章 信息量和熵 2.2 八元编码系统,码长为3,第一个符号用于同步,每秒1000个码字,求它的 信息速率。 解:同步信息均相同,不含信息,因此 每个码字的信息量为 2?8log =2?3=6 bit 因此,信息速率为 6?1000=6000 bit/s 2.3 掷一对无偏骰子,告诉你得到的总的点数为:(a) 7; (b) 12。问各得到多少 信息量。 解:(1) 可能的组合为 {1,6},{2,5},{3,4},{4,3},{5,2},{6,1} )(a p =366=6 1 得到的信息量 =) (1 log a p =6log =2.585 bit (2) 可能的唯一,为 {6,6} )(b p =361 得到的信息量=) (1 log b p =36log =5.17 bit 2.4 经过充分洗牌后的一副扑克(52张),问: (a) 任何一种特定的排列所给出的信息量是多少? (b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量? 解:(a) )(a p =! 521 信息量=) (1 log a p =!52log =225.58 bit (b) ???????花色任选 种点数任意排列 13413!13 )(b p =13 52134!13A ?=1352 13 4C 信息量=1313 52 4log log -C =13.208 bit 2.9 随机掷3颗骰子,X 表示第一颗骰子的结果,Y 表示第一和第二颗骰子的 点数之和,Z 表示3颗骰子的点数之和,试求)|(Y Z H 、)|(Y X H 、 ),|(Y X Z H 、)|,(Y Z X H 、)|(X Z H 。 解:令第一第二第三颗骰子的结果分别为321,,x x x ,1x ,2x ,3x 相互独立, 则1x X =,21x x Y +=,321x x x Z ++= )|(Y Z H =)(3x H =log 6=2.585 bit )|(X Z H =)(32x x H +=)(Y H =2?( 361log 36+362log 18+363log 12+364log 9+365log 536)+36 6 log 6 =3.2744 bit )|(Y X H =)(X H -);(Y X I =)(X H -[)(Y H -)|(X Y H ] 而)|(X Y H =)(X H ,所以)|(Y X H = 2)(X H -)(Y H =1.8955 bit 或)|(Y X H =)(XY H -)(Y H =)(X H +)|(X Y H -)(Y H 而)|(X Y H =)(X H ,所以)|(Y X H =2)(X H -)(Y H =1.8955 bit ),|(Y X Z H =)|(Y Z H =)(X H =2.585 bit )|,(Y Z X H =)|(Y X H +)|(XY Z H =1.8955+2.585=4.4805 bit 2.10 设一个系统传送10个数字,0,1,…,9。奇数在传送过程中以0.5的概 率错成另外一个奇数,其余正确接收,求收到一个数字平均得到的信息量。 解: 信道 X Y 9,7,5,3,1=i 8,6,4,2,0=i √Χ );(Y X I =)(Y H -)|(X Y H 因为输入等概,由信道条件可知, 信息论与编码习题参考答案 第一章 单符号离散信源 同时掷一对均匀的子,试求: (1)“2和6同时出现”这一事件的自信息量; (2)“两个5同时出现”这一事件的自信息量; (3)两个点数的各种组合的熵; (4)两个点数之和的熵; (5)“两个点数中至少有一个是1”的自信息量。 解: bit P a I N n P bit P a I N n P c c N 17.536log log )(361 )2(17.418log log )(362)1(36 662221111 616==-=∴====-=∴== =?==样本空间: (3)信源空间: bit x H 32.436log 36 16236log 36215)(=??+?? =∴ (4)信源空间: bit x H 71.3636 log 366536log 3610 436log 368336log 366236log 36436log 362)(=??+?+?+??= ∴++ (5) bit P a I N n P 17.111 36 log log )(3611333==-=∴== 如有6行、8列的棋型方格,若有两个质点A 和B ,分别以等概落入任一方格内,且它们的坐标分别为(Xa ,Ya ), (Xb ,Yb ),但A ,B 不能同时落入同一方格内。 (1) 若仅有质点A ,求A 落入任一方格的平均信息量; (2) 若已知A 已落入,求B 落入的平均信息量; (3) 若A ,B 是可辨认的,求A ,B 落入的平均信息量。 解: bit a P a P a a P a I a P A i 58.548log )(log )()(H 48log )(log )(481 )(:)1(48 1 i i i i i ==-=∴=-=∴= ∑=落入任一格的概率Θ bit b P b P b b P b I b P A i 55.547log )(log )()(H 47 log )(log )(47 1 )(:B ,)2(48 1i i i i i ==-=∴=-=∴=∑=落入任一格的概率是落入任一格的情况下在已知Θ 一填空题(本题20分,每小题2分) 1、平均自信息为 表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。 平均互信息 表示从Y获得的关于每个X的平均信息量,也表示发X前后Y的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。 2、最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。 3、最大熵值为。 4、通信系统模型如下: 5、香农公式为为保证足够大的信道容量,可采用(1)用频带换信噪比;(2)用信噪比换频带。 6、只要,当N足够长时,一定存在一种无失真编码。 7、当R<C时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。 8、在认识论层次上研究信息的时候,必须同时考虑到形式、含义和效用三个方面的因素。 9、1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。 按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。 按照信息的地位,可以把信息分成客观信息和主观信息。 人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。 信息的可度量性是建立信息论的基础。 统计度量是信息度量最常用的方法。 熵是香农信息论最基本最重要的概念。 事物的不确定度是用时间统计发生概率的对数来描述的。 10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。 11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。 12、自信息量的单位一般有比特、奈特和哈特。 13、必然事件的自信息是 0 。 14、不可能事件的自信息量是∞。 15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。 16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量趋于变小。 17、离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的 N倍。 18、离散平稳有记忆信源的极限熵,。 19、对于n元m阶马尔可夫信源,其状态空间共有 nm 个不同的状态。 20、一维连续随即变量X在[a,b]区间内均匀分布时,其信源熵为 log2(b-a)。信息论与编码课后答案

信息论与编码-习题解答

信息论与编码技术思考题与习题(1-2)

信息论基础》试卷(期末A卷

信息论习题解答

信息论与纠错编码(电子工业出版社)第四章率失真编码 参考答案

信息论基础与编码课后题答案第三章

信息论与编码理论习题答案全解

信息论与编码习题参考答案(全)

信息论与编码试题集与答案