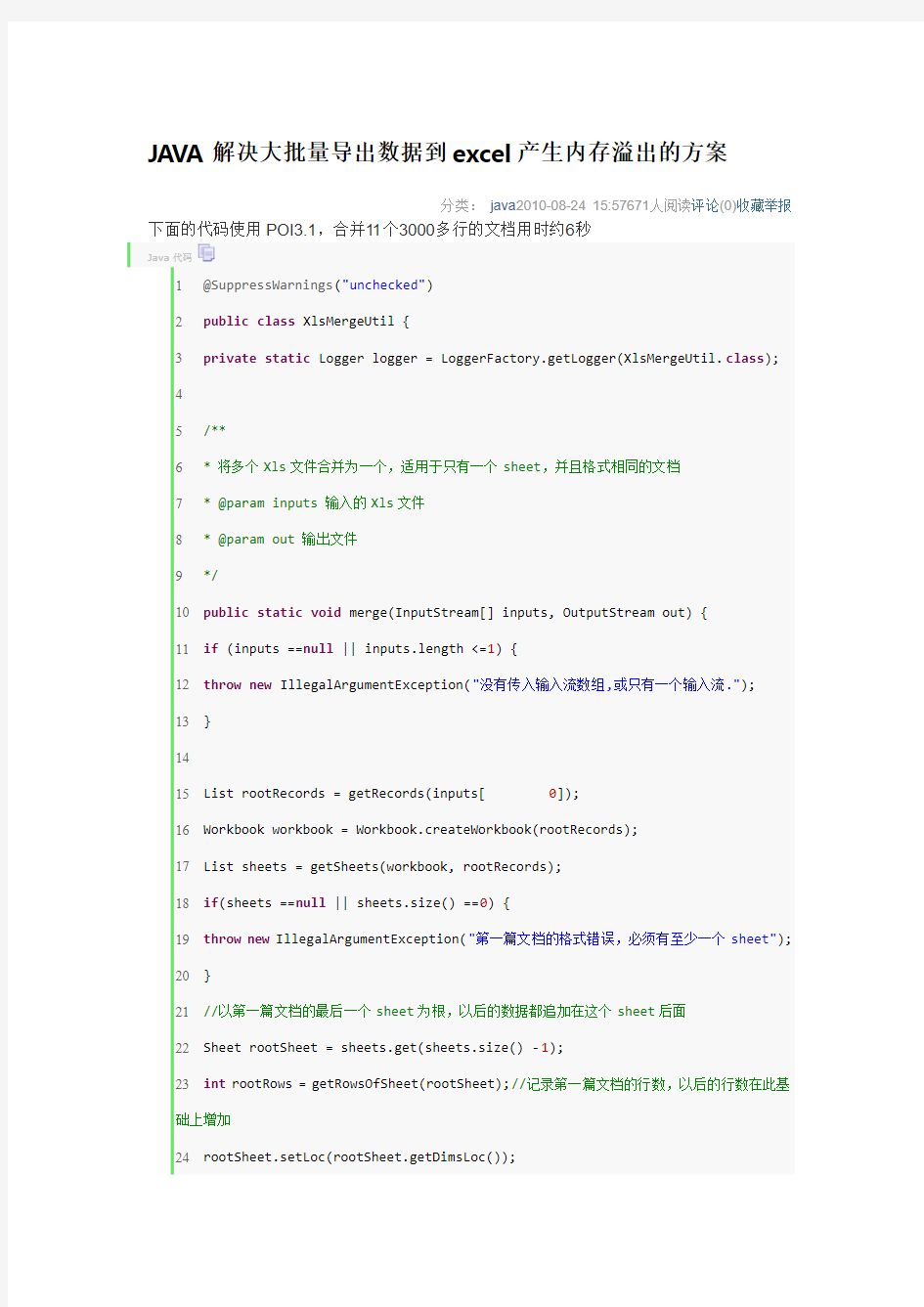

JAVA解决大批量导出数据到excel产生内存溢出的方案

分类:java2010-08-24 15:57671人阅读评论(0)收藏举报下面的代码使用POI3.1,合并11个3000多行的文档用时约6秒

Java代码

1@SuppressWarnings("unchecked")

2public class XlsMergeUtil {

3private static Logger logger = LoggerFactory.getLogger(XlsMergeUtil.class);

4

5/**

6* 将多个Xls文件合并为一个,适用于只有一个sheet,并且格式相同的文档

7* @param inputs 输入的Xls文件

8* @param out 输出文件

9*/

10public static void merge(InputStream[] inputs, OutputStream out) {

11if(inputs ==null|| inputs.length <=1) {

12throw new IllegalArgumentException("没有传入输入流数组,或只有一个输入流.");

13}

14

15List

16Workbook workbook = Workbook.createWorkbook(rootRecords);

17List

18if(sheets ==null|| sheets.size() ==0) {

19throw new IllegalArgumentException("第一篇文档的格式错误,必须有至少一个sheet");

20}

21//以第一篇文档的最后一个sheet为根,以后的数据都追加在这个sheet后面

22Sheet rootSheet = sheets.get(sheets.size() -1);

23int rootRows = getRowsOfSheet(rootSheet);//记录第一篇文档的行数,以后的行数在此基础上增加

24rootSheet.setLoc(rootSheet.getDimsLoc());

25Map

26

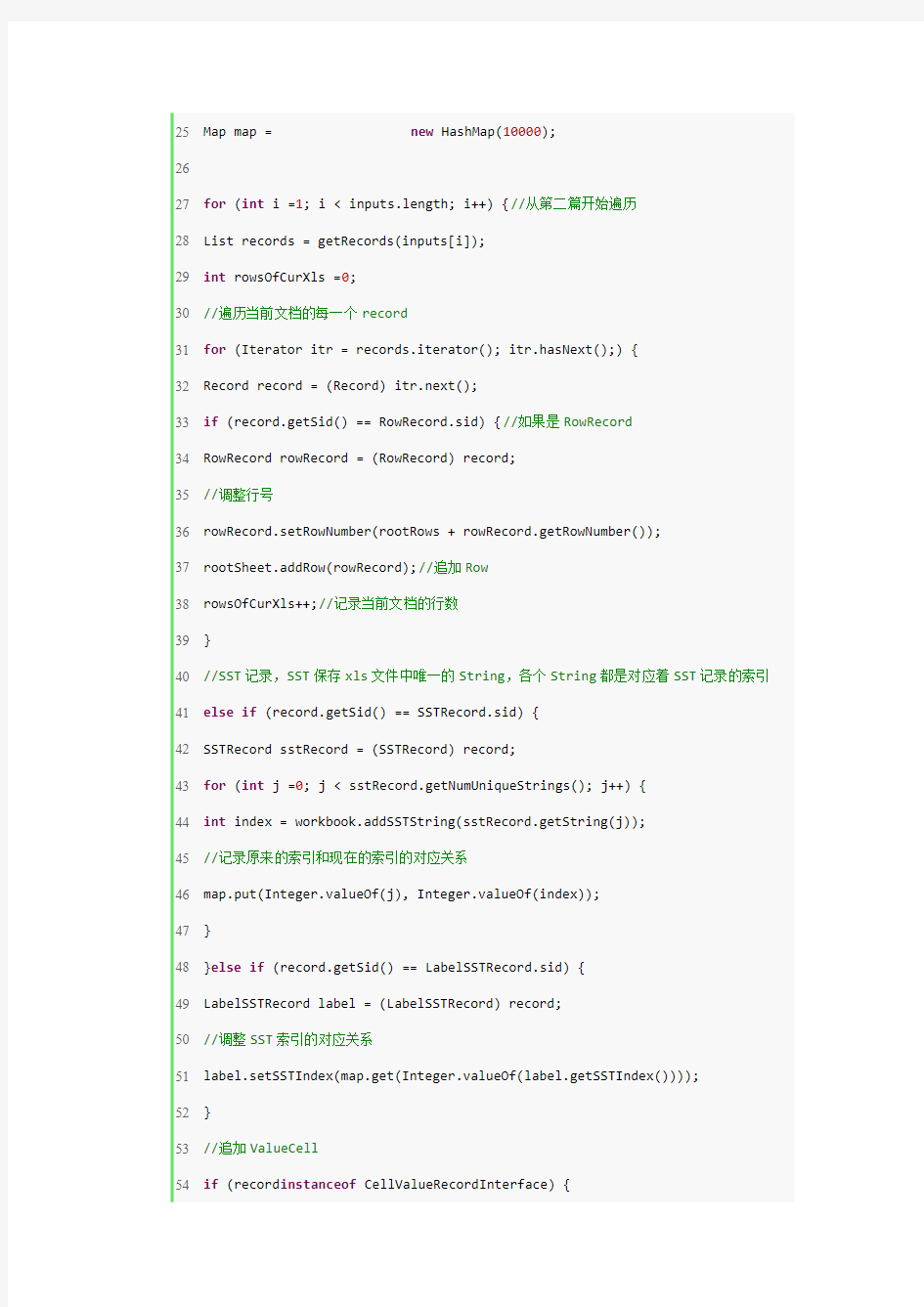

27for(int i =1; i < inputs.length; i++) {//从第二篇开始遍历

28List

29int rowsOfCurXls =0;

30//遍历当前文档的每一个record

31for(Iterator itr = records.iterator(); itr.hasNext();) {

32Record record = (Record) itr.next();

33if(record.getSid() == RowRecord.sid) {//如果是RowRecord

34RowRecord rowRecord = (RowRecord) record;

35//调整行号

36rowRecord.setRowNumber(rootRows + rowRecord.getRowNumber());

37rootSheet.addRow(rowRecord);//追加Row

38rowsOfCurXls++;//记录当前文档的行数

39}

40//SST记录,SST保存xls文件中唯一的String,各个String都是对应着SST记录的索引41else if(record.getSid() == SSTRecord.sid) {

42SSTRecord sstRecord = (SSTRecord) record;

43for(int j =0; j < sstRecord.getNumUniqueStrings(); j++) {

44int index = workbook.addSSTString(sstRecord.getString(j));

45//记录原来的索引和现在的索引的对应关系

46map.put(Integer.valueOf(j), Integer.valueOf(index));

47}

48}else if(record.getSid() == LabelSSTRecord.sid) {

49LabelSSTRecord label = (LabelSSTRecord) record;

50//调整SST索引的对应关系

51label.setSSTIndex(map.get(Integer.valueOf(label.getSSTIndex())));

52}

53//追加ValueCell

55CellValueRecordInterface cell = (CellValueRecordInterface) record; 56int cellRow = cell.getRow() + rootRows;

57cell.setRow(cellRow);

58rootSheet.addValueRecord(cellRow, cell);

59}

60}

61rootRows += rowsOfCurXls;

62}

63byte[] data = getBytes(workbook, sheets.toArray(new Sheet[0]));

64write(out, data);

65}

66

67static void write(OutputStream out,byte[] data) {

68POIFSFileSystem fs =new POIFSFileSystem();

69// Write out the Workbook stream

70try{

71fs.createDocument(new ByteArrayInputStream(data),"Workbook");

72fs.writeFilesystem(out);

73out.flush();

74}catch(IOException e) {

75 e.printStackTrace();

76}finally{

77try{

78out.close();

79}catch(IOException e) {

80 e.printStackTrace();

81}

82}

83}

85static List

87int sheetNum =0;

88

89// convert all LabelRecord records to LabelSSTRecord

90convertLabelRecords(records, recOffset, workbook);

91List

92while(recOffset < records.size()) {

93Sheet sh = Sheet.createSheet(records, sheetNum++, recOffset); 94

95recOffset = sh.getEofLoc() +1;

96if(recOffset ==1) {

97break;

98}

99sheets.add(sh);

100}

101return sheets;

102}

103

104static int getRows(List

105int row =0;

106for(Iterator itr = records.iterator(); itr.hasNext();) {

107Record record = (Record) itr.next();

108if(record.getSid() == RowRecord.sid) {

109row++;

110}

111}

112return row;

113}

115static int getRowsOfSheet(Sheet sheet) {

116int rows =0;

117sheet.setLoc(0);

118while(sheet.getNextRow() !=null) {

119rows++;

120}

121return rows;

122}

123

124@SuppressWarnings("deprecation")

125static List

126try{

127POIFSFileSystem poifs =new POIFSFileSystem(input);

128InputStream stream = poifs.getRoot().createDocumentInputStream("Workbook"); 129return org.apache.poi.hssf.record.RecordFactory.createRecords(stream);

130}catch(IOException e) {

131logger.error("IO异常:{}", e.getMessage());

132e.printStackTrace();

133}

134return Collections.EMPTY_LIST;

135}

136

137static void convertLabelRecords(List records,int offset, Workbook workbook) { 138

139for(int k = offset; k < records.size(); k++) {

140Record rec = (Record) records.get(k);

141

142if(rec.getSid() == LabelRecord.sid) {

143LabelRecord oldrec = (LabelRecord) rec;

145records.remove(k);

146LabelSSTRecord newrec =new LabelSSTRecord();

147int stringid = workbook.addSSTString(new UnicodeString(oldrec.getValue())); 148

149newrec.setRow(oldrec.getRow());

150newrec.setColumn(oldrec.getColumn());

151newrec.setXFIndex(oldrec.getXFIndex());

152newrec.setSSTIndex(stringid);

153records.add(k, newrec);

154}

155}

156}

157

158public static byte[] getBytes(Workbook workbook, Sheet[] sheets) {

159// HSSFSheet[] sheets = getSheets();

160int nSheets = sheets.length;

161

162// before getting the workbook size we must tell the sheets that

163// serialization is about to occur.

164for(int i =0; i < nSheets; i++) {

165sheets[i].preSerialize();

166}

167

168int totalsize = workbook.getSize();

169

170// pre-calculate all the sheet sizes and set BOF indexes

171int[] estimatedSheetSizes =new int[nSheets];

172for(int k =0; k < nSheets; k++) {

173workbook.setSheetBof(k, totalsize);

175estimatedSheetSizes[k] = sheetSize;

176totalsize += sheetSize;

177}

178

179byte[] retval =new byte[totalsize];

180int pos = workbook.serialize(0, retval);

181

182for(int k =0; k < nSheets; k++) {

183int serializedSize = sheets[k].serialize(pos, retval);

184if(serializedSize != estimatedSheetSizes[k]) {

185throw new IllegalStateException("Actual serialized sheet size ("+ serializedSize 186+") differs from pre-calculated size ("+ estimatedSheetSizes[k] +") for sheet ("+ k

187+")");

188Sheet.serializeIndexRecord() does not

189}

190pos += serializedSize;

191}

192return retval;

193}

194

195public static void main(String[] args)throws Exception {

196final String PATH ="E://projects//java//ws_0//export//data//";

197InputStream[] inputs =new InputStream[10];

198inputs[0] =new java.io.FileInputStream(PATH +"07_10.xls");

199for(int i =1; i <=9; i++) {

200inputs[i] =new java.io.FileInputStream(PATH +"07_0"+ i +".xls");

201}

202OutputStream out =new FileOutputStream(PATH +"xx.xls");

204merge(inputs, out);

205System.out.println(System.currentTimeMillis() - t1);//简陋的测试一下时间

206}

207

208}

JAVA解决大批量导出数据到excel产生内存溢出的方案

分类:java2010-08-24 15:57671人阅读评论(0)收藏举报下面的代码使用POI3.1,合并11个3000多行的文档用时约6秒

Java代码

1@SuppressWarnings("unchecked")

2public class XlsMergeUtil {

3private static Logger logger = LoggerFactory.getLogger(XlsMergeUtil.class);

4

5/**

6* 将多个Xls文件合并为一个,适用于只有一个sheet,并且格式相同的文档

7* @param inputs 输入的Xls文件

8* @param out 输出文件

9*/

10public static void merge(InputStream[] inputs, OutputStream out) {

11if(inputs ==null|| inputs.length <=1) {

12throw new IllegalArgumentException("没有传入输入流数组,或只有一个输入流.");

13}

14

15List

16Workbook workbook = Workbook.createWorkbook(rootRecords);

17List

18if(sheets ==null|| sheets.size() ==0) {

19throw new IllegalArgumentException("第一篇文档的格式错误,必须有至少一个sheet");

20}

21//以第一篇文档的最后一个sheet为根,以后的数据都追加在这个sheet后面

22Sheet rootSheet = sheets.get(sheets.size() -1);

23int rootRows = getRowsOfSheet(rootSheet);//记录第一篇文档的行数,以后的行数在此基础上增加

24rootSheet.setLoc(rootSheet.getDimsLoc());

25Map

26

27for(int i =1; i < inputs.length; i++) {//从第二篇开始遍历

28List

29int rowsOfCurXls =0;

30//遍历当前文档的每一个record

31for(Iterator itr = records.iterator(); itr.hasNext();) {

32Record record = (Record) itr.next();

33if(record.getSid() == RowRecord.sid) {//如果是RowRecord

34RowRecord rowRecord = (RowRecord) record;

35//调整行号

36rowRecord.setRowNumber(rootRows + rowRecord.getRowNumber());

37rootSheet.addRow(rowRecord);//追加Row

38rowsOfCurXls++;//记录当前文档的行数

39}

40//SST记录,SST保存xls文件中唯一的String,各个String都是对应着SST记录的索引

41else if(record.getSid() == SSTRecord.sid) {

42SSTRecord sstRecord = (SSTRecord) record;

43for(int j =0; j < sstRecord.getNumUniqueStrings(); j++) {

44int index = workbook.addSSTString(sstRecord.getString(j));

45//记录原来的索引和现在的索引的对应关系

46map.put(Integer.valueOf(j), Integer.valueOf(index));

47}

48}else if(record.getSid() == LabelSSTRecord.sid) {

50//调整SST索引的对应关系

51label.setSSTIndex(map.get(Integer.valueOf(label.getSSTIndex()))); 52}

53//追加ValueCell

54if(record instanceof CellValueRecordInterface) {

55CellValueRecordInterface cell = (CellValueRecordInterface) record; 56int cellRow = cell.getRow() + rootRows;

57cell.setRow(cellRow);

58rootSheet.addValueRecord(cellRow, cell);

59}

60}

61rootRows += rowsOfCurXls;

62}

63byte[] data = getBytes(workbook, sheets.toArray(new Sheet[0]));

64write(out, data);

65}

66

67static void write(OutputStream out,byte[] data) {

68POIFSFileSystem fs =new POIFSFileSystem();

69// Write out the Workbook stream

70try{

71fs.createDocument(new ByteArrayInputStream(data),"Workbook");

72fs.writeFilesystem(out);

73out.flush();

74}catch(IOException e) {

75 e.printStackTrace();

76}finally{

77try{

78out.close();

80 e.printStackTrace();

81}

82}

83}

84

85static List

87int sheetNum =0;

88

89// convert all LabelRecord records to LabelSSTRecord

90convertLabelRecords(records, recOffset, workbook);

91List

92while(recOffset < records.size()) {

93Sheet sh = Sheet.createSheet(records, sheetNum++, recOffset); 94

95recOffset = sh.getEofLoc() +1;

96if(recOffset ==1) {

97break;

98}

99sheets.add(sh);

100}

101return sheets;

102}

103

104static int getRows(List

105int row =0;

106for(Iterator itr = records.iterator(); itr.hasNext();) {

107Record record = (Record) itr.next();

108if(record.getSid() == RowRecord.sid) {

110}

111}

112return row;

113}

114

115static int getRowsOfSheet(Sheet sheet) {

116int rows =0;

117sheet.setLoc(0);

118while(sheet.getNextRow() !=null) {

119rows++;

120}

121return rows;

122}

123

124@SuppressWarnings("deprecation")

125static List

126try{

127POIFSFileSystem poifs =new POIFSFileSystem(input);

128InputStream stream = poifs.getRoot().createDocumentInputStream("Workbook"); 129return org.apache.poi.hssf.record.RecordFactory.createRecords(stream);

130}catch(IOException e) {

131logger.error("IO异常:{}", e.getMessage());

132e.printStackTrace();

133}

134return Collections.EMPTY_LIST;

135}

136

137static void convertLabelRecords(List records,int offset, Workbook workbook) { 138

140Record rec = (Record) records.get(k);

141

142if(rec.getSid() == LabelRecord.sid) {

143LabelRecord oldrec = (LabelRecord) rec;

144

145records.remove(k);

146LabelSSTRecord newrec =new LabelSSTRecord();

147int stringid = workbook.addSSTString(new UnicodeString(oldrec.getValue())); 148

149newrec.setRow(oldrec.getRow());

150newrec.setColumn(oldrec.getColumn());

151newrec.setXFIndex(oldrec.getXFIndex());

152newrec.setSSTIndex(stringid);

153records.add(k, newrec);

154}

155}

156}

157

158public static byte[] getBytes(Workbook workbook, Sheet[] sheets) {

159// HSSFSheet[] sheets = getSheets();

160int nSheets = sheets.length;

161

162// before getting the workbook size we must tell the sheets that

163// serialization is about to occur.

164for(int i =0; i < nSheets; i++) {

165sheets[i].preSerialize();

166}

167

168int totalsize = workbook.getSize();

170// pre-calculate all the sheet sizes and set BOF indexes

171int[] estimatedSheetSizes =new int[nSheets];

172for(int k =0; k < nSheets; k++) {

173workbook.setSheetBof(k, totalsize);

174int sheetSize = sheets[k].getSize();

175estimatedSheetSizes[k] = sheetSize;

176totalsize += sheetSize;

177}

178

179byte[] retval =new byte[totalsize];

180int pos = workbook.serialize(0, retval);

181

182for(int k =0; k < nSheets; k++) {

183int serializedSize = sheets[k].serialize(pos, retval);

184if(serializedSize != estimatedSheetSizes[k]) {

185throw new IllegalStateException("Actual serialized sheet size ("+ serializedSize 186+") differs from pre-calculated size ("+ estimatedSheetSizes[k] +") for sheet ("+ k

187+")");

188Sheet.serializeIndexRecord() does not

189}

190pos += serializedSize;

191}

192return retval;

193}

194

195public static void main(String[] args)throws Exception {

196final String PATH ="E://projects//java//ws_0//export//data//";

197InputStream[] inputs =new InputStream[10];

199for(int i =1; i <=9; i++) {

200inputs[i] =new java.io.FileInputStream(PATH +"07_0"+ i +".xls"); 201}

202OutputStream out =new FileOutputStream(PATH +"xx.xls");

203long t1 = System.currentTimeMillis();

204merge(inputs, out);

205System.out.println(System.currentTimeMillis() - t1);//简陋的测试一下时间206}

207

208}

1、当前大数据技术的基础是由( C)首先提出的。(单选题,本题2分) A:微软 B:百度 C:谷歌 D:阿里巴巴 2、大数据的起源是(C )。(单选题,本题2分) A:金融 B:电信 C:互联网 D:公共管理 3、根据不同的业务需求来建立数据模型,抽取最有意义的向量,决定选取哪种方法的数据分析角色人员是 ( C)。(单选题,本题2分) A:数据管理人员 B:数据分析员 C:研究科学家 D:软件开发工程师 4、(D )反映数据的精细化程度,越细化的数据,价值越高。(单选题,本题2分) A:规模 B:活性 C:关联度 D:颗粒度 5、数据清洗的方法不包括( D)。(单,本题2分)

A:缺失值处理 B:噪声数据清除 C:一致性检查 D:重复数据记录处理 6、智能健康手环的应用开发,体现了( D)的数据采集技术的应用。(单选题,本题2分) A:统计报表 B:网络爬虫 C:API接口 D:传感器 7、下列关于数据重组的说法中,错误的是( A)。(单选题,本题2分) A:数据重组是数据的重新生产和重新采集 B:数据重组能够使数据焕发新的光芒 C:数据重组实现的关键在于多源数据融合和数据集成 D:数据重组有利于实现新颖的数据模式创新 8、智慧城市的构建,不包含( C)。(单选题,本题2分) A:数字城市 B:物联网 C:联网监控 D:云计算 大数据的最显著特征是( A)。(单选题,本题2分) A:数据规模大 B:数据类型多样

C:数据处理速度快 D:数据价值密度高 10、美国海军军官莫里通过对前人航海日志的分析,绘制了新的航海路线图,标明了大风与洋流可能发生的地 点。这体现了大数据分析理念中的(B )。(单选题,本题2分) A:在数据基础上倾向于全体数据而不是抽样数据 B:在分析方法上更注重相关分析而不是因果分析 C:在分析效果上更追究效率而不是绝对精确 D:在数据规模上强调相对数据而不是绝对数据 11、下列关于舍恩伯格对大数据特点的说法中,错误的是(D )。(单选题,本题2分) A:数据规模大 B:数据类型多样 C:数据处理速度快 D:数据价值密度高 12、当前社会中,最为突出的大数据环境是(A )。(单选题,本题2分) A:互联网 B:物联网 C:综合国力 D:自然资源 13、在数据生命周期管理实践中,( B)是(单选题,本题2分) A:数据存储和备份规 B:数据管理和维护 C:数据价值发觉和利用

大数据处理流程的主要环节 大数据处理流程主要包括数据收集、数据预处理、数据存储、数据处理与分析、数据展示/数据可视化、数据应用等环节,其中数据质量贯穿于整个大数据流程,每一个数据处理环节都会对大数据质量产生影响作用。通常,一个好的大数据产品要有大量的数据规模、快速的数据处理、精确的数据分析与预测、优秀的可视化图表以及简练易懂的结果解释,本节将基于以上环节分别分析不同阶段对大数据质量的影响及其关键影响因素。 一、数据收集 在数据收集过程中,数据源会影响大数据质量的真实性、完整性数据收集、一致性、准确性和安全性。对于Web数据,多采用网络爬虫方式进行收集,这需要对爬虫软件进行时间设置以保障收集到的数据时效性质量。比如可以利用八爪鱼爬虫软件的增值API设置,灵活控制采集任务的启动和停止。 二、数据预处理 大数据采集过程中通常有一个或多个数据源,这些数据源包括同构或异构的数据库、文件系统、服务接口等,易受到噪声数据、数据值缺失、数据冲突等影响,因此需首先对收集到的

大数据集合进行预处理,以保证大数据分析与预测结果的准确性与价值性。 大数据的预处理环节主要包括数据清理、数据集成、数据归约与数据转换等内容,可以大大提高大数据的总体质量,是大数据过程质量的体现。数据清理技术包括对数据的不一致检测、噪声数据的识别、数据过滤与修正等方面,有利于提高大数据的一致性、准确性、真实性和可用性等方面的质量; 数据集成则是将多个数据源的数据进行集成,从而形成集中、统一的数据库、数据立方体等,这一过程有利于提高大数据的完整性、一致性、安全性和可用性等方面质量; 数据归约是在不损害分析结果准确性的前提下降低数据集规模,使之简化,包括维归约、数据归约、数据抽样等技术,这一过程有利于提高大数据的价值密度,即提高大数据存储的价值性。 数据转换处理包括基于规则或元数据的转换、基于模型与学习的转换等技术,可通过转换实现数据统一,这一过程有利于提高大数据的一致性和可用性。 总之,数据预处理环节有利于提高大数据的一致性、准确性、真实性、可用性、完整性、安全性和价值性等方面质量,而大数据预处理中的相关技术是影响大数据过程质量的关键因素

科研常用的实验数据分析与处理方法 对于每个科研工作者而言,对实验数据进行处理是在开始论文写作之前十分常见的工作之一。但是,常见的数据分析方法有哪些呢?常用的数据分析方法有:聚类分析、因子分析、相关分析、对应分析、回归分析、方差分析。 1、聚类分析(Cluster Analysis) 聚类分析指将物理或抽象对象的集合分组成为由类似的对象组成的多个类的分析过程。聚类是将数据分类到不同的类或者簇这样的一个过程,所以同一个簇中的对象有很大的相似性,而不同簇间的对象有很大的相异性。聚类分析是一种探索性的分析,在分类的过程中,人们不必事先给出一个分类的标准,聚类分析能够从样本数据出发,自动进行分类。聚类分析所使用方法的不同,常常会得到不同的结论。不同研究者对于同一组数据进行聚类分析,所得到的聚类数未必一致。 2、因子分析(Factor Analysis) 因子分析是指研究从变量群中提取共性因子的统计技术。因子分析就是从大量的数据中寻找内在的联系,减少决策的困难。因子分析的方法约有10多种,如重心法、影像分析法,最大似然解、最小平方法、阿尔发抽因法、拉奥典型抽因法等等。这些方法本质上大都属近似方法,是以相关系数矩阵为基础的,所不同的是相关系数矩阵对角线上的值,采用不同的共同性□2估值。在社会学研究中,因子分析常采用以主成分分析为基础的反覆法。

3、相关分析(Correlation Analysis) 相关分析(correlation analysis),相关分析是研究现象之间是否存在某种依存关系,并对具体有依存关系的现象探讨其相关方向以及相关程度。相关关系是一种非确定性的关系,例如,以X和Y 分别记一个人的身高和体重,或分别记每公顷施肥量与每公顷小麦产量,则X与Y显然有关系,而又没有确切到可由其中的一个去精确地决定另一个的程度,这就是相关关系。 4、对应分析(Correspondence Analysis) 对应分析(Correspondence analysis)也称关联分析、R-Q 型因子分析,通过分析由定性变量构成的交互汇总表来揭示变量间的联系。可以揭示同一变量的各个类别之间的差异,以及不同变量各个类别之间的对应关系。对应分析的基本思想是将一个联列表的行和列中各元素的比例结构以点的形式在较低维的空间中表示出来。 5、回归分析 研究一个随机变量Y对另一个(X)或一组(X1,X2,…,Xk)变量的相依关系的统计分析方法。回归分析(regression analysis)是确定两种或两种以上变数间相互依赖的定量关系的一种统计分析方法。运用十分广泛,回归分析按照涉及的自变量的多少,可分为一

A. 变量代换 B. 离散化 海量数据挖掘技术及工程实践》题目 、单选题(共 80 题) 1) ( D ) 的目的缩小数据的取值范围,使其更适合于数据挖掘算法的需要,并且能够得 到 和原始数据相同的分析结果。 A. 数据清洗 B. 数据集成 C. 数据变换 D. 数据归约 2) 某超市研究销售纪录数据后发现,买啤酒的人很大概率也会购买尿布,这种属于数 据挖 掘的哪类问题 (A) A. 关联规则发现 B. 聚类 C. 分类 D. 自然语言处理 3) 以下两种描述分别对应哪两种对分类算法的评价标准 (A) (a) 警察抓小偷,描述警察抓的人中有多少个是小偷的标准。 (b) 描述有多少比例的小偷给警察抓了的标准。 据相分离 (B) 哪一类任务 (C) A. 根据内容检索 B. 建模描述 7) 下面哪种不属于数据预处理的方法 (D) A. Precision,Recall B. Recall,Precision A. Precision,ROC D. Recall,ROC 4) 将原始数据进行集成、 变换、维度规约、数值规约是在以下哪个步骤的任务 (C) 5) A. 频繁模式挖掘 C. 数据预处理 B. D. 当不知道数据所带标签时, 分类和预测 数据流挖掘 可以使用哪种技术促使带同类标签的数据与带其他标签的数 6) A. 分类 C. 关联分析 建立一个模型, B. D. 聚类 隐马尔可夫链 通过这个模型根据已知的变量值来预测其他某个变量值属于数据挖掘的 C. 预测建模 D. 寻找模式和规则

C.聚集 D. 估计遗漏值 8) 假设12 个销售价格记录组已经排序如下:5, 10, 11, 13, 15, 35, 50, 55, 72, 92, 204, 215 使用如下每种方法将它们划分成四个箱。等频(等深)划分时,15 在第几个箱子内(B) A. 第一个 B. 第二个 C. 第三个 D. 第四个 9) 下面哪个不属于数据的属性类型:(D) A. 标称 B. 序数 C.区间 D. 相异 10) 只有非零值才重要的二元属性被称作:( C ) A. 计数属性 B. 离散属性 C.非对称的二元属性 D. 对称属性 11) 以下哪种方法不属于特征选择的标准方法:(D) A. 嵌入 B. 过滤 C.包装 D. 抽样 12) 下面不属于创建新属性的相关方法的是:(B) A. 特征提取 B. 特征修改 C. 映射数据到新的空间 D. 特征构造 13) 下面哪个属于映射数据到新的空间的方法(A) A. 傅立叶变换 B. 特征加权 C. 渐进抽样 D. 维归约 14) 假设属性income 的最大最小值分别是12000元和98000 元。利用最大最小规范化的方 法将属性的值映射到0 至 1 的范围内。对属性income 的73600 元将被转化为:(D) 15) 一所大学内的各年纪人数分别为:一年级200人,二年级160人,三年级130 人,四年 级110 人。则年级属性的众数是:(A) A. 一年级 B. 二年级 C. 三年级 D. 四年级 16) 下列哪个不是专门用于可视化时间空间数据的技术:(B) A. 等高线图 B. 饼图

大数据量的问题是很多面试笔试中经常出现的问题,比如baidu goog le 腾讯这样的一些涉及到海量数据的公司经常会问到。 下面的方法是我对海量数据的处理方法进行了一个一般性的总结,当然这些方法可能并不能完全覆盖所有的问题,但是这样的一些方法也基本可以处理绝大多数遇到的问题。下面的一些问题基本直接来源于公司的面试笔试题目,方法不一定最优,如果你有更好的处理方法,欢迎与我讨论。 1.Bloom filter 适用范围:可以用来实现数据字典,进行数据的判重,或者集合求交集 基本原理及要点: 对于原理来说很简单,位数组+k个独立hash函数。将hash函数对应的值的位数组置1,查找时如果发现所有hash函数对应位都是1说明存在,很明显这个过程并不保证查找的结果是100%正确的。同时也不支持删除一个已经插入的关键字,因为该关键字对应的位会牵动到其他的关键字。所以一个简单的改进就是counting Bloom filter,用一个counter数组代替位数组,就可以支持删除了。 还有一个比较重要的问题,如何根据输入元素个数n,确定位数组m 的大小及hash函数个数。当hash函数个数k=(ln2)*(m/n)时错误率最小。在错误率不大于E的情况下,m至少要等于n*lg(1/E)才能表示任

意n个元素的集合。但m还应该更大些,因为还要保证bit数组里至少一半为0,则m应该>=nlg(1/E)*lge 大概就是nlg(1/E)1.44倍(lg 表示以2为底的对数)。 举个例子我们假设错误率为0.01,则此时m应大概是n的13倍。这样k大概是8个。 注意这里m与n的单位不同,m是bit为单位,而n则是以元素个数为单位(准确的说是不同元素的个数)。通常单个元素的长度都是有很多bit的。所以使用bloom filter内存上通常都是节省的。 扩展: Bloom filter将集合中的元素映射到位数组中,用k(k为哈希函数个数)个映射位是否全1表示元素在不在这个集合中。Counting bloom filter(CBF)将位数组中的每一位扩展为一个counter,从而支持了元素的删除操作。Spectral Bloom Filter(SBF)将其与集合元素的出现次数关联。SBF采用counter中的最小值来近似表示元素的出现频率。 问题实例:给你A,B两个文件,各存放50亿条URL,每条URL占用6 4字节,内存限制是4G,让你找出A,B文件共同的URL。如果是三个乃至n个文件呢? 根据这个问题我们来计算下内存的占用,4G=2^32大概是40亿*8大概是340亿,n=50亿,如果按出错率0.01算需要的大概是650亿个

数据分析处理需求分类 1 事务型处理 在我们实际生活中,事务型数据处理需求非常常见,例如:淘宝网站交易系统、12306网站火车票交易系统、超市POS系统等都属于事务型数据处理系统。这类系统数据处理特点包括以下几点: 一就是事务处理型操作都就是细粒度操作,每次事务处理涉及数据量都很小。 二就是计算相对简单,一般只有少数几步操作组成,比如修改某行得某列; 三就是事务型处理操作涉及数据得增、删、改、查,对事务完整性与数据一致性要求非常高。 四就是事务性操作都就是实时交互式操作,至少能在几秒内执行完成; 五就是基于以上特点,索引就是支撑事务型处理一个非常重要得技术. 在数据量与并发交易量不大情况下,一般依托单机版关系型数据库,例如ORACLE、MYSQL、SQLSERVER,再加数据复制(DataGurad、RMAN、MySQL数据复制等)等高可用措施即可满足业务需求。 在数据量与并发交易量增加情况下,一般可以采用ORALCERAC集群方式或者就是通过硬件升级(采用小型机、大型机等,如银行系统、运营商计费系统、证卷系统)来支撑. 事务型操作在淘宝、12306等互联网企业中,由于数据量大、访问并发量高,必然采用分布式技术来应对,这样就带来了分布式事务处理问题,而分布式事务处理很难做到高效,因此一般采用根据业务应用特点来开发专用得系统来解决本问题。

2数据统计分析 数据统计主要就是被各类企业通过分析自己得销售记录等企业日常得运营数据,以辅助企业管理层来进行运营决策。典型得使用场景有:周报表、月报表等固定时间提供给领导得各类统计报表;市场营销部门,通过各种维度组合进行统计分析,以制定相应得营销策略等. 数据统计分析特点包括以下几点: 一就是数据统计一般涉及大量数据得聚合运算,每次统计涉及数据量会比较大。二就是数据统计分析计算相对复杂,例如会涉及大量goupby、子查询、嵌套查询、窗口函数、聚合函数、排序等;有些复杂统计可能需要编写SQL脚本才能实现. 三就是数据统计分析实时性相对没有事务型操作要求高。但除固定报表外,目前越来越多得用户希望能做做到交互式实时统计; 传统得数据统计分析主要采用基于MPP并行数据库得数据仓库技术.主要采用维度模型,通过预计算等方法,把数据整理成适合统计分析得结构来实现高性能得数据统计分析,以支持可以通过下钻与上卷操作,实现各种维度组合以及各种粒度得统计分析。 另外目前在数据统计分析领域,为了满足交互式统计分析需求,基于内存计算得数据库仓库系统也成为一个发展趋势,例如SAP得HANA平台。 3 数据挖掘 数据挖掘主要就是根据商业目标,采用数据挖掘算法自动从海量数据中发现隐含在海量数据中得规律与知识。

常用数据分析方法:聚类分析、因子分析、相关分析、对应分析、回归分析、方差分析; 问卷调查常用数据分析方法:描述性统计分析、探索性因素分析、Cronbach’a信度系数分析、结构方程模型分析(structural equations modeling) 。 数据分析常用的图表方法:柏拉图(排列图)、直方图(Histogram)、散点图(scatter diagram)、鱼骨图(Ishikawa)、FMEA、点图、柱状图、雷达图、趋势图。 数据分析统计工具:SPSS、minitab、JMP。 常用数据分析方法: 1、聚类分析(Cluster Analysis) 聚类分析指将物理或抽象对象的集合分组成为由类似的对象组成的多个类的分析过程。聚类是将数据分类到不同的类或者簇这样的一个过程,所以同一个簇中的对象有很大的相似性,而不同簇间的对象有很大的相异性。聚类分析是一种探索性的分析,在分类的过程中,人们不必事先给出一个分类的标准,聚类分析能够从样本数据出发,自动进行分类。聚类分析所使用方法的不同,常常会得到不同的结论。不同研究者对于同一组数据进行聚类分析,所得到的聚类数未必一致。 2、因子分析(Factor Analysis) 因子分析是指研究从变量群中提取共性因子的统计技术。因子分析就是从大量的数据中寻找内在的联系,减少决策的困难。 因子分析的方法约有10多种,如重心法、影像分析法,最大似然解、最小平方法、阿尔发抽因法、拉奥典型抽因法等等。这些方法本质上大都属近似方法,是以相关系数矩阵为基础的,所不同的是相关系数矩阵对角线上的值,采用不同的共同性□2估值。在社会学研究中,因子分析常采用以主成分分析为基础的反覆法。 3、相关分析(Correlation Analysis) 相关分析(correlation analysis),相关分析是研究现象之间是否存在某种依存关系,并对具体有依存关系的现象探讨其相关方向以及相关程度。相关关系是一种非确定性的关系,例如,以X和Y分别记一个人的身高和体重,或分别记每公顷施肥量与每公顷小麦产量,则X与Y显然有关系,而又没有确切到可由其中的一个去精确地决定另一个的程度,这就是相关关系。 4、对应分析(Correspondence Analysis) 对应分析(Correspondence analysis)也称关联分析、R-Q型因子分析,通过分析由定性变量构成的交互汇总表来揭示变量间的联系。可以揭示

公需科目大数据培训考试 考试时间:120分钟 选择题中红色代表正确答案,判断题X为错,R为对。 1.根据涂子沛先生所讲,摩尔定律是在哪一年提出的?(单选题1分) A.1988年 B.2004年 C.1965年 D.1989年 2.2015年,贵阳市的呼叫服务产业达到()坐席。(单选题1分) A.3万 B.5万 C.10万 D.20万 3.以下说法错误的是哪项?(单选题1分) A.大数据的思维方式遵循因果逻辑推理 B.摩尔定律是戈登?摩尔提出的 C.图灵测试是阿兰·图 D.ENIAC于1946年诞生 4.茂名PX事件发生后,下列哪个学校的化工系学生在网上进行了一场“PX词条保卫战”?(单选题1分) A.北大 B.清华 C.浙大 D.复旦 5.促进大数据发展部级联席会议在哪一年的4月13日召开了第一次会议?(单选题1分) A.2014年 B.2015年 C.2013年 D.2016年 6.根据涂子沛先生所讲,哪一年被称为大数据元年?(单选题1分) A.2012年 B.2010年 C.2008年 D.2006年 7.数据、信息与知识三者之间的变化趋势是(单选题1分) A.价值先增后减 B.价值递减 C.价值递增 D.价值不变 8.具体来说,摩尔定律就是每()个月,产品的性能将提高一倍。(单选题1分) A.18 B.16 C.12 D.6 9.“()大数据交易所”2015年4月14日正式运营,目前,交易所已有包括京东、华为、阿里巴巴等超过300家会员企业,交易总金额突破6000万元。(单选题1分)

A.毕节 B.安顺 C.贵阳 D.遵义 10.()说明如果联网越多,从介入方式、技术上越来越突破,则网络规模越大、成本越低,网络的成本可能会趋向于零。(单选题1分) A.吉尔德定律 B.摩尔定律 C.梅特卡尔夫定律 D.新摩尔定律 11.以下说法错误的是哪项?(单选题1分) A.大数据会带来机器智能 B.大数据不仅仅是讲数据的体量大 C.大数据的英文名称是large data D.大数据是一种思维方式 12.美国首个联邦首席信息官是下列哪位总统任命的?(单选题1分) A.克林顿 B.奥巴马 C.小布什 D.老布什 13.截至2015年年底,全国电话用户总数达到()。(单选题1分) A.13.37亿户 B.12.37亿户 C.14.37亿户 D.15.37亿户 14.2012年全国各城市支付宝人均支出排名中,位居第七位的是()(单选题1分) A.嘉兴市 B.台中市 C.高雄市 D.嘉义市 15.吴军博士认为过去五十年是()的时代。(单选题1分) A.科尔定律 B.艾尔定律 C.摩尔定律 D.拉尔定律 16.ENIAC诞生于哪一年?(单选题1分) A.1946年 B.1938年 C.1940年 D.1942年 17.梅特卡尔夫定律主要是描述信息网络,指出网络的价值在于网络的互联,联网的接点数与其价值呈现()的方式,联网越多,系统的价值越大。(单选题1分) A.正比 B.对数 C.指数 D.反比 18.根据周琦老师所讲,高德交通报告针对全国()个城市交通状态进行挖掘分析。(单选题1分) A.38 B.21 C.25 D.30 19.2012年全国各城市支付宝人均支出排名中,位居第三位的是()(单选题1分) A.嘉义市 B.杭州市 C.嘉兴市 D.高雄市

第六节数据处理的基本方法 前面我们已经讨论了测量与误差的基本概念,测量结果的最佳值、误差和不确定度的计算。然而,我们进行实验的最终目的是为了通过数据的获得和处理,从中揭示出有关物理量的关系,或找出事物的内在规律性,或验证某种理论的正确性,或为以后的实验准备依据。因而,需要对所获得的数据进行正确的处理,数据处理贯穿于从获得原始数据到得出结论的整个实验过程。包括数据记录、整理、计算、作图、分析等方面涉及数据运算的处理方法。常用的数据处理方法有:列表法、图示法、图解法、逐差法和最小二乘线性拟合法等,下面分别予以简单讨论。 列表法是将实验所获得的数据用表格的形式进行排列的数据处理方法。列表法的作用有两种:一是记录实验数据,二是能显示出物理量间的对应关系。其优点是,能对大量的杂乱无章的数据进行归纳整理,使之既有条不紊,又简明醒目;既有助于表现物理量之间的关系,又便于及时地检查和发现实验数据是否合理,减少或避免测量错误;同时,也为作图法等处理数据奠定了基础。 用列表的方法记录和处理数据是一种良好的科学工作习惯,要设 计出一个栏目清楚、行列分明的表格,也需要在实验中不断训练,逐步掌握、熟练,并形成习惯。 一般来讲,在用列表法处理数据时,应遵从如下原则:

(1) 栏目条理清楚,简单明了,便于显示有关物理量的关系。 (2) 在栏目中,应给出有关物理量的符号,并标明单位(一般不重复写在每个数据的后面)。 (3) 填入表中的数字应是有效数字。 (4) 必要时需要加以注释说明。 例如,用螺旋测微计测量钢球直径的实验数据列表处理如下。 用螺旋测微计测量钢球直径的数据记录表 从表中,可计算出 D i D = n = 5.9967 ( mm)

2017贵州大数据考试题目和答案

? 1.大数据元年是指(单选题1分)得分:1分 o A.2010年 o B.2011年 o C.2012年 o D.2013年 ? 2.《国务院办公厅关于促进和规范健康医疗大数据应用发展的指导意见》提出,到2020年,统筹区域布局,依托现有资源建成()区域临床医学数据示范中心。(单选题1分)得分:1分 o A.100个 o B.200个 o C.300个 o D.400个

? 3.近几年,我国电子信息产业一直保持了()以上的年增长速度,成为国民经济各个领域中间的佼佼者。(单选题1分)得分:1分 o A.7% o B.8% o C.9% o D.10% ? 4.宁家骏委员指出,过去我们研制一个新型号的航天器,平均需要多长时间?(单选题1分)得分:1分 o A.1-2年 o B.3-4年 o C.5-6年 o D.7-8年

? 5.具体来说,摩尔定律就是每()个月,产品的性能将提高一倍。(单选题1分)得分:1分 o A.6 o B.12 o C.16 o D.18 ? 6.以下说法错误的是哪项?(单选题1分)得分:1分 o A.大数据是一种思维方式 o B.大数据不仅仅是讲数据的体量大 o C.大数据会带来机器智能 o D.大数据的英文名称是large data ?7.第一个提出大数据概念的公司是(单选题1分)得分:1分

o A.微软公司 o B.脸谱公司 o C.谷歌公司 o D.麦肯锡公司 ?8.大数据要求企业设置的岗位是(单选题1分)得分:0分 o A.首席分析师和首席工程师 o B.首席信息官和首席工程师 o C.首席分析师和首席数据官 o D.首席信息官和首席数据官 ?9.世界上第一台电子计算机(ENIAC)是在哪一年宣告诞生的?(单选题1分)得分:1分 o A.1946年 o B.1947年

通信网安全理论与技术大数据处理中的安全 学院:电子信息工程学院 专业:通信工程 学生姓名:李海峰 学号:13111026 指导教师:穆海冰 2013年10月16

中文摘要 大数据要求在合理时间内撷取、管理、处理、并整理海量数据,并将其成为帮助企业经营决策更积极目的的资讯。比较一般数据处理有着数据量巨大、数据类型多样、价值密度低、处理速度快等特点。 作为新兴产物,大数据仍然有许多亟需解决的安全问题。从基础技术角度来看,大数据依托的基础技术是NoSQL(非关系型数据库),NoSQL允许不断对数据记录添加属性,其前瞻安全性变得非常重要。从核心价值角度来看,大数据关键在于数据分析和利用,但数据分析技术的发展,对用户隐私产生极大的威胁。 本文首先讲述什么是大数据,及大数据的特点,然后根据其特点分析,说明大数据存在的一些安全隐患,最后阐述怎样解决大数据中存在的一些安全问题。 关键词:大数据;安全;NoSQL;虚拟化

Abstract Large data requires a reasonable time to capture, manage, process, and organize vast amounts of data, and make these data become more active to help business decision-making purposes information. Compared with general data,there are huge amount of data, many kinds of data types, the value of low density, processing speed and other characteristics. As a new product, there are still many large data security problems needed to solve. From basic technical perspective, NoSQL (non-relational databases) is relied by large data, NoSQL allows data records continuously add attributes, and its forward-looking security becomes very important. From the perspective of core values, the key lies in big data analysis and use of data, but with the development of data analysis technology, user privacy is Under threat. This paper first describes what is big data, and large data characteristics, and then analyzes the existence of some large data security risks according to its characteristics.Finally explain how to solve some existing large data security issues. Keywords: Big data;Safe; NoSQL; Virtualization

PB级大数据存储与分析解析 部门: xxx 时间: xxx 制作人:xxx 整理范文,仅供参考,可下载自行修改

PB级大数据存储技术与分析技术解读 2018年12月2日 目录 一、PB级大数据存储技术解读2 二、大数据分析系统应规避的问题5 三、剖析Hadoop和大数据的七误解8 四、6个优秀的开源文件系统助力大数据分析13 五、大数据与关系型数据库是否水火不容?NO (17) 六、大数据探讨:如何整理1700亿条Twitter发布信息?21 七、畅谈阿里巴巴的大数据梦26 八、Twitter利用Storm系统处理实时大数据35 一、PB级大数据存储技术解读 对于存储管理人员来说,大数据应该分为大数据存储和大数据分析,这两者的关系是——大数据存储是用于大数据分析的。然而,到目前为止这是两种截然不同的计算机技术领域。本文就重点解读一下PB级大数据存储技术,希望对您有所帮助。b5E2RGbCAP

越来越多的存储产品都在融入大数据的概念和功能,并使之成为产品的一大卖点。但对于从事存储管理的专业人员来说,对“大数据”在具体应用场景中的特点和区别有所了解。p1EanqFDPw 大数据存储致力于研发可以扩展至PB甚至EB级别的数据存储平台;大数据分析关注在最短时间内处理大量不同类型的数据集。DXDiTa9E3d 在快速变化的技术趋势中有两个特点需要存储管理人员重视起来。 第一,大数据分析流程和传统的数据仓库的方式完全不同,其已经变成了业务部门级别和数据中心级别的关键应用。这也是存储管理员的切入点。随着基础平台(分布式计算或其它架构>变得业务关键化,用户群较以往更加地依赖这一平台,这也使得其成为企业安全性、数据保护和数据管理策略的关键课题。RTCrpUDGiT

大数据分析与处理方法解读 【文章摘要】要知道,大数据已不再是数据大,最重要的现实就是对大数据进行分析,只有通过分析才能获取很多智能的,深入的,有价值的信息。 越来越多的应用涉及到大数据,这些大数据的属性,包括数量,速度,多样性等等都是呈现了大数据不断增长的复杂性,所以,大数据的分析方法在大数据领域就显得尤为重要,可以说是决定最终信息是否有价值的决定性因素。基于此,大数据分析的方法理论有哪些呢? 大数据分析的五个基本方面 PredictiveAnalyticCapabilities(预测性分析能力) 数据挖掘可以让分析员更好的理解数据,而预测性分析可以让分析员根据可视化分析和数据挖掘的结果做出一些预测性的判断。 DataQualityandMasterDataManagement(数据质量和数据管理) 数据质量和数据管理是一些管理方面的最佳实践。通过标准化的流程和工具对数据进行处理可以保证一个预先定义好的高质量的分析结果。 AnalyticVisualizations(可视化分析) 不管是对数据分析专家还是普通用户,数据可视化是数据分析工具最基本的要求。可视化可以直观的展示数据,让数据自己说话,让观众听到结果。 SemanticEngines(语义引擎) 我们知道由于非结构化数据的多样性带来了数据分析的新的挑战,我们需要一系列的工具去解析,提取,分析数据。语义引擎需要被设计成能够从“文档”中智能提取信息。 DataMiningAlgorithms(数据挖掘算法) 可视化是给人看的,数据挖掘就是给机器看的。集群、分割、孤立点分析还有其他的算法让我们深入数据内部,挖掘价值。这些算法不仅要处理大数据的量,也要处理大数据的速度。 假如大数据真的是下一个重要的技术革新的话,我们最好把精力关注在大数据能给我们带来的好处,而不仅仅是挑战。 大数据处理

大数据量,海量数据处理方法总结 从目前大公司用的比较多的数据处理系统角度,你可以去看看关于Hadoop,Hbase,Hive的书,纯粹讲海量数据处理的没见过, https://www.doczj.com/doc/1b12045320.html,/~ullman/mmds.html,这个是关于海量数据挖掘的 大数据量的问题是很多面试笔试中经常出现的问题,比如baidu google 腾讯这样的一些涉及到海量数据的公司经常会问到。 下面的方法是我对海量数据的处理方法进行了一个一般性的总结,当然这些方法可能并不能完全覆盖所有的问题,但是这样的一些方法也基本可以处理绝大多数遇到的问题。下面的一些问题基本直接来源于公司的面试笔试题目,方法不一定最优,如果你有更好的处理方法,欢迎与我讨论。 1.Bloom filter 适用范围:可以用来实现数据字典,进行数据的判重,或者集合求交集 基本原理及要点: 对于原理来说很简单,位数组+k个独立hash函数。将hash函数对应的值的位数组置1,查找时如果发现所有hash函数对应位都是1说明存在,很明显这个过程并不保证查找的结果是100%正确的。同时也不支持删除一个已经插入的关键字,因为该关键字对应的位会牵动到其他的关键字。所以一个简单的改进就是counting Bloom filter,用一个counter 数组代替位数组,就可以支持删除了。 还有一个比较重要的问题,如何根据输入元素个数n,确定位数组m的大小及hash函数个数。当hash函数个数k=(ln2)*(m/n)时错误率最小。在错误率不大于E的情况下,m 至少要等于n*lg(1/E)才能表示任意n个元素的集合。但m还应该更大些,因为还要保证bit数组里至少一半为0,则m应该>=nlg(1/E)*lge 大概就是nlg(1/E)1.44倍(lg表示以2为底的对数)。 举个例子我们假设错误率为0.01,则此时m应大概是n的13倍。这样k大概是8个。 注意这里m与n的单位不同,m是bit为单位,而n则是以元素个数为单位(准确的说是不同元素的个数)。通常单个元素的长度都是有很多bit的。所以使用bloom filter内存上通常都是节省的。 扩展: Bloom filter将集合中的元素映射到位数组中,用k(k为哈希函数个数)个映射位是否全1表示元素在不在这个集合中。Counting bloom filter(CBF)将位数组中的每一位扩展为一个counter,从而支持了元素的删除操作。Spectral Bloom Filter(SBF)将其与集

第一组试题 一、选择题 1、以下哪个不是大数据的特征(C ) A. 价值密度低 B. 数据类型繁多 C.访问时间短 D. 处理速度快 2、当前大数据技术的基础是由( C )首先提出的。(单选题,本题2 分)A:微软 B:百度 C:谷歌 D:阿里巴巴 3、大数据的起源是(C )。(单选题,本题2 分) A:金融 B:电信 C:互联网 D:公共管理 4、根据不同的业务需求来建立数据模型,抽取最有意义的向量,决定选取哪种方法的数据分析角色人员是( C )。(单选题,本题 2 分) A:数据管理人员 B:数据分析员 C:研究科学家 D:软件开发工程师 5、(C )反映数据的精细化程度,越细化的数据,价值越高。(单选题,本题 2 分) A:规模 B:活性 C:颗粒度 D:关联度 6、智能健康手环的应用开发,体现了( C )的数据采集技术的应用。(单选 题,本题 2 分) A:统计报表 B:网络爬虫 C:传感器 D:API 接口 7、下列关于数据重组的说法中,错误的是(C )。(单选题,本题2 分)A:数据重组实现的关键在于多源数据融合和数据集成 B:数据重组能够使数据焕发新的光芒 C:数据重组是数据的重新生产和重新采集 D:数据重组有利于实现新颖的数据模式创新

8、智慧城市的构建,不包含(C )。(单选题,本题2 分) A:数字城市 B:物联网 C:联网监控 D:云计算 9、当前社会中,最为突出的大数据环境是(C )。(单选题,本题2 分)A:综合国力 B:物联网 C:互联网 D:自然资源 二、判断题 1.对于大数据而言,最基本。最重要的是要求就是减少错误、保证质量。因此,大数据收集的信息要尽量精确。() 2. 对于大数据而言,在数据规模上强调相对数据而不是绝对数据。() 3.基于大数据的营销模式和传统营销模式,传统营销模式比大数据营销模式投入更小。() 4.大数据具有体量大、结构单一、时效性强的特征。() 三、简答题 1.大数据发展过程中遇到的问题有哪些? 解析: (1)大数据是全数据,忽视甚至蔑视抽样; (2)连续数据就是大数据; (3)数据量级大是大数据; (4)数据量大好于量小。 2.咸鱼APP在投入使用发展过程中有哪些不足之处? 解析: (1)交易信任危机 (2)物流问题 (3)商品的售后及维修问题

大数据并行处理方法与举例 1、介绍 1.1 背景 互联网行业中,日常运营中生成、累积的用户网络行为数据等大数据规模相当庞大,以 至于不能用G或T来衡量。大数据到底有多大?一组名为“互联网上一天”的数据告诉我 们,一天之中,互联网产生的全部内容可以刻满1.68亿张DVD;发出的邮件有2940亿封之 多(相当于美国两年的纸质信件数量);发出的社区帖子达200万个(相当于《时代》杂志770年的文字量);卖出的手机为37.8万台,高于全球每天出生的婴儿数量37.1万……而到 了2020年,全世界所产生的数据规模将达到今天的44倍。可以说,人类社会已经步入了大 数据时代。然而,大数据用现有的一般技术又难以处理,并且海量的非结构化数据带来的并 不仅仅是存储、传输的问题,做好海量非结构化数据分析以及快速处理以更好的服务客户、 提高业务效率已经成为紧迫的问题。 伴随着数据规模的爆炸式增长,数据并行分析处理技术也在不断进行着改进,以满足大 数据处理对实时性的需求。数据并行处理(Data Parallel Processing)是指计算机系统能够同 时执行两个或更多个处理机的一种计算方法。并行处理的主要目的是节省大型和复杂问题的 解决时间。为使用并行处理,首先需要对程序进行并行化处理,也就是说将工作各部分分配 到不同处理机中。当下比较流行的大数据分布式计算应用最具有代表性的有:MapReduce、Spark和GraphX。下面详细介绍这三种应用的基本原理及应用例子。 1.2 MapReduce 2006年由Apache基金会开发的Hadoop项目,由分布式文件系统HDFS和MapReduce 工作引擎所组成。其中MapReduce采用“分而治之”的思想,把对大规模数据集的操作,分发给一个主节点管理下的各个分节点共同完成,然后通过整合各个节点的中间结果,得到最终结果。简单地说,MapReduce就是“任务的分解与结果的汇总”。在Hadoop中,用于执行MapReduce任务的机器角色有两个:一个是JobTracker;另一个是TaskTracker,JobTracker是用于调度工作的,TaskTracker是用于执行工作的。一个Hadoop集群中只有一台JobTracker。在分布式计算中,MapReduce框架负责处理了并行编程中分布式存储、工作调度、负载均衡、容错均衡、容错处理以及网络通信等复杂问题,把处理过程高度抽象为两个函数:map和reduce,map负责把任务分解成多个任务,reduce负责把分解后多任务处理的结果汇总起来。MapReduce极大地方便了编程人员在不会分布式并行编程的情况下,将自己的程序运行在分布式系统上。 MapReduce在企业中被非常广泛地利用,包括分布grep、分布排序、web连接图反转、

常用数据分析方法论 ——摘自《谁说菜鸟不会数据分析》 数据分析方法论主要用来指导数据分析师进行一次完整的数据分析,它更多的是指数据分析思路,比如主要从哪几方面开展数据分析?各方面包含什么内容和指标? 数据分析方法论主要有以下几个作用: ●理顺分析思路,确保数据分析结构体系化 ●把问题分解成相关联的部分,并显示它们之间的关系 ●为后续数据分析的开展指引方向 ●确保分析结果的有效性及正确性 常用的数据分析理论模型 用户使用行为STP理论 SWOT …… 5W2H 时间管理生命周期 逻辑树 金字塔SMART原则 …… PEST分析法 PEST分析理论主要用于行业分析 PEST分析法用于对宏观环境的分析。宏观环境又称一般环境,是指影响一切行业和企业的各种宏观力量。 对宏观环境因素作分析时,由于不同行业和企业有其自身特点和经营需要,分析的具体内容会有差异,但一般都应对政治、经济、技术、社会,这四大类影响企业的主要外部环境因素进行分析。

以下以中国互联网行业分析为例。此处仅为方法是用实力,并不代表互联网行业分析只需要作这几方面的分析,还可根据实际情况进一步调整和细化相关分析指标:

5W2H分析法 5W2H分析理论的用途广泛,可用于用户行为分析、业务问题专题分析等。 利用5W2H分析法列出对用户购买行为的分析:(这里的例子并不代表用户购买行为只有以下所示,要做到具体问题具体分析)

逻辑树分析法 逻辑树分析理论课用于业务问题专题分析 逻辑树又称问题树、演绎树或分解树等。逻辑树是分析问题最常使用的工具之一,它将问题的所有子问题分层罗列,从最高层开始,并逐步向下扩展。 把一个已知问题当成树干,然后开始考虑这个问题和哪些相关问题有关。 (缺点:逻辑树分析法涉及的相关问题可能有遗漏。)

《海量数据挖掘技术及工程实践》题目 一、单选题(共80题) 1)( D )的目的缩小数据的取值范围,使其更适合于数据挖掘算法的需要,并且能够得到 和原始数据相同的分析结果。 A.数据清洗 B.数据集成 C.数据变换 D.数据归约 2)某超市研究销售纪录数据后发现,买啤酒的人很大概率也会购买尿布,这种属于数据挖 掘的哪类问题?(A) A. 关联规则发现 B. 聚类 C. 分类 D. 自然语言处理 3)以下两种描述分别对应哪两种对分类算法的评价标准? (A) (a)警察抓小偷,描述警察抓的人中有多少个是小偷的标准。 (b)描述有多少比例的小偷给警察抓了的标准。 A. Precision,Recall B. Recall,Precision A. Precision,ROC D. Recall,ROC 4)将原始数据进行集成、变换、维度规约、数值规约是在以下哪个步骤的任务?(C) A. 频繁模式挖掘 B. 分类和预测 C. 数据预处理 D. 数据流挖掘 5)当不知道数据所带标签时,可以使用哪种技术促使带同类标签的数据与带其他标签的数 据相分离?(B) A. 分类 B. 聚类 C. 关联分析 D. 隐马尔可夫链 6)建立一个模型,通过这个模型根据已知的变量值来预测其他某个变量值属于数据挖掘的 哪一类任务?(C) A. 根据内容检索 B. 建模描述 C. 预测建模 D. 寻找模式和规则 7)下面哪种不属于数据预处理的方法? (D) A.变量代换 B.离散化

C.聚集 D.估计遗漏值 8)假设12个销售价格记录组已经排序如下:5, 10, 11, 13, 15, 35, 50, 55, 72, 92, 204, 215 使用如下每种方法将它们划分成四个箱。等频(等深)划分时,15在第几个箱子内? (B) A.第一个 B.第二个 C.第三个 D.第四个 9)下面哪个不属于数据的属性类型:(D) A.标称 B.序数 C.区间 D.相异 10)只有非零值才重要的二元属性被称作:( C ) A.计数属性 B.离散属性 C.非对称的二元属性 D.对称属性 11)以下哪种方法不属于特征选择的标准方法: (D) A.嵌入 B.过滤 C.包装 D.抽样 12)下面不属于创建新属性的相关方法的是: (B) A.特征提取 B.特征修改 C.映射数据到新的空间 D.特征构造 13)下面哪个属于映射数据到新的空间的方法? (A) A.傅立叶变换 B.特征加权 C.渐进抽样 D.维归约 14)假设属性income的最大最小值分别是12000元和98000元。利用最大最小规范化的方 法将属性的值映射到0至1的范围内。对属性income的73600元将被转化为:(D) A.0.821 B.1.224 C.1.458 D.0.716 15)一所大学内的各年纪人数分别为:一年级200人,二年级160人,三年级130人,四年 级110人。则年级属性的众数是: (A) A.一年级 B.二年级 C.三年级 D.四年级