首先,以上分析本质上都属于排序分析(Ordination analysis)。排序(ordination)的过程就是在一个可视化的低维空间(通常是二维)重新排列这些样方,使得样方之间的距离最大程度地反映出平面散点图内样方之间的关系信息。

1、只使用物种组成数据的排序称作非限制性排序(unconstrained ordination)

(1)主成分分析(principal components analysis,PCA)

(2)对应分析(correspondence analysis, CA)

(3)去趋势对应分析(Detrended correspondence analysis, DCA)

(3)主坐标分析(principal coordinate analysis, PCoA)

(4)非度量多维尺度分析(non-metric multi-dimensional scaling, NMDS)

2、同时使用物种和环境因子组成数据的排序叫作限制性排序(constrained ordination)

(1)冗余分析(redundancy analysis,RDA)

(2)典范对应分析(canonical correspondence analysis, CCA)

让我们来仔细看看PCA与PCoA分析:

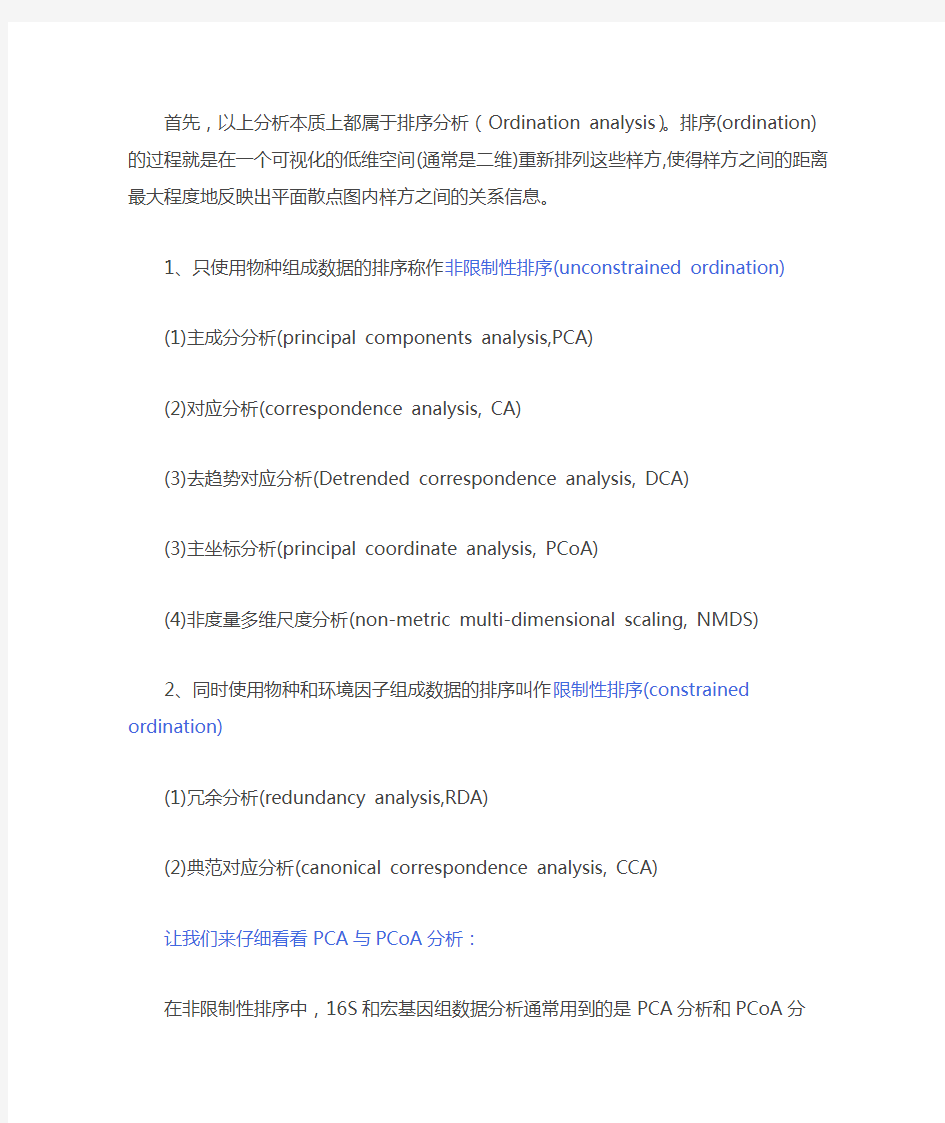

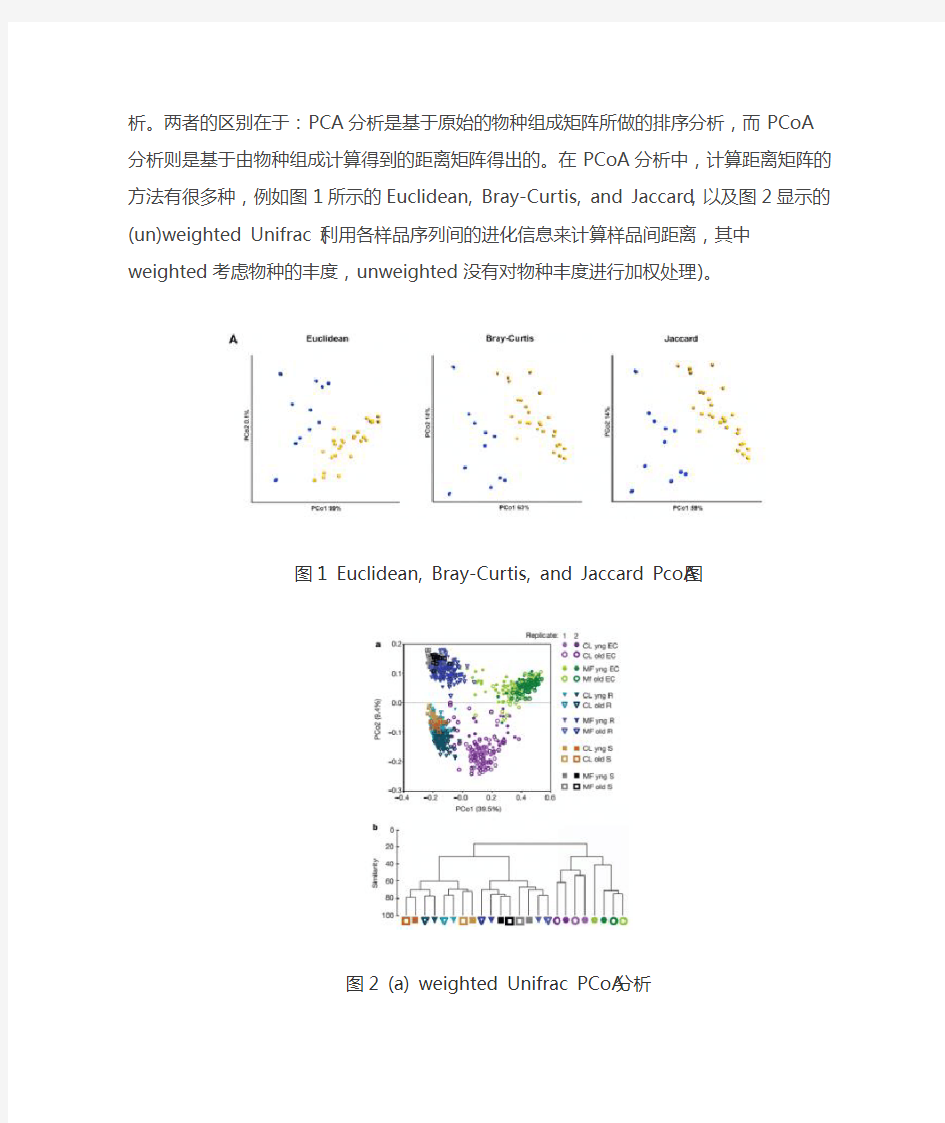

在非限制性排序中,16S和宏基因组数据分析通常用到的是PCA分析和PCoA分析。两者的区别在于:PCA分析是基于原始的物种组成矩阵所做的排序分析,而PCoA分析则是基于由物种组成计算得到的距离矩阵得出的。在PCoA分析中,计算距离矩阵的方法有很多种,例如图1所示的Euclidean, Bray-Curtis, and Jaccard,以及图2显示的(un)weighted Unifrac (利用各样品序列间的进化信息来计算样品间距离,其中weighted考虑物种的丰度,unweighted没有对物种丰度进行加权处理)。

图1 Euclidean, Bray-Curtis, and Jaccard PcoA图

图2 (a) weighted Unifrac PCoA分析

PCoA1维度将根内样品与根周边和土壤样品很好的分开;而PCoA2能够将不同土壤的样品很好的区分开来;(b)用pairwise-Bray-Curtis相似度对样品进行聚类。

再来看看CCA与RDA分析:

限制性排序主要有CCA分析和RDA分析。RDA基于线性模型,CCA则是基于单峰模型。一般我们会选择CCA来做直接梯度分析。但是,如果CCA排序的效果不太好,就可以考虑换做用RDA分析。RDA或CCA选择原则:先用species-sample资料做DCA分析,看分析结果中Lengths of gradient 的第一轴的大小,如果大于4.0,就应选CCA;如果在3.0-4.0之间,选RDA和CCA均可;如果小于3.0, RDA的结果要好于CCA。图3是CCA分析图,图中箭头代表不同的环境因子,射线越长表示该环境因子影响越大。环境因子之间的夹角为锐角时表示两个环境因子之间呈正相关关系,钝角时呈负相关关系。

图3 CCA分析图

箭头代表不同的环境因子,射线越长表示该环境因子影响越大。环境因子之间的夹角为锐角时表示两个环境因子之间呈正相关关系,钝角时呈负相关关系。

主成分分析(Principal Component Analysis ,PCA ) 主成分分析(Principal Component Analysis ,PCA )是一种掌握事物主要矛盾的统计分析方法,它可以从多元事物中解析出主要影响因素,揭示事物的本质,简化复杂的问题。计算主成分的目的是将高维数据投影到较低维空间。给定n 个变量的m 个观察值,形成一个n ′m 的数据矩阵,n 通常比较大。对于一个由多个变量描述的复杂事物,人们难以认识,那么是否可以抓住事物主要方面进行重点分析呢?如果事物的主要方面刚好体现在几个主要变量上,我们只需要将这几个变量分离出来,进行详细分析。但是,在一般情况下,并不能直接找出这样的关键变量。这时我们可以用原有变量的线性组合来表示事物的主要方面,PCA 就是这样一种分析方法。PCA 主要用于数据降维,对于一系列例子的特征组成的多维向量,多维向量里的某些元素本身没有区分性,比如某个元素在所有的例子中都为1,或者与1差距不大,那么这个元素本身就没有区分性,用它做特征来区分,贡献会非常小。所以我们的目的是找那些变化大的元素,即方差大的那些维,而去除掉那些变化不大的维,从而使特征留下的都是“精品”,而且计算量也变小了。对于一个k维的特征来说,相当于它的每一维特征与其他维都是正交的(相当于在多维坐标系中,坐标轴都是垂直的),

那么我们可以变化这些维的坐标系,从而使这个特征在某些维上方差大,而在某些维上方差很小。例如,一个45度倾斜的椭圆,在第一坐标系,如果按照x,y坐标来投影,这些点的x和y的属性很难用于区分他们,因为他们在x,y轴上坐标变化的方差都差不多,我们无法根据这个点的某个x属性来判断这个点是哪个,而如果将坐标轴旋转,以椭圆长轴为x轴,则椭圆在长轴上的分布比较长,方差大,而在短轴上的分布短,方差小,所以可以考虑只保留这些点的长轴属性,来区分椭圆上的点,这样,区分性比x,y轴的方法要好!所以我们的做法就是求得一个k维特征的投影矩阵,这个投影矩阵可以将特征从高维降到低维。投影矩阵也可以叫做变换矩阵。新的低维特征必须每个维都正交,特征向量都是正交的。通过求样本矩阵的协方差矩阵,然后求出协方差矩阵的特征向量,这些特征向量就可以构成这个投影矩阵了。特征向量的选择取决于协方差矩阵的特征值的大小。举一个例子:对于一个训练集,100个对象模板,特征是10维,那么它可以建立一个100*10的矩阵,作为样本。求这个样本的协方差矩阵,得到一个10*10的协方差矩阵,然后求出这个协方差矩阵的特征值和特征向量,应该有10个特征值和特征向量,我们根据特征值的大小,取前四个特征值所对应的特征向量,构成一个10*4的矩阵,这个矩阵就是我们要求的特征矩阵,100*10的样本矩阵乘以这个10*4的

一、简介 PCA(Principal Components Analysis)即主成分分析,是图像处理中经常用到的降维方法,大家知道,我们在处理有关数字图像处理方面的问题时,比如经常用的图像的查询问题,在一个几万或者几百万甚至更大的数据库中查询一幅相近的图像。这时,我们通常的方法是对图像库中的图片提取响应的特征,如颜色,纹理,sift,surf,vlad等等特征,然后将其保存,建立响应的数据索引,然后对要查询的图像提取相应的特征,与数据库中的图像特征对比,找出与之最近的图片。这里,如果我们为了提高查询的准确率,通常会提取一些较为复杂的特征,如sift,surf等,一幅图像有很多个这种特征点,每个特征点又有一个相应的描述该特征点的128维的向量,设想如果一幅图像有300个这种特征点,那么该幅图像就有300*vector(128维)个,如果我们数据库中有一百万张图片,这个存储量是相当大的,建立索引也很耗时,如果我们对每个向量进行PCA处理,将其降维为64维,是不是很节约存储空间啊?对于学习图像处理的人来说,都知道PCA是降维的,但是,很多人不知道具体的原理,为此,我写这篇文章,来详细阐述一下PCA及其具体计算过程: 二、PCA原理 1、原始数据: 为了方便,我们假定数据是二维的,借助网络上的一组数据,如下: x=[2.5, 0.5, 2.2, 1.9, 3.1, 2.3, 2, 1,1.5, 1.1]T y=[2.4, 0.7, 2.9, 2.2, 3.0, 2.7, 1.6, 1.1, 1.6, 0.9]T 2、计算协方差矩阵 什么是协方差矩阵?相信看这篇文章的人都学过数理统计,一些基本的常识都知道,但是,也许你很长时间不看了,都忘差不多了,为了方便大家更好的理解,这里先简单的回顾一下数理统计的相关知识,当然如果你知道协方差矩阵的求法你可以跳过这里。 (1)协方差矩阵: 首先我们给你一个含有n个样本的集合,依次给出数理统计中的一些相关概念: 均值: 标准差:

主元分析(PCA)理论分析及应用 什么是PCA PCA是Principal component analysis的缩写,中文翻译为主元分析。它是一种对数据进行分析的技术,最重要的应用是对原有数据进行简化。正如它的名字:主元分析,这种方法可以有效的找出数据中最“主要”的元素和结构,去除噪音和冗余,将原有的复杂数据降维,揭示隐藏在复杂数据背后的简单结构。它的优点是简单,而且无参数限制,可以方便的应用与各个场合。因此应用极其广泛,从神经科学到计算机图形学都有它的用武之地。被誉为应用线形代数最价值的结果之一。 在以下的章节中,不仅有对PCA的比较直观的解释,同时也配有较为深入的分析。首先将从一个简单的例子开始说明PCA应用的场合以及想法的由来,进行一个比较直观的解释;然后加入数学的严格推导,引入线形代数,进行问题的求解。随后将揭示PCA与SVD(Singular Value Decomposition)之间的联系以及如何将之应用于真实世界。最后将分析PCA理论模型的假设条件以及针对这些条件可能进行的改进。 一个简单的模型 在实验科学中我常遇到的情况是,使用大量的变量代表可能变化的因素,例如光谱、电压、速度等等。但是由于实验环境和观测手段的限制,实验数据往往变得极其的复杂、混乱和冗余的。如何对数据进行分析,取得隐藏在数据背后的变量关系,是一个很困难的问题。在神经科学、气象学、海洋学等等学科实验中,假设的变量个数可能非常之多,但是真正的影响因素以及它们之间的关系可能又是非常之简单的。 下面的模型取自一个物理学中的实验。它看上去比较简单,但足以说明问题。如错误!未找到引用源。所示。这是一个理想弹簧运动规律的测定实验。假设球是连接在一个无质量无摩擦的弹簧之上,从平衡位置沿x轴拉开一定的距离然后释放。 图表错误!未定义书签。

一、基本原理 主成分分析是数学上对数据降维的一种方法。其基本思想是设法将原来众多的具有一定相关性的指标X1,X2,…,XP (比如p 个指标),重新组合成一组较少个数的互不相关的综合指标Fm 来代替原来指标。那么综合指标应该如何去提取,使其既能最大程度的反映原变量Xp 所代表的信息,又能保证新指标之间保持相互无关(信息不重叠)。 设F1表示原变量的第一个线性组合所形成的主成分指标,即 11112121...p p F a X a X a X =+++,由数学知识可知,每一个主成分所提取的信息量可 用其方差来度量,其方差Var(F1)越大,表示F1包含的信息越多。常常希望第一主成分F1所含的信息量最大,因此在所有的线性组合中选取的F1应该是X1,X2,…,XP 的所有线性组合中方差最大的,故称F1为第一主成分。如果第一主成分不足以代表原来p 个指标的信息,再考虑选取第二个主成分指标F2,为有效地反映原信息,F1已有的信息就不需要再出现在F2中,即F2与F1要保持独立、不相关,用数学语言表达就是其协方差Cov(F1, F2)=0,所以F2是与F1不相关的X1,X2,…,XP 的所有线性组合中方差最大的,故称F2为第二主成分,依此类推构造出的F1、F2、……、Fm 为原变量指标X1、X2……XP 第一、第二、……、第m 个主成分。 11111221221122221122...............p p p p m m m mp p F a X a X a X F a X a X a X F a X a X a X =+++??=+++?? ??=+++? 根据以上分析得知: (1) Fi 与Fj 互不相关,即Cov(Fi ,Fj) = 0,并有Var(Fi)=ai ’Σai ,其 中Σ为X 的协方差阵 (2)F1是X1,X2,…,Xp 的一切线性组合(系数满足上述要求)中方差最大的,……,即Fm 是与F1,F2,……,Fm -1都不相关的X1,X2,…,XP 的所有线性组合中方差最大者。 F1,F2,…,Fm (m ≤p )为构造的新变量指标,即原变量指标的第一、第二、……、第m 个主成分。 由以上分析可见,主成分分析法的主要任务有两点: (1)确定各主成分Fi (i=1,2,…,m )关于原变量Xj (j=1,2 ,…, p )的表达式,即系数ij a ( i=1,2,…,m ; j=1,2 ,…,p )。从数学上可以证明,原变量协方差矩阵的特征根是主成分的方差,所以前m 个较大特征根就代表前m 个较大的主成分方差值;原变量协方差矩阵前m 个较大的特征值i λ(这样选取才能保证主成分的方差依次最大)所对应的特征向量就是相应主成分Fi 表达式的系数i a ,为了加以限制,系数i a 启用的是i λ对应的单位化的特征向量,

第二章 主成分分析 1. 主成分分析的基本原理 统计学上PCA 的定义为用几个较少的综合指标来代替原来较多的指标,而这些较少的综合指标既能尽多地反映原来较多指标的有用信息,且相互之间又是无关的。作为一种建立在统计最优原则基础上的分析方法,主成分分析具有较长的发展历史。在1901年,Pearson 首先将变换引入生物学领域,并重新对线性回归进行了分析,得出了变换的一种新形式。Hotelling 于1933年则将其与心理测验学领域联系起来,把离散变量转变为无关联系数。在概率论理论建立的同时,主成分分析又单独出现,由Karhunen 于1947年提出,随后Loeve 于1963年将其归纳总结。因此,主成分分析也被称为K-L 变换[1]。 PCA 运算就是一种确定一个坐标系统的直交变换,在这个新的坐标系统下,变换数据点的方差沿新的坐标轴得到了最大化。这些坐标轴经常被称为是主成分。PCA 运算是一个利用了数据集的统计性质的特征空间变换,这种变换在无损或很少损失了数据集的信息的情况下降低了数据集的维数。 PCA 的基本原理如下:给定输入数据矩阵m n X ? (通常m n >),它由一 些中心化的样本数据1{}m i i x =构成,其中n i x R ∈且 10m i i x ==∑ (2-1) PCA 通过式(2-2)将输入数据矢量i x 变换为新的矢量 T i i s U x = (2-2) 其中:U 是一个n n ?正交矩阵,它的第i 列i U 是样本协方差矩阵 1 1n T i i i C x x n ==∑ (2-3) 的第i 个本征矢量。换句话说,PCA 首先求解如下的本征问题

主成分分析法(PCA) 在实际问题中,我们经常会遇到研究多个变量的问题,而且在多数情况下,多个变量之间常常存在一定的相关性。由于变量个数较多再加上变量之间的相关性,势必增加了分析问题的复杂性。如何从多个变量中综合为少数几个代表性变量,既能够代表原始变量的绝大多数信息,又互不相关,并且在新的综合变量基础上,可以进一步的统计分析,这时就需要进行主成分分析。 I. 主成分分析法(PCA)模型 (一)主成分分析的基本思想 主成分分析是采取一种数学降维的方法,找出几个综合变量来代替原来众多的变量,使这些综合变量能尽可能地代表原来变量的信息量,而且彼此之间互不相关。这种将把多个变量化为少数几个互相无关的综合变量的统计分析方法就叫做主成分分析或主分量分析。 主成分分析所要做的就是设法将原来众多具有一定相关性的变量,重新组合为一组新的相互无关的综合变量来代替原来变量。通常,数学上的处理方法就是将原来的变量做线性组合,作为新的综合变量,但是这种组合如果不加以限制,则可以有很多,应该如何选择呢?如果将选取的第一个线性组合即第一个综合变量记为1F ,自然希望它尽可能多地反映原来变量的信息,这里“信息”用方差来测量,即希望)(1F Var 越大,表示1F 包含的信息越多。因此在所有的线性组合中所选取的1F 应该是方差最大的,故称1F 为第一主成分。如果第一主成分不足以代表原来p 个变量的信息,再考虑选取2F 即第二个线性组合,为了有效地反映原来信息,1F 已有的信息就不需要再出现在2F 中,用数学语言表达就是要求 0),(21=F F Cov ,称2F 为第二主成分,依此类推可以构造出第三、四……第p 个主成分。 (二)主成分分析的数学模型 对于一个样本资料,观测p 个变量p x x x ,,21,n 个样品的数据资料阵为: ??????? ??=np n n p p x x x x x x x x x X 21 222 21112 11()p x x x ,,21=

第二章主成分分析 1.主成分分析的基本原理 统计学上PCA 的定义为用几个较少的综合指标来代替原来较多的指标,而这些较少的综合指标既能尽多地反映原来较多指标的有用信息,且相互之间又是无关的。作为一种建立在统计最优原则基础上的分析方法,主成分分析具有较长的发展历史。在1901年,Pearson 首先将变换引入生物学领域,并重新对线性回归进行了分析,得出了变换的一种新形式。Hotelling 于1933年则将其与心理测验学领域联系起来,把离散变量转变为无关联系数。在概率论理论建立的同时,主成分分析又单独出现,由Karhunen 于1947年提出,随后Loeve 于1963年将其归纳总结。因此,主成分分析也被称为K-L 变换[1]。 PCA 运算就是一种确定一个坐标系统的直交变换,在这个新的坐标系统下,变换数据点的方差沿新的坐标轴得到了最大化。这些坐标轴经常被称为是主成分。PCA 运算是一个利用了数据集的统计性质的特征空间变换,这种变换在无损或很少损失了数据集的信息的情况下降低了数据集的维数。 PCA 的基本原理如下:给定输入数据矩阵m n X ? (通常m n >),它由一 些中心化的样本数据1{}m i i x =构成,其中n i x R ∈且 10m i i x ==∑ (2-1) PCA 通过式(2-2)将输入数据矢量i x 变换为新的矢量 T i i s U x = (2-2) 其中:U 是一个n n ?正交矩阵,它的第i 列i U 是样本协方差矩阵 1 1n T i i i C x x n ==∑(2-3) 的第i 个本征矢量。换句话说,PCA 首先求解如下的本征问题

主成分分析 主成分分析(Principal Component Analysis ,PCA )或者主元分析。是一种掌握事物主要矛盾的统计分析方法,它可以从多元事物中解析出主要影响因素,揭示事物的本质,简化复杂的问题。计算主成分的目的是将高维数据投影到较低维空间。给定n 个变量的m 个观察值,形成一个n ′ m 的数据矩阵,n 通常比较大。对于一个由多个变量描述的复杂事物,人们难以认识,那么是否可以抓住事物主要方面进行重点分析呢?如果事物的主要方面刚好体现在几个主要变量上,我们只需要将这几个变量分离出来,进行详细分析。但是,在一般情况下,并不能直接找出这样的关键变量。这时我们可以用原有变量的线性组合来表示事物的主要方面,PCA 就是这样一种分析方法。 PCA 主要用于数据降维,对于一系列例子的特征组成的多维向量,多维向量里的某些元素本身没有区分性,比如某个元素在所有的例子中都为1,或者与1差距不大,那么这个元素本身就没有区分性,用它做特征来区分,贡献会非常小。所以我们的目的是找那些变化大的元素,即方差大的那些维,而去除掉那些变化不大的维,从而使特征留下的都是“精品”,而且计算量也变小了。对于一个k维的特征来说,相当于它的每一维特征与其他维都是正交的(相当于在多维坐标系中,坐标轴都是垂直的),那么我们可以变化这些维的坐标系,从而使这个特征在某些维上方差大,而在某些维上方差很小。例如,一个45度倾斜的椭圆,在第一坐标系,如果按照x,y坐标来投影,这些点的x和y的属性很难用于区分他们,因为他们在x,y轴上坐标变化的方差都差不多,我们无法根据这个点的某个x属性来判断这个点是哪个,而如果将坐标轴旋转,以椭圆长轴为x轴,则椭圆在长轴上的分布比较长,方差大,而在短轴上的分布短,方差小,所以可以考虑只保留这些点的长轴属性,来区分椭圆上的点,这样,区分性比x,y轴的方法要好! 所以我们的做法就是求得一个k维特征的投影矩阵,这个投影矩阵可以将特征从高维降到低维。投影矩阵也可以叫做变换矩阵。新的低维特征必须每个维都正交,特征向量都是正交的。通过求样本矩阵的协方差矩阵,然后求出协方差矩阵的特征向量,这些特征向量就可以构成这个投影矩阵了。特征向量的选择取决于协方差矩阵的特征值的大小。 举例: 对于一个训练集,100个对象模板,特征是10维,那么它可以建立一个100*10的矩阵,作为样本。求这个样本的协方差矩阵,得到一个10*10的协方差矩阵,然后求出这个协方差矩阵的特征值和特征向量,应该有10个特征值和特征向量,我们根据特征值的大小,取前四个特征值所对应的特征向量,构成一个10*4的矩阵,这个矩阵就是我们要求的特征矩阵,100*10的样本矩阵乘以这个10*4的特征矩阵,就得到了一个100*4的新的降维之后的样本矩阵,每个特征的维数下降了。 当给定一个测试的特征集之后,比如1*10维的特征,乘以上面得到的10*4的特征矩阵,便可以得到一个1*4的特征,用这个特征去分类。 所以做PCA实际上是求得这个投影矩阵,用高维的特征乘以这个投影矩阵,便可以将高维特征的维数下降到指定的维数。 PCA 的目标是寻找r (r 神经网络方法课程报告吴强200820901021 浅析主成分分析方法 简介 成分分析(PCA)是现代数据分析方法的支柱,它就像一个黑箱被广泛地运用在各个领域,在本文中本人将谈谈对主成分分析的认识,对PCA数据压缩,去噪的应用的理解,以及PCA局限性和其在脑电分类问题的实际应用中的问题,最后简单分析了在EEG/fMRI同步采集信号时利用PCA去噪可能存在的问题。 虚拟实验例子 这里我首先举一个主成分分析的虚拟实验作为例子,以便能更好地,更直观地理解PCA。 虚拟实验模型如下图所示,下图中的红球的运动是我们要考察或者说是观测的对象,而红球被通过一个弹簧连接到固定的墙上,红球做沿弹簧径向的反复震动,下图中就是X轴方向,当然由于各种外界因素的干扰影响,如摩擦,碰撞,弹簧的非理想结构,使得红球的运动方向除了沿弹簧径向方向外还有在其他方向具有不确定性的运动。 为了观测红球的运动,虚拟实验中设计了三个摄像头A/B/C,从不同角度来记录红球的运动,而虚拟实验的目的就是通过三个摄像头A/B/C的观测数据找出红球的最主要的运动方向,即沿弹簧径向的运动的X轴方向。 这里根据应用PCA分析的常见的实际情况,有以下假设: 1)摄像头只能观测到红球在其二维坐标中的坐标位置。 2)假设弹簧对于摄像头是不可见的。 3)除红球摄像头的位置坐标,X/Y/Z坐标系是未知的且不可直接观测的。 4)三个摄像头A/B/C的相对位置,拍摄方向未知 如果有一个问题:红球到底是沿什么方向的弹簧驱动的? 现在可能有人会说,红球主要的运动方向不是显而易见的吗?一眼就可以看出来!当然由于人眼的立体视觉,如果在现实中重现该实验确实能一眼就搞定。但是请问如果是超过三维的高维空间呢?实际上一般每个传感器能观测采样到的往往是一维时间序列数据,而由这样多个传感器采样数据构成的多维观测数据矩阵,给你这样一个矩阵你又如何能“看出”如本虚拟实验中的红球的弹簧弹性震动的运动方向? 所以要解决这个问题,我们就可以运用PCA分析方法。通过PCA就可以从三个摄像头的观测数据中分析出红球的本征弹性震动,即沿着弹簧方向的运动,从数学的角度说就是找到在由A/B/C三个摄像头所记录数据构成的空间中,找到X轴方向的坐标表示,即给空间中的一个向量。 主成分分析法(PCA) 在实际问题中.我们经常会遇到研究多个变量的问题.而且在多数情况下.多个变量之间常常存在一定的相关性。由于变量个数较多再加上变量之间的相关性.势必增加了分析问题的复杂性。如何从多个变量中综合为少数几个代表性变量.既能够代表原始变量的绝大多数信息.又互不相关.并且在新的综合变量基础上.可以进一步的统计分析.这时就需要进行主成分分析。 I. 主成分分析法(PCA)模型 (一)主成分分析的基本思想 主成分分析是采取一种数学降维的方法.找出几个综合变量来代替原来众多的变量.使这些综合变量能尽可能地代表原来变量的信息量.而且彼此之间互不相关。这种将把多个变量化为少数几个互相无关的综合变量的统计分析方法就叫做主成分分析或主分量分析。 主成分分析所要做的就是设法将原来众多具有一定相关性的变量.重新组合为一组新的相互无关的综合变量来代替原来变量。通常.数学上的处理方法就是将原来的变量做线性组合.作为新的综合变量.但是这种组合如果不加以限制.则可以有很多.应该如何选择呢?如果将选取的第一个线性组合即第一个综合变量记为1F .自然希望它尽可能多地反映原来变量的信息.这里“信息”用方差来测量.即希望)(1F Var 越大.表示1F 包含的信息越多。因此在所有的线性组合中所选取的1F 应该是方差最大的.故称1F 为第一主成分。如果第一主成分不足以代表原来p 个变量的信息.再考虑选取2F 即第二个线性组合.为了有效地反映原来信息.1F 已有的信息就不需要再出现在2F 中.用数学语言表达就是要求0),(21=F F Cov .称2F 为第二主成分.依此类推可以构造出第三、四……第p 个主成分。 (二)主成分分析的数学模型 对于一个样本资料.观测p 个变量p x x x Λ,,21.n 个样品的数据资料阵为: ?????? ? ??=np n n p p x x x x x x x x x X ΛM M M M ΛΛ212222111211()p x x x Λ,,21= 主元分析(PCA)理论分析及应用 (主要基于外文教程翻译) 什么是PCA? PCA是Principal component analysis的缩写,中文翻译为主元分析。它是一种对数据进行分析的技术,最重要的应用是对原有数据进行简化。正如它的名字:主元分析,这种方法可以有效的找出数据中最“主要”的元素和结构,去除噪音和冗余,将原有的复杂数据降维,揭示隐藏在复杂数据背后的简单结构。它的优点是简单,而且无参数限制,可以方便的应用与各个场合。因此应用极其广泛,从神经科学到计算机图形学都有它的用武之地。被誉为应用线形代数最价值的结果之一。 在以下的章节中,不仅有对PCA的比较直观的解释,同时也配有较为深入的分析。首先将从一个简单的例子开始说明PCA应用的场合以及想法的由来,进行一个比较直观的解释;然后加入数学的严格推导,引入线形代数,进行问题的求解。随后将揭示PCA与SVD(Singular Value Decomposition)之间的联系以及如何将之应用于真实世界。最后将分析PCA理论模型的假设条件以及针对这些条件可能进行的改进。 一个简单的模型 在实验科学中我常遇到的情况是,使用大量的变量代表可能变化的因素,例如光谱、电压、速度等等。但是由于实验环境和观测手段的限制,实验数据往往变得极其的复杂、混乱和冗余的。如何对数据进行分析,取得隐藏在数据背后的变量关系,是一个很困难的问题。在神经科学、气象学、海洋学等等学科实验中,假设的变量个数可能非常之多,但是真正的影响因素以及它们之间的关系可能又是非常之简单的。 下面的模型取自一个物理学中的实验。它看上去比较简单,但足以说明问题。如错误!未找到引用源。图表1所示。这是一个理想弹簧运动规律的测定实验。假设球是连接在一个无质量无摩擦的弹簧之上,从平衡位置沿轴拉开一定的距离然后释放。主成分分析(PCA)入门

(完整word版)主成分分析PCA(含有详细推导过程以和案例分析matlab版)

PCA分析方法