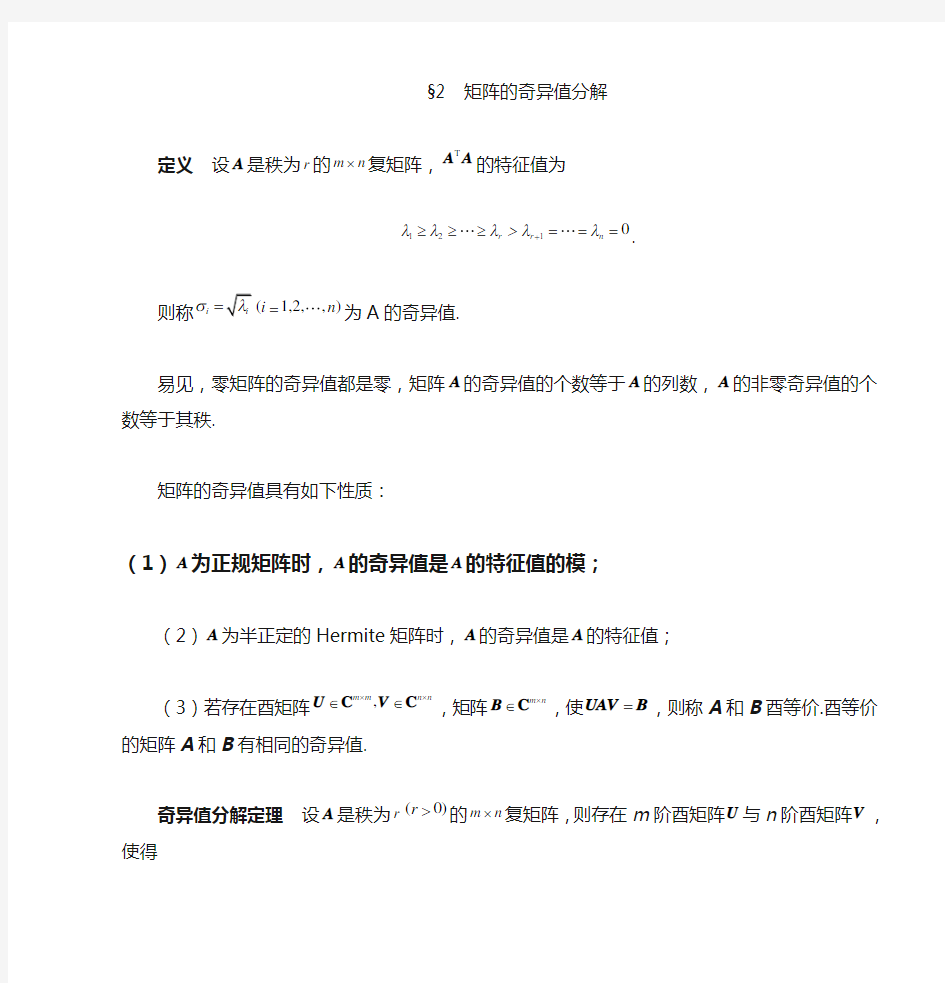

§2 矩阵的奇异值分解

定义 设A 是秩为r 的m n ?复矩阵,T A A 的特征值为

1210r r n λλλ>λλ+≥≥

≥===.

则称i σ=(1,2,

,)i n =为A 的奇异值.

易见,零矩阵的奇异值都是零,矩阵A 的奇异值的个数等于A 的列数,A 的非零奇异值的个数等于其秩.

矩阵的奇异值具有如下性质:

(1)A 为正规矩阵时,A 的奇异值是A 的特征值的模;

(2)A 为半正定的Hermite 矩阵时,A 的奇异值是A 的特征值;

(3)若存在酉矩阵,m m n n ??∈∈U V C C ,矩阵m n ?∈B C ,使=UAV B ,则称A 和B 酉等价.酉等价的矩阵A 和B 有相同的奇异值.

奇异值分解定理 设A 是秩为r (0)r >的m n ?复矩阵,则存在m 阶酉矩阵U 与n 阶酉矩阵V ,使得

H ??

==??

??

O U AV O O ∑?. ① 其中12diag(,,,)r σσσ=∑,i σ(1,2,,)i r =为矩阵A 的全部非零奇异值.

证明 设Hermite 矩阵H A A 的n 个特征值按大小排列为

1210r r n λλλ>λλ+≥≥

≥===.

则存在n 阶酉矩阵V ,使得

1

2

H H ()n λλ????

??==???

???

???

?

O V A A V O O ∑. ②

将V 分块为 12()=V V V , 其中1V ,2V 分别是V 的前r 列与后n r -列. 并改写②式为

2

H ??=?

???

O A AV V O

O ∑. 则有

H 2H 112==A AV V A AV O , ∑. ③

由③的第一式可得

H H 2H 1111()()r ==V A AV AV AV E , 或者∑∑∑.

由③的第二式可得

H 222()() ==AV AV O AV O 或者.

令111-=U AV ∑,则H 11r =U U E ,即1U 的r 个列是两两正交的单位向量.记作112(,,,)r =U u u u ,

因此可将12,,,r u u u 扩充成m C 的标准正交基,

记增添的向量为1,

,r m +u u ,并构造矩阵21(,

,)r m +=U u u ,则 12121(,)(,,

,,,

,)r r m +==U U U u u u u u

是m 阶酉矩阵,且有 H H

1121 r ==U U E U U O ,.

于是可得

H

H H 1

121H 2()()????===????

????

O U U AV U AV AV U O O O U ,,∑∑. 由①式可得

H H H

H 111222r r r σσσ??==+++????

O A U V u v u v u v O O ∑. ④

称④式为矩阵A 的奇异值分解.

值得注意的是:在奇异值分解中121,,

,,,

,r r m +u u u u u 是H AA 的特征

向量,而V 的列向量是H A A 的特征向量,并且H AA 与H A A 的非零特征值

完全相同.但矩阵A 的奇异值分解不惟一.

证明2 设Hermite 矩阵H A A 的n 个特征值按大小排列为

1210r r n λλλ>λλ+≥≥

≥===.

则存在n 阶酉矩阵V ,使得

1

2

H H ()n λλ????

??==???

???

???

?

O V A A V O O ∑. ② 将V 分块为12(,,,)n =V v v v ,它的n 个列12,,,n v v v 是对应于特征值

12,,,n λλλ的标准正交的特征向量.

为了得到酉矩阵U ,首先考察m C 中的向量组12,,

,r Av Av Av ,由于当

i 不等于j 时有

H H H H H (,)()()0i j j i j i j i i i j i λλ=====Av Av Av Av v A Av v v v v

所以向量组12,,

,r Av Av Av 是m C 中的正交向量组.

又 2H H H 2

||||i i i i i i i

λσ===Av v A Av v v , 所以 ||||i i i σ=Av .

令1

i i i

=u Av σ,1,2,

,i r =,则得到m C 中的标准正交向量组12,,

,r u u u ,

把它扩充成为m C 中的标准正交基11,

,,,r r m +u u u u ,令

11(,,,,)r r m +=U u u u u

则U 是m 阶酉矩阵.由已知及前面的推导可得

i i i σ=Av u ,1,2,,i r =;i =Av 0,1,

,i r n =+;

从而 121

(,,,)(,,,,,)

n r ==AV A v v v Av Av 0

11120

(,,,,,)(,,

,)0r m r

σσσσ?? ?

?== ? ? ??

?

O u u u u u O

O 00 ??

= ???

ΣO U O O

故有=AV U Δ,即H =U AV Δ.

例1 求矩阵120202??

=??

??

A 的奇异值分解. 解 T 5

2

42

4

04

4??

??=??????

A A 的特征值为1239,4,0λλλ===, 对

应

的单位特征向量依次为

T T T

1231

,1)

,(2,1,2)3

=

=

-=-v v v .

所以 505

26

43?-?

=??

-???

V . 于是可得

()2r =A ,3002∑??

=??

??

. 计算111221∑-??

==

??-??

U AV ,则A 的奇异值分解为 T

300020??=????

A U V .

在A 的奇异值分解中,酉矩阵V 的列向量称为A 的右奇异向量,V

的前r 列是H A A 的r 个非零特征值所对应的特征向量,将他们取为矩阵V 1,则12(,)=V V V .酉矩阵U 的列向量被称为A 的左奇异向量,将U 从前r 列处分块为12(,)=U U U ,由分块运算,有

H H H H

1111212H H H

22122()??????

=== ??????

?????O U U AV U AV U AV AV AV O O U U AV U AV ,∑ 从而 21

1=A V A V U Σ,=0.

正交基;

(2)1U 的列向量组是矩阵A 的列空间(){}R =A Ax 的一组标准正交基;

(1)1V 的列向量组是矩阵A 的零空间(){}N ==A x Ax 0正交补

H ()R A 的一组标准正交基;

(1)2U 的列向量组是矩阵A 的列空间(){}R =A Ax 正交补H ()N A 的一组标准正交基.

在A 的奇异值分解中,酉矩阵U 和V 不是惟一的.A 的奇异值分解给出了矩阵A 的许多重要信息. 更进一步,由于12(,,)m =U u u u ,12(,,,)n =V v v v ,可借助于奇异

值分解,将A 表示为

H

11H 2

12H 0

(,,

,)0m r

n σσ???? ? ?

? ?= ? ? ? ? ? ???

?

?v O v A u u u O

O v H H

H 111222r r r σσσ=+++u v u v u v

归纳这一结果,有如下定理.

定理 设m n ?∈A C ,A 的非零奇异值为12r σσσ≥≥

≥,12,,r

u u u 是应于奇异值的左奇异向量,12,,

,r v v v 是应于奇异值的右奇异向量,则

T T

T 111222r r r σσσ=+++A u v u v u v .

上式给出的形式被称为矩阵A 的奇异值展开式,对一个k r ≤,略去A 的一些小的奇异值对应的项,去矩阵k A 为

T T T

111222k k k k

σσσ=++

+A u v u v u v . 则k A 是一个秩为k 的m ×n 矩阵.可以证明,k A 是在所有秩为k 的m ×n 矩阵中,从Frobenius 范数的意义下,与矩阵A 距离最近的一个矩阵.这在实

际中应用广泛.例如,在图像数字化技术中,一副图片可以转换成一个m ×n 阶像素矩阵来储存,存储量m ×n 是个数.如果利用矩阵的奇异值展开式,则只要存储A 的奇异值i σ,奇异向量,i i u v 的分量,总计r (m +n +1)个数.取m =n =1000,r =100作一个比较,

m ×n =,r (m +n +1)=100(1000+1000+1)=.

取A 的奇异值展开式,,存储量较A 的元素情形减少了80%.另外,可取

k r <,用k A 逼近A ,能够达到既压缩图像的存储量,又保持图像不失真

的目的.

由矩阵A 的奇异值分解可得

T T

T 111222r r r σσσ=++

+A u v u v u v

可见,A 是矩阵T T

T 1122,,

,r r u v u v u v 的加权和,其中权系数按递减排列

120r σσσ≥≥≥>.

显然,权系数大的那些项对矩阵A 的贡献大,因此当舍去权系数小的一些项后,仍然能较好的“逼近”矩阵A ,这一点在数字图像处理方面非常有用.

矩阵的秩k 逼近定义为

T T

T

111222 1k k k k r σσσ=++

+≤≤A u v u v u v

秩r 逼近就精确等于A ,而秩1逼近的误差最大.

矩阵的奇异值分解不但在线性方程组,矩阵范数,广义逆,最优化等方面有着广泛的应用.而且在数字计算,数字图像处理,信息检索,心里学等领域也有着极重要的应用.有兴趣的读者可参阅有关教科书,如Steven J.Leon 的《线性代数》.

3 矩阵A的奇异值分解与线性变换T A

设A 是一个秩为r 的m ×n 复矩阵,即m n

?∈A C

,rank()r =A ,则由

()T ==A A βαα可以定义线性变换

:n m T →A C C .

设矩阵A 有奇异值分解H

=A U ΣV ,则将矩阵n n

?∈V C 的列向量组12,,,n v v v 取

作空间n

C 的标准正交基;则将矩阵m m

?∈U C

的列向量组12,,

m u u u 取作空间m

C 的标准正交基,则在所取的基下,线性变换T A 对应的变换矩阵就是Σ.

设n

∈C α,α在基12,,

,n v v v 下坐标向量为T 12(,,,)n x x x =x ,=Vx α.

那么α在线性变换T A 下的像β具有形式:

11H

()()()00r r x x T σσ??

? ? ?===== ? ? ? ? ???

A A U ΣV Vx U Σx U βαα.

其中12,,

,r σσσ是A 的非零奇异值,所以,α的像()T =A βα在m C 中基

12,,m u u u 下的坐标是

T 11(0

0)r r x x σσ==y Σx .

从中可以看出,当rank()r =A 时,在取定的基下,线性变换()T A α的作用是

将原像坐标中的前r 个分量分别乘以A 的非零奇异值12,,,r σσσ,后(n-r )分量

化为零.如果原像坐标满足条件:

22

2

121n x x x ++

+=,

则像坐标满足条件:

2221

2

1

2

(

)(

)(

)1r

r

y y y σσσ++

+≤.

在rank()r n ==A 时,等式成立.因此,有如下定理.

定理 设H =A U ΣV 是m ×n 实矩阵A 的奇异值分解,rank()r =A ,则n

R 中的单位圆球面在线性变换T A 下的像集合是:

(1)若r n =,则像集合是m

R 中的椭球面; (2)若r n <,则像集合是m R 中的椭球体. 例2 设矩阵120202??=?

?

??

A ,求

3

R 中的单位圆球面在线性变换:T A y

=Ax 下的像的几何图形.

解

由例1

,矩阵A 有如下奇异值分解

T

5012300262102043??

?- ??

??????=??????-????????-?????

?A . rank()23,n =<=A 由定理,单位球面的像满足不等式

22

12

22

132y y +≤. 即单位球面的像是实心椭圆22

12

194

y y +≤.

特征值:一矩阵A作用与一向量a,结果只相当与该向量乘以一常数λ。即A*a=λa,则a 为该矩阵A的特征向量,λ为该矩阵A的特征值。 奇异值:设A为m*n阶矩阵,A H A的n个特征值的非负平方根叫作A的奇异值。记 (A) 为σ i 上一次写了关于PCA与LDA的文章,PCA的实现一般有两种,一种是用特征值分解去实现的,一种是用奇异值分解去实现的。在上篇文章中便是基于特征值分解的一种解释。特征值和奇异值在大部分人的印象中,往往是停留在纯粹的数学计算中。而且线性代数或者矩阵论里面,也很少讲任何跟特征值与奇异值有关的应用背景。奇异值分解是一个有着很明显的物理意义的一种方法,它可以将一个比较复杂的矩阵用更小更简单的几个子矩阵的相乘来表示,这些小矩阵描述的是矩阵的重要的特性。就像是描述一个人一样,给别人描述说这个人长得浓眉大眼,方脸,络腮胡,而且带个黑框的眼镜,这样寥寥的几个特征,就让别人脑海里面就有一个较为清楚的认识,实际上,人脸上的特征是有着无数种的,之所以能这么描述,是因为人天生就有着非常好的抽取重要特征的能力,让机器学会抽取重要的特征,SVD是一个重要的方法。 在机器学习领域,有相当多的应用与奇异值都可以扯上关系,比如做feature reduction的PCA,做数据压缩(以图像压缩为代表)的算法,还有做搜索引擎语义层次检索的LSI(Latent Semantic Indexing) 另外在这里抱怨一下,之前在百度里面搜索过SVD,出来的结果都是俄罗斯的一种狙击枪(AK47同时代的),是因为穿越火线这个游戏里面有一把狙击枪叫做 SVD,而在Google上面搜索的时候,出来的都是奇异值分解(英文资料为主)。想玩玩战争游戏,玩玩COD不是非常好吗,玩山寨的CS有神马意思啊。国内的网页中的话语权也被这些没有太多营养的帖子所占据。真心希望国内的气氛能够更浓一点,搞游戏的人真正是喜欢制作游戏,搞Data Mining的人是真正喜欢挖数据的,都不是仅仅为了混口饭吃,这样谈超越别人才有意义,中文文章中,能踏踏实实谈谈技术的太少了,改变这个状况,从我自己做起吧。 前面说了这么多,本文主要关注奇异值的一些特性,另外还会稍稍提及奇异值的计算,不过本文不准备在如何计算奇异值上展开太多。另外,本文里面有部分不算太深的线性代数的知识,如果完全忘记了线性代数,看本文可能会有些困难。 一、奇异值与特征值基础知识: 特征值分解和奇异值分解在机器学习领域都是属于满地可见的方法。两者有着很紧密的关系,我在接下来会谈到,特征值分解和奇异值分解的目的都是一样,就是提取出一个矩阵最重要的特征。先谈谈特征值分解吧:

奇异值分解及其应用 This model paper was revised by the Standardization Office on December 10, 2020

PCA的实现一般有两种,一种是用特征值分解去实现的,一种是用奇异值分解去实现的。特征值和奇异值在大部分人的印象中,往往是停留在纯粹的数学计算中。而且线性代数或者矩阵论里面,也很少讲任何跟特征值与奇异值有关的应用背景。奇异值分解是一个有着很明显的物理意义的一种方法,它可以将一个比较复杂的矩阵用更小更简单的几个子矩阵的相乘来表示,这些小矩阵描述的是矩阵的重要的特性。就像是描述一个人一样,给别人描述说这个人长得浓眉大眼,方脸,络腮胡,而且带个黑框的眼镜,这样寥寥的几个特征,就让别人脑海里面就有一个较为清楚的认识,实际上,人脸上的特征是有着无数种的,之所以能这么描述,是因为人天生就有着非常好的抽取重要特征的能力,让机器学会抽取重要的特征,SVD是一个重要的方法。 在机器学习领域,有相当多的应用与奇异值都可以扯上关系,比如做feature reduction的PCA,做数据压缩(以图像压缩为代表)的算法,还有做搜索引擎语义层次检索的LSI(Latent Semantic Indexing) 奇异值与特征值基础知识 特征值分解和奇异值分解在机器学习领域都是属于满地可见的方法。两者有着很紧密的关系,我在接下来会谈到,特征值分解和奇异值分解的目的都是一样,就是提取出一个矩阵最重要的特征。先谈谈特征值分解吧: 如果说一个向量v是方阵A的特征向量,将一定可以表示成下面的形式: 这时候λ就被称为特征向量v对应的特征值,一个矩阵的一组特征向量是一组正交向量。特征值分解是将一个矩阵分解成下面的形式: 其中Q是这个矩阵A的特征向量组成的矩阵,Σ是一个对角阵,每一个对角线上的元素就是一个特征值。我这里引用了一些参考文献中的内容来说明一下。首先,要明确的是,一个矩阵其实就是一个线性变换,因为一个矩阵乘以一个向量后得到的向量,其实就相当于将这个向量进行了线性变换。比如说下面的一个矩阵: 它其实对应的线性变换是下面的形式:

矩阵的奇异值分解(SVD)及其应用 版权声明: 本文由LeftNotEasy发布于https://www.doczj.com/doc/7b15013536.html,, 本文可以被全部的转载或者部分使用,但请注明出处,如果有问题,请联系wheeleast@https://www.doczj.com/doc/7b15013536.html, 前言: 上一次写了关于PCA与LDA的文章,PCA的实现一般有两种,一种是用特征值分解去实现的,一种是用奇异值分解去实现的。在上篇文章中便是基于特征值分解的一种解释。特征值和奇异值在大部分人的印象中,往往是停留在纯粹的数学计算中。而且线性代数或者矩阵论里面,也很少讲任何跟特征值与奇异值有关的应用背景。奇异值分解是一个有着很明显的物理意义的一种方法,它可以将一个比较复杂的矩阵用更小更简单的几个子矩阵的相乘来表示,这些小矩阵描述的是矩阵的重要的特性。就像是描述一个人一样,给别人描述说这个人长得浓眉大眼,方脸,络腮胡,而且带个黑框的眼镜,这样寥寥的几个特征,就让别人脑海里面就有一个较为清楚的认识,实际上,人脸上的特征是有着无数种的,之所以能这么描述,是因为人天生就有着非常好的抽取重要特征的能力,让机器学会抽取重要的特征,SVD是一个重要的方法。 在机器学习领域,有相当多的应用与奇异值都可以扯上关系,比如做feature reduction的PCA,做数据压缩(以图像压缩为代表)的算法,还有做搜索引擎语义层次检索的LSI(Latent Sem antic Indexing) 另外在这里抱怨一下,之前在百度里面搜索过SVD,出来的结果都是俄罗斯的一种狙击枪(AK47同时代的),是因为穿越火线这个游戏里面有一把狙击枪叫做SVD,而在Google上面搜索的时候,出来的都是奇异值分解(英文资料为主)。想玩玩战争游戏,玩玩COD不是非常好吗,玩山寨的CS有神马意思啊。国内的网页中的话语权也被这些没有太多营养的帖子所占据。真心希望国内的气氛能够更浓一点,搞游戏的人真正是喜欢制作游戏,搞Data Mining的人是真正喜欢挖数据的,都不是仅仅为了混口饭吃,这样谈超越别人才有意义,中文文章中,能踏踏实实谈谈技术的太少了,改变这个状况,从我自己做起吧。 前面说了这么多,本文主要关注奇异值的一些特性,另外还会稍稍提及奇异值的计算,不过本文不准备在如何计算奇异值上展开太多。另外,本文里面有部分不算太深的线性代数的知识,如果完全忘记了线性代数,看本文可能会有些困难。 一、奇异值与特征值基础知识: 特征值分解和奇异值分解在机器学习领域都是属于满地可见的方法。两者有着很紧密的关系,我在接下来会谈到,特征值分解和奇异值分解的目的都是一样,就是提取出一个矩阵最重要的特征。先谈谈特征值分解吧: 1)特征值: 如果说一个向量v是方阵A的特征向量,将一定可以表示成下面的形式:

§2 矩阵的奇异值分解 定义 设A 是秩为r 的m n ?复矩阵,T A A 的特征值为 1210r r n λλλ>λλ+≥≥≥=== . 则称i σ=(1,2,,)i n = 为A 的奇异值. 易见,零矩阵的奇异值都是零,矩阵A 的奇异值的个数等于A 的列数,A 的非零奇异值的个数等于其秩. 矩阵的奇异值具有如下性质: (1)A 为正规矩阵时,A 的奇异值是A 的特征值的模; (2)A 为半正定的Hermite 矩阵时,A 的奇异值是A 的特征值; (3)若存在酉矩阵,m m n n ??∈∈U V C C ,矩阵m n ?∈B C ,使=U A V B ,则称A 和B 酉等价.酉等价的矩阵A 和B 有相同的奇异值. 奇异值分解定理 设A 是秩为r (0)r >的m n ?复矩阵,则存 在m 阶酉矩阵U 与n 阶酉矩阵V ,使得 H ??==? ??? O U A V O O ∑?. ① 其中12diag(,,,)r σσσ= ∑,i σ(1,2,,) i r = 为矩阵A 的全部非零奇 异值. 证明 设Hermite 矩阵H A A 的n 个特征值按大小排列为 1210r r n λλλ>λλ+≥≥≥=== . 则存在n 阶酉矩阵V ,使得

12 H H ()n λλ???? ??= =?????? ??? ? O V A A V O O ∑. ② 将V 分块为 12()=V V V , 其中1V ,2V 分别是V 的前r 列与后n r -列. 并改写②式为 2 H ??=? ??? O A AV V O O ∑. 则有 H 2 H 112==A A V V A A V O , ∑. ③ 由③的第一式可得 H H 2 H 1111()()r ==V A A V A V A V E , 或者∑∑∑. 由③的第二式可得 H 222()() ==A V A V O A V O 或者. 令1 11-=U A V ∑ ,则H 11r =U U E ,即1U 的r 个列是两两正交的单位向 量.记作112(,,,)r =U u u u ,因此可将12,,,r u u u 扩充成m C 的标准正交基,记增添的向量为1,,r m +u u ,并构造矩阵21(,,)r m +=U u u ,则 12121(,)(,,,,,,)r r m +==U U U u u u u u 是m 阶酉矩阵,且有 H H 1121 r ==U U E U U O ,. 于是可得 H H H 1121H 2()()???? ===??? ??? ?? O U U AV U AV AV U O O O U ,,∑ ∑. 由①式可得 H H H H 111222r r r σσσ??==+++? ??? O A U V u v u v u v O O ∑ . ④

PCA的实现一般有两种,一种是用特征值分解去实现的,一种是用奇异值分解去实现的。特征值和奇异值在大部分人的印象中,往往是停留在纯粹的数学计算中。而且线性代数或者矩阵论里面,也很少讲任何跟特征值与奇异值有关的应用背景。奇异值分解是一个有着很明显的物理意义的一种方法,它可以将一个比较复杂的矩阵用更小更简单的几个子矩阵的相乘来表示,这些小矩阵描述的是矩阵的重要的特性。就像是描述一个人一样,给别人描述说这个人长得浓眉大眼,方脸,络腮胡,而且带个黑框的眼镜,这样寥寥的几个特征,就让别人脑海里面就有一个较为清楚的认识,实际上,人脸上的特征是有着无数种的,之所以能这么描述,是因为人天生就有着非常好的抽取重要特征的能力,让机器学会抽取重要的特征,SVD是一个重要的方法。 在机器学习领域,有相当多的应用与奇异值都可以扯上关系,比如做feature reduction的PCA,做数据压缩(以图像压缩为代表)的算法,还有做搜索引擎语义层次检索的LSI(Latent Semantic Indexing) 奇异值与特征值基础知识 特征值分解和奇异值分解在机器学习领域都是属于满地可见的方法。两者有着很紧密的关系,我在接下来会谈到,特征值分解和奇异值分解的目的都是一样,就是提取出一个矩阵最重要的特征。先谈谈特征值分解吧: 特征值

如果说一个向量v是方阵A的特征向量,将一定可以表示成下面的形式: 这时候λ就被称为特征向量v对应的特征值,一个矩阵的一组特征向量是一组正交向量。特征值分解是将一个矩阵分解成下面的形式: 其中Q是这个矩阵A的特征向量组成的矩阵,Σ是一个对角阵,每一个对角线上的元素就是一个特征值。我这里引用了一些参考文献中的内容来说明一下。首先,要明确的是,一个矩阵其实就是一个线性变换,因为一个矩阵乘以一个向量后得到的向量,其实就相当于将这个向量进行了线性变换。比如说下面的一个矩阵: 它其实对应的线性变换是下面的形式: 因为这个矩阵M乘以一个向量(x,y)的结果是:

矩阵的奇异值分解及数值实现 1.引言 矩阵的奇异值分解是数学研究中一种重要的方法, 除了其理论价值外,在工程领域中的应用也很普遍。例如: 在最优化问题、特征值问题、广义逆矩阵计算、高质量的统计计算、信号和图像处理、系统辨识、滤波器设计、谱估计、时间序列分析、控制理论和酉不变范数理论等领域, 奇异值分解都占有极其重要的作用同时它在求线性方程组的数组时也经常使用。它的核心在于在求出矩阵的有效秩的同时不改变矩阵的有关度量特性, 这对统计和检测数据的处理有很重要的作用。但矩阵奇异值分解的严重不足之处在于速度慢、计算量和存储量相当大, 并且到现在仍然没有计算矩阵的奇异值分解的快速算法。因此研究奇异值分解的快速算法,在理论上和工程实际中都有重要意义。 2.矩阵的奇异值分解 在数值分析中,矩阵的奇异值分解具有相当重要的作用, 因此在求矩阵的奇异值分解时, 必须掌握矩阵的奇异值分解的理论及相关概念。 2.1 矩阵的奇异值相关定义 定义2.1.1对于任一个mn阶复(实)矩阵A,设AH(AT)为A的共轭转置矩阵,则AHA的n个特征值的非负平方根称为A的奇异值,也就是A共有n个奇异值,且全部》0。AHA是一个半正定矩

阵,所以它的特征值》0。 设A?HYCmn(r>0),AHA的特征值 为?%d1>?%d夢…》?%dr>?%dr+1=- =?%dn=0则 称?%li=(i=1,2,…,n)为A的奇异值。 从定义可以看出以下性质: (1)mn 矩阵的奇异值的个数等于列数; (2)AHA和AAH的非零特征值相同,A的非零奇异值的个数等 于r?%ZnkA。 定义2。1。2设A为复数域C上的n阶矩阵,如果存在 数?%d?HY(和非零的n维向量x,使得Ax=?%dx就称?%d是矩阵A 的特征值,x是A的属于(或对应于)特征值?%d的特征向量。 定义2。1。3 设mn矩阵A?HYCmn,r?%ZnkA=r(r>0),则AHA 和AAH的特征值都是非负实数。 3.矩阵奇异值分解的性质 既然矩阵奇异值分解在计算中有如此重要的作用, 当然它就具有一些重要的性质, 并且这些性质的应用也相当广泛。 性质3.1 A的奇异值由A惟一确定,但酉矩阵U和V不惟一,故矩阵A的奇异值分解一般不惟一。 性质 3.2 奇异值分解可以计算出矩阵的条件数。 设A?HYCmn且存在可逆矩阵P使得 P- 1AP=di?%Zg(?%d1 …,?%dn),则称?UP-1?U|| PII 为矩阵A关于特征值问题的条件数, 记为k(P) 。

矩阵的奇异值分解 在数字图像处理的应用浅析 学院:··· 专业:·· 姓名:·· 学号:·· 2011年11月6日

目录 一、绪论 ................................................................................................................................. - 1 - 二、数字图像处理简介 ............................................................................................................. - 2 - 三、矩阵的奇异值分解原理 ..................................................................................................... - 4 - 3.1 矩阵的奇异值 ............................................................................................................. - 4 - 3.2 矩阵的奇异值分解(SVD) ....................................................................................... - 4 - 四、奇异值分解的图像性质 ..................................................................................................... - 5 - 五、图像的奇异值分解压缩方法 ............................................................................................. - 7 - 5.1 奇异值分解压缩原理分析 ......................................................................................... - 7 - 5.2 奇异值分解压缩应用过程 ......................................................................................... - 8 - 六、小结 ................................................................................................................................. - 9 -

PCA(协方差矩阵和奇异值分解两种方法求特征值特征向量)

PCA(协方差矩阵和奇异值分解两种方法求特征值特征向量) 2015-12-30 10:43 1157人阅读评论(0) 收藏举报分类: 模式识别(1) 1.问题描述 在许多领域的研究与应用中,往往需要对反映事物的多个变量进行大量的观测,收集大量数据以便进行分析寻找规律。多变量大样本无疑会为研究和应用提供了丰富的信息,但也在一定程度上增加了数据采集的工作量,更重要的是在大多数情况下,许多变量之间可能存在相关性,从而增加了问题分析的复杂性,同时对分析带来不便。如果分别对每个指标进行分析,分析往往是孤立的,而不是综合的。盲目减少指标会损失很多信息,容易产生错误的结论。 2.过程 主成分分析法是一种数据转换的技术,当我们对一个物体进行衡量时,我们将其特征用向量 (a1,a2,a3,...an)进行表示,每一维都有其对应的variance(表示在其均值附近离散的程度);其所有

维的variance之和,我们叫做总的variance;我们对物体进行衡量时,往往其特征值之间是correlated 的,比如我们测量飞行员时,有两个指标一个是飞行技术(x1),另一个是对飞行的喜好程度(x2),这两者之间是有关联的,即correlated的。我们进行PCA(主成分分析时),我们并没有改变维数,但是我们却做了如下变换,设新的特征为(x1,x2,x3...,xn); 其中 1)x1的variance占总的variance比重最大; 2)除去x1,x2的variance占剩下的variance比重最大; .... 依次类推; 最后,我们转换之后得到的(x1,x2,...xn)之间都是incorrelated,我们做PCA时,仅取(x1,x2,....xk),来表示我们测量的物体,其中,k要小于n。主成分的贡献率就是某主成分的方差在全部方差中的比值。这个值越大,表明该主成分综合X1,X2,…,XP信息的能力越强。如果前k个主成分的贡献率达到85%,