BroadCom网卡Team绑定不同模式速度测试

设备环境

一台6224P千兆网络交换机

两台服务器Server1 和Server2

Server 1:

2个1G BroadCom以太网口,分别接到交换机G1和G2口, Windows 2003 SP2系统,

Nic1 IP:192.168.1.20, Nic2 IP:192.168.2.20

Server 2:

2个1G BroadCom以太网口,分别接到交换机G3和G4口, Windows 2003 SP2系统

Nic1 IP:192.168.1.30, Nic2 IP:192.168.2.30

测试软件

FastCopy, 通过copy Server1共享一个大小为2.7G的文件测试

一.不配置任何网卡Team

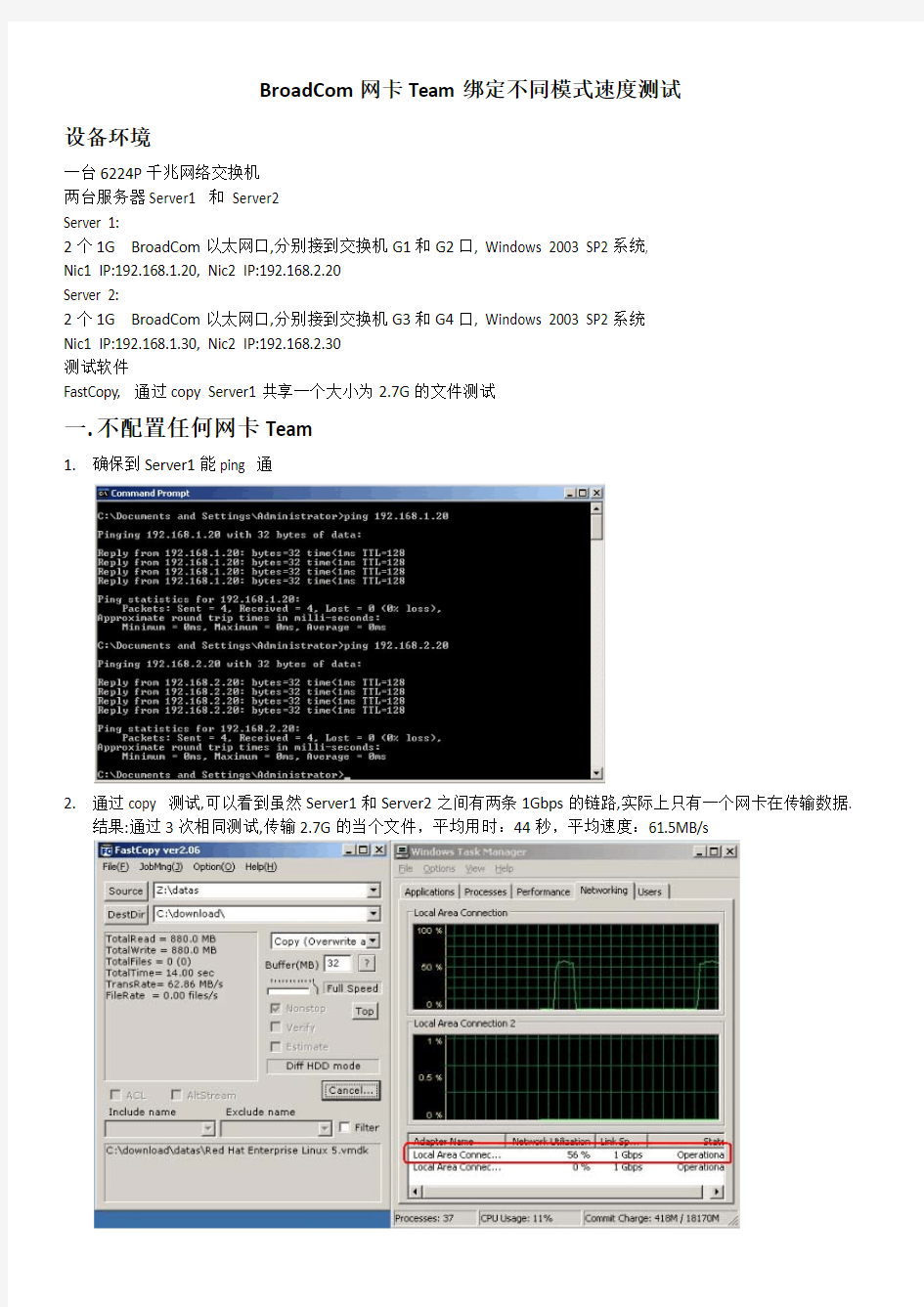

1.确保到Server1能ping 通

2.通过copy 测试,可以看到虽然Server1和Server2之间有两条1Gbps的链路,实际上只有一个网卡在传输数据.

结果:通过3次相同测试,传输2.7G的当个文件,平均用时:44秒,平均速度:61.5MB/s

二、配置成负载均衡冗余模式

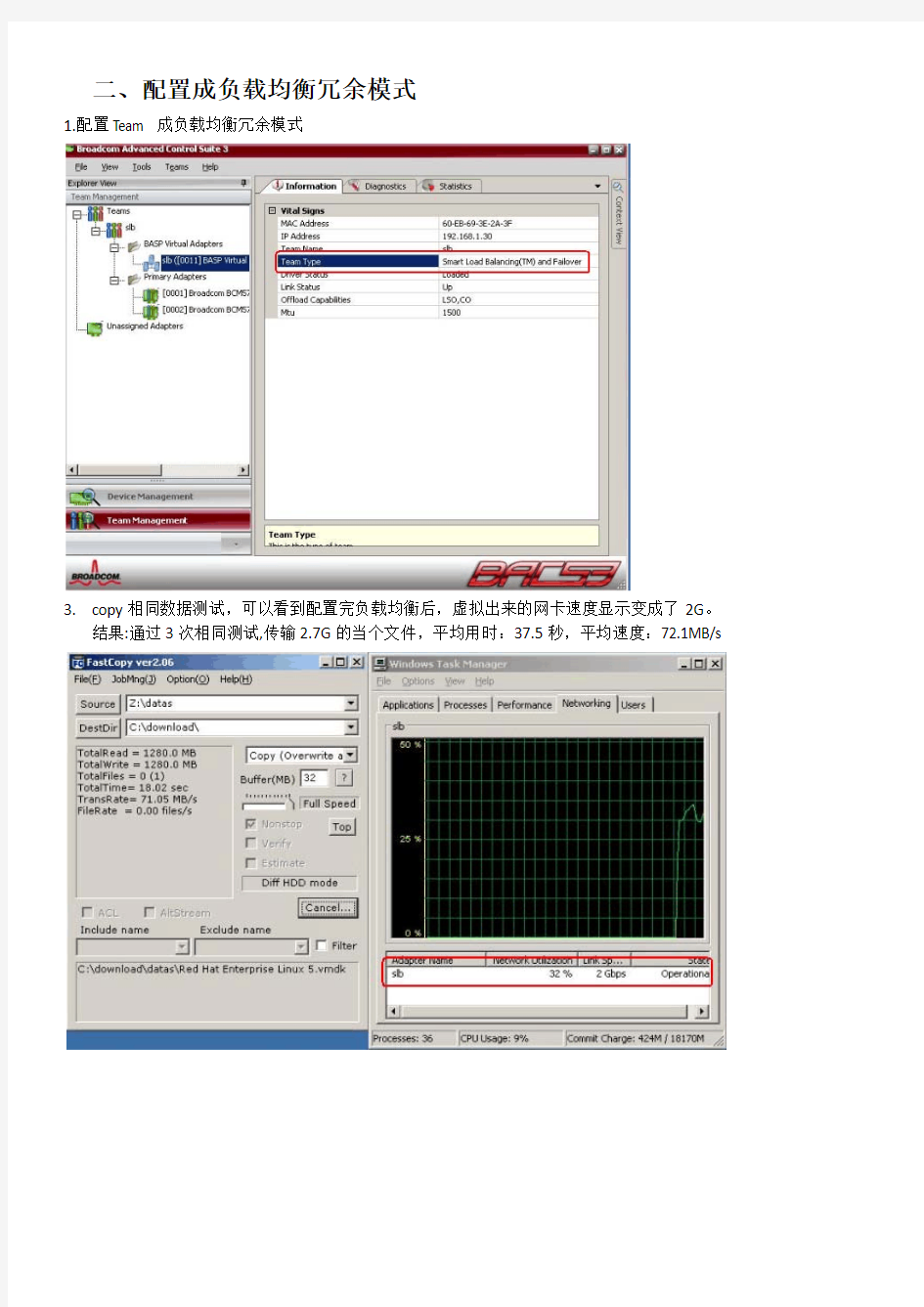

1.配置Team 成负载均衡冗余模式

3.copy相同数据测试,可以看到配置完负载均衡后,虚拟出来的网卡速度显示变成了2G。

结果:通过3次相同测试,传输2.7G的当个文件,平均用时:37.5秒,平均速度:72.1MB/s

三.配置成链路聚合模式。

1.在配置的时候会提示,提示交换机端也需要配置。

2.交换机段配置链路聚合,通过对比网络连接速度,可以发现,交换机配置完后速度变成了2Gbs console#configure

console(config)#interface range ethernet 1/g1-1/g2

console(config-if)#channel-group 1 mode auto

console(config-if)#exit

console(config)#interface range ethernet 1/g3-1/g4

console(config-if)#channel-group 2 mode auto

4.copy相同数据测试,可以看到配置完负载均衡后,虚拟出来的网卡速度显示变成了2G。

结果:通过3次相同测试,传输2.7G的当个文件,平均用时:41.2秒,平均速度:65.3MB/s

总结

对于相同的单个文件2.7G

不配置任何的网卡Team, 平均用时:44秒,平均速度:61.5MB/s

配置负载均衡冗余模式, 平均用时:37.5秒,平均速度:72.1MB/s,速度比不配置要高大约17%配置链路聚合模式,平均用时: 41.2秒,平均速度:65.3MB/s,速度比不配置要高大约6%

所以如果配置网卡Team,选择负载均衡冗余模式要好些。

Windows 双网卡绑定 第一步:硬件连接与安装 首先进入BIOS设置将主板上集成的网卡打开,同时将独立网卡插入空闲的PCI插槽,用直通双绞线将两块网卡和宽带路由器的LAN口相连。重新启动Windows XP系统,自动为两块网卡安装好驱动程序。打开“网络连接”,会看到“本地连接”和“本地连接2”两个连接,而且这两个连接已经启用,硬件的连接与安装就算完成了。 第二步:绑定双网卡 下载并安装绑定双网卡的软件“NIC Express”(下载地址 https://www.doczj.com/doc/ae14067709.html,/soft/36156.htm)。在安装软件的过程中保持默认值,一路点击“Next”后,最后点击“Demo”就可以完成安装。在将两块网卡绑定而虚拟出新设备的时候,会提示“未通过微软认证”,连续点击几次“仍然继续”按钮就可以继续安装。 弹出“绑定”窗口后(见图),在中间文本框中输入绑定后的连接名称(如“网卡绑定”),点击“Add”按钮将两块网卡加入到下面的“Assigned Adpaters”即可。接着进入NIC Express的配置界面,保持默认值就可完成安装。

网卡绑定 第三步:配置连接 进入“网络连接”窗口,会看到多出了一个“网卡绑定NIC Express Virtual Adapter”的连接,并且已启用。现在,这两块网卡已经成功绑定,可以右键点击“网卡绑定”,进行IP地址、子网、网关等参数的配置。将IP地址设置为与路由器默认IP在同一网段,网关设置为路由器默认IP地址。 测速 现在就可以进行BT下载的测试了。以用BitComet下载一个350MB的热门电影为例。打开数据流量窗口,可以从流量曲线监控图以及BitComet的“任务摘要”中看到两块网卡都在进行数据传输。双网卡绑定组的传输速率从80KB/s起步,最高达到123KB/s,两块网卡的平均传输速率比较稳定,下载350MB的电影耗时23分钟,平均下载速度为110KB/s。利用单网卡执行相同的下载任务,发

用双网卡,提高网速! 大家好,我前几天在去联想玩的时候,看到他们工程师一台机装好几个网卡,速度还不错,我看一下,回到公司也到网上找了一些资料,双(多)网卡用一个IP的技术,对于各种内网服务器,和电脑、、、、很有用处,我把我在网上找到的资料整理了一下,大家看一看,也许对大家有好处! 所谓双网卡,就是通过软件将双网卡绑定为一个IP地址,这个技术对于许多朋友来说并不陌生,许多高档服务器网卡(例如intel8255x系列、3COM服务器网卡等)都具有多网卡绑定功能,可以通过软硬件设置将两块或者多块网卡绑定在同一个IP地址上,使用起来就好象在使用一块网卡,多网卡绑定的优点不少,首先,可以增大带宽,假如一个网卡的带宽是100M,理论上两块网卡就是200M,三块就是300M,当然实际上的效果是不会是这样简单的增加的,不过经实际测试使用多个网卡对于增加带宽,保持带宽的稳定性肯定是有裨益的,如果交换机等相关条件不错的话,这个效果还是很能令人满意;其次,可以形成网卡冗余阵列、分担负载,双网卡被绑定成“一块网卡”之后,同步一起工作,对服务器的访问流量被均衡分担到两块网卡上,这样每块网卡的负载压力就小多了,抗并发访问的能力提高,保证了服务器访问的稳定和畅快,当其中一块发生故障的时候,另一块立刻接管全部负载,过程是无缝的,服务不会中断,直到维修人员到来。先下载一个软件NIC Express 下载完软件,先不忙安装,咱们还是先准备好硬件。 第一部分:硬件安装 虽然,理论上讲绑定越多网卡在一起,最终效果提升就越明显,但是考虑到复杂程度,这里就以绑定双网卡为例进行说明,如果读者觉得好玩,兴致很高的话,按照下面方法愿意绑定多少就绑定多少个网卡,其实一般同一台服务器,绑定2-3块网卡也就够了,太多了,据说因为链路聚合的先天缺点,会过多占用服务器资源,反过来会影响服务器速度(关于这个我没实验,不过我觉得凡事都离不开物极必反的道理,适度最好)。 打开服务器机箱,把两块网卡拧在主板PCI插槽上!:》 硬件的安装很简单,我也不在这里说了。省的大家骂我:》 第二部分:设置调试 下面要进行设置及调试了,也就是要将这两块8139D廉价网卡,如同高档服务器网卡那样绑

多网卡负载均衡 NICExpress软件下载地址: https://www.doczj.com/doc/ae14067709.html,/soft/36156.htm 注册码: 名称:https://www.doczj.com/doc/ae14067709.html, 序列号: 381567 =============================================== 前言:市面上现在天生支持绑定功能的网卡不多,而且多是出身名门的高档服务器网卡,身价不菲,设置过程也比较专业,使用和维护都不简便。难道我等平头百姓,攥着几十元的廉价8139的兄弟们就无缘领略双网卡绑定的快感了吗?非也,今天我就教大家一招,只需一款小小的软件,就可以用普通的8139之类的网卡体验一把双网卡绑定的愉悦,这个软件就叫做“NICExpress”,可能行家们已经捂着嘴乐了,呵呵,笔者的出发点是给菜鸟兄弟们排难解惑,穷办法自娱自乐,说得过火的地方,大家不要见笑,DIY的乐趣就在于此啊。 朋友或许会问了,为什么要用双网卡呢?用双网卡有什么好处?所谓双网卡,就是通过软件将双网卡绑定为一个IP地址,这个技术对于许多朋友来说并不陌生,许多高档服务器网卡(例如intel8255x系列、3COM 服务器网卡等)都具有多网卡绑定功能,可以通过软硬件设置将两块或者多块网卡绑定在同一个IP地址上,使用起来就好象在使用一块网卡。 广告:d_text 多网卡绑定的优点不少,首先,可以增大带宽,假如一个网卡的带宽是100M,理论上两块网卡就是200M,三块就是300M,当然实际上的效果是不会是这样简单的增加的,不过经实际测试使用多个网卡对于增加带宽,保持带宽的稳定性肯定是有裨益的,如果交换机等相关条件不错的话,这个效果还是很能令人满意;其次,可以形成网卡冗余阵列、分担负载,双网卡被绑定成“一块网卡”之后,同步一起工作,对服务器的访问流量被均衡分担到两块网卡上,这样每块网卡的负载压力就小多了,抗并发访问的能力提高,保证了服务器访问的稳定和畅快,当其中一块发生故障的时候,另一块立刻接管全部负载,过程是无缝的,服务不会中断,直到维修人员到来。 OK,现在就手把手的教大家如何用50元来打造出双网卡的效果! 先下载软件(点击这里下载NIC Express Enterprise),这是最新版本4.0,只有2.15M,软件的兼容性已经做得很好,支持win98/Me/2000/XP/2003。基本上支持目前市场上常见的各种网卡,百兆和千兆网卡都可以用来绑定,但是千万注意,最好用于绑定的网卡是完全相同的,至少也是基于同一芯片的,这样多块网卡才能合作得比较好。切记不要把10M网卡和100M网卡绑定在一起,那样根本起不到提升作用。 下载完软件,先不忙安装,咱们还是先准备好硬件。 第一部分:硬件安装 虽然,理论上讲绑定越多网卡在一起,最终效果提升就越明显,但是考虑到复杂程度,这里就以绑定双网卡为例进行说明,如果读者觉得好玩,兴致很高的话,按照下面方法愿意绑定多少就绑定多少个网卡,其实一般同一台服务器,绑定2-3块网卡也就够了,太多了,据说因为链路聚合的先天缺点,会过多占用服务器资源,反过来会影响服务器速度(关于这个我没实验,不过我觉得凡事都离不开物极必反的道理,适度最好)。 我取出“珍藏”的一对市场上随处可见的8139D10M/100M自适应网卡,市场价格25元一个,北京某厂的产品,做工还算精细,总成本50元人民币。

Linux下的双网卡绑定bond0 em1 em2 一、什么是bonding Linux bonding 驱动提供了一个把多个网络接口设备捆绑为单个的网络接口设置来使用,用于网络负载均衡及网络冗余 二、bonding应用方向 1、网络负载均衡 对于bonding的网络负载均衡是我们在文件服务器中常用到的,比如把三块网卡,当做一块来用,解决一个IP地址,流量过大,服务器网络压力过大的问题。对于文件服务器来说,比如NFS或SAMBA文件服务器,没有任何一个管理员会把内部网的文件服务器的IP地址弄很多个来解决网络负载的问题。如果在内网中,文件服务器为了管理和应用上的方便,大多是用同一个IP地址。对于一个百M的本地网络来说,文件服务器在多个用户同时使用的情况下,网络压力是极大的,特别是SAMABA和NFS服务器。为了解决同一个IP地址,突破流量的限制,毕竟网线和网卡对数据的吞吐量是有限制的。如果在有限的资源的情况下,实现网络负载均衡,最好的办法就是bonding 2、网络冗余 对于服务器来说,网络设备的稳定也是比较重要的,特别是网卡。在生产型的系统中,网卡的可靠性就更为重要了。在生产型的系统中,大多通过硬件设备的冗余来提供服务器的可靠性和安全性,比如电源。bonding 也能为网卡提供冗余的支持。把多块网卡绑定到一个IP地址,当一块网卡发生物理性损坏的情况下,另一块网卡自动启用,并提供正常的服务,即:默认情况下只有一块网卡工作,其它网卡做备份 三、bonding实验环境及配置 1、实验环境 系统为:CentOS,使用2块网卡(em1、em2 ==> bond0)来实现bonding技术 2、bonding配置 第一步:先查看一下内核是否已经支持bonding 1)如果内核已经把bonding编译进内核,那么要做的就是加载该模块到当前内核;其次查看ifenslave该工具是否也已经编译 modprobe -l bond* 或者modinfo bonding modprobe bonding lsmod | grep 'bonding' echo 'modprobe bonding &> /dev/null' >> /etc/rc.local(开机自动加载bonding模块到内核) which ifenslave 注意:默认内核安装完后就已经支持bonding模块了,无需要自己手动编译 2)如果bonding还没有编译进内核,那么要做的就是编译该模块到内核 (1)编译bonding tar -jxvf kernel-XXX.tar.gz cd kernel-XXX

服务器多网卡捆绑 1、Linux系统 1-1、 RHEL5下双网卡绑定。 1-1-1、新增网卡 这个新增的网卡是我们自己设计的虚拟的网卡,在物理上是不存在的。 1-1-2、修改物理网卡配置

1-1-3、设置虚拟网卡模块 说明:miimon是用来进行链路监测的。比如:miimon=500,那么系统每500ms监测一次链路连接状态,如果有一条线路不通就转入另一条线路;mode的值表示工作模式,他共有0-6 七种模式,常用的为0,1两种。 ?mode=0表示load balancing (round-robin)为负载均衡方式,两块网卡都工作。 ?mode=1表示fault-tolerance (active-backup)提供冗余功能,工作方式是主备的工作方式,也就是说默认情况下只有一块网卡工作,另一块做备份. bonding只能提供链路监测,即从主机到交换机的链路是否接通。如果只是交换机对外的链路down掉了,而交换机本身并没有故障,那么bonding会认为链路没有问题而继续使用。 例子中使用mode=0的配置来做负载均衡提高系统性能,增大并发带宽。

1-1-4、加载模块(重启系统后就不用手动再加载了) 1-1-5确认模块是否加载成功: 1-1-6、重启网络: 用外部同一网段的一台机器做ping试验,双网卡机器上手工拔掉其中任意一条网络线(或者使用ifup eth0|ifdown eth1),ping机器的终端应该没有中断信息,或者有一个”timeout”后很快恢复,则证明试验成功。 1-2、 RHEL6下双网卡绑定 1-2-1、新增网卡 这个新增的网卡是我们自己设计的虚拟的网卡,在物理上是不存在的。

双网卡绑定实践 Windows平台下常用的双网卡绑定软件有Intel PROSet、NICExpress。本文主要介绍用Intel PROset实现双网卡绑定的方法。 英特尔PROSet 是一个高级的配置实用程序,可用来测试英特尔网络适配器并配置标准和高级功能。通常Intel网卡的驱动包中就包含这个程序,在安装驱动的时候PROSet默认是被安装的。 测试环境: 测试机:R525 G3,Intel双千兆网卡 OS:windows 2003 server 企业版32位 终端:联想笔记本(用于测试服务器双网卡绑定效果) 步骤: 1、打开设备管理器,双击任意一块Intel 82576; 注意R525 G3默认有3块网卡,82574L是管理网口 2、在弹出的配置对话框中,选择分组页面。此时由于系统中的网卡没有进行绑定,因此此

时组下拉列表框是灰色不可选的,单击“新组”; 3、在弹出的“新组向导”对话框中,填写组的名称,下一步; 4、钩选需要绑定的两个网卡,下一步;

5、这里列出了可选择的网卡绑定的模式,常用的是容错和负载平衡。这里我们选择容错,单击下一步; 6、完成向导;

7、此时我们可以看到刚才的分组页面中组的下拉列表中已经有team1; 8、同时弹出的还有team1的属性对话框,单击设置页面,可以看到其中一块网卡状态为“活动”,另一块网卡装状态为“待命”。在此界面中还可进行删除组和修改组的操作,单击“修改组”;

9、在弹出的对话框中,可以设置双网卡的主从关系,如不进行设定,此关系是不固定的。即:当断掉当前活动状态的主网口时,待命的网口将接替主网口的位置,对外提供服务,并成为主网口。当之前断开的网口恢复后,主从关系不会改变,该网口变为待命状态。 10、固定主从关系,设置当前活动的网口为主适配器,待命网口为次适配器;

提高服务器可用性的多网卡绑定聚合技术的应用 王和平 摘要:通过NICExpress软件对服务器多网卡进行捆绑聚合,以实现增加带宽、负载均衡、故障自动转移等,从而达到服务器的高可靠性和高可用性。 关键词:网卡聚合;服务器;高可用性 一、引言 现今几乎各行各业内部都建立了自己的服务器,由于服务器的特殊地位,它的可靠性、可用性及其I/O速度就显得非常的重要,保持服务器的高可用性和安全性是企业IT环境的重要指标,其中最重要的一点是服务器网络连接的高可用性。本文通过NICExpress软件,通过实际部署服务器多网卡,以提高服务器网络连接的可用性,配合实现构建高可靠性的网络环境。 二、网卡聚合绑定的特点 网卡绑定聚合就是通过软件将多块网卡绑定为一个IP地址,使用起来就好象在使用一块网卡。网卡是计算机和外部联系的主要通道。个人计算机默认安装一块网卡,服务器基本配置应该安装两块网卡。如果服务器上仅安装一块网卡,建议管理员至少增加一块网卡。一块为主网卡,其他为备用网卡,然后再通过网线将对应的网卡连接到同一交换机上。在服务器和交换机之间建立主连接和备用连接。通过NICExpress虚拟网卡软件将多块网卡绑定为一块网卡,或称之为虚拟网卡组,然后为虚拟网卡组设置一个唯一的IP地址。安装多块网卡后,通过多网卡并发方式传输数据,有利于提高网络传输效率,提高系统性能。一旦网卡组中的任何一个物理连接断开,比如网卡出现故障或链路断开,系统软件将自动监测连接状态,出现故障的网卡将自动切换到其他网卡的物理连接上。 在服务器中部署多块网卡聚合绑定后,将具备如下特点: 1.增加带宽。假如网卡的带宽100Mbps,那么理论上两块网卡聚合绑定后的带宽就是200Mbps,三块网卡聚合绑定后的带宽就是300Mbps。当然实际上的效果是不会这样简单相加的,不过经实际测试使用多个网卡绑定对于增加带宽,保持带宽的稳定性肯定是有益的。经过实际测量,三块带宽为100Mbps的网卡绑定后传输总带宽可以达到260Mbps。 2.均衡负载。多块网卡聚合绑定,可以形成网卡冗余阵列、分担负载。多块网卡被聚合绑定成“一块网卡”之后,网卡之间同步工作,对服务器的访问流量被均衡分配到不同网卡上,从而减轻每块网卡的网络负载,增强服务器的并发访问能力,服务器性能。 3.故障自动切换。如果服务器中的任一网卡出现故障,那么其他网卡将自动接管全部负载,过程是无缝的,数据传输不会中断。服务器中的系统服务或者应用不会中断,增强服务器的可用性。 三、网卡绑定聚合的原则 在服务器中部署多块网卡绑定聚合应该遵循以下原则: 1.聚合绑定的网卡型号应该相同、性能指标要一致,否则运行过程中不稳定,容易出错甚至蓝屏。 2.最大网卡数量原则。绑定的网卡越多,总带宽的增加效果似乎就越明显;但其实还应该考虑到网卡绑定聚合后在运行过程中会过多占用服务器资源,反过来会在一定程度影响服务器的运行速度。所以,管理员可以参考计算机配置和管理软件所支持的最大网卡数量。 3.所有的网卡建议连接到同一台交换机上。 四、部署过程 下面以NICExpress软件实际部署为例,说明多网卡的绑定聚合过程。

常用操作系统双网卡绑定方法 目录 一、RHEL 5.7 LINUX 下网卡绑定设置 (1) 二、RHEL6 LINUX 下网卡绑定设置 (3) 三、SUSE 10 下网卡绑定设置 (11) 四、SUSE 11 下网卡绑定设置 (16) 五、Windows 下网卡绑定设置 (22) 一、RHEL 5.7 LINUX 下网卡绑定设置 [root@Linux5 ~]# more /etc/sysconfig/network-scripts/ifcfg-bond0 # Broadcom Corporation NetXtreme II BCM5709S Gigabit Ethernet DEVICE=bond0 BOOTPROTO=static ONBOOT=yes IPADDR=10.96.19.207 NETMASK=255.255.255.0 GATEWAY=10.96.19.1 TYPE=Ethernet [root@Linux5 ~]# more /etc/sysconfig/network-scripts/ifcfg-eth0 # Broadcom Corporation NetXtreme II BCM5709S Gigabit Ethernet DEVICE=eth0 BOOTPROTO=none HWADDR=34:40:B5:BD:24:18 ONBOOT=yes MASTER=bond0 SLAVE=yes TYPE=Ethernet [root@Linux5 ~]# more /etc/sysconfig/network-scripts/ifcfg-eth1 # Broadcom Corporation NetXtreme II BCM5709S Gigabit Ethernet DEVICE=eth1 BOOTPROTO=none HWADDR=34:40:B5:BD:24:1A ONBOOT=yes MASTER=bond0

Broadcom Gigabit Ethernet Adapter Teaming 任何可用的千兆BRODCOM网卡都可以配置为TEAM的一部分.TEAMING是一种将多块千兆BRODCOM网卡绑定作为一个虚拟网卡.好处就是负载均衡. 通过选择每一个可用的千兆BRODCOM网卡并添加它们到负载均衡成员栏来创建TEAM.对于用户和应用程序,只看到一个虚的网卡. 负载均衡组中的成员共享绑定的数据流. 在一个基本的成员区域中,任一个千兆BRODCOM网卡都可以被指定为主成员负责数据流的控制,而指定为备用成员的网卡只有在所有的主 成员网卡都失败时,才开始接管数据流.一旦任一个主成员网卡恢复,数据马上由该主成员控制. 创建teaming包含下列几个步骤: * 打开BASP属性窗口 * 创建teams * 添加网卡到teams * 分配一个IP地址给teamss * 重启机器 BASP是适用于windows2003,windows2000,windowsNT,Redhat Liunx,NetWare的一个broadcom的中介型驱动程 序,需要先安装对应的broadcom网卡驱动程序. 目前它提供了负载均衡;错误冗余;VLAN高级功能,都通过创建teaming来实现. 注意: 一个team可以包含1到8个网卡,每个网卡都可以指定为主成员或备用成员. BASP的负载均衡;错误冗余功能支持与第三方厂商网卡在同一个team中协同工作. BASP FOR Windows 2000 & 20003 & NT提供以下选项: - 支持下列网卡作为故障应急(failover) Alteon AceNic,3COM 10/100 Server adapters;intel 10/1000 server

端口聚合(IEEE802.3ad Port Trunking) 可将2至8个10/100Base-TX端口聚合成一条干路,在全双工工作模式下达到400Mbps-1.6Gbps的带宽。端口聚合技术能充分利用现有设备实现高速数据传递,也可以通过千兆端口聚合技术实现千兆位链路的聚合,最多可以聚合4Gbps的链路带宽。 Broadcom Gigabit Ethernet Adapter Teaming 任何可用的千兆BRODCOM网卡都可以配置为TEAM的一部分.TEAMING是一种将多块千兆BRODCOM 网卡绑定作为一个虚拟网卡.好处就是负载均衡. 通过选择每一个可用的千兆BRODCOM网卡并添加它们到负载均衡成员栏来创建TEAM.对于用户和应用程序,只看到一个虚的网卡. 负载均衡组中的成员共享绑定的数据流. 在一个基本的成员区域中,任一个千兆BRODCOM网卡都可以被指定为主成员负责数据流的控制,而指定为备用成员的网卡只有在所有的主 成员网卡都失败时,才开始接管数据流.一旦任一个主成员网卡恢复,数据马上由该主成员控制. 创建teaming包含下列几个步骤: * 打开BASP属性窗口 * 创建teams * 添加网卡到teams * 分配一个IP地址给teamss * 重启机器 BASP是适用于windows2003,windows2000,windowsNT,Redhat Liunx,NetWare的一个broadcom的中介型驱动程 序,需要先安装对应的broadcom网卡驱动程序. 目前它提供了负载均衡;错误冗余;VLAN高级功能,都通过创建teaming来实现. 注意: 一个team可以包含1到8个网卡,每个网卡都可以指定为主成员或备用成员. BASP的负载均衡;错误冗余功能支持与第三方厂商网卡在同一个team中协同工作. BASP FOR Windows 2000 & 20003 & NT提供以下选项: - 支持下列网卡作为故障应急(failover) Alteon AceNic,3COM 10/100 Server adapters;intel 10/1000 server adapters;intel 1000baseSX server adapter; intel 82559 板载网卡 - 智能负载均衡,交换机不需设置. - 普通链路聚合(GEC/FEC,Open Trunk),需要在交换机上启用trunking - IEEE802.3ad链路聚合(静态配置),需要交换机支持802.3ad - 通过IEEE802.1Q-1988tagging,每个网卡最多支持64个VLANS,只支持braodcom或Alteon网卡

INTERNET双网卡绑定一个IP 第一步:安装好所有网卡驱动程序,可以在网络-->适配器里看到如图一(当然可能你没有这么多的网卡,只看到两张或三张),其中有两张INTERNET 的网卡,因我这么服务器是HP的,网卡已经是OEM产品了,所以显示的是HP 10/100TX PCI FAST ETHERNET ADAPTER,如果你买的是原装INTERNET网卡,显示的应是INTETNET 10/100TX PCI FAST ETHERNET ADAPTER(以下不再另加说明)。 此主题相关图片如下: 第二步:选中[1] HP 10/100TX PCI ETHERNET ADAPTER BUS 0 ...点击属性(P)...出现另一对话框,如图二:

第三步:在Show all 8255x-based adapters前面的小方框点上小勾,如图三: 第四步:经过第三步,可以看到所有的INTERNET网卡都显示出来了,点击Adapter Teaming,出现图四:

第五步:从图四中可以看出,出现一个二块小网卡的标志,那就是网卡组,不过现在还没有加入网卡,图四的下部分是网卡组的功能,第一个是AFT ONLY 即容错功能,第二个是load balancing即网络平衡功能,第三个是fast etherchannel即加快网络速度功能,一般来说做无盘是为了加快速度,所以要选第三个。 第六步:选中图四网卡组下面的网卡,点击Move Up,得到如图五所示的配置:

第七步:图五中点OK确定,在网络-->适配器里可以看到多了一个适配器,如图六:

第八步:在图六中点协议,再选中TCP/IP通讯协议,如图七:

如何让双网卡同时工作 NIC Express是一款功能非常独特的网络加速程序(点击下载NIC Express),可以绑定多块网卡以组成一块虚拟网卡,这样可以增加网络的带宽,当然前提是网卡的传输速率必须相同,这样才能在网络高负荷状态时实现负载均衡,否则是没有任何意义的。 程序的安装 接下来,就可以开始安装和配置NIC Express,这里需要注意的主要有3个方面: 1. 启用网络负载均衡 安装过程中会弹出一个提示对话框,这里是询问是否启用“Load Balancing function ali ty”,即网络负载均衡,这个功能可以在数据流量比较大时自动分配到各个网卡产上,以减轻单块网卡的压力,从而达到流畅的访问效果,因此这里当然是选择“Enabled”啦。 2. 虚拟网卡驱动程序的安装 安装过程的最后会报告说NIC Express的虚拟网卡驱动程序未曾通过Windows徽标测试,无法验证同Windows XP的相容性,询问是否继续,请单击“仍然继续”按钮继续安装。 3. 设置绑定的网卡 接下来,我们需要对绑定的网卡进行设置。计算机中安装的所有网卡将在主窗口的“A vailab le”列表框中出现,选中后单击“Add”按钮将其添加到下面的“Assigned Adapter s”列表框中即可完成添加操作。 默认设置下,绑定网卡组会使用“New Array”作为名称,当然也可以重新输入一个名称,然后会进入配置对话框,我们并不需要进行修改,直接使用默认设置即可。 网卡组的设置

进入“网络连接”窗口,可以看到本地连接图标已增加为3个,增加的那个“NIC Exp ress Virtual Miniport”就是绑定后的网卡组,它的使用与单一网卡完全相同,相当于一个单一的虚拟网卡,按照单一网卡的设置参数进行设置即可,可以为这块虚拟网卡设置IP 地址、子网掩码、网关等参数。 1. 设置监控内容 从开始菜单的程序组中找到“NIC Express Enterprise Edition”选项,这是NIC Exp ress软件自带的一个监控程序,在“setting”标签页中可以设置网卡流量的计量单位,这里提供了Packets/Sec、 Mbits/Sec、Kbits/Sec三种单位,默认使用Mbits/Sec(兆/每秒),我们只需要在“Graph Detail”中将默认的“By Protocol”重置为“By Incoming/Outgoi ng”即可。 如果你希望观察网卡组中每块网卡的流量或者整个组的流量,只要在“Select Device”中选择相应的设备即可。 2. 设置网卡绑定模式 切换到“Advanced”标签页,你可以在这里设置网卡绑定的工作模式,双网卡组默认工作在“NIC Express ELB”模式;如果需要关闭网络负载均衡功能,可以在这里选择“Load Balancing Disa ble”,其他的选项就不用设置了。 NIC Express可以通过绑定多块网卡以增加网络的带宽.需要注意的一点,在绑定网卡时,网卡的传输速率必须相同NIC Express才可以在网络高负荷状态做到负载均衡,否则是没有任何意义的。 我照着以上提示安装并设置,但是发现该软件不支持winXP,只能发现一个网卡。 不知哪位高手能提供一个新的软件解决绑定双网卡。

suse linux双网卡绑定设置详解 双网卡的绑定可以实现冗余和高可用性,在suse linux 10中和redhat linux 5中设置双网卡绑定是不太一样的,下面详解一下suse linux 下的双网卡绑定: 步骤1:进入到网络配置目录 # cd /etc/sysconfig/network 步骤2:创建ifcfg-bond0配置文件 Vi ifcfg-bond0 输入如下内容保存 BOOTPROTO='static' BROADCAST='' IPADDR='172.27.120.21 #要绑定的ip地址 NETMASK='255.255.255.0 '#网段的掩码 NETWORK='' STARTMODE='onboot' BONDING_MASTER='yes' BONDING_MODULE_OPTS='mode=1 miimon=100 ' # mode=1是主备模式(active-backup) mode=0是平衡模式(balance_rr) BONDING_SLAVE0='eth0' #第一块网卡的mac地址 BONDING_SLAVE1='eth1' #第二块网卡的mac地址 ETHTOOL_OPTIONS='' MTU='' NAME='' REMOTE_IPADDR='' USERCONTROL='no' 步骤3:使用yast进入网卡的配置界面,把原有的两块网卡设置为没有ip,网卡模式改为自动获取地址模式,删除/etc/sysconfig/network下的已经绑定的网卡的配置文件 步骤4:注意默认网关的配置,使用yast管理工具进入路由设置界面,或者通过修改配置文件的方式并运行命令进行配置 配置默认网关。 # vi routes 插入如下内容 default 172.27.120.254 - - # route add default gw 172.27.120.254 步骤5:重启网络服务,使配置生效 # rcnetwork restart 步骤6:验证 (1) 输入ifconfig可以看到bond0已经运行了,bond0、eth1、eth0的MAC地址都是一样 JSBC-SIHUA-DB02:/etc/sysconfig/network # ifconfig bond0 Link encap:Ethernet HWaddr 78:2B:CB:4B:54:D5

一、L inux bonding研究及实现 Linux Bonding 本文介绍Linux(具体发行版本是CentOS5.6)下的双卡绑定的原理及实现。 Linux双网卡绑定实现是使用两块网卡虚拟成为一块网卡设备,这简单来说,就是两块网卡具有相同的IP地址而并行链接聚合成一个逻辑链路工作。这项技术在Sun和Cisco中分别被称为Trunking和Etherchannel技术,在Linux的2.4.x及其以后的内核则称为Bonding技术。 bonding的前提条件:网卡应该具备自己独立的BIOS芯片,并且各网卡芯片组型号相同。同一台服务器上的网卡毫无疑问是是符合这个条件的。 Bonding原理 bonding的原理:在正常情况下,网卡只接收目的硬件地址(MAC Address)是自身MAC的以太网帧,过滤别的数据帧,以减轻驱动程序的负担;但是网卡也支持另外一种被称为混杂promisc的模式,可以接收网络上所有的帧,bonding就运行在这种模式下,而且修改了驱动程序中的mac地址,将两块网卡的MAC地址改成相同,可以接收特定MAC的数据帧。然后把相应的数据帧传送给bond驱动程序处理。 为方便理解bonding的配置及实现,顺便阐述一下Linux的网络接口及其配置文件。在Linux 中,所有的网络通讯都发生在软件接口与物理网络设备之间。与网络接口配置相关的文件,以及控制网络接口状态的脚本文件,全都位于/etc/sysconfig/netwrok-scripts/ 目录下。网络

接口配置文件用于控制系统中的软件网络接口,并通过这些接口实现对网络设备的控制。当系统启动时,系统通过这些接口配置文件决定启动哪些接口,以及如何对这些接口进行配置。接口配置文件的名称通常类似于ifcfg-

端口聚合( Port Trunking ) 可将2至8个10/100Base-TX 端口聚合成一条干路,在全双工工作模式下达到的带宽。端口聚合技术能充分利用现有设备实现高速数据传递,也可以通过千兆端口聚合技术实现千兆位链路的聚合,最多可以聚合4Gbps的链路带宽。 Broadcom Gigabit Ethernet Adapter Teaming 任何可用的千兆BRODCO网卡都可以配置为TEAM勺一部分.TEAMING是一种将多块千兆BRODCC网卡绑定作为一个虚拟网卡. 好处就是负载均衡. 通过选择每一个可用的千兆BRODCC网卡并添加它们到负载均衡成员栏来创建TEAM对于用户和应用程序 只看到一个虚的网卡. 负载均衡组中的成员共享绑定的数据流. 在一个基本的成员区域中,任一个千兆BRODCOM卡都可以被指定为主成员负责数据流的控制,而指定为备用成员的网卡只有在所有的主 成员网卡都失败时,才开始接管数据流.一旦任一个主成员网卡恢复,数据马上由该主成员控制. 创建teaming 包含下列几个步骤: * 打开BASP属性窗口 * 创建teams * 添加网卡到teams * 分配一个IP 地址给teamss * 重启机器 BASP是适用于windows2003,windows2000,windowsNT,Redhat Liunx,NetWare 的一个broadcom 的中介型驱动程 序, 需要先安装对应的broadcom 网卡驱动程序.

目前它提供了负载均衡;错误冗余;VLAN高级功能,都通过创建teaming来实现. 注意:一个team可以包含1到8个网卡,每个网卡都可以指定为主成员或备用成员. BASP的负载均衡;错误冗余功能支持与第三方厂商网卡在同一个team中协同工作. BASP FOR Windows 2000 & 20003 & NT提供以下选项: - 支持下列网卡作为故障应急(failover) Alteon AceNic,3COM 10/100 Server adapters;intel 10/1000 server adapters;intel 1000baseSX server adapter; intel 82559 板载网卡 - 智能负载均衡, 交换机不需设置. - 普通链路聚合(GEC/FEC,Open Trunk), 需要在交换机上启用trunking - 链路聚合( 静态配置), 需要交换机支持 - 通过,每个网卡最多支持64个VLANS只支持braodcom或Alteon网卡 BASP FOR RH Linux 提供以下几种team 的模式: - 智能负载均衡 普通链路聚合(GEC/FEC,Open Trunk), 需要在交换机上启用trunking 链路聚合( 静态配置), 需要交换机支持 - VLAN Pachket tagging Smart Load Balancing (SLB) ?

intel、博康、Marvell、NF网卡的动态负载均衡设置 部分内容由网上摘抄修改 Marvell网卡绑定教程 控制台及驱动下载:https://www.doczj.com/doc/ae14067709.html,/product.aspx?P_ID=4zanuPTONhbnijk4 https://www.doczj.com/doc/ae14067709.html,/pub/ASUS/mb/socket775/P5BV-C/DRIVER/CPA_Win32_56423.zip 控制台和驱动的安装就不说了,一直下一步就可以了! 现在打开控制台软件:

单击“add team”按钮,弹出下面窗口: 注:"teaming mode"选择"static"

OK分组"BOOT"创建完毕: 最后将网卡添加进刚刚建立的BOOT分组即可:

4网卡汇聚最终图:

NF网卡绑定教程 https://www.doczj.com/doc/ae14067709.html,/Windows/nForce/9.28/9.28_nforce_winserv2003_32bit_international_whql.exe 下载解压,网卡驱动在Ethernet目录,网卡绑定软件在\Ethernet\NAM目录。 安装好之后,运行开始菜单的NVIDIA Corporation\NVIDIA Control Panel\networking项 显示如下界面,单击“Adjust teaming configuration”项

可以选择“use default teaming configuration”自动按默认设置组。 也可以选择“use custom teaming configuration”,弹出引导设置窗口。 选择自动负载均衡及容错“Load Balance and Failover”模式,点击下一步

SUSE 11图形界面操作双网卡绑定1.输入yast2登入图形界面,选择Network Settings点击进去 2.选择Overview中Add,进去选择Bond,并进行网卡命名后进行下一步

3.在静态地址中输入你所需要指定的IP,选择Bond Slaves

4.将两块网卡选择为绑定网卡,并选择参数。(下面会将每个参数作解释,根据实际需求选择)

balance-rr (mode=0) 轮转(Round-robin)策略:从头到尾顺序的在每一个slave接口上面发送数据包。本模式提供负载均衡和容错的能力。 active-backup(mode=1) 活动-备份(主备)策略:在绑定中,只有一个slave被激活。当且仅当活动的slave 接口失败时才会激活其他slave。为了避免交换机发生混乱此时绑定的MAC地址只有一个外部端口上可见。在bongding的2.6.2及其以后的版本中,主备模式下发生一次故障迁移时,bonding将在新激活的slave上会送一个或者多个gratuitous ARP.bonding的主salve接口上以及配置在接口上的所有VLAN接口都会发送gratuitous ARP,只要这些接口上配置了至少一个IP地址。VLAN接口上发送的的gratuitous ARP将会附上适当的VLAN id。本模式提供容错能力,primary option,documented below会影响本模式的行为。 balance-xor(mode=2) XOR策略:基于所选择的传送hash策略。 本模式提供负载均衡和容错的能力。 broadcast(mode=3) 广播策略:在所有的slave接口上传送所有的报文。本模式提供容错能力。 802.3ad(mode=4) IEEE 802.3ad 动态链路聚合。创建共享相同的速率和双工模式的聚合组。能根据802.3ad 规利用所有的slave来建立聚合链路。Salve的出站选择取决于传输的hash策略,默认策略是简单的XOR策略,而hash策略则可以通xmit_hash_policy选项加以改变。需要注意的是:不是所有的传输策略都与802.3ad兼容,尤其是802.3ad标准的43.2.4章节中关于packet mis-ordering要求的地方。不同个体的实现往往出现很大的不兼容。 先决条件: 1. 每个slave的基本驱动支持Ehtool获取速率和双工状态。 2.交换机支持IEEE 802.3ad动态链路聚合。大多数的交换机都需要使用某种配置方式来启用802.3ad模式。

Windows2012网卡绑定 在服务器管理器中,定位到本地服务器,可以看到网卡的状态,其中NIC组合显示为已禁用。点击它。 在NIC组合的适配器和借口窗口中,选择需要绑定的网卡,点击任务,添加到新组。

弹出新建组窗口,勾选需要绑定的网卡,并为新组起名team1。

其它属性——成组模式: a、静态成组(IEEE 802.3ad draft v1):此模式配置交换机和主机之间需要哪种链接组 合形式,由于这是一个静态配置的解决方案有任何附加协议,所以就不会因为交换机或主机因为电缆的插入错误或其它错误而导致组合的形成.此种模式中,网卡可以工作于不同的速度,就是说可以用不通速度的网卡建立组合, 但同样要求交换机完全支持IEEE 802.3ad 标准,一般情况下,服务器级别的交换机通常支持此模式. b、交换机独立:这是配置时的默认值,此模式不要求交换机参与组合配置,由于独 立模式下的交换机不知道网卡是主机上组合一部分,网卡可以连接到不同的交换机. c、LACP动态组合(IEEE 802.1ax, LACP):LACP动态组合是到同一台交换机的链路聚合, 只不过不是静态配置的,而是动态构成(也就是自动协商)的.它是通过一种智能的链路协商协议LACP (Link Aggregation Control Protocol)来实现的.LACP原本用于交换机和交换机之间的链路聚合,启用了LACP协议的2台交换机会相互发送LACP的协商报文,当发现2者之间有多条可用的链路的时候,自动将这些链路组合成一条带宽更大的逻辑链路,从而利用负载均衡来实现加宽交换机间链路带宽的目的.