Spark入门实战系列--6.SparkSQL(上)--SparkSQL简介

【注】该系列文章以及使用到安装包/测试数据可以在《倾情大奉送--Spark入门实战系列》获取

1、SparkSQL的发展历程

1.1Hive and Shark

SparkSQL的前身是Shark,给熟悉RDBMS但又不理解MapReduce的技术人员提供快速上手的工具,Hive应运而生,它是当时唯一运行在Hadoop上的SQL-on-Hadoop工具。但是MapReduce计算过程中大量的中间磁盘落地过程消耗了大量的I/O,降低的运行效率,为了提高SQL-on-Hadoop的效率,大量的SQL-on-Hadoop工具开始产生,其中表现较为突出的是:

●MapR的Drill

●Cloudera的Impala

●Shark

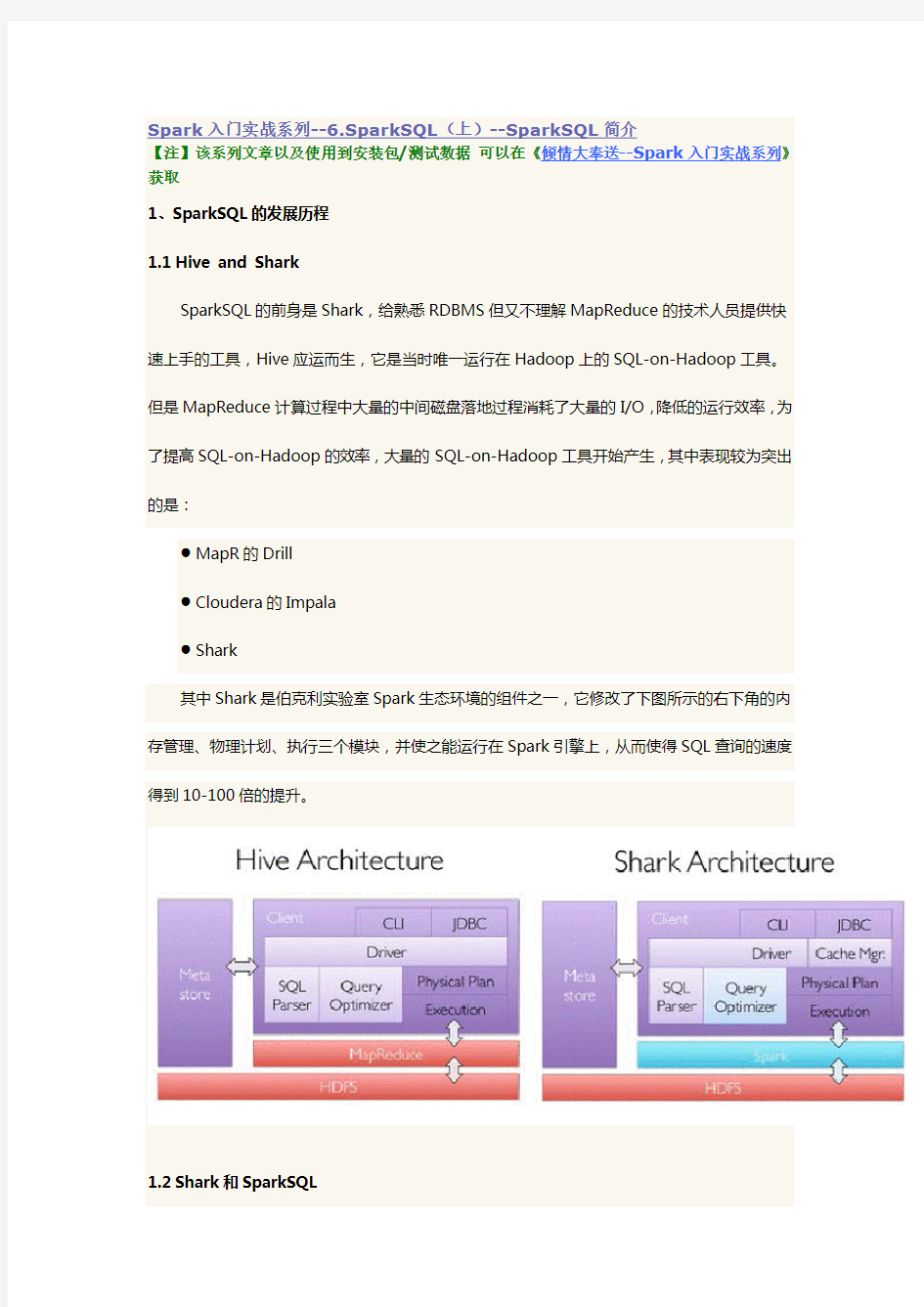

其中Shark是伯克利实验室Spark生态环境的组件之一,它修改了下图所示的右下角的内存管理、物理计划、执行三个模块,并使之能运行在Spark引擎上,从而使得SQL查询的速度得到10-100倍的提升。

1.2Shark和SparkSQL

但是,随着Spark的发展,对于野心勃勃的Spark团队来说,Shark对于Hive的太多依赖(如采用Hive的语法解析器、查询优化器等等),制约了Spark的One Stack Rule Them All 的既定方针,制约了Spark各个组件的相互集成,所以提出了SparkSQL项目。SparkSQL抛弃原有Shark的代码,汲取了Shark的一些优点,如内存列存储(In-Memory Columnar Storage)、Hive兼容性等,重新开发了SparkSQL代码;由于摆脱了对Hive的依赖性,SparkSQL 无论在数据兼容、性能优化、组件扩展方面都得到了极大的方便,真可谓“退一步,海阔天空”。

●数据兼容方面不但兼容Hive,还可以从RDD、parquet文件、JSON文件中获取数据,

未来版本甚至支持获取RDBMS数据以及cassandra等NOSQL数据;

●性能优化方面除了采取In-Memory Columnar Storage、byte-code generation等优

化技术外、将会引进Cost Model对查询进行动态评估、获取最佳物理计划等等;

●组件扩展方面无论是SQL的语法解析器、分析器还是优化器都可以重新定义,进行扩展。

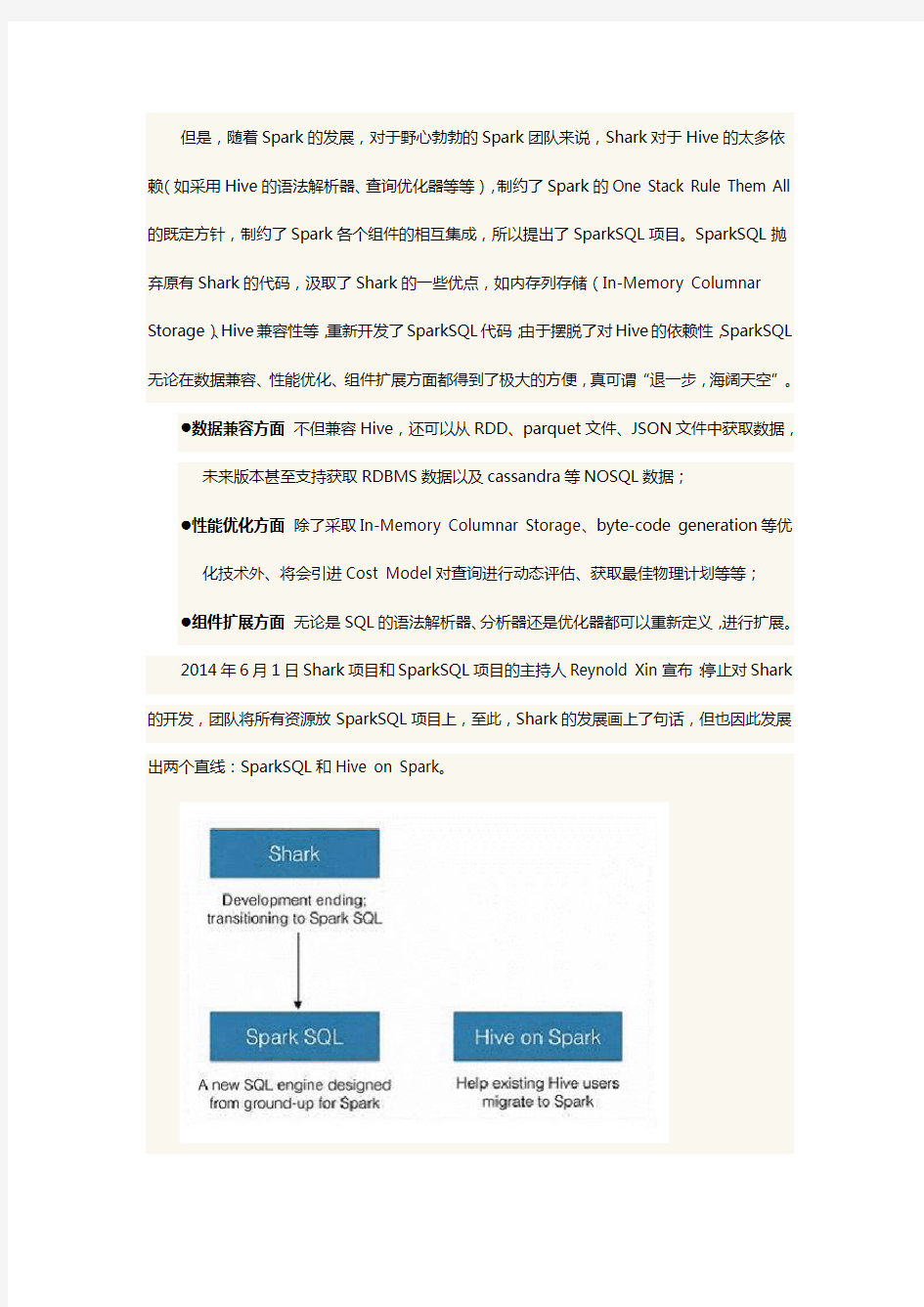

2014年6月1日Shark项目和SparkSQL项目的主持人Reynold Xin宣布:停止对Shark 的开发,团队将所有资源放SparkSQL项目上,至此,Shark的发展画上了句话,但也因此发展出两个直线:SparkSQL和Hive on Spark。

其中SparkSQL作为Spark生态的一员继续发展,而不再受限于Hive,只是兼容Hive;而Hive on Spark是一个Hive的发展计划,该计划将Spark作为Hive的底层引擎之一,也就是说,Hive将不再受限于一个引擎,可以采用Map-Reduce、Tez、Spark等引擎。

1.3SparkSQL的性能

Shark的出现,使得SQL-on-Hadoop的性能比Hive有了10-100倍的提高:

那么,摆脱了Hive的限制,SparkSQL的性能又有怎么样的表现呢?虽然没有Shark相对于Hive那样瞩目地性能提升,但也表现得非常优异:

为什么SparkSQL的性能会得到怎么大的提升呢?主要SparkSQL在下面几点做了优化:

A:内存列存储(In-Memory Columnar Storage)

SparkSQL的表数据在内存中存储不是采用原生态的JVM对象存储方式,而是采用内存列存储,如下图所示。

该存储方式无论在空间占用量和读取吞吐率上都占有很大优势。

对于原生态的JVM对象存储方式,每个对象通常要增加12-16字节的额外开销,对于一个270MB的TPC-H lineitem table数据,使用这种方式读入内存,要使用970MB左右的内存空间(通常是2~5倍于原生数据空间);另外,使用这种方式,每个数据记录产生一个JVM对象,如果是大小为200B的数据记录,32G的堆栈将产生1.6亿个对象,这么多的对象,对于GC来说,可能要消耗几分钟的时间来处理(JVM的垃圾收集时间与堆栈中的对象数量呈线性相关)。显然这种内存存储方式对于基于内存计算的Spark来说,很昂贵也负担不起。

对于内存列存储来说,将所有原生数据类型的列采用原生数组来存储,将Hive支持的复杂数据类型(如array、map等)先序化后并接成一个字节数组来存储。这样,每个列创建一个JVM 对象,从而导致可以快速的GC和紧凑的数据存储;额外的,还可以使用低廉CPU开销的高效压缩方法(如字典编码、行长度编码等压缩方法)降低内存开销;更有趣的是,对于分析查询中频繁使用的聚合特定列,性能会得到很大的提高,原因就是这些列的数据放在一起,更容易读入内存进行计算。

B:字节码生成技术(bytecode generation,即CG)

在数据库查询中有一个昂贵的操作是查询语句中的表达式,主要是由于JVM的内存模型引起的。比如如下一个查询:

SELECT a + b FROM table

在这个查询里,如果采用通用的SQL语法途径去处理,会先生成一个表达式树(有两个节点的Add树,参考后面章节),在物理处理这个表达式树的时候,将会如图所示的7个步骤:

1.调用虚函数Add.eval(),需要确认Add两边的数据类型

2.调用虚函数a.eval(),需要确认a的数据类型

3.确定a的数据类型是Int,装箱

4.调用虚函数b.eval(),需要确认b的数据类型

5.确定b的数据类型是Int,装箱

6.调用Int类型的Add

7.返回装箱后的计算结果

其中多次涉及到虚函数的调用,虚函数的调用会打断CPU的正常流水线处理,减缓执行。Spark1.1.0在catalyst模块的expressions增加了codegen模块,如果使用动态字节码生成技术(配置spark.sql.codegen参数),SparkSQL在执行物理计划的时候,对匹配的表达式采用特定的代码,动态编译,然后运行。如上例子,匹配到Add方法:

然后,通过调用,最终调用:

最终实现效果类似如下伪代码:

val a: Int = inputRow.getInt(0)

val b: Int = inputRow.getInt(1)

val result: Int = a + b

resultRow.setInt(0, result)

对于Spark1.1.0,对SQL表达式都作了CG优化,具体可以参看codegen模块。CG优化的实现主要还是依靠scala2.10的运行时放射机制(runtime reflection)。对于SQL查询的CG优化,可以简单地用下图来表示:

C:Scala代码优化

另外,SparkSQL在使用Scala编写代码的时候,尽量避免低效的、容易GC的代码;尽管增加了编写代码的难度,但对于用户来说,还是使用统一的接口,没受到使用上的困难。下图是一个Scala代码优化的示意图:

2、SparkSQL运行架构

类似于关系型数据库,SparkSQL也是语句也是由Projection(a1,a2,a3)、Data Source (tableA)、Filter(condition)组成,分别对应sql查询过程中的Result、Data Source、Operation,也就是说SQL语句按Result-->Data Source-->Operation的次序来描述的。

当执行SparkSQL语句的顺序为:

1.对读入的SQL语句进行解析(Parse),分辨出SQL语句中哪些词是关键词(如SELECT、FROM、

WHERE),哪些是表达式、哪些是Projection、哪些是Data Source等,从而判断SQL 语句是否规范;

2.将SQL语句和数据库的数据字典(列、表、视图等等)进行绑定(Bind),如果相关的Projection、

Data Source等都是存在的话,就表示这个SQL语句是可以执行的;

3.一般的数据库会提供几个执行计划,这些计划一般都有运行统计数据,数据库会在这些计划中

选择一个最优计划(Optimize);

4.计划执行(Execute),按Operation-->Data Source-->Result的次序来进行的,在执行过

程有时候甚至不需要读取物理表就可以返回结果,比如重新运行刚运行过的SQL语句,可能直接从数据库的缓冲池中获取返回结果。

2.1Tree和Rule

SparkSQL对SQL语句的处理和关系型数据库对SQL语句的处理采用了类似的方法,首先会将SQL语句进行解析(Parse),然后形成一个Tree,在后续的如绑定、优化等处理过程都是对Tree的操作,而操作的方法是采用Rule,通过模式匹配,对不同类型的节点采用不同的操作。在整个sql语句的处理过程中,Tree和Rule相互配合,完成了解析、绑定(在SparkSQL 中称为Analysis)、优化、物理计划等过程,最终生成可以执行的物理计划。

2.1.1 Tree

●Tree的相关代码定义在

sql/catalyst/src/main/scala/org/apache/spark/sql/catalyst/trees

●Logical Plans、Expressions、Physical Operators都可以使用Tree表示

●Tree的具体操作是通过TreeNode来实现的

?SparkSQL定义了catalyst.trees的日志,通过这个日志可以形象的表示出树的结构

?TreeNode可以使用scala的集合操作方法(如foreach, map, flatMap, collect等)进行操作

?有了TreeNode,通过Tree中各个TreeNode之间的关系,可以对Tree进行遍历操作,如使用transformDown、transformUp将Rule应用到给定的树段,然后用结果替代

旧的树段;也可以使用transformChildrenDown、transformChildrenUp对一个给

定的节点进行操作,通过迭代将Rule应用到该节点以及子节点。

●TreeNode可以细分成三种类型的Node:

?UnaryNode 一元节点,即只有一个子节点。如Limit、Filter操作

?BinaryNode 二元节点,即有左右子节点的二叉节点。如Jion、Union操作

?LeafNode 叶子节点,没有子节点的节点。主要用户命令类操作,如SetCommand

2.1.2 Rule

●Rule的相关代码定义在

sql/catalyst/src/main/scala/org/apache/spark/sql/catalyst/rules

●Rule在SparkSQL的Analyzer、Optimizer、SparkPlan等各个组件中都有应用到

●Rule是一个抽象类,具体的Rule实现是通过RuleExecutor完成

●Rule通过定义batch和batchs,可以简便的、模块化地对Tree进行transform操作

●Rule通过定义Once和FixedPoint,可以对Tree进行一次操作或多次操作(如对某些Tree

进行多次迭代操作的时候,达到FixedPoint次数迭代或达到前后两次的树结构没变化才停止操作,具体参看RuleExecutor.apply)

2.2sqlContext和hiveContext的运行过程

SparkSQL有两个分支,sqlContext和hiveContext,sqlContext现在只支持SQL语法解析器(SQL-92语法);hiveContext现在支持SQL语法解析器和hivesql语法解析器,默认为hiveSQL语法解析器,用户可以通过配置切换成SQL语法解析器,来运行hiveSQL不支持的语法,

2.2.1 sqlContext的运行过程

sqlContext总的一个过程如下图所示:

1.SQL语句经过SqlParse解析成UnresolvedLogicalPlan;

2.使用analyzer结合数据数据字典(catalog)进行绑定,生成resolvedLogicalPlan;

3.使用optimizer对resolvedLogicalPlan进行优化,生成optimizedLogicalPlan;

4.使用SparkPlan将LogicalPlan转换成PhysicalPlan;

5.使用prepareForExecution()将PhysicalPlan转换成可执行物理计划;

6.使用execute()执行可执行物理计划;

7.生成SchemaRDD。

在整个运行过程中涉及到多个SparkSQL的组件,如SqlParse、analyzer、optimizer、SparkPlan 等等

2.2.2hiveContext的运行过程

hiveContext总的一个过程如下图所示:

1.SQL语句经过HiveQl.parseSql解析成Unresolved LogicalPlan,在这个解析过程中对hiveql

语句使用getAst()获取AST树,然后再进行解析;

2.使用analyzer结合数据hive源数据Metastore(新的catalog)进行绑定,生成resolved

LogicalPlan;

3.使用optimizer对resolved LogicalPlan进行优化,生成optimized LogicalPlan,优化前使

用了ExtractPythonUdfs(catalog.PreInsertionCasts(catalog.CreateTables(analyzed)))进行预处理;

4.使用hivePlanner将LogicalPlan转换成PhysicalPlan;

5.使用prepareForExecution()将PhysicalPlan转换成可执行物理计划;

6.使用execute()执行可执行物理计划;

7.执行后,使用map(_.copy)将结果导入SchemaRDD。

2.3catalyst优化器

SparkSQL1.1总体上由四个模块组成:core、catalyst、hive、hive-Thriftserver:

●core处理数据的输入输出,从不同的数据源获取数据(RDD、Parquet、json等),将查询

结果输出成schemaRDD;

●catalyst处理查询语句的整个处理过程,包括解析、绑定、优化、物理计划等,说其是优化

器,还不如说是查询引擎;

●hive对hive数据的处理

●hive-ThriftServer提供CLI和JDBC/ODBC接口

在这四个模块中,catalyst处于最核心的部分,其性能优劣将影响整体的性能。由于发展时间尚短,还有很多不足的地方,但其插件式的设计,为未来的发展留下了很大的空间。下面是catalyst 的一个设计图:

其中虚线部分是以后版本要实现的功能,实线部分是已经实现的功能。从上图看,catalyst主要的实现组件有:

●sqlParse,完成sql语句的语法解析功能,目前只提供了一个简单的sql解析器;

●Analyzer,主要完成绑定工作,将不同来源的Unresolved LogicalPlan和数据元数据(如hive

metastore、Schema catalog)进行绑定,生成resolved LogicalPlan;

●optimizer对resolved LogicalPlan进行优化,生成optimized LogicalPlan;

●Planner将LogicalPlan转换成PhysicalPlan;

●CostModel,主要根据过去的性能统计数据,选择最佳的物理执行计划

这些组件的基本实现方法:

●先将sql语句通过解析生成Tree,然后在不同阶段使用不同的Rule应用到Tree上,通过转

换完成各个组件的功能。

●Analyzer使用Analysis Rules,配合数据元数据(如hive metastore、Schema catalog),

完善Unresolved LogicalPlan的属性而转换成resolved LogicalPlan;

●optimizer使用Optimization Rules,对resolved LogicalPlan进行合并、列裁剪、过滤器

下推等优化作业而转换成optimized LogicalPlan;

●Planner使用Planning Strategies,对optimized LogicalPlan

3、SparkSQL CLI

CLI(Command-Line Interface,命令行界面)是指可在用户提示符下键入可执行指令的界面,它通常不支持鼠标,用户通过键盘输入指令,计算机接收到指令后予以执行。Spark CLI 指的是使用命令界面直接输入SQL命令,然后发送到Spark集群进行执行,在界面中显示运行过程和最终的结果。

Spark1.1相较于Spark1.0最大的差别就在于Spark1.1增加了Spark SQL CLI和ThriftServer,使得Hive用户还有用惯了命令行的RDBMS数据库管理员较容易地上手,真正意义上进入了SQL时代。

【注】Spark CLI和Spark Thrift Server实验环境为第二课《Spark编译与部署(下)--Spark 编译安装》所搭建

3.1运行环境说明

3.1.1 硬软件环境

●主机操作系统:Windows 64位,双核4线程,主频2.2G,10G内存

●虚拟软件:VMware? Worksta tion 9.0.0 build-812388

●虚拟机操作系统:CentOS 64位,单核

●虚拟机运行环境:

?JDK:1.7.0_55 64位

?Hadoop:2.2.0(需要编译为64位)

?Scala:2.11.4

?Spark:1.1.0(需要编译)

?Hive:0.13.1

3.2配置并启动

3.2.1 创建并配置hive-site.xml

在运行Spark SQL CLI中需要使用到Hive Metastore,故需要在Spark中添加其uris。具体方法是在SPARK_HOME/conf目录下创建hive-site.xml文件,然后在该配置文件中,添加hive.metastore.uris属性,具体如下:

3.2.2 启动Hive

在使用Spark SQL CLI之前需要启动Hive Metastore(如果数据存放在HDFS文件系统,还需要启动Hadoop的HDFS),使用如下命令可以使Hive Metastore启动后运行在后台,可以通过jobs查询:

$nohup hive --service metastore > metastore.log 2>&1 &

3.2.3 启动Spark集群和Spark SQL CLI

通过如下命令启动Spark集群和Spark SQL CLI:

$cd /app/hadoop/spark-1.1.0

$sbin/start-all.sh

$bin/spark-sql --master spark://hadoop1:7077 --executor-memory 1g

在集群监控页面可以看到启动了SparkSQL应用程序:

这时就可以使用HQL语句对Hive数据进行查询,另外可以使用COMMAND,如使用set进行设置参数:默认情况下,SparkSQL Shuffle的时候是200个partition,可以使用如下命令修改该参数:

SET spark.sql.shuffle.partitions=20;

运行同一个查询语句,参数改变后,Task(partition)的数量就由200变成了20。

3.2.4 命令参数

通过bin/spark-sql --help可以查看CLI命令参数:

其中[options] 是CLI启动一个SparkSQL应用程序的参数,如果不设置--master的话,将在启动spark-sql的机器以local方式运行,只能通过http://机器名:4040进行监控;这部分参数,可以参照Spark1.0.0 应用程序部署工具spark-submit 的参数。

[cli option]是CLI的参数,通过这些参数CLI可以直接运行SQL文件、进入命令行运行SQL 命令等等,类似以前的Shark的用法。需要注意的是CLI不是使用JDBC连接,所以不能连接到ThriftServer;但可以配置conf/hive-site.xml连接到Hive的Metastore,然后对Hive数据进行查询。

3.3实战Spark SQL CLI

3.3.1 获取订单每年的销售单数、销售总额

第一步设置任务个数,在这里修改为20个

spark-sql>SET spark.sql.shuffle.partitions=20;

第二步运行SQL语句

spark-sql>use hive;

spark-sql>select c.theyear,count(distinct a.ordernumber),sum(b.amount) from tbStock a join tbStockDetail b on a.ordernumber=b.ordernumber join tbDate c on

a.dateid=c.dateid group by c.theyear order by c.theyear;

第三步查看运行结果

3.3.2 计算所有订单每年的总金额

第一步执行SQL语句

spark-sql>select c.theyear,count(distinct a.ordernumber),sum(b.amount) from tbStock a join tbStockDetail b on a.ordernumber=b.ordernumber join tbDate c on

a.dateid=c.dateid group by c.theyear order by c.theyear;

美国SPARK课程初探 摘要:美国学者所提出的SPARK课程明确地提出了体育教学的全新理念。借鉴引用国外先进课程理念让它为体育教学实践服务。 关键词:美国;SPARK课程;体育教学 一、SPARK课程产生的背景 1989年6月,美国圣地亚哥州立大学的一个研究团队从当时已经比较普遍的学生肥胖问题入手,提出通过运动、玩耍和积极休息的方式进行体育教学改革,以提高小学生的健康水平,而这个研究项目的最终成果就是SPARK(Sport,Play,and Active Recreation for Kids,儿童运动、游戏和娱乐活动)课程。 二、SPARK课程的特点及优势 SPARK的教学不只是40分钟的课堂传授,更强调将每个孩子的运动兴趣和能力在时间上予以延续;SPARK的另外一个突破点便在于其大胆地开创了自主选择性教学。他的任何一项体育活动,都有多种参与水平,倡导给予学生更多自主选择的机会。 三、初识SPARK课程的几点启发

1.大胆放手鼓励,让孩子成为学习的主人 实施新课改以来,体育教师在教学中一直努力地尝试通过各种方法与手段,帮助学生进行自主学习、合作学习与探究学习,但结果并不尽如人意。SPARK课程所实施的“个人最好的一天”则给了我们一些启示:学生是学习过程的主人;学习评价是学生学习过程中一个根据教学要求自我设计的环节,学生的学习过程开始逐渐转变为学生自我控制的过程。 2.顺应孩子天性,实现游戏与运动技能的渗透 在SPARK课程下很多教学都融入了贴近生活并趣味十足的游戏练习,尊重并顺应了孩子们天性发展的客观规律,充分体现了体育教学生活化的特点。例如:在初学基础舞步时,体育教师会为学生创设一种“荒芜”的情境,组织学生围着圆圈慢走,借助“风滚草”这种植物的特性,不仅引导学生在地面模仿“风滚草”的旋转动作,同时还让学生对这种植物有了更直观的了解,使得旋转变得更加有趣。 反观国内体育教师在运用游戏教学方式时,有些体育教师“为游戏而进行游戏教学”,缺少与运动技能学习的结合,从而造成整个课堂教学内容重游戏、轻技能,看似活跃,实则空洞的现象。 3.多维分析教材,充分衍生教学资源 课堂教学不能仅仅只局限于“教材”,更要注重从本课

SPARK课程培训心得 本次培训主要包括以下内容: 一、美国SPARK课程培训师Julie的SPARK课堂实践的培训。二、美国运动教育模式研究人沃德博士的讲座。三、华师大体育与健康学院季书记的新课程的培训讲座。四、中国体卫艺司王司长的讲座。五、参观SPARK课程实验学校,观摩教师上课。六、华师大体育与健康学院金燕老师的SOFT数据收集的讲座。七、华师大体育与健康学院汪晓赞院长的SPARK课程前期经验汇总及后期工作安排的报告。 通过以上的培训让我收获颇多,具体心得如下: 一、Julie的培训,除了给我们讲解了SPARK课程的一些理念之外,更重要的是给我们一线体育教师呈现了SPARK课程如何在体育课中进行音乐的运用,例如如何用音乐控制开始与结束,用音乐作为练习的背景音乐,用音乐来调动学生们的练习兴趣。分组的随机性、公平性、超级团队的形成。在练习过程中要不断的变换练习方式,练习的难度要循序渐进,同时在过程中注重培养学生们的空间位置感、安全意识、规则意识等,同时最主要的是注重体能的发展。 二、沃德博士讲座让我深有感触,他主要讲到的:(一)运动教育的主要目标:通过教学使你变得,有能力、有学问、热衷运动。(二)运动教育可以为学生们带来:友谊、学会团队成员工作、分享成功与失败的经验、学会公平竞赛、学会洒脱的对待胜负、成为团队成员、在比赛中熟练的运用技术和战术、理解体育比赛。(三)沃德博士以球类教学为例:要求每节课不要少于30分钟,以单元教学为主,不要少于18课时,以赛季的形式呈现学习过程。赛季前主要学习技、战术,开展团队工作,学习公平竞赛的技能。赛季期间队于队之间打1-2场比赛。采用积分累积的形式,可以把很多的内容融入评比得分之中。(四)赛季选择角色:教练、管理者、队长、裁判、体能教练等。每个队还要签公平协议。沃德博士亲自运用运动教育课程模式现场执教了两节足球课,30名志愿者教师积极参与并体验了运动教育课程模式,这种新的模式又一次冲击了教师们的教育思潮。课后沃德博士针对老师们提出的问题进行了集中解惑,理论与实践相结合,让老师们更加深入的了解和认识了运动教育课程模式! 三、季书记的讲话中向我们一线教师提出了两方面的要求:(一)我们一线

《大数据技术与应用基础》教学大纲 学时:60 代码: 适用专业: 制定: 审核: 批准: 一、课程的地位、性质和任务 大数据技术的发展,已被列为国家重大发展战略。而在过去的几年里,无论是聚焦大数据发展的《促进大数据发展行动纲要》,还是《“十三五”规划》中都深刻体现了政府对大数据产业和应用发展的重视。目前国内大数据发展还处于加速期、转型期,数据与传统产业的融合还处于起步阶段,各行业对大数据分析和挖掘的应用还不理想。但随着市场竞争的加剧,各行业对大数据技术研究的热情越来越高,在未来几年,各领域的数据分析都将大规模应用。 本课程在注重大数据时代应用环境前提下,考虑大数据处理分析需求多样复杂的基本情况,从初学者角度出发,以轻量级理论、丰富的实例对比性地介绍大数据常用计算模式的各种系统和工具。考虑到当前大数据发展处于起步并逐步赶超先进的阶段,其应用领域丰富广泛,在教学过程中应注重掌握大数据分析的实践操作。本课程通过丰富简单易上手的实例,让学生能够切实体会和掌握各种类型工具的特点和应用。 二、课程教学基本要求 1. 了解大数据的发展和基本概念,理解并掌握大数据的特征及主要技术层面。 2. 掌握Scrapy环境的搭建,了解网络爬虫获取数据的过程,熟悉爬虫项目的创建。 3. 深刻了解hadoop的基础理论,理解并掌握Hadoop单机及集群环境的部署方法。 4. 掌握HDFS的基本概念和HDFS在hadoop中的作用,理解并识记HDFS的使用,了解HDFS 的JAVA API接口及数据流原理;让学生明白Map过程与Reduce过程这两个独立部分各自的原理及合作途径,知道如何独立编写满足自己需求的MapReduce程序。 5. 理解HBase中涉及的基本概念,掌握HBase的简单应用;让学生了解数据仓库的基础概念,熟悉Hive与HDFS、MapReduce直接的关心。 6. 熟悉Spark和RDD的基本概念,熟悉spark接口的使用,解决实战时的步骤及思路。

上市公司,官网:https://www.doczj.com/doc/8113632377.html, 大数据开发初学者该如何学习 导读: 第一章:初识Hadoop 第二章:更高效的WordCount 第三章:把别处的数据搞到Hadoop上 第四章:把Hadoop上的数据搞到别处去 第五章:快一点吧,我的SQL 第六章:一夫多妻制 第七章:越来越多的分析任务 第八章:我的数据要实时 第九章:我的数据要对外 第十章:牛逼高大上的机器学习 经常有初学者会问,自己想往大数据方向发展,该学哪些技术,学习路线是什么样的,觉得大数据很火,就业很好,薪资很高……首先,如果你确定了想往这个方面发展,先考虑自己的过去从业经历、专业、兴趣是什么。计算机专业——操作系统、硬件、网络、服务器?软件专业——软件开发、编程、写代码?还是数学、统计学专业——对数据和数字特别感兴趣? 其实这就是想告诉你大数据的三个发展方向,平台搭建/优化/运维/监控、大数据开发/设计/架构、数据分析/挖掘。 先扯一下大数据的4V特征: ?数据量大,TB->PB ?数据类型繁多,结构化、非结构化文本、日志、视频、图片、地理位置等;

上市公司,官网:https://www.doczj.com/doc/8113632377.html, ?商业价值高,但是这种价值需要在海量数据之上,通过数据分析与机器学习更快速的挖掘出来; ?处理时效性高,海量数据的处理需求不再局限在离线计算当中。 现如今,正式为了应对大数据的这几个特点,开源的大数据框架越来越多,越来越强,先列举一些常见的: 文件存储:Hadoop HDFS、Tachyon、KFS 离线计算:Hadoop MapReduce、Spark 流式、实时计算:Storm、Spark Streaming、S4、Heron K-V、NOSQL数据库:HBase、Redis、MongoDB 资源管理:YARN、Mesos 日志收集:Flume、Scribe、Logstash、Kibana 消息系统:Kafka、StormMQ、ZeroMQ、RabbitMQ 查询分析:Hive、Impala、Pig、Presto、Phoenix、SparkSQL、Drill、Flink、Kylin、Druid 分布式协调服务:Zookeeper 集群管理与监控:Ambari、Ganglia、Nagios、Cloudera Manager 数据挖掘、机器学习:Mahout、Spark MLLib 数据同步:Sqoop 任务调度:Oozie 1.1 学会百度与Google

用Apache Spark进行大数据处理——第一部分:入门介绍 什么是Spark Apache Spark是一个围绕速度、易用性和复杂分析构建的大数据处理框架。最初在2009年由加州大学伯克利分校的AMPLab开发,并于2010年成为Apache的开源项目之一。与Hadoop和Storm等其他大数据和MapReduce技术相比,Spark有如下优势。 首先,Spark为我们提供了一个全面、统一的框架用于管理各种有着不同性质(文本数据、图表数据等)的数据集和数据源(批量数据或实时的流数据)的大数据处理的需求。 Spark可以将Hadoop集群中的应用在内存中的运行速度提升100倍,甚至能够将应用在磁盘上的运行速度提升10倍。 Spark让开发者可以快速的用Java、Scala或Python编写程序。它本身自带了一个超过80个高阶操作符集合。而且还可以用它在shell中以交互式地查询数据。 除了Map和Reduce操作之外,它还支持SQL查询,流数据,机器学习和图表数据处理。开发者可以在一个数据管道用例中单独使用某一能力或者将这些能力结合在一起使用。 在这个Apache Spark文章系列的第一部分中,我们将了解到什么是Spark,它与典型的MapReduce解决方案的比较以及它如何为大数据处理提供了一套完整的工具。 Hadoop和Spark Hadoop这项大数据处理技术大概已有十年历史,而且被看做是首选的大数据集合处理的解决方案。MapReduce是一路计算的优秀解决方案,不过对于需要多路计算和算法的用例来说,并非十分高效。数据处理流程中的每一步都需要一个Map阶段和一个Reduce阶段,而且如果要利用这一解决方案,需要将所有用例都转换成MapReduce模式。 在下一步开始之前,上一步的作业输出数据必须要存储到分布式文件系统中。因此,复制和磁盘存储会导致这种方式速度变慢。另外Hadoop解决方案中通常会包含难以安装和管理的集群。而且为了处理不同的大数据用例,还需要集成多种不同的工具(如用于机器学习的Mahout和流数据处理的Storm)。 如果想要完成比较复杂的工作,就必须将一系列的MapReduce作业串联起来然后顺序执行这些作业。每一个作业都是高时延的,而且只有在前一个作业完成之后下一个作业才能开始启动。 而Spark则允许程序开发者使用有向无环图(DAG)开发复杂的多步数据管道。而且还支持跨有向无环图的内存数据共享,以便不同的作业可以共同处理同一个数据。

Scala从基础到开发实战 对于进化缓慢的Java跟C++语言来说,目前Scala无疑更适应现代化特质的语言,语法简洁,同时兼备函数式编程与面向对象编程,具有令人耳目一新的编程范式。而运行在Java 虚拟机上的编译环境使得其具有很多的现有工具与类库,拥有快速的可靠的解释器和编译器。 本课程是Scala语言基础课程,面向没有或仅有少量编程语言基础的同学,当然,具有一定的Java或C、C++语言基础将有助于本课程的学习。在本课程内,将更注重scala的各种语言规则和应用,通过学习本课程能具备初步的Scala语言实际编程能力。 Scala最近的红火也得益于Spark分布式内存计算平台的兴起,由于其惊人的计算速度,Spark将要革命Hadoop的说法尘嚣日上,但学习Spark的一项瓶颈是其原生语言Scala并不为大众所熟知,即使是资深程序员,从未听说过Scala者大有人在,于是本门课程也可以称为Spark系列的前置课程,供深入学习大数据技术的同仁们进行热身运动。 课程大纲: 第一课:Scala介绍——如何安装Scala REPL、SBT、IDE,编写简单的Scala程序;函数式编程简介 第二课:Scala的class和object,Scala的变量、类的介绍 第三课:Scala的基本数据类型、控制语句 第四课:高阶函数、Currying、尾递归 第五课:数据结构:List、Map、Set 第六课:组合和继承 第七课:Trait 第八课:响应式编程介绍 第九课:Akka框架(一)——akka的基本用法 第十课:Akka框架(二)——actor的监控 第十一课:Akka框架(三)——网络编程 第十二课:Akka框架(四)——akka使用技巧

实验一Scala部署及基本语法 (5) 1. 安装Scala (6) 1.1 进入安装目录 (6) 2. Scala基础 (7) 2.1 基础语法 (7) 2.2 控制结构 (11) 实验二Scala数据结构 (13) 3. Scala数据结构 (14) 3.1 列表 (14) 3.2 集合 (14) 3.3 映射(Map) (15) 3.4 迭代器 (17) 实验三Scala类和对象 (20) 4. 类 (21) 4.1 简单的类 (21) 5. 对象 (24) 5.1 单例对象 (25) 5.2 伴生对象 (25) 5.3 应用程序对象 (26) 实验四Scala函数式编程WordCount (27) 6. 实验操作 (29) 6.1 创建需要统计的目录 (29) 实验五spark安装部署 (31) 1、检查环境hadoop集群环境 (31) 2、Spark部署 (32) 1

实验六Spark RDD编程 (45) 1.RDD编程 (46) 实验七Spark单词统计实验 (47) 2、检查hadoop集群环境 (49) 2、创建项目 (50) 2.1创建java maven项目 (51) 2.2更改JDK版本 (54) 2.3配置pom.xml文件 (58) 2.4创建SparkWordCount类 (64) 4、打包项目 (70) 5、运行打包好的jar程序 (76) 5.1 运行程序 (76) 实验八Spark Hbase读写实验 (77) 1、检查hadoop集群环境 (79) 2、Hbase创建studen表 (80) 2.1 进入hbase环境 (80) 2.2 查看表是否存在 (80) 2.3 创建student表 (81) 2.4 往表里插入数据 (81) 2.5 使用scan命令查看表结构 (82) 3、创建项目 (83) 3.1创建java maven项目 (84) 3.2更改JDK版本 (87) 3.3配置pom.xml文件 (91) 1

利用Scala语言开发Spark应用程序 park内核是由Scala语言开发的,因此使用Scala语言开发Spark应用程序是自然而然的事情。如果你对Scala语言还不太熟悉,可以阅读网络教程A Scala Tutorial for Java Programmers或者相关Scala书籍进行学习。 AD: Spark内核是由Scala语言开发的,因此使用Scala语言开发Spark应用程序是自然而然的事情。如果你对Scala语言还不太熟悉,可以阅读网络教程A Scala Tutorial for Java Programmers或者相关Scala书籍进行学习。 本文将介绍3个Scala Spark编程实例,分别是WordCount、TopK和SparkJoin,分别代表了Spark 的三种典型应用。 1. WordCount编程实例 WordCount是一个最简单的分布式应用实例,主要功能是统计输入目录中所有单词出现的总次数,编写步骤如下: 步骤1:创建一个SparkContext对象,该对象有四个参数:Spark master位置、应用程序名称,Spark安装目录和jar存放位置,对于Spark On Y ARN而言,最重要的是前两个参数,第一个参数指定为yarn-standalone ,第二个参数是自定义的字符串,举例如下: valsc=newSparkContext(args(0), WordCount ,System.getenv( SPARK_HOME ),Seq(System.getenv( SPARK_TEST_JAR ))) 步骤2:读取输入数据。我们要从HDFS上读取文本数据,可以使用SparkCon valtextFile=sc.textFile(args(1)) 当然,Spark允许你采用任何Hadoop InputFormat,比如二进制输入格式SequenceFileInputFormat,此时你可以使用SparkContext中的hadoopRDD函数,举例如下: valinputFormatClass=classOf[SequenceFileInputFormat[Text,Text]]varhadoopRdd=sc.hadoopRDD(c onf,inputFormatClass,classOf[Text],classOf[Text]) 或者直接创建一个HadoopRDD对象: varhadoopRdd=newHadoopRDD(sc,conf,classOf[SequenceFileInputFormat[Text,Text,classOf[Text],c lassOf[Text]) 步骤3:通过RDD转换算子操作和转换RDD,对于WordCount而言,首先需要从输入数据中每行字符串中解析出单词,水草玛瑙 https://www.doczj.com/doc/8113632377.html,然后将相同单词放到一个桶中,最后统计每个桶中每个单词出现的频率,举例如下: valresult=hadoopRdd.flatMap{case(key,value)= value.toString().split( \\s+ }.map(word= (word,1)).reduceByKey(_+_) 其中,flatMap函数可以将一条记录转换成多条记录(一对多关系),map函数将一条记录转换为另一条记录(一对一关系),高山茶 https://www.doczj.com/doc/8113632377.html, reduceByKey函数将key相同的数据划分到一个桶中,并以key为单位分组进行计算,这些函数的具体含义可参考:Spark Transformation。步骤4:将产生的RDD数据集保存到HDFS上。可以使用SparkContext中的saveAsTextFile哈数将数据集保存到HDFS目录下,默认采用Hadoop提供的TextOutputFormat,每条记录以(key,value)的形式打印输出,你也可以采用saveAsSequenceFile函数将数据保存为SequenceFile格式等,举例如下: result.saveAsSequenceFile(args(2)) 当然,一般我们写Spark程序时,需要包含以下两个头文件: importorg.apache.spark._importSparkContext._ WordCount完整程序已在Apache Spark学习:利用Eclipse构建Spark集成开发环境一文中进行了介绍,在次不赘述。 需要注意的是,指定输入输出文件时,需要指定hdfs的URI,比如输入目录是hdfs:hadoop-testtmpinput,输出目录是hdfs:hadoop-testtmpoutput,其中,hdfs:hadoop-test 是由Hadoop配置文件core- site.xml中参数https://www.doczj.com/doc/8113632377.html,指定的,具体替换成你的配置即可。 2. TopK编程实例

spark入门教程及经验总结 问题导读1.cluster mode 模式运行包含哪些流程? 2.yarn mode 运行模式有什么特点? 3..在关闭http file server进程时,遇到什么错误?一、环境准备测试环境使用的cdh提供的quickstart vmhadoop版本:2.5.0-cdh5.2.0spark版本:1.1.0 二、Hello Spark将 /usr/lib/spark/examples/lib/spark-examples-1.1.0-cdh5.2.0-hado op2.5.0-cdh5.2.0.jar 移动到 /usr/lib/spark/lib/spark-examples-1.1.0-cdh5.2.0-hadoop2.5.0-cd h5.2.0.jar 执行程序./bin/run-example SparkPi 10 日志分析:程序检查ip,host,SecurityManager 启动sparkDriver。通过akka工具启动一个tcp监听[akka.tcp://sparkDriver@192.168.128.131:42960]

启动MapOutputTracker,BlockManagerMaster 启动一个block manager,也就是 ConnectionManagerId(192.168.128.131,41898),其中包含一个MemoryStore 通过netty启动一个HTTP file server: SocketConnector@0.0.0.0:55161 启动一个sparkUI:http://192.168.128.131:4040通过http上传本地程序运行Jar包 连接HeartbeatReceiver: akka.tcp://sparkDriver@192.168.128.131:42960/user/Heartbeat Receiver Starting job: reduce分析中job,有stage 0 (MappedRDD[1]) 添加并启动运行task Submitting 10 missing tasks from Stage 0通过http协议获取程序jar包,并添加到classloader完成task 后,将结果发送到driverscheduler.DAGScheduler完成Stage

51cto学院-Scala深入浅出实战初级入门经典视频课程 课程目标 为进一步推动大数据技术的发展和应用,在王家林的带领下联合大数据狂热爱好者和一线实践专家构建了“DT大数据梦工厂”公益团队,旨在免 费分享大数据最佳实践技术,帮助您和公司在大数据时代重铸强大IT大 脑,笑傲互联网+时代!在这里,先从Scala语言的编程开发实战学起。。。适用人群 Scala语言爱好者,Spark技术爱好者,大数据技术学习者 课程简介 《Scala深入浅出实战初级入门经典视频课程》 从Scala的开发环境的搭建起步,基于纯粹动手实战的原则,循序渐进的覆盖Scal a基础、Scala面向对象编程、Scala函数式编程、集合的操作深度实战、Scala测 试等实用实战内容,是《Scala深入浅出实战中级---进阶经典》和《Scala深入浅 出实战高级---高手之巅》的前置课程。纯粹的实战精华课程打造能够进行Scala编程实战的您! 从零开始,跟随着王家林老师每天早晨4点左右发布的一个绝对精华的约15分钟的大数据免费视频学习大数据方面的技术,先从Scala语言的编程开发实战学起。。。 Scala是一门以JVM为目标运行环境并将面向对象和函数式编程语言的最佳特性结合在一起的编程语言,此课程是大数据框架Spark的前置课程: 1、Spark框架是采用Scala语言编写的,精致而优雅。要想成为Spark高手,你 就必须阅读Spark的源代码,就必须掌握Scala;

2、虽然说现在的Spark可以采用多语言Java、Python等进行应用程序开发,但 是最快速的和支持最好的开发API依然并将永远是Scala方式的API,所以你必须掌握Scala来编写复杂的和高性能的Spark分布式程序; 3、本课程采用循序渐进的实战方式,深入浅出的讲解Scala所有核心内容和高级实 战技巧 课程 1 第1讲:Scala开发环境搭建和HelloWorld解析 24分钟 本视频介绍了Scala语言的特性,Java的安装,详细介绍了Scala的下载、Scala的环境变量配置,ScalaIDE工具的安装。在Scala的环境安装完成后又动手演示了一个在ScalaIDE中建立Sc ala工程的例子,并演示运行结果。 2 第2讲:Scala函数定义、流程控制、异常处理入门实战 24分钟 本视频以具体的例子代码详细介绍了1)Scala中函数的定义格式,以main函数为例介绍了ma in函数中的参数意义和返回值,同时还介绍了无参数函数的调用方式和有参数函数的调用方式。 2)介绍了Scala中流程控制do-while循环、for循环的使用方式。3)Scala中的异常处理try-catch-finally的使用流程。 3 第3讲:Tuple、Array、Map与文件操作入门实战 15分钟 本视频以具体的例子代码详细介绍了1)Scala中的元组的定义、元组的元素访问方式。2)Scal a中数组的定义、数组的遍历方式。3)Scala中Map集合的定义和访问方式。4)Scala中网络文件和本地文件的访问方式。 4

Spark入门实战系列--6.SparkSQL(上)--SparkSQL简介 【注】该系列文章以及使用到安装包/测试数据可以在《倾情大奉送--Spark入门实战系列》获取 1、SparkSQL的发展历程 1.1Hive and Shark SparkSQL的前身是Shark,给熟悉RDBMS但又不理解MapReduce的技术人员提供快速上手的工具,Hive应运而生,它是当时唯一运行在Hadoop上的SQL-on-Hadoop工具。但是MapReduce计算过程中大量的中间磁盘落地过程消耗了大量的I/O,降低的运行效率,为了提高SQL-on-Hadoop的效率,大量的SQL-on-Hadoop工具开始产生,其中表现较为突出的是: ●MapR的Drill ●Cloudera的Impala ●Shark 其中Shark是伯克利实验室Spark生态环境的组件之一,它修改了下图所示的右下角的内存管理、物理计划、执行三个模块,并使之能运行在Spark引擎上,从而使得SQL查询的速度得到10-100倍的提升。 1.2Shark和SparkSQL

但是,随着Spark的发展,对于野心勃勃的Spark团队来说,Shark对于Hive的太多依赖(如采用Hive的语法解析器、查询优化器等等),制约了Spark的One Stack Rule Them All 的既定方针,制约了Spark各个组件的相互集成,所以提出了SparkSQL项目。SparkSQL抛弃原有Shark的代码,汲取了Shark的一些优点,如内存列存储(In-Memory Columnar Storage)、Hive兼容性等,重新开发了SparkSQL代码;由于摆脱了对Hive的依赖性,SparkSQL 无论在数据兼容、性能优化、组件扩展方面都得到了极大的方便,真可谓“退一步,海阔天空”。 ●数据兼容方面不但兼容Hive,还可以从RDD、parquet文件、JSON文件中获取数据, 未来版本甚至支持获取RDBMS数据以及cassandra等NOSQL数据; ●性能优化方面除了采取In-Memory Columnar Storage、byte-code generation等优 化技术外、将会引进Cost Model对查询进行动态评估、获取最佳物理计划等等; ●组件扩展方面无论是SQL的语法解析器、分析器还是优化器都可以重新定义,进行扩展。 2014年6月1日Shark项目和SparkSQL项目的主持人Reynold Xin宣布:停止对Shark 的开发,团队将所有资源放SparkSQL项目上,至此,Shark的发展画上了句话,但也因此发展出两个直线:SparkSQL和Hive on Spark。

IT=挨踢,这是IT人的自嘲,进入IT行业是有四五年了,也算得上是一个“老人”了吧,见了不少新人,面试了不少新人,也带了一些新人,多多少少还是有点发言权的。 新人们常常会说我看了多少多少的书,看过某某人写的书,仿佛书看了就会做了。其实不然,很多新人在面试的时候夸夸其谈,说啥啥都知道一点,到真正做的时候,啥都不会。归根到底是没有经验,技术这玩意儿经验非常重要,很多东西如果不是你碰到了,你从书上一辈子都找不到答案。 一般都是先把整个书翻一下,了解一下书的基本内容,然后在实际项目中遇到相应的问题再去翻书,当然这是因为我对技术已经有一定的了解,不需要通读整本书。初学者应该找一些适合自己的书,通读一遍,其中的例子要认真做,一定要自己去写代码,而不是Copy。我以前在学做网页的时候,别人都用Dreamweaver去做,只有我打开源代码编辑器学习HTML源代码的编写。 做完书的例子只能说明你会削木头了,但会削木头离会做柜子还有很远的路要走。还记得达·芬奇画鸡蛋的故事么?不停地重复肯定是枯燥的,所以你需要自己尝试去做一些实际的东西,比如做一个个人主页、一个留言本、一个通信地址本......在这些实际的东西中去实现你的创意,去实现你在书本上所学习的例子,并且将这些例子加入你的思想。 永远不要认为书本能给你带来多少东西,虽然它们很有用,但它们只是一个Key,一个引你入门的Key。 四川是旅游的天堂,无法拒绝她火辣辣的美食,无法拒绝她惊艳的自然风光,更无法拒绝她的古蜀文化。随着社会物质文明和精神文明的不断提高,越来越多的人在社会的残酷竞争中优胜劣汰!在追求男女平等的同时,男生和女生却面临同样的竞争,这就是社会生存潜

LabSpark1000光谱仪操作规程 一.实验室环境要求: 实验室内温度:恒定在20~25℃之间某一温度。 实验室内湿度:≤70%。 仪器工作场所应防止震动,如周边有较大震动,宜采取减震措施。 实验室保持清洁,尽可能不与酸碱等腐蚀性物质在一起。 防止电磁干扰,环境存在强电磁场时,实验室宜采取屏蔽措施。 供电:220V,50Hz单相;有单独地线;在工厂自发电时慎用仪器,局域电压的大幅波动有可能对仪器造成损坏。 二.仪器使用要求: 氩气:纯度99.999%。氧气减压器控制压力,二级表头分压力0.2~0.5 MPa,当一级表头总压力到1MPa时,需要更换一瓶新的氩气。 仪器温度:仪器采用内部恒温系统,通常设定35℃,每台仪器可能不同,实际温度要求在30~37℃之间某温度恒定。 仪器真空度:小于20Pa(150 mT),最好在13Pa(100 mT)以内,并恒定于某一值。分析有色金属仪器,真空值可高于该值。 有间歇式真空的,真空泵自动在设定范围内启动、停止。一般设定范围 1.0Pa~10.0Pa。 仪器长时间关机想要启用时,环境相对湿度≥70%时,要提前4小时开启空调,待室内温度、湿度满足要求后开启仪器,仪器通电后只进行“加热”进行自恒温,启动真空泵抽真空。其他操作待12小时后再进行。如室内湿度过大,仪器电器部分易短路损坏。 强雷雨天气慎用,以免雷击造成电路板烧毁。 仪器除非长时间不用,建议不要关机。经常开关机会对仪器的稳定性及寿命造成影响。仪器分析使用时功率在2000W左右,待机功率500W左右。 仪器所用电脑为专用设备,建议不作他用。上网、插带病毒存储设备会使电脑感染病毒,导致程序不能运行。 三.开关机步骤 开机: 1.打开氩气总阀,调节出气压力在合适位置。 2.按下交流接触器绿色按钮。 3.打开稳压电源。 4.按下接线插座上按钮,灯亮为打开。 5.启动光谱仪主。按仪器右下方绿色“启动”开关,如有真空泵控制开关,同时按下。 6.打开电脑及显示器。 7.进入主分析操作界面。双击桌面上或进入分析

SPARK课程培训心得 SPARK课程培训心得 本次培训主要包括以下内容: 一、美国SPARK课程培训师Julie的SPARK课堂实践的培训。二、美国运动教育模式研究人沃德博士的讲座。三、华师大体育与健康学院季书记的新课程的培训讲座。四、中国体卫艺司王司长的讲座。五、参观SPARK 课程实验学校,观摩教师上课。六、华师大体育与健康学院金燕老师的SOFT 数据收集的讲座。七、华师大体育与健康学院汪晓赞院长的SPARK课程前期经验汇总及后期工作安排的报告。 通过以上的培训让我收获颇多,具体心得如下: 一、Julie的培训,除了给我们讲解了SPARK课程的一些理念之外,更重要的是给我们一线体育教师呈现了SPARK课程如何在体育课中进行音乐的运用,例如如何用音乐控制开始与结束,用音乐作为练习的背景音乐,用音乐来调动学生们的练习兴趣。分组的随机性、公平性、超级团队的形成。在练习过程中要不断的变换练习方式,练习的难度要循序渐进,同时在过程中注重培养学生们的空间位置感、安全意识、规则意识等,同时最主要的是注重体能的发展。

二、沃德博士讲座让我深有感触,他主要讲到的:(一)运动教育的主要目标:通过教学使你变得,有能力、有学问、热衷运动。(二)运动教育可以为学生们带来:友谊、学会团队成员工作、分享成功与失败的经验、学会公平竞赛、学会洒脱的对待胜负、成为团队成员、在比赛中熟练的运用技术和战术、理解体育比赛。(三)沃德博士以球类教学为例:要求每节课不要少于30分钟,以单元教学为主,不要少于18课时,以赛季的形式呈现学习过程。赛季前主要学习技、战术,开展团队工作,学习公平竞赛的技能。赛季期间队于队之间打1-2场比赛。采用积分累积的形式,可以把很多的内容融入评比得分之中。(四)赛季选择角色:教练、管理者、队长、裁判、体能教练等。每个队还要签公平协议。沃德博士亲自运用运动教育课程模式现场执教了两节足球课,30名志愿者教师积极参与并体验了运动教育课程模式,这种新的模式又一次冲击了教师们的教育思潮。课后沃德博士针对老师们提出的问题进行了集中解惑,理论与实践相结合,让老师们更加深入的了解和认识了运动教育课程模式! 三、季书记的讲话中向我们一线教师提出了两方面的要求:(一)我们一线教师要做一名有科研意识的教师,不要总是让别人牵着走。在教学方面要有自己的特点,教学中要研究开发适合自己学校的校本课程,并制定相应的教学计划。(二)体育课教学首先要关注学生们体能的发展,要让学生们出汗。其次在技术教学的同时要与战术相结合,达到学以致用。更重要的是发挥体育教育的育人功能,培养学生们的综合能力及综合素质。

Spark入门(Python版) 本文由伯乐在线- douxingxiang 翻译,toolate 校稿。未经许可,禁止转载! 英文出处:Benjamin Bengfort。欢迎加入翻译组。Hadoop是对大数据集进行分布式计算的标准工具,这也是为什么当你穿过机场时能看到”大数据(Big Data)”广告的原因。它已经成为大数据的操作系统,提供了包括工具和技巧在内的丰富生态系统,允许使用相对便宜的商业硬件集群进行超级计算机级别的计算。2003和2004年,两个来自Google的观点使Hadoop成为可能:一个分布式存储框架(Google文件系统),在Hadoop中被实现为HDFS;一个分布式计算框架(MapReduce)。 这两个观点成为过去十年规模分析(scaling analytics)、大规模机器学习(machine learning),以及其他大数据应用出现的主要推动力!但是,从技术角度上讲,十年是一段非常长的时间,而且Hadoop还存在很多已知限制,尤其是MapReduce。对MapReduce编程明显是困难的。对大多数分析,你都必须用很多步骤将Map和Reduce任务串接起来。这造成类SQL 的计算或机器学习需要专门的系统来进行。更糟的是,MapReduce要求每个步骤间的数据要序列化到磁盘,这意味着MapReduce作业的I/O成本很高,导致交互分析和迭代算

法(iterative algorithms)开销很大;而事实是,几乎所有的最优化和机器学习都是迭代的。 为了解决这些问题,Hadoop一直在向一种更为通用的资源管理框架转变,即YARN(Yet Another Resource Negotiator, 又一个资源协调者)。YARN实现了下一代的MapReduce,但同时也允许应用利用分布式资源而不必采用MapReduce进 行计算。通过将集群管理一般化,研究转到分布式计算的一般化上,来扩展了MapReduce的初衷。 Spark是第一个脱胎于该转变的快速、通用分布式计算范式,并且很快流行起来。Spark使用函数式编程范式扩展了MapReduce模型以支持更多计算类型,可以涵盖广泛的工作流,这些工作流之前被实现为Hadoop之上的特殊系统。Spark 使用内存缓存来提升性能,因此进行交互式分析也足够快速(就如同使用Python解释器,与集群进行交互一样)。缓存同时提升了迭代算法的性能,这使得Spark非常适合数据理论任务,特别是机器学习。 本文中,我们将首先讨论如何在本地机器上或者EC2的集群上设置Spark进行简单分析。然后,我们在入门级水平探索Spark,了解Spark是什么以及它如何工作(希望可以激发更多探索)。最后两节我们开始通过命令行与Spark进行交互,然后演示如何用Python写Spark应用,并作为Spark作业提交到集群上。

Spark 实战,第1 部分: 使用Scala 语言开发Spark 应用程序 本文旨在通过具有实际意义的案例向读者介绍如何使用Scala 语言开发Spark 应用程序并在Spark 集群上运行。本文涉及的所有源数据都将从HDFS(Hadoop Distributed File System)读取,部分案例的输出结果也会写入到HDFS, 所以通过阅读本文,读者也会学习到Spark 和HDFS 交互的一些知识。 查看本系列更多内容|3评论: 王龙, 软件开发工程师, IBM 内容

关于Spark Spark 由加州大学伯克利分校AMP 实验室(Algorithms, Machines, and People Lab) 开发,可用来构建大型的、低延迟的大数据处理的应用程序。并且提供了用于机器学习(MLlib), 流计算(Streaming), 图计算(GraphX) 等子模块,最新的1.4.0 版本更是提供了与R 语言的集成,这使得Spark 几乎成为了多领域通吃的全能技术。Spark 对数据的存储,转换,以及计算都是基于一个叫RDD(Resilient Distributed Dataset) 分布式内存的抽象,应用程序对需要计算的数据的操作都是通过对RDD 的一系列转化(Transformation) 和动作(Action) 算子完成的,其中转化算子可以把一个RDD 转成另一个RDD,如filter 算子可以通过添加过滤条件生成一个只包含符合条件的数据的新的RDD。动作算子负责完成最终的计算,如count 算子可以计算出整个RDD 表示的数据集中元素的个数。关于Spark 所支持的算子以及使用方法请参考Spark 官方网站。本文所使用的Spark 的发行版是1.3.1,读者可根据需要下载相应的版本。 回页首关于Scala Scala 语言是一门类Java 的多范式语言,其设计初衷就是为了继承函数式编程的面向对象编程的各种特性,正如Scala 语言官网描述的那样:Object-Oriented Meets Functional, 就是给出了一个关于Scala 语言特性的最简单明了的概括。 Spark 框架使用Scala 语言开发,那么使用Scala 语言开发Spark 应用程序就变成一件很自然的事情,虽然Spark 提供了面向Python,Java 等语言的编程接口,但是从各个方面来看使用Scala 编程都是最简单最容易理解的,特别是当程序出现异常或者是需要通过学习源码来定位问题时,您会发现学习Scala 语言来编写Spark 应用程序是多么有意义的事情。关于Scala 语言,如果您还没有基础,请参考 ?Scala 语言官网 ?Scala 中文网 ?Twitter 提供的Scala 课堂 ?面向Java 开发人员的Scala 指南系列 由于Spark 1.3.1 版本使用的是Scala 2.10.x 版本,所以本文将使用Scala 2.10.5 版本。 回页首搭建开发环境 1. 安装Scala IDE

豆瓣整个基础架构可以粗略的分为在线和离线两大块。在线的部分和大部分网站类似:前面用,用Nginx做反向代理,形成负载均衡的一层;应用层主要是做运算,将运算结果返回给前面的DAE平台是这两年建起来的,现在大部分豆瓣的应用基本都跑在DAE上面了;应用后面的基

以DPark能够大幅提升性能。另外,因为DPark的编写使用了函数式语言的特点,所以可以写的非常简洁: 到目前(2014年3月),DPark的集群规模和处理数据量已经比去年多了一倍左右,一天要处 理60~100T B左右的数据。 团队 当前,我所负责的豆瓣平台部一共包括四个部分:核心系统,这块也是由我直接带领的,共6名工程师;DAE,现在是彭宇负责,共4名工程师;DBA两人;SA两人。 平台部负责的项目大多是跟业务无关的东西,贴近应用层的主要在产品线团队做,这个分工跟豆瓣工程团队的发展历史有关。早期豆瓣工程师还不多的时候,就已经分为两种倾向,一种是偏业务的,就是去做用户能看得见的东西;另一种是支持性的,运行在业务层下面、不被用户所感知的东西。下面这一层就衍变成了平台部门。 在豆瓣,不管是做产品还是做平台的工程师,技术实力都比较强,一个项目应该从哪个部门发起,并不是看这个任务的难度,而是看它是公共的还是业务特有的。有些项目即使未来可能会成为公共的,但一开始只是一个产品线需要,那么它也会从产品线发起。比如豆瓣的短信服务,最开始是产品线有需求,所以这些服务都是由他们发起完成的,平台这边主要负责提供建设服务的架构,比如DoubanService,告诉他们一个服务怎样去写、怎样去部署、怎样去对用户开放。短信服务后来成为很多产品线都在使用的服务,同时这个系统本身也越来越成熟,那么它逐渐就被转移到SA团队来进行维护。

第一章Graphx 参考:https://www.doczj.com/doc/8113632377.html,/art/201408/450049.htm Spark+GraphX大规模图计算和图挖掘(V3.0) 本章旨在介绍图计算、Spark GraphX和梳理GraphX学习时的关键知识结构。 1.1 分布式计算 1.1.1 分布式图计算框架的目的 将对于巨型图的各种操作包装为简单的接口,让分布式存储、并行计算等复杂问题对上层透明,从而使复杂网络和图算法的工程师,更加聚焦在图相关的模型设计和使用上,而不用关心底层的分布式细节。 需要解决两个通用问题:图存储模式和图计算模式。 1.1.2 图存储模式 巨型图的存储总体上有边分割和点分割两种存储方式。2013年,GraphLab2.0将其存储方式由边分割变为点分割,在性能上取得重大提升,目前基本上被业界广泛接受并使用。 1.1. 2.1边分割 每个顶点都存储一次,但有的边会被打断分到两台机器上。这样做的好处是节省存储空间;坏处是对图进行基于边的计算时,对于一条两个顶点被分到不同机器上的边来说,要跨机器通信传输数据,内网通信流量大。 1.1. 2.2点分割 每条边只存储一次,都只会出现在一台机器上。邻居多的点会被复制到多台机器上,增加了存储开销,同时会引发数据同步问题。好处是可以大幅减少内网通信量。 现在是点分割占上风,各种分布式图计算框架都将自己底层的存储形式变成了点分割。主要原因有以下两个。 磁盘价格下降,存储空间不再是问题,而内网的通信资源没有突破性进展,集群计算时内网带宽是宝贵的,时间比磁盘更珍贵。这点就类似于常见的空间换时间的策略。 在当前的应用场景中,绝大多数网络都是“无尺度网络”,遵循幂律分布,不同点的邻居数量相差非常悬殊。而边分割会使那些多邻居的点所相连的边大多数被分到不同的机器上,这样的数据分布会使得内网带宽更加捉襟见肘,于是边分割存储方式被渐渐抛弃了。 1.1.3 图计算模型