数据挖掘结课报告

学院:专业:学号:姓名:

摘要:数据挖掘(Data Mining)是利用一种或多种计算机学习技术,从数据中自动分析并提取信息的处理过程。数据挖掘的目的是寻找和发掘数据中潜在的有价值的信息、知识、规律、联系和模式。它是当前热门的、具有广阔商业应用前景的一个研究领域。本文笔者结合专业所学,简单介绍了数据挖掘在本专业应用。并做了数据挖掘试验工作,分析了相应结果。

关键词:数据挖掘;地球物理;分类预测;聚类分析;关联规则

§1 介绍

国内外的数据挖掘技术的应用研究,均只是从数据驱动的角度实施挖掘过程,而忽略了领域专家的所具有的专业背景知识,缺乏人机交互机制。因此,根据各种地球物理勘探数据的特征,从勘探领域模型驱动的角度出发,引入数据挖掘技术,确定其挖掘思路,建立各种挖掘方法之间的联系,利用其数学模型和数学分析方法从海量的数中获得最大增益信息来指导勘探,不仅是数据的需要,更重要的是为地球物理勘探提供了一种高效率、高精度、低成本、高回报的新方法[1]。在国内,部分学者将数据挖掘这门新方法在地球物理应用领域进行了积极探索[1-3]。李雄炎等[1](2009)在石油天然气勘探领域进行了数据挖掘应用探索。朱传华等[3](2010)应用数据挖掘技术,从滑坡灾害历史数据中挖掘出有利于滑坡灾害预测预报的有效信息,为预警指挥系统服务。可以说,数据挖掘在地球物理方面的应用前景较好,但需要国内外学者进一步探索,发挥交叉学科作用,使数据挖掘可以服务于地球物理领域。本文仅利用老师提供的非地球物理资料样本,操作weka进行一些简单实验,熟悉数据挖掘方法。

§2实验

2.1 分类预测

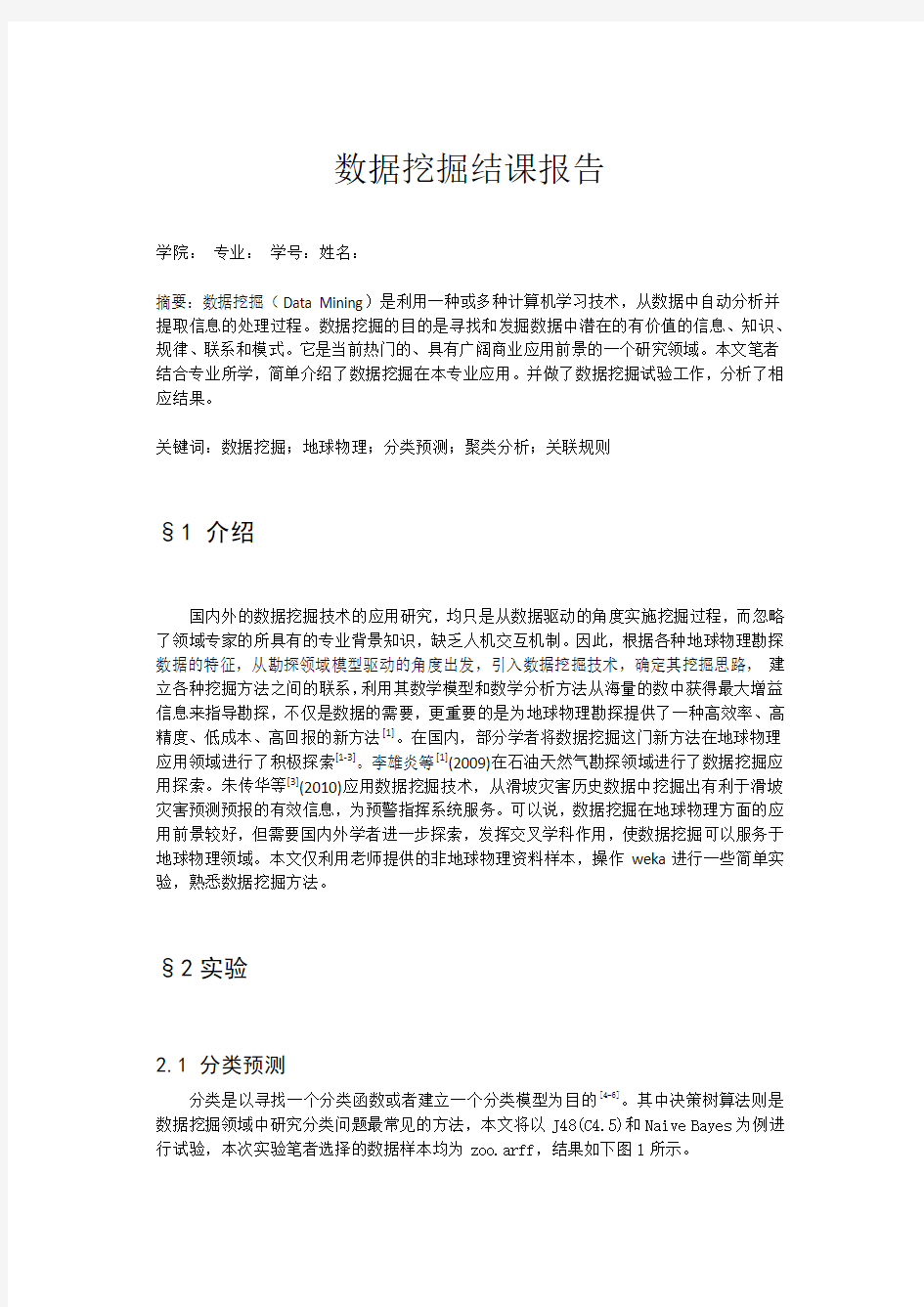

分类是以寻找一个分类函数或者建立一个分类模型为目的[4-6]。其中决策树算法则是数据挖掘领域中研究分类问题最常见的方法,本文将以J48(C4.5)和Naive Bayes为例进行试验,本次实验笔者选择的数据样本均为zoo.arff,结果如下图1所示。

图1.决策树法和朴素贝叶斯法分类结果比较

2.2聚类分析

聚类是按照一组个体的相似性程度把它们聚成一些分离类别,使得类内部对象之间的相似度较大,而类与类之间对象的相似度较小,它的目的是尽量使得同类个体之间的距离达到最小,反之,不同类个体之间的距离则尽可能大,从而使同一类中的个体具有极高的相似性[4-5]。下面将以十大经典算法中的K均值算法为例进行试验,依据前面分类的情况,选择“SimpleKMeans”,我修改“numClusters”为 7,说明希望把这101条动物实例聚成7类,即 K=7。下面的“seed”参数是要设置一个随机种子,依此产生一个随机数,用来得到 K 均值算法中第一次给出的 K 个簇中心的位置。我们不妨暂时让它就为10、50、100作对比实验,“Within cluster sum of squared errors:”即总聚类平方差的值,其值越小说明给的初值越好。我选中“Cluster Mode”的是“Classes to clusters evaluation”进行试验,结果如下:

①seed为10时,总聚类平方差的值为255.0,Correctly Clustered Instances:31.68%;

②seed为50时,总聚类平方差的值为245.0,Correctly Clustered Instances:7.92%;

③seed为100时,总聚类平方差的值为249.0,Correctly Clustered Instances:17.82%。

可以从上述结果中得知,在这三种“seed”下,值为 50 为最佳聚类效果最好,误差小于 8%,明显优于另外两个。我在下面做实验还用了“seed”为 90、150、200 等数值做了试验,发现精度先增加然后会再下降,限于篇幅此处不做陈述。我们可以看出选的“seed”对分类结果影响较大。

2.3 关联规则

关系数据库中存在着一种重要的关系:数据关联,这种关系其实是一种容易被人们发现的知识,可以进行相关学习。关联分析的目的是发掘海量数据中存在的数据之间的相关性。从大量的记录中发现有趣的关联关系,可以有效地帮助我们制定决策,例如交叉并行购物、分类器的设计等关联又可分为简单关联、时序关联和因果关联[4-6]。关联规则分析是使用 Apriori 算法进行试验。本次试验要求只计算出可信度不低于0.9的关联规则,并取可信度排在前五位的关联规则如下:

Best rules found:

1. backbone=true 83 ==> venomous=false 79 conf:(0.95)

2. breathes=true 80 ==> fins=false 76 conf:(0.95)

3. domestic=false 88 ==> venomous=false 81 conf:(0.92)

4. fins=false 84 ==> venomous=false 77 conf:(0.92)

5. fins=false 84 ==> breathes=true 76 conf:(0.9)

§3 结论

本次实验很好地熟悉操作了weka中一些简单的应用:分类、聚类、关联规则分析。通过阅读大量文献,我还了解了数据挖掘在本专业的应用,这是以前未曾意识到的。所以,可以毫不夸张的说,刘老师给我开了这方面的一扇窗,以后如果有机会我会进行交叉学科相关研究,将数据挖掘的数据处理方法同所学专业联系起来,更好地为地球物理勘探工作服务。

参考文献

[1]李雄炎,李洪奇. 数据挖掘技术在石油天然气勘探领域的应用探索[J]. 地球物理学进展,2009,05:1807-1813.

[2]彭丰林,陈会忠,沈萍等. 地球物理中大数据的历史渊源与时代发展[A]. 中国地球物理学会信息技术专业委员会.地球物理信息监测与计算技术应用研讨活动论文摘要[C].中国地球物理学会信息技术专业委员会:,2015:2.

[3]朱传华. 三峡库区地质灾害数据仓库与数据挖掘应用研究[D].中国地质大学,2010.

[4]吴烨. 基于Weka平台的决策树算法研究与实现[D].西安电子科技大学,2014.

[5]戴红,常子冠,于宁.数据挖掘导论[M].北京:清华大学出版社,2014.

[6]Ian H.Witten,Eibe Frank.数据挖掘实用机器学习技术(原书第2版)[M].董琳,等译.北京:机械工业出版社,2012.

数据挖掘考试题目——聚类 一、填空题 1、密度的基于中心的方法使得我们可以将点分类为:__________、________ 、_________。 2、DBSCAN算法在最坏的情况下,时间复杂度是__________、空间复杂度是__________。 3、DBSCAN算法的优点是_______、__________________________。 4、DBSCAN算法的缺点是处理_________________、_____________的数据效果不好。 5、DBSCAN算法的参数有:___________、____________。 6、簇的有效性的非监督度量常常可以分为两类:__________、__________,它常采用的指标为__________。 7、簇的有效性的监督度量通常称为___________,它度量簇标号与外部提供的标号的匹配程度主要借助____________。 8、在相似度矩阵评价的聚类中,如果有明显分离的簇,则相似度矩阵应当粗略地是__________。 9、DBSCAN算法的参数确定的基本方法是观察____________________的特性。 10、不引用附加的信息,评估聚类分析结果对数据拟合情况属于__________技术。 答案: 1、核心点边界点噪声点 2、O(n2) O(n) 3、耐噪声能够处理任意大小和形状的簇 4、高维数据变密度的 5、EPS MinPts 6、簇的凝聚性簇的分离性均方差(SSE) 7、外部指标监督指标的熵 8、块对角的 9、点到它的第K个最近邻的距离(K-距离) 10、非监督 二、选择题 1、DBSCAN算法的过程是(B)。 ①删除噪声点。 ②每组连通的核心点形成一个簇。 ③将所有点标记为核心点、边界点和噪声点。 ④将每个边界点指派到一个与之关联的核心点的簇中。 ⑤为距离在Eps之内的所有核心点之间赋予一条边。 A:①②④⑤③ B:③①⑤②④ C:③①②④⑤ D:①④⑤②③ 2、如果有m个点,DBSCAN在最坏的情况下的时间复杂度度为(C)。 A O(m) B O(mlogm) C O(m2) D O(logm) 3、在基本DBSCAN的参数选择方法中,点到它的K个最近邻的距离中的K选作为哪一个参数(B)。 A Eps B MinPts C 质心 D 边界

数据挖掘聚类问题(Plants Data Set)实验报告 1.数据源描述 1.1数据特征 本实验用到的是关于植物信息的数据集,其中包含了每一种植物(种类和科属)以及它们生长的地区。数据集中总共有68个地区,主要分布在美国和加拿大。一条数据(对应于文件中的一行)包含一种植物(或者某一科属)及其在上述68个地区中的分布情况。可以这样理解,该数据集中每一条数据包含两部分内容,如下图所示。 图1 数据格式 例如一条数据:abronia fragrans,az,co,ks,mt,ne,nm,nd,ok,sd,tx,ut,wa,wy。其中abronia fragrans是植物名称(abronia是科属,fragrans是名称),从az一直到wy 是该植物的分布区域,采用缩写形式表示,如az代表的是美国Arizona州。植物名称和分布地区用逗号隔开,各地区之间也用逗号隔开。 1.2任务要求 聚类。采用聚类算法根据某种特征对所给数据集进行聚类分析,对于聚类形成的簇要使得簇内数据对象之间的差异尽可能小,簇之间的差距尽可能大。 2.数据预处理 2.1数据清理 所给数据集中包含一些对聚类过程无用的冗余数据。数据集中全部数据的组织结构是:先给出某一科属的植物及其所有分布地区,然后给出该科属下的具体植物及其分布地区。例如: ①abelmoschus,ct,dc,fl,hi,il,ky,la,md,mi,ms,nc,sc,va,pr,vi ②abelmoschus esculentus,ct,dc,fl,il,ky,la,md,mi,ms,nc,sc,va,pr,vi ③abelmoschus moschatus,hi,pr 上述数据中第①行给出了所有属于abelmoschus这一科属的植物的分布地区,接下来的②③两行分别列出了属于abelmoschus科属的两种具体植物及其分布地区。从中可以看出后两行给出的所有地区的并集正是第一行给出的地区集

计算机工程应用技术本栏目责任编辑:贾薇薇 数据挖掘中的聚类分析方法 黄利文 (泉州师范学院理工学院,福建泉州362000) 摘要:聚类分析是多元统计分析的重要方法之一,该方法在许多领域都有广泛的应用。本文首先对聚类的分类做简要的介绍,然后给出了常用的聚类分析方法的基本思想和优缺点,并对常用的聚类方法作比较分析,以便人们根据实际的问题选择合适的聚类方法。 关键词:聚类分析;数据挖掘 中图分类号:TP311文献标识码:A文章编号:1009-3044(2008)12-20564-02 ClusterAnlaysisMethodsofDataMining HUANGLi-wen (SchoolofScience,QuanzhouNormalUniversity,Quanzhou362000,China) Abstract:Clusteranalysisisoneoftheimportantmethodsofmultivariatestatisticalanalysis,andthismethodhasawiderangeofapplica-tionsinmanyfields.Inthispaper,theclassificationoftheclusterisintroducedbriefly,andthengivessomecommonmethodsofclusteranalysisandtheadvantagesanddisadvantagesofthesemethods,andtheseclusteringmethodwerecomparedandanslyzedsothatpeoplecanchosesuitableclusteringmethodsaccordingtotheactualissues. Keywords:ClusterAnalysis;DataMining 1引言 聚类分析是数据挖掘中的重要方法之一,它把一个没有类别标记的样本集按某种准则划分成若干个子类,使相似的样品尽可能归为一类,而不相似的样品尽量划分到不同的类中。目前,该方法已经被广泛地应用于生物、气候学、经济学和遥感等许多领域,其目的在于区别不同事物并认识事物间的相似性。因此,聚类分析的研究具有重要的意义。 本文主要介绍常用的一些聚类方法,并从聚类的可伸缩性、类的形状识别、抗“噪声”能力、处理高维能力和算法效率五个方面对其进行比较分析,以便人们根据实际的问题选择合适的聚类方法。 2聚类的分类 聚类分析给人们提供了丰富多彩的分类方法,这些方法大致可归纳为以下几种[1,2,3,4]:划分方法、层次方法、基于密度的聚类方法、基于网格的聚类方法和基于模型的聚类方法。 2.1划分法(partitiongingmethods) 给定一个含有n个对象(或元组)的数据库,采用一个划分方法构建数据的k个划分,每个划分表示一个聚簇,且k≤n。在聚类的过程中,需预先给定划分的数目k,并初始化k个划分,然后采用迭代的方法进行改进划分,使得在同一类中的对象之间尽可能地相似,而不同类的中的对象之间尽可能地相异。这种聚类方法适用于中小数据集,对大规模的数据集进行聚类时需要作进一步的改进。 2.2层次法(hietarchicalmethods) 层次法对给定数据对象集合按层次进行分解,分解的结果形成一颗以数据子集为节点的聚类树,它表明类与类之间的相互关系。根据层次分解是自低向上还是自顶向下,可分为凝聚聚类法和分解聚类法:凝聚聚类法的主要思想是将每个对象作为一个单独的一个类,然后相继地合并相近的对象和类,直到所有的类合并为一个,或者符合预先给定的终止条件;分裂聚类法的主要思想是将所有的对象置于一个簇中,在迭代的每一步中,一个簇被分裂为更小的簇,直到最终每个对象在单独的一个簇中,或者符合预先给定的终止条件。在层次聚类法中,当数据对象集很大,且划分的类别数较少时,其速度较快,但是,该方法常常有这样的缺点:一个步骤(合并或分裂)完成,它就不能被取消,也就是说,开始错分的对象,以后无法再改变,从而使错分的对象不断增加,影响聚类的精度,此外,其抗“噪声”的能力也较弱,但是若把层次聚类和其他的聚类技术集成,形成多阶段聚类,聚类的效果有很大的提高。2.3基于密度的方法(density-basedmethods) 该方法的主要思想是只要临近区域的密度(对象或数据点的数目)超过某个阈值,就继续聚类。也就是说,对于给定的每个数据点,在一个给定范围的区域中必须至少包含某个数目的点。这样的方法就可以用来滤处"噪声"孤立点数据,发现任意形状的簇。2.4基于网格的方法(grid-basedmethods) 这种方法是把对象空间量化为有限数目的单元,形成一个网格结构。所有的聚类操作都在这个网格结构上进行。用这种方法进行聚类处理速度很快,其处理时间独立于数据对象的数目,只与量化空间中每一维的单元数目有关。 2.5基于模型的方法(model-basedmethod) 基于模型的方法为每个簇假定一个模型,寻找数据对给定模型的最佳拟合。该方法经常基于这样的假设:数据是根据潜在的概 收稿日期:2008-02-17 作者简介:黄利文(1979-),男,助教。

一、解答题(满分30分,每小题5分) 1. 怎样理解数据挖掘和知识发现的关系?请详细阐述之 首先从数据源中抽取感兴趣的数据,并把它组织成适合挖掘的数据组织形式;然后,调用相应的算法生成所需的知识;最后对生成的知识模式进行评估,并把有价值的知识集成到企业的智能系统中。 知识发现是一个指出数据中有效、崭新、潜在的、有价值的、一个不可忽视的流程,其最终目标是掌握数据的模式。流程步骤:先理解要应用的领域、熟悉相关知识,接着建立目标数据集,并专注所选择的数据子集;再作数据预处理,剔除错误或不一致的数据;然后进行数据简化与转换工作;再通过数据挖掘的技术程序成为模式、做回归分析或找出分类模型;最后经过解释和评价成为有用的信息。 2.时间序列数据挖掘的方法有哪些,请详细阐述之 时间序列数据挖掘的方法有: 1)、确定性时间序列预测方法:对于平稳变化特征的时间序列来说,假设未来行为与现在的行为有关,利用属性现在的值预测将来的值是可行的。例如,要预测下周某种商品的销售额,可以用最近一段时间的实际销售量来建立预测模型。 2)、随机时间序列预测方法:通过建立随机模型,对随机时间序列进行分析,可以预测未来值。若时间序列是平稳的,可以用自回归(Auto Regressive,简称AR)模型、移动回归模型(Moving Average,简称MA)或自回归移动平均(Auto Regressive Moving Average,简称ARMA)模型进行分析预测。 3)、其他方法:可用于时间序列预测的方法很多,其中比较成功的是神经网络。由于大量的时间序列是非平稳的,因此特征参数和数据分布随着时间的推移而变化。假如通过对某段历史数据的训练,通过数学统计模型估计神经网络的各层权重参数初值,就可能建立神经网络预测模型,用于时间序列的预测。

关联规则数据挖掘 学习报告

目录 引言 2 案例 2 关联规则 3 (一)关联规则定义 (二)相关概念 (三)关联规则分类 数据 6 (一)小型数据 (二)大型数据 应用软件7 (一)WEKA (二)IBM SPSS Modeler 数据挖掘12 总结27

一、引言 数据库与互联网技术在日益发展壮大,人们每天可以获得的信息量呈指数级增长。如何从这浩如瀚海的数据中找出我们需要的数据显得尤为重要。数据挖掘又为资料探勘、数据采矿。它是数据库知识发现中的一个步骤。数据挖掘一般是指从大量的数据中通过算法搜索隐藏于其中信息的过程。数据挖掘通常与计算机科学有关,并通过统计、在线分析处理、情报检索、机器学习、专家系统(依靠过去的经验法则)和模式识别等诸多方法来实现上述目标。 数据挖掘大致分为以下几类:分类(Classification)、估计(Estimation)、预测(Prediction)、相关性分组或关联规则(Affinity grouping or association rules)、聚类(Clustering)、复杂数据类型挖掘(Text, Web ,图形图像,视频,音频等)。 二、案例 "尿布与啤酒"的故事。 在一家超市里,有一个有趣的现象:尿布和啤酒赫然摆在一起出售。但是这个奇怪的举措却使尿布和啤酒的销量双双增加了。这不是一个笑话,而是发生在美国沃尔玛连锁店超市的真实案例,并一直为商家所津津乐道。沃尔玛拥有世界上最大的数据仓库系统,为了能够准确了解顾客在其门店的购买习惯,沃尔玛对其顾客的购物行为进行购物篮分析,想知道顾客经常一起购买的商品有哪些。沃尔玛数据仓库里集中了其各门店的详细原始交易数据。在这些原始交易数据的基础上,沃尔玛利用数据挖掘方法对这些数据进行分析和挖掘。一个意外的发现是:"跟尿布一起购买最多的商品竟是啤酒!经过大量实际调查和分析,揭示了一个隐藏在"尿布与啤酒"背后的美国人的一种行为模式:在美国,一些年轻的父亲下班后经常要到超市去买婴儿尿布,而他们中有30%~40%的人同时也为自己买一些啤酒。产生这一现象的原因是:美国的太太们常叮嘱她们的丈夫下班后为小孩买尿布,而丈夫们在买尿布后又随手带回了他们喜欢的啤酒。 按常规思维,尿布与啤酒风马牛不相及,若不是借助数据挖掘技术对大量交易数据进行挖掘分析,沃尔玛是不可能发现数据内在这一有价值的规律的。

数据挖掘考试题目——关联分析 一、10个选择 1.以下属于关联分析的是() A.CPU性能预测B.购物篮分析 C.自动判断鸢尾花类别D.股票趋势建模 2.维克托?迈尔-舍恩伯格在《大数据时代:生活、工作与思维的大变革》一书中,持续强调了一个观点:大数据时代的到来,使我们无法人为地去发现数据中的奥妙,与此同时,我们更应该注重数据中的相关关系,而不是因果关系。其中,数据之间的相关关系可以通过以下哪个算法直接挖掘() A.K-means B.Bayes Network C.C4.5 D.Apriori 3.置信度(confidence)是衡量兴趣度度量()的指标。 A.简洁性B.确定性 C.实用性D.新颖性 4.Apriori算法的加速过程依赖于以下哪个策略() A.抽样B.剪枝 C.缓冲D.并行 5.以下哪个会降低Apriori算法的挖掘效率() A.支持度阈值增大B.项数减少 C.事务数减少D.减小硬盘读写速率 6.Apriori算法使用到以下哪些东东() A.格结构、有向无环图B.二叉树、哈希树 C.格结构、哈希树D.多叉树、有向无环图 7.非频繁模式() A.其置信度小于阈值B.令人不感兴趣 C.包含负模式和负相关模式D.对异常数据项敏感 8.对频繁项集、频繁闭项集、极大频繁项集的关系描述正确的是()[注:分别以1、2、3代表之] A.3可以还原出无损的1 B.2可以还原出无损的1 C.3与2是完全等价的D.2与1是完全等价的 9.Hash tree在Apriori算法中所起的作用是() A.存储数据B.查找 C.加速查找D.剪枝 10.以下不属于数据挖掘软件的是() A.SPSS Modeler B.Weka C.Apache Spark D.Knime 二、10个填空 1.关联分析中表示关联关系的方法主要有:和。 2.关联规则的评价度量主要有:和。 3.关联规则挖掘的算法主要有:和。 4.购物篮分析中,数据是以的形式呈现。 5.一个项集满足最小支持度,我们称之为。 6.一个关联规则同时满足最小支持度和最小置信度,我们称之为。

数据挖掘实验报告(二)关联规则挖掘 姓名:李圣杰 班级:计算机1304 学号:1311610602

一、实验目的 1. 1.掌握关联规则挖掘的Apriori算法; 2.将Apriori算法用具体的编程语言实现。 二、实验设备 PC一台,dev-c++5.11 三、实验内容 根据下列的Apriori算法进行编程:

四、实验步骤 1.编制程序。 2.调试程序。可采用下面的数据库D作为原始数据调试程序,得到的候选1项集、2项集、3项集分别为C1、C2、C3,得到的频繁1项集、2项集、3项集分别为L1、L2、L3。

代码 #include 聚类分析和关联规则属于数据挖掘这个大概念中的两类挖掘问题, 聚类分析是无监督的发现数据间的聚簇效应。 关联规则是从统计上发现数据间的潜在联系。 细分就是 聚类分析与关联规则是数据挖掘中的核心技术; 从统计学的观点看,聚类分析是通过数据建模简化数据的一种方法。传统的统计聚类分析方法包括系统聚类法、分解法、加入法、动态聚类法、有序样品聚类、有重叠聚类和模糊聚类等。采用k-均值、k-中心点等算法的聚类分析工具已被加入到许多著名的统计分析软件包中,如SPSS、SAS等。 从机器学习的角度讲,簇相当于隐藏模式。聚类是搜索簇的无监督学习过程。与分类不同,无监督学习不依赖预先定义的类或带类标记的训练实例,需要由聚类学习算法自动确定标记,而分类学习的实例或数据对象有类别标记。聚类是观察式学习,而不是示例式的学习。 聚类分析是一种探索性的分析,在分类的过程中,人们不必事先给出一个分类的标准,聚类分析能够从样本数据出发,自动进行分类。聚类分析所使用方法的不同,常常会得到不同的结论。不同研究者对于同一组数据进行聚类分析,所得到的聚类数未必一致。 从实际应用的角度看,聚类分析是数据挖掘的主要任务之一。而且聚类能够作为一个独立的工具获得数据的分布状况,观察每一簇数据的特征,集中对特定的聚簇集合作进一步地分析。聚类分析还可以作为其他算法(如分类和定性归纳算法)的预处理步骤。 关联规则挖掘过程主要包含两个阶段:第一阶段必须先从资料集合中找出所有的高频项目组(FrequentItemsets),第二阶段再由这些高频项目组中产生关联规则(AssociationRules)。 关联规则挖掘的第一阶段必须从原始资料集合中,找出所有高频项目组(LargeItemsets)。高频的意思是指某一项目组出现的频率相对于所有记录而言,必须达到某一水平。 关联规则挖掘的第二阶段是要产生关联规则(AssociationRules)。从高频项目组产生关联规则,是利用前一步骤的高频k-项目组来产生规则,在最小信赖度(MinimumConfidence)的条件门槛下,若一规则所求得的信赖度满足最小信赖度,称此规则为关联规则。 关联规则分析报告 2009年7月8日 目录 一前言 (1) 二数据预处理 (1) 三前7710条真实数据分析 (2) 1商品按小类分析 (2) 2商品按中类分析 (4) 3商品按大类分析 (4) 4分析比较 (5) 四后44904条随机数据分析 (5) 1商品按小类分析 (5) 2商品按中类分析 (7) 3商品按大类分析 (8) 4分析比较 (8) 五52614条混合数据分析 (8) 1商品按小类分析 (8) 2商品按中类分析 (11) 3商品按大类分析 (11) 4分析比较 (12) 六总结 (12) 一前言 使用关联规则挖掘算法分析购物清单时,会产生不止“啤酒→尿布”的单一关联规则,而将出现涉及多种商品的“纵横交错”的多条关联规则。针对这一实际问题,本文利用学生日常购物记录数据进行关联分析,通过概念分层从不同粒度上分析商品之间的关联性,从而找到商品之间的关联规则,实现优化超市货物摆放次序的目的。 二数据预处理 1)在SQL server 2000 查询分析器里执行下面的SQL语句 declare @sql varchar(8000) set @sql = 'select zid ,xh' select @sql = @sql + ' , max(case goodsid when ''' + goodsid + ''' then goodsid end) [' + 'n'+ goodsid + ']' from (select distinct goodsid from rcxfjl) as a set @sql = @sql + ' into table_a from rcxfjl group by zid,xh' exec(@sql) 2)在PB里将有购买记录的列改为”yes” for i=1 to dw_1.rowcount() for li_index=1 to long(dw_1.object.datawindow.column.count) if integer(dw_1.getitemstring(i,dw_1.describe('#' + string(li_index) + ".name")))>0 then dw_1.setitem(i,dw_1.describe('#' + string(li_index) + ".name"),"yes") end if next next 3)将处理好的数据直接导出到Excel中 4)将Excel表中的空格替换成”?”(在weka中?表示缺省值) 实验三 一、实验原理 K-Means算法是一种 cluster analysis 的算法,其主要是来计算数据聚集的算法,主要通过不断地取离种子点最近均值的算法。 在数据挖掘中,K-Means算法是一种cluster analysis的算法,其主要是来计算数据聚集的算法,主要通过不断地取离种子点最近均值的算法。 算法原理: (1) 随机选取k个中心点; (2) 在第j次迭代中,对于每个样本点,选取最近的中心点,归为该类; (3) 更新中心点为每类的均值; (4) j<-j+1 ,重复(2)(3)迭代更新,直至误差小到某个值或者到达一定的迭代步 数,误差不变. 空间复杂度o(N) 时间复杂度o(I*K*N) 其中N为样本点个数,K为中心点个数,I为迭代次数 二、实验目的: 1、利用R实现数据标准化。 2、利用R实现K-Meams聚类过程。 3、了解K-Means聚类算法在客户价值分析实例中的应用。 三、实验内容 依据航空公司客户价值分析的LRFMC模型提取客户信息的LRFMC指标。对其进行标准差标准化并保存后,采用k-means算法完成客户的聚类,分析每类的客户特征,从而获得每类客户的价值。编写R程序,完成客户的k-means聚类,获得聚类中心与类标号,并统计每个类别的客户数 四、实验步骤 1、依据航空公司客户价值分析的LRFMC模型提取客户信息的LRFMC指标。 2、确定要探索分析的变量 3、利用R实现数据标准化。 4、采用k-means算法完成客户的聚类,分析每类的客户特征,从而获得每类客户的价值。 五、实验结果 客户的k-means聚类,获得聚类中心与类标号,并统计每个类别的客户数 六、思考与分析 使用不同的预处理对数据进行变化,在使用k-means算法进行聚类,对比聚类的结果。 kmenas算法首先选择K个初始质心,其中K是用户指定的参数,即所期望的簇的个数。 这样做的前提是我们已经知道数据集中包含多少个簇. 1.与层次聚类结合 经常会产生较好的聚类结果的一个有趣策略是,首先采用层次凝聚算法决定结果 数据挖掘实验报告(三) 聚类分析 姓名:李圣杰 班级:计算机1304 学号:1311610602 一、实验目的 1、掌握k-means 聚类方法; 2、通过自行编程,对三维空间内的点用k-means 方法聚类。 二、实验设备 PC 一台,dev-c++5.11 三、实验内容 1.问题描述: 立体空间三维点的聚类. 说明:数据放在数据文件中(不得放在程序中),第一行是数据的个数,以后各行是各个点的x,y,z 坐标。 2.设计要求 读取文本文件数据,并用K-means 方法输出聚类中心 3. 需求分析 k-means 算法接受输入量k ;然后将n 个数据对象划分为 k 个聚类以便使得所获得的聚类满足:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算的。 k-means 算法的工作过程说明如下:首先从n 个数据对象任意选择k 个对象作为初始聚类中心,而对于所剩下的其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类。然后,再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值),不断重复这一过程直到标准测度函数开始收敛为止。一般都采用均方差作为标准测度函数,具体定义如下: 2 1∑∑=∈-=k i i i E C p m p (1) 其中E 为数据库中所有对象的均方差之和,p 为代表对象的空间中的一个点,m i 为聚类C i 的均值(p 和m i 均是多维的)。公式(1)所示的聚类标准,旨在使所获得的k 个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。 四、实验步骤 Step 1.读取数据组,从N 个数据对象任意选择k 个对象作为初始聚类中心; Step 2.循环Step 3到Step 4直到每个聚类不再发生变化为止; Step 3.根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离,并根据最小距离重新对相应对象进行划分; Step 4.重新计算每个(有变化)聚类的均值(中心对象)。 代码 #include 第八章聚类分析 设想要求对一个数据对象的集合进行分析,但与分类不同的是,它要划分的类是未知的。聚类(clustering)就是将数据对象分组成为多个类或簇(cluster),在同一个簇中的对象之间具有较高的相似度,而不同簇中的对象差别较大。相异度是基于描述对象的属性值来计算的。距离是经常采用的度量方式。聚类分析源于许多研究领域,包括数据挖掘,统计学,生物学,以及机器学习。 在本章中,大家将了解基于大数据量上进行操作而对聚类方法提出的要求,将学习如何计算由各种属性和不同的类型来表示的对象之间的相异度。还将学习几种聚类技术,它们可以分为如下几类:划分方法(partitioning method),层次方法(hierarchical method),基于密度的方法(density-based method),基于网格的方法(grid-based method),和基于模型的方法(model-based method)。本章最后讨论如何利用聚类方法进行孤立点分析(outlier detection)。 8.1 什么是聚类分析? 将物理或抽象对象的集合分组成为由类似的对象组成的多个类的过程被称为聚类。由聚类所生成的簇是一组数据对象的集合,这些对象与同一个簇中的对象彼此相似,与其他簇中的对象相异。在许多应用中,一个簇中的数据对象可以被作为一个整体来对待。 聚类分析是一种重要的人类行为。早在孩提时代,一个人就通过不断地改进下意识中的聚类模式来学会如何区分猫和狗,或者动物和植物。聚类分析已经广泛地用在许多应用中,包括模式识别,数据分析,图像处理,以及市场研究。通过聚类,一个人能识别密集的和稀疏的区域,因而发现全局的分布模式,以及数据属性之间的有趣的相互关系。 “聚类的典型应用是什么?”在商业上,聚类能帮助市场分析人员从客户基本库中发现不同的客户群,并且用购买模式来刻画不同的客户群的特征。在生物学上,聚类能用于推导植物和动物的分类,对基因进行分类,获得对种群中固有结构的认识。聚类在地球观测数据库中相似地区的确定,汽车保险持有者的分组,及根据房子的类型,价值,和地理位置对一个城市中房屋的分组上也可以发挥作用。聚类也能用于对Web上的文档进行分类,以发现信息。作为一个数据挖掘的功能,聚类分析能作为一个独立的工具来获得数据分布的情况,观察每个簇的特点,集中对特定的某些簇作进一步的分析。此外,聚类分析可以作为其他算法(如分类等)的预处理步骤,这些算法再在生成的簇上进行处理。 数据聚类正在蓬勃发展,有贡献的研究领域包括数据挖掘,统计学,机器学习,空间数据库技术,生物学,以及市场营销。由于数据库中收集了大量的数据,聚类分析已经成为数据挖掘研究领域中一个非常活跃的研究课题。 作为统计学的一个分支,聚类分析已经被广泛地研究了许多年,主要集中在基于距离的聚类分析。基于k-means(k-平均值),k-medoids(k-中心)和其他一些方法的聚类分析工具已经被加入到许多统计分析软件包或系统中,例如S-Plus,SPSS,以及SAS。在机器学习领域,聚类是无指导学习(unsupervised learning)的一个例子。与分类不同,聚类和无指导学习不依赖预先定义的类和训练样本。由于这个原因,聚类是通过观察学习,而不是通过例子学习。在概念聚类(conceptual clustering)中,一组对象只有当它们可以被一个概念描述时才形成一个簇。这不同于基于几何距离来度量相似度的传统聚类。概念聚类由两个部分组成:(1)发现合适的簇;(2)形成对每个簇的描述。在这里,追求较高类内相似度和较低类间相似度的指导原则仍然适用。 数据挖掘论文聚类分析论文 摘要:结合数据挖掘技术的分析,对基于数据挖掘的道路交通流分布模式问题进行了探讨,最后进行了实验并得出结果。 关键词:数据挖掘;聚类分析;交通流 road traffic flow distribution mode research based on data mining chen yuan (hunan vocational and technical college,changsha410004,china) abstract:combinded with the analysis of data mining technology,the distirbution model of traffic flow is discussed,and an experiment is carried out and its related conclusions are made in this paper. keywords:data mining;clustering analysis;traffic flow 道路网络上不同空间上的交通流具有相异的空间分布 模式,如“线”性模式主要代表有城市主干道,“面”状模式主要出现在繁华地段等。本文设计了一个道路交通流空间聚类算法以挖掘道路交通流分布模式,在真实数据和模拟数据上的实验表明spanbre算法具有良好的性能。 数据挖掘(datamining),也称数据库的知识发现(knowledgediseoveryindatabase)是指从随机、模糊的受到一定影响的大容量实际应用数据样本中,获取其中隐含的事前未被人们所知具有潜在价值的信息和知识的过程。 数据挖掘非独立概念,它涉及很多学科领域和方法,如有人工智能、数据统计、可视化并行计算等。数据挖掘的分类有很多,以挖掘任务为区别点,可以划分为模型发现、聚类、关联规则发现、序列分析、偏差分析、数据可视化等类型。 一、基于数据挖掘的道路交通流分布模式问题分析 类似化整为零各个击破的思想,交通区域划分通常会将整个交通网络分为若干个相互联系的子区域,再通过协调子区域各监测点交通信号配时方案,对个区域内运行的交通流在整体上进行管理与控制,从而达到优化整个道路网络的交通流。但是人为划定子区域的方案在实时改变因缺少自学习与自组织功能而导致整体方案出现滞后性。所以要加强路网通行能力,必须寻找突破人为划分、有效获取道路网络上交通流的空间分布模式的方法,以实现根据交通流的空间分布特点,合理划分路网交通区域,缓解交通拥挤的现状的目标。 在智能交通系统中应用最广泛的交通流信息采集方法 是电磁感应技术支撑的环形感应线圈检测器。这种流行甚广 数据挖掘考试题 公司内部编号:(GOOD-TMMT-MMUT-UUPTY-UUYY-DTTI- 数据挖掘考试题 一.选择题 1. 当不知道数据所带标签时,可以使用哪种技术促使带同类标签的数据与带其他标签的数据相分离( ) A.分类 B.聚类 C.关联分析 D.主成分分析 2. ( )将两个簇的邻近度定义为不同簇的所有点对邻近度的平均值,它是一种凝聚层次聚类技术。 A.MIN(单链) B.MAX(全链) C.组平均 D.Ward方法 3.数据挖掘的经典案例“啤酒与尿布试验”最主要是应用了( )数据挖掘方法。 A 分类 B 预测 C关联规则分析 D聚类 4.关于K均值和DBSCAN的比较,以下说法不正确的是( ) A.K均值丢弃被它识别为噪声的对象,而DBSCAN一般聚类所有对象。 B.K均值使用簇的基于原型的概念,DBSCAN使用基于密度的概念。 C.K均值很难处理非球形的簇和不同大小的簇,DBSCAN可以处理不同大小和不同形状的簇 D.K均值可以发现不是明显分离的簇,即便簇有重叠也可以发现,但是DBSCAN 会合并有重叠的簇 5.下列关于Ward’s Method说法错误的是:( ) A.对噪声点和离群点敏感度比较小 B.擅长处理球状的簇 C.对于Ward方法,两个簇的邻近度定义为两个簇合并时导致的平方误差 D.当两个点之间的邻近度取它们之间距离的平方时,Ward方法与组平均非常相似 6.下列关于层次聚类存在的问题说法正确的是:( ) A.具有全局优化目标函数 B.Group Average擅长处理球状的簇 C.可以处理不同大小簇的能力 D.Max对噪声点和离群点很敏感 7.下列关于凝聚层次聚类的说法中,说法错误的事:( ) A.一旦两个簇合并,该操作就不能撤销 B.算法的终止条件是仅剩下一个簇 C.空间复杂度为()2m O D.具有全局优化目标函数 8.规则{牛奶,尿布}→{啤酒}的支持度和置信度分别为:( ) 9.下列( )是属于分裂层次聚类的方法。 A.Min B.Max C.Group Average D.MST 10.对下图数据进行凝聚聚类操作,簇间相似度使用MAX计算,第二步是哪两个簇合并:( ) A.在{3}和{l,2}合并 B.{3}和{4,5}合并 C.{2,3}和{4,5}合并 简略介绍如下聚类方法:划分方法、层次方法。每种给出两个例子。 (1)划分方法:给定一个有N个对象的集合,划分方法构造数据的K个分区,每一个分区表示一个簇,且K≤N。而且这K个分组满足下列条件:第一,每一个分组至少包含一条记录;第二,每一条记录属于且仅属于一个分组(注意:这个要求在某些模糊聚类算法中可以放宽);对于给定的K,算法首先给出一个初始的分组方法,以后通过反复迭代的方法改变分组,使得每一次改进之后的分组方案都较前一次好,而所谓好的标准就是:同一分组中的记录越近越好,而不同分组中的记录越远越好。 使用这个基本思想的算法有:K-MEANS 算法、K-MEDOIDS 算法、CLARANS 算法。 (2)层次方法:这种方法对给定的数据集进行层次似的分解,直到某种条件满足为止。具体又可分为“自底向上”和“自顶向下”两种方案。例如在“自底向上”方案中,初始时每一个数据记录都组成一个单独的组,在接下来的迭代中,它把那些相互邻近的组合并成一个组,直到所有的记录组成一个分组或者某个条件满足为止。 代表算法有:BIRCH 算法、CURE 算法、CHAMELEON 算法等。 假设数据挖掘的任务是将如下的8个点(用(x, y)代表位置)聚类为3个簇。 A1(2,10), A2(2,5), A3(8,4), B1(5,8), B2(7,5), B3(6,4), C1(1,2), C2(4,9) 距离函数是欧氏距离。假设初始我们选择A1、B1和C1分别为每个簇的中心,用k-均值算法给出: (a)在第一轮执行后的3个簇中心。 (b)最后的3个簇。 (a)第一轮后, 三个新的簇为(1){A1} (2){B1,A3,B2,B3,C2} (3){C1,A2} 簇中心分别为(1) (2, 10), (2) (6, 6), (3) , . (b)最后3个簇为(1) {A1,C2,B1}, (2) {A3,B2,B3}, (3) {C1,A2}. 毕业设计(论文)外文文献翻译 文献、资料中文题目:聚类分析 文献、资料英文题目:clustering 文献、资料来源: 文献、资料发表(出版)日期: 院(部): 专业:自动化 班级: 姓名: 学号: 指导教师: 翻译日期: 2017.02.14 外文翻译 英文名称:Data mining-clustering 译文名称:数据挖掘—聚类分析 专业:自动化 姓名:**** 班级学号:**** 指导教师:****** 译文出处:Data mining:Ian H.Witten, Eibe Frank 著 Clustering 5.1 INTRODUCTION Clustering is similar to classification in that data are grouped. However, unlike classification, the groups are not predefined. Instead, the grouping is accomplished by finding similarities between data according to characteristics found in the actual data. The groups are called clusters. Some authors view clustering as a special type of classification. In this text, however, we follow a more conventional view in that the two are different. Many definitions for clusters have been proposed: ●Set of like elements. Elements from different clusters are not alike. ●The distance between points in a cluster is less than the distance between a point in the cluster and any point outside it. A term similar to clustering is database segmentation, where like tuple (record) in a database are grouped together. This is done to partition or segment the database into components that then give the user a more general view of the data. In this case text, we do not differentiate between segmentation and clustering. A simple example of clustering is found in Example 5.1. This example illustrates the fact that that determining how to do the clustering is not straightforward. As illustrated in Figure 5.1, a given set of data may be clustered on different attributes. Here a group of homes in a geographic area is shown. The first floor type of clustering is based on the location of the home. Homes that are geographically close to each other are clustered together. In the second clustering, homes are grouped based on the size of the house. Clustering has been used in many application domains, including biology, medicine, anthropology, marketing, and economics. Clustering applications include plant and animal classification, disease classification, image processing, pattern recognition, and document retrieval. One of the first domains in which clustering was used was biological taxonomy. Recent uses include examining Web log data to detect usage patterns. When clustering is applied to a real-world database, many interesting problems occur: ●Outlier handling is difficult. Here the elements do not naturally fall into any cluster. They can be viewed as solitary clusters. However, if a clustering algorithm attempts to find larger clusters, these outliers will be forced to be placed in some cluster. This process may result in the creation聚类分析、数据挖掘、关联规则这几个概念的关系

数据挖掘关联规则分析报告

数据挖掘实验报告三

数据挖掘实验报告-聚类分析

数据挖掘CHAPTER8聚类分析

数据挖掘论文聚类分析论文

数据挖掘考试题精编版

数据挖掘第三版第十章课后习题答案

Data-mining-clustering数据挖掘—聚类分析大学毕业论文外文文献翻译及原文