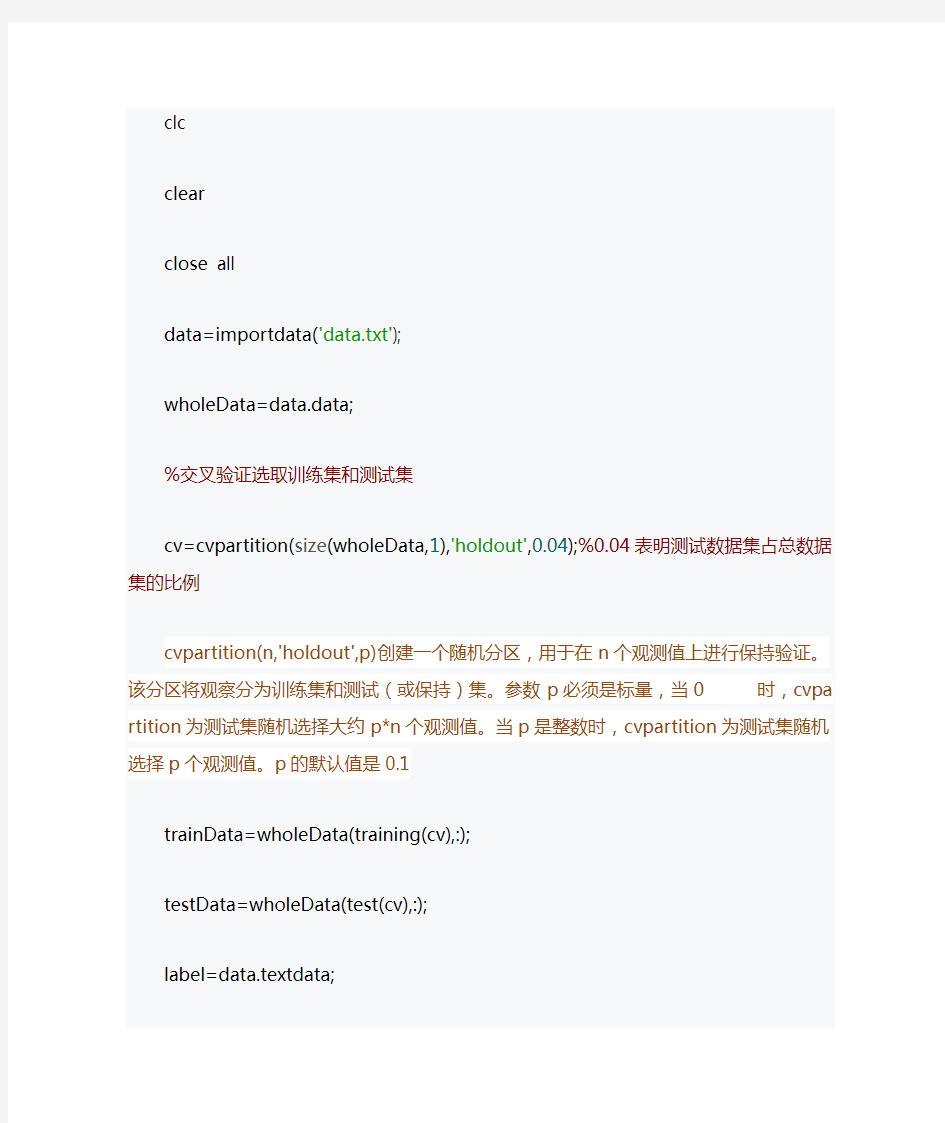

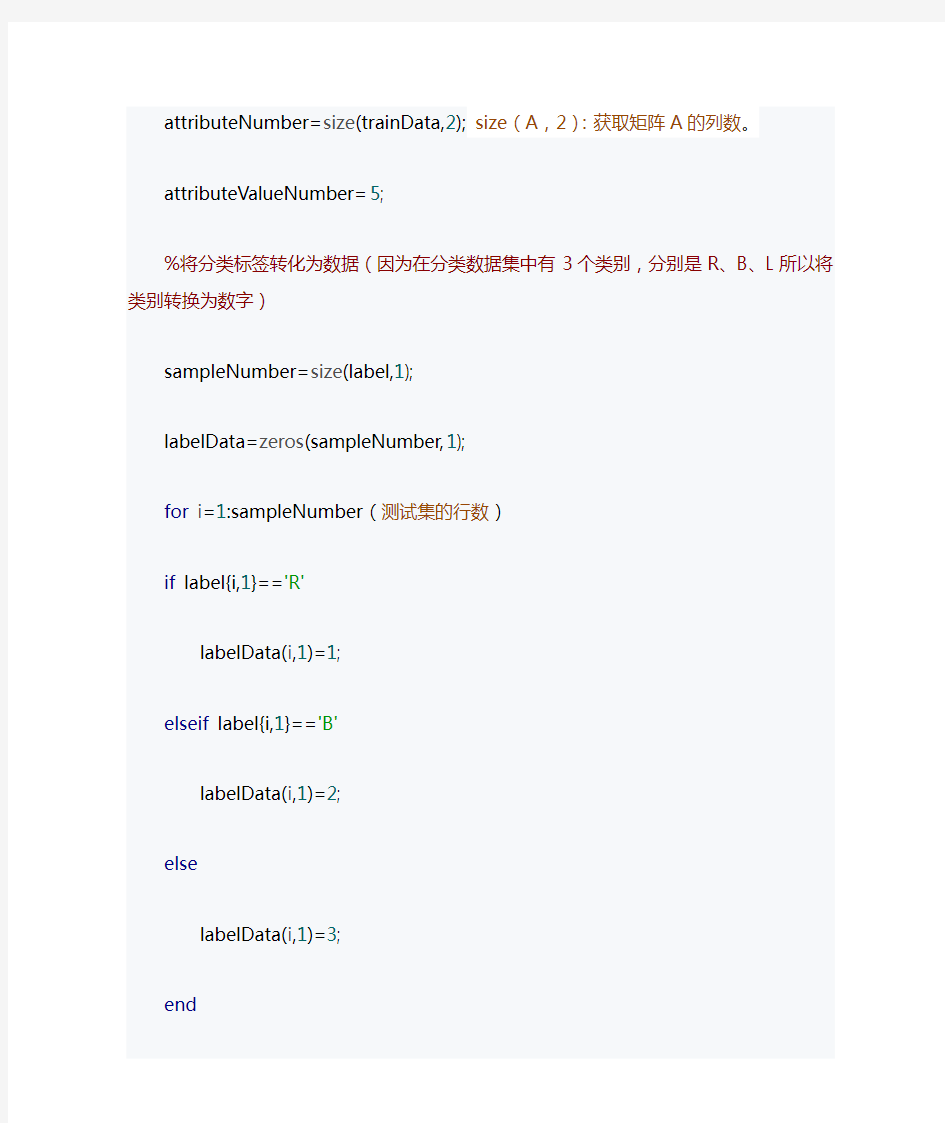

clc

clear

close all

data=importdata('data.txt');

wholeData=data.data;

%交叉验证选取训练集和测试集

cv=cvpartition(size(wholeData,1),'holdout',0.04);%0.04表明测试数据集占总数据集的比例

cvpartition(n,'holdout',p)创建一个随机分区,用于在n个观测值上进行保持验证。该分区将观察分为训练集和测试(或保持)集。参数p必须是标量,当0 trainData=wholeData(training(cv),:); testData=wholeData(test(cv),:); label=data.textdata; attributeNumber=size(trainData,2);size(A,2):获取矩阵A的列数。attributeValueNumber=5; %将分类标签转化为数据(因为在分类数据集中有3个类别,分别是R、B、L所以将类别转换为数字) sampleNumber=size(label,1); labelData=zeros(sampleNumber,1); for i=1:sampleNumber(测试集的行数) if label{i,1}=='R' labelData(i,1)=1; elseif label{i,1}=='B' labelData(i,1)=2; else labelData(i,1)=3; end end trainLabel=labelData(training(cv),:); trainSampleNumber=size(trainLabel,1); testLabel=labelData(test(cv),:); %计算每个分类的样本的概率 labelProbability=tabulate(trainLabel); tabulate函数的功能是创建向量X信息数据频率表。其函数使用格式: tbl = tabulate(x) 创建的TBL(数据频率表)的结构:第一列:x的唯一值第二列:每个值的实例数量第三列:每个值的百分比 %P_yi,计算P(yi) P_y1=labelProbability(1,3)/100;(第一行,第三个元素) P_y2=labelProbability(2,3)/100; P_y3=labelProbability(3,3)/100; count_1=zeros(attributeNumber,attributeValueNumber);%count_1(i,j):y=1情况下,第i个属性取j值的数量统计 count_2=zeros(attributeNumber,attributeValueNumber);%count_1(i,j):y=2情况下,第i个属性取j值的数量统计 count_3=zeros(attributeNumber,attributeValueNumber);%count_1(i,j):y=3情况下,第i个属性取j值的数量统计 %统计每一个特征的每个取值的数量 for jj=1:3 for j=1:trainSampleNumber for ii=1:attributeNumber for k=1:attributeValueNumber if jj==1 if trainLabel(j,1)==1&&trainData(j,ii)==k count_1(ii,k)=count_1(ii,k)+1; end elseif jj==2 if trainLabel(j,1)==2&&trainData(j,ii)==k count_2(ii,k)=count_2(ii,k)+1; end else if trainLabel(j,1)==3&&trainData(j,ii)==k count_3(ii,k)=count_3(ii,k)+1; end end end end end end %计算第i个属性取j值的概率,P_a_y1是分类为y=1前提下取值,其他依次类推。P_a_y1=count_1./labelProbability(1,2); P_a_y2=count_2./labelProbability(2,2); P_a_y3=count_3./labelProbability(3,2); %使用测试集进行数据测试 labelPredictNumber=zeros(3,1); predictLabel=zeros(size(testData,1),1); for kk=1:size(testData,1) testDataTemp=testData(kk,:); Pxy1=1; Pxy2=1; Pxy3=1; %计算P(x|yi) for iii=1:attributeNumber Pxy1=Pxy1*P_a_y1(iii,testDataTemp(iii)); Pxy2=Pxy2*P_a_y2(iii,testDataTemp(iii)); Pxy3=Pxy3*P_a_y3(iii,testDataTemp(iii)); end %计算P(x|yi)*P(yi) PxyPy1=P_y1*Pxy1; PxyPy2=P_y2*Pxy2; PxyPy3=P_y3*Pxy3; if PxyPy1>PxyPy2&&PxyPy1>PxyPy3 predictLabel(kk,1)=1; disp(['this item belongs to No.',num2str(1),' label or the R labe l']) labelPredictNumber(1,1)=labelPredictNumber(1,1)+1; elseif PxyPy2>PxyPy1&&PxyPy2>PxyPy3 predictLabel(kk,1)=2; labelPredictNumber(2,1)=labelPredictNumber(2,1)+1; disp(['this item belongs to No.',num2str(2),' label or the B labe l']) elseif PxyPy3>PxyPy2&&PxyPy3>PxyPy1 predictLabel(kk,1)=3; labelPredictNumber(3,1)=labelPredictNumber(3,1)+1; disp(['this item belongs to No.',num2str(3),' label or the L labe l']) end end testLabelCount=tabulate(testLabel); % 计算混淆矩阵 disp('the confusion matrix is : ') C_Bayes=confusionmat(testLabel,predictLabel) 89 ?103 以上部分就是针对于这个已有的数据集进行的算法的实现。 ?结果与分析 C_Bayes是计算出来的混淆矩阵。 其结果为: C_Bayes= 83000000148003000014 为了验证该自编程序是否可靠,我再使用了Matlab自带的贝叶斯算法的函数fitcnb进行该数据的分类测试 Nb=fitcnb(trainData,trainLabel); y_nb=Nb.predict(testData); C_nb=confusionmat(testLabel,y_nb) ? 1 ? 2 ? 3 ? 4 其中C_nb是采用自带函数得到的结果的混淆矩阵 其结果为: C_nb= 83000000148003000014 可以发现其结果是完全一样的。 为了进一步验证程序的可靠性,我改变了交叉验证中训练集和测试集的比例,设置为0.2,此时采用自编程序得到的混淆矩阵为: C_Bayes= 6340000055263004050052 而使用自带函数fitcnb得到的结果为: C_nb= 6340000055263004050052 可以发现再次得到了一致的结果。 总结 贝叶斯分类器的matlab实现 贝叶斯分类原理: 1)在已知P(Wi),P(X|Wi)(i=1,2)及给出待识别的X的情况下,根据贝叶斯公式计算出后验概率P(Wi|X) ; 2)根据1)中计算的后验概率值,找到最大的后验概率,则样本X属于该类 举例: 解决方案: 但对于两类来说,因为分母相同,所以可采取如下分类标准: %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%% %By Shelley from NCUT,April 14th 2011 %Email:just_for_h264@https://www.doczj.com/doc/71444914.html, %此程序利用贝叶斯分类算法,首先对两类样本进行训练, %进而可在屏幕上任意取点,程序可输出属于第一类,还是第二类%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%% clear; close all %读入两类训练样本数据 load data %求两类训练样本的均值和方差 u1=mean(Sample1); u2=mean(Sample2); sigm1=cov(Sample1); sigm2=cov(Sample2); %计算两个样本的密度函数并显示 x=-20:0.5:40; y= -20:0.5:20; [X,Y] = meshgrid(x,y); F1 = mvnpdf([X(:),Y(:)],u1,sigm1); F2 = mvnpdf([X(:),Y(:)],u2,sigm2); P1=reshape(F1,size(X)); P2=reshape(F2,size(X)); figure(2) surf(X,Y,P1) hold on surf(X,Y,P2) shading interp colorbar title('条件概率密度函数曲线'); %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %% %以下为测试部分 %利用ginput随机选取屏幕上的点(可连续取10个点) 最近发现很多公司招聘数据挖掘的职位都提到贝叶斯分类,其实我不太清楚他们是要求理解贝叶斯分类算法,还是要求只需要通过工具(SPSS,SAS,Mahout)使用贝叶斯分类算法进行分类。 反正不管是需求什么都最好是了解其原理,才能知其然,还知其所以然。我尽量简单的描述贝叶斯定义和分类算法,复杂而有全面的描述参考“数据挖掘:概念与技术”。贝叶斯是一个人,叫(Thomas Bayes),下面这哥们就是。 本文介绍了贝叶斯定理,朴素贝叶斯分类算法及其使用MapReduce实现。 贝叶斯定理 首先了解下贝叶斯定理 P X H P(H) P H X= 是不是有感觉都是符号看起来真复杂,我们根据下图理解贝叶斯定理。 这里D是所有顾客(全集),H是购买H商品的顾客,X是购买X商品的顾客。自然X∩H是即购买X又购买H的顾客。 P(X) 指先验概率,指所有顾客中购买X的概率。同理P(H)指的是所有顾客中购买H 的概率,见下式。 X P X= H P H= P(H|X) 指后验概率,在购买X商品的顾客,购买H的概率。同理P(X|H)指的是购买H商品的顾客购买X的概率,见下式。 X∩H P H|X= X∩H P X|H= 将这些公式带入上面贝叶斯定理自然就成立了。 朴素贝叶斯分类 分类算法有很多,基本上决策树,贝叶斯分类和神经网络是齐名的。朴素贝叶斯分类假定一个属性值对给定分类的影响独立于其他属性值。 描述: 这里有个例子假定我们有一个顾客X(age = middle,income=high,sex =man):?年龄(age)取值可以是:小(young),中(middle),大(old) ?收入(income)取值可以是:低(low),中(average),高(high) ?性别(sex)取值可以是:男(man),女(woman) 其选择电脑颜色的分类标号H:白色(white),蓝色(blue),粉色(pink) 问题: 用朴素贝叶斯分类法预测顾客X,选择哪个颜色的分类标号,也就是预测X属于具有最高后验概率的分类。 解答: Step 1 也就是说我们要分别计算X选择分类标号为白色(white),蓝色(blue),粉色(pink)的后验概率,然后进行比较取其中最大值。 根据贝叶斯定理 朴素贝叶斯算法 1.算法简介 朴素贝叶斯分类是一种十分简单的分类算法,叫它朴素贝叶斯分类是因为这种方法的思想真的很朴素,朴素贝叶斯的思想基础是:对于给出的待分类项,求解在此项出现的条件下各个类别出现的概率,哪个最大,就认为此待分类项属于哪个类别。 2.算法定义 朴素贝叶斯分类的正式定义如下: 1)设为一个待分类项,而每个a为x的一个特征属性; 2)有类别集合; 3)计算。 4)如果,则。 其中关键是如何计算步骤3)中的各个条件概率。计算过程如下: (1)找到一个已知分类的待分类项集合,该集合称为训练样本集。 (2)统计得到在各类别下各个特征属性的条件概率估计。即 (3)如果各个特征属性是条件独立的,则根据贝叶斯定理有如下推导: 因为分母对于所有类别为常数,因此只要将分子最大化皆可。又因为各特征属性是条件独立的,所以有: 可以看到,整个朴素贝叶斯分类分为三个阶段: 第一阶段——准备工作阶段,这个阶段的任务是为朴素贝叶斯分类做必要的准备,主要工作是根据具体情况确定特征属性,并对每个特征属性进行适当划分,然后由人工对一部分待分类项进行分类,形成训练样本集合。这一阶段的输入是所有待分类数据,输出是特征属性和训练样本。这一阶段是整个朴素贝叶斯分类中唯一需要人工完成的阶段,其质量对整个过程将有重要影响,分类器的质量很大程度上由特征属性、特征属性划分及训练样本质量决定。 第二阶段——分类器训练阶段,这个阶段的任务就是生成分类器,主要工作是计算每个类别在训练样本中的出现频率及每个特征属性划分对每个类别的条 件概率估计,并将结果记录。其输入是特征属性和训练样本,输出是分类器。这一阶段是机械性阶段,根据前面讨论的公式可以由程序自动计算完成。 第三阶段——应用阶段。这个阶段的任务是使用分类器对待分类项进行分类,其输入是分类器和待分类项,输出是待分类项与类别的映射关系。这一阶段也是机械性阶段,由程序完成。 3.估计类别下特征属性划分的条件概率及Laplace校准 ?估计类别下特征属性划分的条件概率 计算各个划分的条件概率P(a|y)是朴素贝叶斯分类的关键性步骤,当特征属性为离散值时,只要很方便的统计训练样本中各个划分在每个类别中出现的频率即可用来估计P(a|y),下面重点讨论特征属性是连续值的情况。 当特征属性为连续值时,通常假定其值服从高斯分布(也称正态分布)。即: 而 因此只要计算出训练样本中各个类别中此特征项划分的各均值和标准差,代入上述公式即可得到需要的估计值。 ?Laplace校准 当某个类别下某个特征项划分没有出现时,会产生P(a|y)=0的现象,这会令分类器质量大大降低。为了解决这个问题,引入Laplace校准,就是对每个类别下所有划分的计数加1,这样如果训练样本集数量充分大时,并不会对结果产生影响,并且解决了上述频率为0的尴尬局面。 ●Laplace校准详解 假设离散型随机变量z有{1,2,…,k}共k个值,用 j (),{1,2,,} p z j j k Φ=== 来表示每个值的概率。假设在m个训练样本中,z的观察值是其中每一个观察值对应k个值中的一个。那么z=j出现的概率为: Laplace校准将每个特征值出现次数事先都加1,通俗讲就是假设它们都出现过一次。那么修改后的表达式为: 数据挖掘(8):朴素贝叶斯分类算法原理与实践 隔了很久没有写数据挖掘系列的文章了,今天介绍一下朴素贝叶斯分类算法,讲一下基本原理,再以文本分类实践。 一个简单的例子 朴素贝叶斯算法是一个典型的统计学习方法,主要理论基础就是一个贝叶斯公式,贝叶斯公式的基本定义如下: 这个公式虽然看上去简单,但它却能总结历史,预知未来。公式的右边是总结历史,公式的左边是预知未来,如果把Y看出类别,X看出特征,P(Yk|X)就是在已知特征X的情况下求Yk类别的概率,而对P(Yk|X)的计算又全部转化到类别Yk的特征分布上来。举个例子,大学的时候,某男生经常去图书室晚自习,发现他喜欢的那个女生也常去那个自习室,心中窃喜,于是每天买点好吃点在那个自习室蹲点等她来,可是人家女生不一定每天都来,眼看天气渐渐炎热,图书馆又不开空调,如果那个女生没有去自修室,该男生也就不去,每次男生鼓足勇气说:“嘿,你明天还来不?”,“啊,不知道,看情况”。然后该男生每天就把她去自习室与否以及一些其他情况做一下记录,用Y表示该女生是否去自习室,即Y={去,不去},X是跟去自修室有关联的一系列条件,比如当天上了哪门主课,蹲点统计了一段时间后,该男生打算今天不再蹲点,而是先预测一下她会不会去,现在已经知道了今天上了常微分方法这么主课,于是计算P(Y=去|常微分方 程)与P(Y=不去|常微分方程),看哪个概率大,如果P(Y=去|常微分方程) >P(Y=不去|常微分方程),那这个男生不管多热都屁颠屁颠去自习室了,否则不就去自习室受罪了。P(Y=去|常微分方程)的计算可以转为计算以前她去的情况下,那天主课是常微分的概率P(常微分方程|Y=去),注意公式右边的分母对每个类别(去/不去)都是一样的,所以计算的时候忽略掉分母,这样虽然得到的概率值已经不再是0~1之间,但是其大小还是能选择类别。 后来他发现还有一些其他条件可以挖,比如当天星期几、当天的天气,以及上一次与她在自修室的气氛,统计了一段时间后,该男子一计算,发现不好算了,因为总结历史的公式: 这里n=3,x(1)表示主课,x(2)表示天气,x(3)表示星期几,x(4)表示气氛,Y仍然是{去,不去},现在主课有8门,天气有晴、雨、阴三种、气氛有A+,A,B+,B,C五种,那么总共需要估计的参数有8*3*7*5*2=1680个,每天只能收集到一条数据,那么等凑齐1 680条数据大学都毕业了,男生打呼不妙,于是做了一个独立性假设,假设这些影响她去自习室的原因是独立互不相关的,于是 有了这个独立假设后,需要估计的参数就变为,(8+3+7+5)*2 = 46个了,而且每天收集的一条数据,可以提供4个参数,这样该男生就预测越来越准了。 作业:在下列条件下,求待定样本x=(2,0)T的类别,画出分界线,编程上机。 1、二类协方差不等 Matlab程序如下: >> x1=[mean([1,1,2]),mean([1,0,-1])]',x2=[mean([-1,-1,-2]),mean([1,0,-1])]' x1 = 1.3333 x2 = -1.3333 >> m=cov([1,1;1,0;2,-1]),n=cov([-1,1;-1,0;-2,-1]) m = 0.3333 -0.5000 -0.5000 1.0000 n = 0.3333 0.5000 0.5000 1.0000 >> m1=inv(m),n1=inv(n) m1 = 12.0000 6.0000 6.0000 4.0000 n1 = 12.0000 -6.0000 -6.0000 4.0000 >> p=log((det(m))/(det(n))) p = >> q=log(1) q = >> x=[2,0]' x = 2 >> g=0.5*(x-x1)'*m1*(x-x1)-0.5*(x-x2)'*n1*(x-x2)+0.5*p-q g = -64 (说明:g<0,则判定x=[2,0]T属于ω1类) (化简矩阵多项式0.5*(x-x1)'*m1*(x-x1)-0.5*(x-x2)'*n1*(x-x2)+0.5*p-q,其中x1,x2已知,x 设为x=[ x1,x2]T,化简到(12x1-16+6x2)(x1-4/3)+(6x1-8+4x2) -(12x1+16-6x2)(x1+4/3)-(-6x1-8+4x2)x2, 下面用matlab化简,程序如下) >> syms x2; >> syms x1; >> w=(12*x1-16+6*x2)*(x1-4/3)+(6*x1-8+4*x2)*x2-(12*x1+16-6*x2)*(x1+4/3)-(-6*x1-8+4*x2)*x 2,simplify(w) w = 朴素贝叶斯 优点:在数据较少的情况下仍然有效,可以处理多类别问题 缺点:对于输入数据的准备方式较为敏感 适用数据类型:标称型数据 贝叶斯准则: 使用朴素贝叶斯进行文档分类 朴素贝叶斯的一般过程 (1)收集数据:可以使用任何方法。本文使用RSS源 (2)准备数据:需要数值型或者布尔型数据 (3)分析数据:有大量特征时,绘制特征作用不大,此时使用直方图效果更好 (4)训练算法:计算不同的独立特征的条件概率 (5)测试算法:计算错误率 (6)使用算法:一个常见的朴素贝叶斯应用是文档分类。可以在任意的分类场景中使用朴素贝叶斯分类器,不一定非要是文本。 准备数据:从文本中构建词向量 摘自机器学习实战。 [['my','dog','has','flea','problems','help','please'], 0 ['maybe','not','take','him','to','dog','park','stupid'], 1 ['my','dalmation','is','so','cute','I','love','him'], 0 ['stop','posting','stupid','worthless','garbage'], 1 ['mr','licks','ate','my','steak','how','to','stop','him'], 0 ['quit','buying','worthless','dog','food','stupid']] 1 以上是六句话,标记是0句子的表示正常句,标记是1句子的表示为粗口。我们通过分析每个句子中的每个词,在粗口句或是正常句出现的概率,可以找出那些词是粗口。 在bayes.py文件中添加如下代码: [python]view plaincopy 1.# coding=utf-8 2. 3.def loadDataSet(): 4. postingList = [['my', 'dog', 'has', 'flea', 'problems', 'help', 'please' ], 5. ['maybe', 'not', 'take', 'him', 'to', 'dog', 'park', 'stupid'], 6. ['my', 'dalmation', 'is', 'so', 'cute', 'I', 'love', 'him'], 7. ['stop', 'posting', 'stupid', 'worthless', 'garbage'], 8. ['mr', 'licks', 'ate', 'my', 'steak', 'how', 'to', 'stop', 'him'], 9. ['quit', 'buying', 'worthless', 'dog', 'food', 'stupid']] 10. classVec = [0, 1, 0, 1, 0, 1] # 1代表侮辱性文字,0代表正常言论 11.return postingList, classVec 12. 13.def createVocabList(dataSet): 14. vocabSet = set([]) 15.for document in dataSet: 16. vocabSet = vocabSet | set(document) 17.return list(vocabSet) 18. 19.def setOfWords2Vec(vocabList, inputSet): 20. returnVec = [0] * len(vocabList) 21.for word in inputSet: 22.if word in vocabList: 23. returnVec[vocabList.index(word)] = 1 24.else: 25.print"the word: %s is not in my Vocabulary!" % word 26.return returnVec 实验一 Bayes 分类器设计 【实验目的】 对模式识别有一个初步的理解,能够根据自己的设计对贝叶斯决策理论算法有一个深刻地认识,理解二类分类器的设计原理。 【实验条件】 Matlab 软件 【实验原理】 根据贝叶斯公式,给出在类条件概率密度为正态分布时具体的判别函数表达式,用此判别函数设计分类器。数据随机生成,比如生成两类样本(如鲈鱼和鲑鱼),每个样本有两个特征(如长度和亮度),每类有若干个(比如50个)样本点,假设每类样本点服从二维正态分布,随机生成具体数据,然后估计每类的均值与协方差,在下列各种情况下求出分类边界。先验概率自己给定,比如都为0.5。如果可能,画出在两类协方差不相同的情况下的分类边界。 若第一类的样本为{}12,,n x x x ,则第一类均值的估计为1 1?n k k x n μ==∑,协方差的估计为1 1???()()n T k k k x x n μμ=∑=--∑。则在两类协方差不相同的情况下的判别函数为: 判别边界为g1(x)-g2(x)=0,是一条一般二次曲线(可能是椭圆、双曲线、抛物线等)。 【实验内容】 1、 自动随机生成两类服从二维正态分布的样本点 2、 计算两类样本的均值和协方差矩阵 3、 按照两类协方差不相同情况下的判别函数,求出判别方程曲线。 4、 通过修改不同的参数(均值、方差、协方差矩阵),观察判别方程曲线的变化。 【实验程序】 clear all; close all; samplenum = 50;%样本的个数 n1(:,1) = normrnd(8,4,samplenum,1);%产生高斯分布的二维随机样本,第一个参数为均值,第二个为方差 n1(:,2) = normrnd(6,4,samplenum,1);%产生高斯分布的二维随机样本,第一个参数为均值,第二个为方差 n2(:,1) = normrnd(14,4,samplenum,1);%产生高斯分布的二维随机样本,第一个参数为均值,第二个为方差 n2(:,2) = normrnd(16,4,samplenum,1);%产生高斯分布的二维随机样本,第一个参数为均值,第二个为方差 scatter(n1(1:samplenum,1),n1(1:samplenum,2),'ro');%画出样本 hold on scatter(n2(1:samplenum,1),n2(1:samplenum,2),'g*');%画出样本 u1 = mean(n1);%计算第一类样本的均值 e1=0; for i=1:20 e1 = e1+(n1(i,:)-u1)'*(n1(i,:)-u1);%计算协方差矩阵 end; u2 = mean(n2);%计算第二类样本的均值 e2=0; for i=1:20 e2 = e2+(n2(i,:)-u2)'*(n2(i,:)-u2);%计算协方差矩阵 end; e2=e2/20;%计算协方差矩阵 e1=e1/20;%计算协方差矩阵 %-------------通过改变条件来完成不同的曲线--------- % e2 = e1; %-------------------------------------------------- u1 = u1'; u2 = u2'; scatter(u1(1,1),u1(2,1),'b+');%画出样本中心 scatter(u2(1,1),u2(2,1),'b+');%画出样本中心 line([u1(1,1),u2(1,1)],[u1(2,1),u2(2,1)]); %画出样本中心连线 %求解分类方程 W1=-1/2*inv(e1); w1=inv(e1)*u1; w10=-1/2*u1'*inv(e1)*u1-1/2*log(det(inv(e1)))+log(0.5);%假设w1的先验概率为0.5 W2=-1/2*inv(e2); w2=inv(e2)*u2; w20=-1/2*u2'*inv(e2)*u2-1/2*log(det(inv(e2)))+log(0.5);% 假设w2的先验概率为0.5 syms x y; fn = [x,y]*(W1-W2)*[x,y]'+(w1-w2)'*[x,y]'+w10-w20; ezplot(fn,[0,30]); 朴素贝叶斯分类器 Naive Bayesian Classifier C语言实现 信息电气工程学院 计算本1102班 20112212465 马振磊 1.贝叶斯公式 通过贝叶斯公式,我们可以的知在属性F1-Fn成立的情况下,该样本属于分类C的概率。 而概率越大,说明样本属于分类C的可能性越大。 若某样本可以分为2种分类A,B。 要比较P(A | F1,F2......) 与P(B | F1,F2......)的大小只需比较,P(A)P(F1,F2......| A) ,与P(B)P(F1,F2......| B) 。因为两式分母一致。 而P(A)P(F1,F2......| A)可以采用缩放为P(A)P(F1|A)P(F2|A).......(Fn|A) 因此,在分类时,只需比较每个属性在分类下的概率累乘,再乘该分类的概率即可。 分类属性outlook 属性temperature 属性humidity 属性wind no sunny hot high weak no sunny hot high strong yes overcast hot high weak yes rain mild high weak yes rain cool normal weak no rain cool normal strong yes overcast cool normal strong no sunny mild high weak yes sunny cool normal weak yes rain mild normal weak yes sunny mild normal strong yes overcast mild high strong yes overcast hot normal weak no rain mild high strong 以上是根据天气的4种属性,某人外出活动的记录。 若要根据以上信息判断 (Outlook = sunny,Temprature = cool,Humidity = high,Wind = strong) 所属分类。 P(yes| sunny ,cool ,high ,strong )=P(yes)P(sunny|yes)P(cool |yes)P(high|yes)P(strong|yes)/K P(no| sunny ,cool ,high ,strong )=P(no)P(sunny|no)P(cool |no)P(high|no)P(strong|no)/K K为缩放因子,我们只需要知道两个概率哪个大,所以可以忽略K。 P(yes)=9/14 P(no)=5/14 P(sunny|yes)=2/9 P(cool|yes)=1/3 P(high|yes)=1/3 P(strong|yes)=1/3 P(sunny|no)=3/5 P(cool|no)=1/5 P(high|no)=4/5 P(strong|no)=3/5 P(yes| sunny ,cool ,high ,strong)=9/14*2/9*1/3*1/3*1/3=0.00529 P(no| sunny ,cool ,high ,strong )=5/14*3/5*1/5*4/5*3/5=0.20571 No的概率大,所以该样本实例属于no分类。 朴素贝叶斯分类器的应用 作者:阮一峰 日期:2013年12月16日 生活中很多场合需要用到分类,比如新闻分类、病人分类等等。 本文介绍朴素贝叶斯分类器(Naive Bayes classifier),它是一种简单有效的常用分类算法。 一、病人分类的例子 让我从一个例子开始讲起,你会看到贝叶斯分类器很好懂,一点都不难。 某个医院早上收了六个门诊病人,如下表。 症状职业疾病 打喷嚏护士感冒 打喷嚏农夫过敏 头痛建筑工人脑震荡 头痛建筑工人感冒 打喷嚏教师感冒 头痛教师脑震荡 现在又来了第七个病人,是一个打喷嚏的建筑工人。请问他患上感冒的概率有多大? 根据贝叶斯定理: P(A|B) = P(B|A) P(A) / P(B) 可得 P(感冒|打喷嚏x建筑工人) = P(打喷嚏x建筑工人|感冒) x P(感冒) / P(打喷嚏x建筑工人) 假定"打喷嚏"和"建筑工人"这两个特征是独立的,因此,上面的等式就变成了 P(感冒|打喷嚏x建筑工人) = P(打喷嚏|感冒) x P(建筑工人|感冒) x P(感冒) / P(打喷嚏) x P(建筑工人) 这是可以计算的。 P(感冒|打喷嚏x建筑工人) = 0.66 x 0.33 x 0.5 / 0.5 x 0.33 = 0.66 因此,这个打喷嚏的建筑工人,有66%的概率是得了感冒。同理,可以计算这个病人患上过敏或脑震荡的概率。比较这几个概率,就可以知道他最可能得什么病。 这就是贝叶斯分类器的基本方法:在统计资料的基础上,依据某些特征,计算各个类别的概率,从而实现分类。 二、朴素贝叶斯分类器的公式 假设某个体有n项特征(Feature),分别为F1、F2、...、F n。现有m个类别(Category),分别为C1、C2、...、C m。贝叶斯分类器就是计算出概率最大的那个分类,也就是求下面这个算式的最大值: P(C|F1F2...Fn) = P(F1F2...Fn|C)P(C) / P(F1F2...Fn) 由于 P(F1F2...Fn) 对于所有的类别都是相同的,可以省略,问题就变成了求 P(F1F2...Fn|C)P(C) 的最大值。 朴素贝叶斯算法详细总结 朴素贝叶斯法是基于贝叶斯定理与特征条件独立假设的分类方法,是经典的机器学习算法之一,处理很多问题时直接又高效,因此在很多领域有着广泛的应用,如垃圾邮件过滤、文本分类等。也是学习研究自然语言处理问题的一个很好的切入口。朴素贝叶斯原理简单,却有着坚实的数学理论基础,对于刚开始学习算法或者数学基础差的同学们来说,还是会遇到一些困难,花费一定的时间。比如小编刚准备学习的时候,看到贝叶斯公式还是有点小害怕的,也不知道自己能不能搞定。至此,人工智能头条特别为大家寻找并推荐一些文章,希望大家在看过学习后,不仅能消除心里的小恐惧,还能高效、容易理解的get到这个方法,从中获得启发没准还能追到一个女朋友,脱单我们是有技术的。贝叶斯分类是一类分类算法的总称,这类算法均以贝叶斯定理为基础,故统称为贝叶斯分类。而朴素朴素贝叶斯分类是贝叶斯分类中最简单,也是常见的一种分类方法。这篇文章我尽可能用直白的话语总结一下我们学习会上讲到的朴素贝叶斯分类算法,希望有利于他人理解。 ▌分类问题综述 对于分类问题,其实谁都不会陌生,日常生活中我们每天都进行着分类过程。例如,当你看到一个人,你的脑子下意识判断他是学生还是社会上的人;你可能经常会走在路上对身旁的朋友说“这个人一看就很有钱、”之类的话,其实这就是一种分类操作。 既然是贝叶斯分类算法,那么分类的数学描述又是什么呢? 从数学角度来说,分类问题可做如下定义: 已知集合C=y1,y2,……,yn 和I=x1,x2,……,xn确定映射规则y=f(),使得任意xi∈I有且仅有一个yi∈C,使得yi∈f(xi)成立。 其中C叫做类别集合,其中每一个元素是一个类别,而I叫做项集合(特征集合),其中每一个元素是一个待分类项,f叫做分类器。分类算法的任务就是构造分类器f。 分类算法的内容是要求给定特征,让我们得出类别,这也是所有分类问题的关键。那么如何由指定特征,得到我们最终的类别,也是我们下面要讲的,每一个不同的分类算法,对 简单分类器的MATLAB实现 摘要:本实验运用最小距离法、Fisher线形判别法、朴素贝叶斯法、K近邻法四种模式识别中最简单的方法处理两维两类别的识别问题,最后对实验结果进行了比较。 关键字:MATLAB 最小距离Fisher线形判别朴素贝叶斯K近邻法 一.M atlab语言简介 Matlab 语言(即Matrix 和Laboratory) 的前三位字母组合,意为“矩阵实验室”,Matlab 语言是一种具有面向对象程序设计特征的高级语言,以矩阵和阵列为基本编程单位。Matlab 可以被高度“向量化”,而且用户易写易读。传统的高级语言开发程序不仅仅需要掌握所用语言的语法,还需要对有关算法进行深入的分析。与其他高级程序设计语言相比,Matlab 在编程的效率、可读性以及可移植性等方面都要高于其他高级语言,但是执行效率要低于高级语言,对计算机系统的要求比较高。例如,某数据集是m*n的二维数据组,对一般的高级计算机语言来说,必须采用两层循环才能得到结果,不但循环费时费力,而且程序复杂;而用Matlab 处理这样的问题就快得多,只需要一小段程序就可完成该功能,虽然指令简单,但其计算的快速性、准确性和稳定性是一般高级语言程序所远远不及的。严格地说,Matlab 语言所开发的程序不能脱离其解释性执行环境而运行。 二.样本预处理 实验样本来源于1996年UCI的Abalone data,原始样本格式如下: 1 2 3 4 5 6 7 8 9 其中第一行是属性代码:1.sex 2.length 3.diameter 4.height 5.whole_weight 6.shucked_weight 7 .viscera weight 8. shell weight 9.age 原始样本是一个8维20类的样本集,就是根据Abalone的第一至第八个特征来预测第九个特征,即Abalone的年龄。为简单其见,首先将原始样本处理成两维两类别问题的样本。选取length和weiht作为两个特征向量,来预测第三个特征向量age.(age=6或者age=9),我们将age=6的样本做为第一类,age=12的样本做为第二类。 处理后的样本: length weight age 第二章 1、简述基于最小错误率的贝叶斯决策理论;并分析在“大数据时代”,使用贝叶斯决策理论需要解决哪些问 题,贝叶斯决策理论有哪些优缺点,贝叶斯决策理论适用条件和范围是什么?举例说明风险最小贝叶斯决策理论的意义。 答:在大数据时代,我们可以获得很多的样本数据,并且是已经标记好的;要使用贝叶斯决策理论最重要的是确定类条件概率密度函数和相关的参数。 优缺点:贝叶斯决策的优点是思路比较简单,大数据的前提下我们可以得到较准确的先验概率, 因此如果确定了类条件概率密度函数,我们便可以很快的知道如何分类,但是在大数据的前提下,类条件概率密度函数的确定不是这么简单,因为参数可能会增多,有时候计算量也是很大的。 适用条件和范围: (1) 样本(子样)的数量(容量)不充分大,因而大子样统计理论不适宜的场合。 (2) 试验具有继承性,反映在统计学上就是要具有在试验之前已有先验信息的场合。用这种方法进 行分类时要求两点: 第一,要决策分类的参考总体的类别数是一定的。例如两类参考总体(正常状态Dl和异常状态D2),或L类参考总体D1,D2,…,DL(如良好、满意、可以、不满意、不允许、……)。 第二,各类参考总体的概率分布是已知的,即每一类参考总体出现的先验概率P(Di)以及各类概率 密度函数P(x/Di)是已知的。显然,0≤P(Di)≤1,(i=l,2,…,L),∑P(Di)=1。 说明风险最小贝叶斯决策理论的意义: 那股票举例,现在有A、B两个股票,根据市场行情结合最小错误率的风险选择A股(假设为0.55),而B股(0.45);但是选着A股必须承担着等级为7的风险,B股风险等级仅为4;这时因遵循最 小风险的贝叶斯决策,毕竟如果A股投资的失败带来的经济损失可能获得收益还大。 2、教材中例2.1-2.2的Matlab实现. 2.1:结果: 深圳大学研究生课程:模式识别理论与方法 课程作业实验报告 实验名称:Bayes Classifier 实验编号:proj02-01 姓名:汪长泉 学号:2100130303 规定提交日期:2010年10月20日 实际提交日期:2010年10月20日 摘要:在深入掌握多维高斯分布性质,贝叶斯分类的基础上,用计算机编程实现一个分类两类模式样本的贝叶斯分类器。用matlab编程,并分析了实验结果,得出贝叶斯分类的一般结论。 1. 贝叶斯分类器 贝叶斯分类器的分类原理是通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。 1.1 两类情况 两类情况是多类情况的基础,多类情况往往是用多个两类情况解决的。 ① 用i ω,i =1, 2表示样本x (一般用列向量表示)所属的类别。 ② 假设先验概率()P ω1,()P ω2已知。(这个假设是合理的,因为如果先验概率未知,可以从训 练特征向量中估算出来,即如果N 是训练样本总数,其中有,N N 12个样本分别属于 2,1ωω,则相应的先验概率: ()/P N N ω≈11,2 ()/P N N ω≈2) ③ 假设(类)条件概率密度函数 (|),i p ωx i =1,2 已知,用来描述每一类中特征向量的分 布情况。如果类条件概率密度函数未知,则可以从可用的训练数据中估计出来。 1.2贝叶斯判别方法 贝叶斯分类规则描述为: 如果2(|)(|)P ωP ω>1x x ,则x ∈1ω 如果2(|)(|)P ωP ω<1x x ,则x ∈2ω (2-1-1) 贝叶斯分类规则就是看x ∈ω1的可能性大,还是x ∈2ω的可能性大。(|)i P ωx , i =1,2解释为当样本x 出现时,后验概率(|)P ω1x 和(|)P ω2x 的大小从而判别为属于 1ω或属于2ω类。 1.3三种概率的关系――――贝叶斯公式 ()() (|)= () i i i p |P P p ωωωx x x (2-1-3) 其中,()p x 是x 的概率密度函数(全概率密度),它等于所有可能的类概率密度函数乘以相应的先验概率之和。 ()(|)()i i i p p P ωω==∑2 1 x x 实验报告 一. 实验目的 1、 掌握密度函数监督参数估计方法; 2、 掌握贝叶斯最小错误概率分类器设计方法。 二.实验内容 对于一个两类分类问题,设两类的先验概率相同,(12()()P P ωω=),两类的类条件概率密度函数服从二维正态分布,即 11(|)~(,)P N ω1x μΣ2(|)~(,)P N ω22x μΣ 其中,=[3,6]T 1μ,0.50=02???? ?? 1Σ,=[3,-2]T 2μ,20=02??????2Σ。 1) 随机产生两类样本; 2) 设计最大似然估计算法对两类类条件概率密度函数进行估计; 3) 用2)中估计的类条件概率密度函数设计最小错误概率贝叶斯分类器,实现对两类样本的分类。 三.实验原理 最大似然估计 1. 作用 在已知试验结果(即是样本)的情况下,用来估计满足这些样本分布的参数,把可能性最大的那个参数θ作为真实* θ的参数估计。 2. 离散型 设X 为离散型随机变量, 12=(,,...,)k θθθθ为多维参数向量,如果随机变量 1,...,n X X 相互独立且概率计算式为 {}1(;,...) i i i k P x p x θθX ==,则可得概率函数为 {}1111,...,(;,...)n n n i k i P x x p x θθ=X =X ==∏,在 12=(,,...,)k θθθθ固定时,上式表示11,...,n n x x X =X =的概率;当 11,...,n n x x X =X =已知的时候,它又变成 12=(,,...,)k θθθθ的函数,可以把它记为12111(,,...,)(;,...,)n k k i L p x θθθθθ==∏,称此函数为似然函数。似然函数值的大小意味着该样本值出现的可能性的大小,既然已经得到了样本值 11,...,n n x x X =X =,那么它出现的可能性应该是较大的,即似然 函数的值也应该是比较大的,因而最大似然估计就是选择使12(,,...,) k L θθθ达到最 大值的那个θ作为真实* θ的估计。 3. 连续型 设X 为连续型随机变量,其概率密度函数为1(;,...) i k f x θθ, 1,...n x x 为从该总体中 抽出的样本,同样的如果 1,...n x x 相互独立且同分布,于是样本的联合概率密度为12111(,,...,)(;,...,) n k k i L f x θθθθθ==∏。大致过程同离散型一样。 最大后验概率判决准则 先验概率 1() P ω和 2() P ω,类条件概率密度 1(|) P X ω和 2(|) P X ω,根据贝叶斯公 式1 (|)() (|)(|)() i i i c j j j p x P P X p X P ωωωωω== ∑,当 12(|)(|) P P ωω>x x 则可以下结论,在x 条件 下,事件 1ω出现的可能性大,将x 判定为1ω类。 clc clear close all data=importdata('data.txt'); wholeData=data.data; %交叉验证选取训练集和测试集 cv=cvpartition(size(wholeData,1),'holdout',0.04);%0.04表明测试数据集占总数据集的比例 cvpartition(n,'holdout',p)创建一个随机分区,用于在n个观测值上进行保持验证。该分区将观察分为训练集和测试(或保持)集。参数p必须是标量,当0 if label{i,1}=='R' labelData(i,1)=1; elseif label{i,1}=='B' labelData(i,1)=2; else labelData(i,1)=3; end end trainLabel=labelData(training(cv),:); trainSampleNumber=size(trainLabel,1); testLabel=labelData(test(cv),:); %计算每个分类的样本的概率 labelProbability=tabulate(trainLabel); tabulate函数的功能是创建向量X信息数据频率表。其函数使用格式: tbl = tabulate(x) 创建的TBL(数据频率表)的结构:第一列:x的唯一值第二列:每个值的实例数量第三列:每个值的百分比 %P_yi,计算P(yi) P_y1=labelProbability(1,3)/100;(第一行,第三个元素) 朴素贝叶斯分类算法 一.贝叶斯分类的原理 贝叶斯分类器的分类原理是通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。也就是说,贝叶斯分类器是最小错误率意义上的优化。 贝叶斯分类器是用于分类的贝叶斯网络。该网络中应包含类结点C,其中C 的取值来自于类集合( c1 , c2 , ... , cm),还包含一组结点X = ( X1 , X2 , ... , Xn),表示用于分类的特征。对于贝叶斯网络分类器,若某一待分类的样本D,其分类特征值为x = ( x1 , x2 , ... , x n) ,则样本D 属于类别ci 的概率P( C = ci | X1 = x1 , X2 = x 2 , ... , Xn = x n) ,( i = 1 ,2 , ... , m) 应满足下式: P( C = ci | X = x) = Max{ P( C = c1 | X = x) , P( C = c2 | X = x ) , ... , P( C = cm | X = x ) } 贝叶斯公式: P( C = ci | X = x) = P( X = x | C = ci) * P( C = ci) / P( X = x) 其中,P( C = ci) 可由领域专家的经验得到,而P( X = x | C = ci) 和P( X = x) 的计算则较困难。 二.贝叶斯伪代码 整个算法可以分为两个部分,“建立模型”与“进行预测”,其建立模型的伪代码如下: numAttrValues 等简单的数据从本地数据结构中直接读取 构建几个关键的计数表 for(为每一个实例) { for( 每个属性 ){ 为 numClassAndAttr 中当前类,当前属性,当前取值的单元加 1 为 attFrequencies 中当前取值单元加 1 } } 预测的伪代码如下: for(每一个类别){ for(对每个属性 xj){ for(对每个属性 xi){ 实验报告 课程名称:模式识别 学院:电子通信与物理学院专业:电子信息工程 班级:电子信息工程2013-3姓名: 学号: 指导老师: 实验一Bayes 分类器设计 本实验旨在让同学对模式识别有一个初步的理解,能够根据自己的设计对贝叶斯决策理论算法有一个深刻地认识,理解二类分类器的设计原理。 1实验原理 最小风险贝叶斯决策可按下列步骤进行: (1)在已知)(i P ω,)(i X P ω,i=1,…,c 及给出待识别的X 的情况下,根据贝叶斯公式计算出后验概率: ∑==c j i i i i i P X P P X P X P 1)()() ()()(ωωωωω j=1,…,x (2)利用计算出的后验概率及决策表,按下面的公式计算出采取i a ,i=1,…,a 的条件风险 ∑==c j j j i i X P a X a R 1)(),()(ωωλ,i=1,2,…,a (3)对(2)中得到的a 个条件风险值)(X a R i ,i=1,…,a 进行比较,找出使其条件风险最小的决策k a ,即 则k a 就是最小风险贝叶斯决策。 2实验内容 假定某个局部区域细胞识别中正常(1ω)和非正常(2ω)两类先验概率分别为 正常状态:P (1ω)=; 异常状态:P (2ω)=。 现有一系列待观察的细胞,其观察值为x : 已知类条件概率密度曲线如下图: )|(1ωx p )|(2ωx p 类条件概率分布正态分布分别为(-2,)(2,4)试对观察的结果进行分类。 3 实验要求 1) 用matlab 完成分类器的设计,要求程序相应语句有说明文字。 2) 根据例子画出后验概率的分布曲线以及分类的结果示意图。 3) 如果是最小风险贝叶斯决策,决策表如下: 最小风险贝叶斯决策表: 请重新设计程序,画出相应的后验概率的分布曲线和分类结果,并比较两个结果。贝叶斯分类器的matlab实现

朴素贝叶斯分类算法及其MapReduce实现

朴素贝叶斯算法

大数据挖掘(8):朴素贝叶斯分类算法原理与实践

贝叶斯分类作业题

朴素贝叶斯python代码实现

Bayes分类器设计

朴素贝叶斯分类器

朴素贝叶斯分类器应用

朴素贝叶斯算法详细总结

简单分类器的MATLAB实现

贝叶斯决策理论的Matlab实现

模式识别作业--两类贝叶斯分类

贝叶斯分类器

朴素贝叶斯matlab实现

朴素贝叶斯分类算法代码实现

实验一Bayes分类器设计