随机森林中决策树棵数对性能的影响

%% I. 清空环境变量

clear all

clc

warning off

%% II. 导入数据

load data.mat

%%

% 1. 随机产生训练集/测试集

a = randperm(569);

Train = data(a(1:500),:);

Test = data(a(501:end),:);

%%

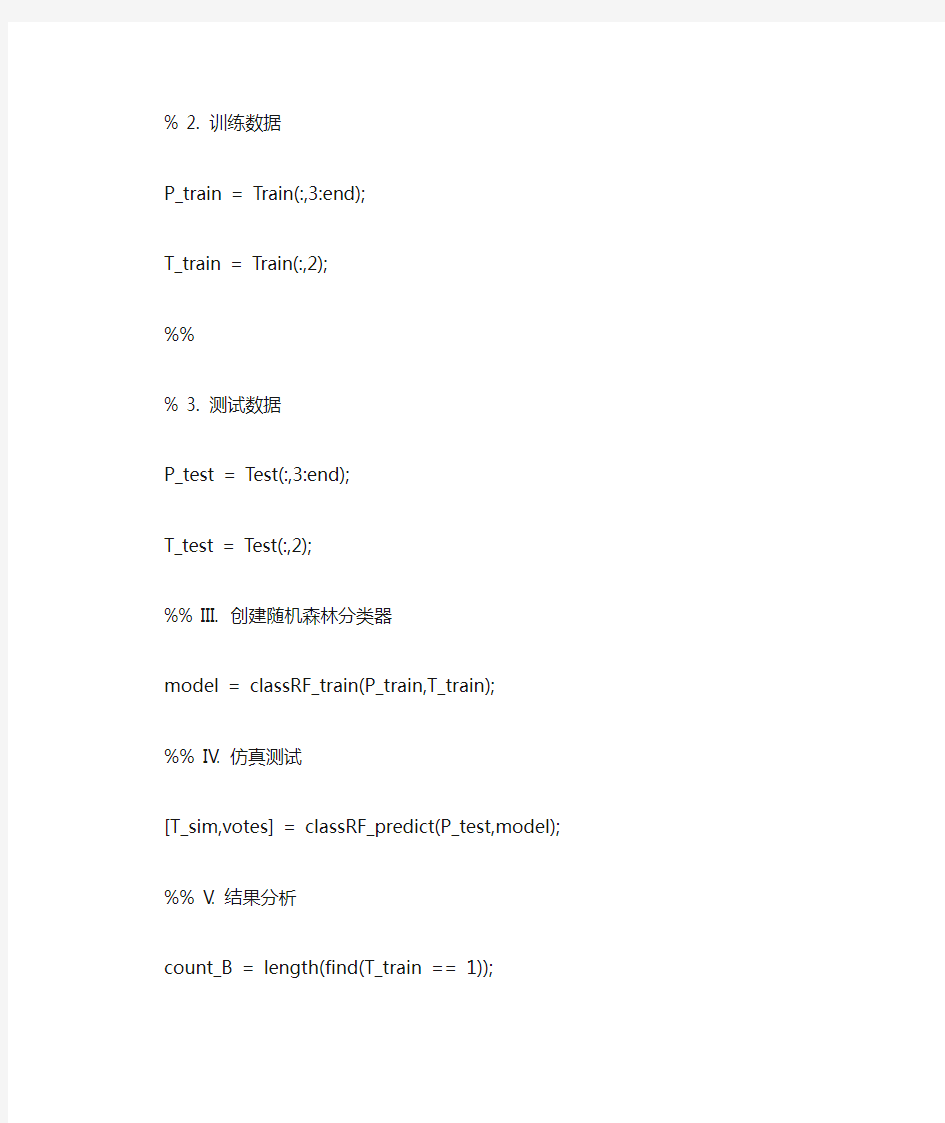

% 2. 训练数据

P_train = Train(:,3:end);

T_train = Train(:,2);

%%

% 3. 测试数据

P_test = Test(:,3:end);

T_test = Test(:,2);

%% III. 创建随机森林分类器

model = classRF_train(P_train,T_train);

%% IV. 仿真测试

[T_sim,votes] = classRF_predict(P_test,model);

%% V. 结果分析

count_B = length(find(T_train == 1));

count_M = length(find(T_train == 2));

total_B = length(find(data(:,2) == 1));

total_M = length(find(data(:,2) == 2)); number_B = length(find(T_test == 1)); number_M = length(find(T_test == 2));

number_B_sim = length(find(T_sim == 1 & T_test == 1));

number_M_sim = length(find(T_sim == 2 & T_test == 2));

disp(['病例总数:' num2str(569)...

' 良性:' num2str(total_B)...

' 恶性:' num2str(total_M)]);

disp(['训练集病例总数:' num2str(500)...

' 良性:' num2str(count_B)...

' 恶性:' num2str(count_M)]);

disp(['测试集病例总数:' num2str(69)...

' 良性:' num2str(number_B)...

' 恶性:' num2str(number_M)]);

disp(['良性乳腺肿瘤确诊:' num2str(number_B_sim)...

' 误诊:' num2str(number_B - number_B_sim)...

' 确诊率p1=' num2str(number_B_sim/number_B*100) '%']); disp(['恶性乳腺肿瘤确诊:' num2str(number_M_sim)...

' 误诊:' num2str(number_M - number_M_sim)...

' 确诊率p2=' num2str(number_M_sim/number_M*100) '%']);

%% VI. 绘图

figure

index = find(T_sim ~= T_test);

plot(votes(index,1),votes(index,2),'r*')

hold on

index = find(T_sim == T_test);

plot(votes(index,1),votes(index,2),'bo')

hold on

legend('错误分类样本','正确分类样本')

plot(0:500,500:-1:0,'r-.')

hold on

plot(0:500,0:500,'r-.')

hold on

line([100 400 400 100 100],[100 100 400 400 100])

xlabel('输出为类别1的决策树棵数')

ylabel('输出为类别2的决策树棵数')

title('随机森林分类器性能分析')

Accuracy = zeros(1,20);

for i = 50:50:1000 %模拟从50棵树到1000棵树的一个结果,每次增加50棵i

%每种情况,运行100次,取平均值

accuracy = zeros(1,100);

for k = 1:100

% 创建随机森林

model = classRF_train(P_train,T_train,i);

% 仿真测试

T_sim = classRF_predict(P_test,model);

accuracy(k) = length(find(T_sim == T_test)) / length(T_test);

end

Accuracy(i/50) = mean(accuracy);

end

%% 1960009019 l132********

% 1. 绘图

figure

plot(50:50:1000,Accuracy)

xlabel('随机森林中决策树棵数')

ylabel('分类正确率')

实验算法决策树和随机森林实验 【实验名称】 决策树和随机森林实验 【实验目的】 掌握决策树和随机森林实验模型应用过程,根据模型要求逬行数据预处理,建模,评价与应用; 【背景描述】 决策树与随机森林,属于监督学习,通过纯化指标的计算,确走分支方式,逐步构建成树形结构。决策树由节点(node )和有向边(directed edge )组成。节点的类型有两种:内部节点和叶子节点。具中,内部节点表示一个特征或属性的测试条件(用于分开具有不同特性的记录),叶子节点表示一个分类。 随机森林顾名思义,是用随机的方式建立一个森林,森林里面有很多的决策树组成,随机森林的每一棵决策树之间是没有关联的。在得到森林之后,当有一个新的输入样本逬入的时候,就让森林中的每一棵决策树分别进行一下判断,看看这个样本应该属于哪一类(对于分类算法),然后看看哪_类被选择最多,就预测这个样本为那一类。 【知识准备】 了解决策树与随机森林模型的使用场景,数据标准。了解Python/Spark数据处理一般方法。了解spark模型调用,训练以及应用方法 【实验要求】 完成决策树和随机森林实验 【实验设备】

Windows或Linux操作系统的计算机。部署Spark r Python r本实验提供centos6.8环境。【实验说明】 采用UCI机器学习库中的wine数据集作为算法数据,训练决策树与随机森林模型,对样本进行聚类。 【实验坏境】 Spark 23.1 r Pyrhon3.X ,实验在命令行pyspark中进行,或者把代码写在py脚本,由于本次为实验,以学习模型为主,所以在命令行中逐步执行代码,以便更加清晰地了解整个建模流程。【实验步骤】第一步:启动pyspark : 命令行中键入pyspark -master local[4],本地模式启动spark与python :

(收藏)决策树的作用与画法介绍? 导语: 决策树是一种在结构化决策过程中出现复杂分支时所使用的特定决策情况的树形图模型。它的每个内部节点都表示一个属性上的测试,每个分支代表一个属性某个值域上的测试输出,每个叶节点都存放在一种类别。决策树是使用分支方法来说明各种可能性,评判项目风险及可行性。 免费获取决策树软件:https://www.doczj.com/doc/699193274.html,/project/decisiontree/ 决策树符号 决策树通常包括决策节点,事件节点,结束等符号,如下图所示。图中所有的符号都是可以编辑的,用户可以根据自己的不同需求来改变符号的颜色,大小以及尺寸。

决策树的优点与缺点 优点:1.可读性好,具有描述性,易于人工理解与分析。 2. 效率高,一次创建可以反复使用。 3. 通过信息增益轻松处理不相关的属性, 缺点:1. 信息不是特别准确。 2. 决策容易受到法律问题和人为观点的影响。 亿图助你快速绘制决策树 第一步:新建空白页面 运行亿图软件,找到项目管理,通过双击模板页面下的决策树来打开一个空白页面。如果时间有限制的话,用户可以直接在例子页面选择合适的例子进行编辑以节省时间。

第二步:拖放符号 从右边符号库中拖放合适的决策树符号在空白页面上,并根据自己的需要调节符号的大小或颜色。 第三步:添加文本

用户有2种添加文本的方式。第一种是直接双击符号然后输入文本;第二种是ctrl+2打开一个文本框然后输入文本。 第四步:选择主题 导航到页面布局,从内置的主题中选择一个合适的主题让决策树显得更加专业和吸引人。 第五步:保存或导出决策树 回到文件页面,用户可以点击保存将决策树保存为默认的.eddx格式或者为了方便分享点击导出&发送将决策树导出为常见的文件格式。

决策树算法的原理与应用 发表时间:2019-02-18T17:17:08.530Z 来源:《科技新时代》2018年12期作者:曹逸知[导读] 在以后,分类问题也是伴随我们生活的主要问题之一,决策树算法也会在更多的领域发挥作用。江苏省宜兴中学江苏宜兴 214200 摘要:在机器学习与大数据飞速发展的21世纪,各种不同的算法成为了推动发展的基石.而作为十大经典算法之一的决策树算法是机器学习中十分重要的一种算法。本文对决策树算法的原理,发展历程以及在现实生活中的基本应用进行介绍,并突出说明了决策树算法所涉及的几种核心技术和几种具有代表性的算法模式。 关键词:机器学习算法决策树 1.决策树算法介绍 1.1算法原理简介 决策树模型是一种用于对数据集进行分类的树形结构。决策树类似于数据结构中的树型结构,主要是有节点和连接节点的边两种结构组成。节点又分为内部节点和叶节点。内部节点表示一个特征或属性, 叶节点表示一个类. 决策树(Decision Tree),又称为判定树, 是一种以树结构(包括二叉树和多叉树)形式表达的预测分析模型,决策树算法被评为十大经典机器学习算法之一[1]。 1.2 发展历程 决策树方法产生于上世纪中旬,到了1975年由J Ross Quinlan提出了ID3算法,作为第一种分类算法模型,在很多数据集上有不错的表现。随着ID3算法的不断发展,1993年J Ross Quinlan提出C4.5算法,算法对于缺失值补充、树型结构剪枝等方面作了较大改进,使得算法能够更好的处理分类和回归问题。决策树算法的发展同时也离不开信息论研究的深入,香农提出的信息熵概念,为ID3算法的核心,信息增益奠定了基础。1984年,Breiman提出了分类回归树算法,使用Gini系数代替了信息熵,并且利用数据来对树模型不断进行优化[2]。2.决策树算法的核心 2.1数据增益 香农在信息论方面的研究,提出了以信息熵来表示事情的不确定性。在数据均匀分布的情况下,熵越大代表事物的越不确定。在ID3算法中,使用信息熵作为判断依据,在建树的过程中,选定某个特征对数据集进行分类后,数据集分类前后信息熵的变化就叫作信息增益,如果使用多个特征对数据集分别进行分类时,信息增益可以衡量特征是否有利于算法对数据集进行分类,从而选择最优的分类方式建树。如果一个随机变量X的可以取值为Xi(i=1…n),那么对于变量X来说,它的熵就是

随机森林中决策树棵数对性能的影响 %% I. 清空环境变量 clear all clc warning off %% II. 导入数据 load data.mat %% % 1. 随机产生训练集/测试集 a = randperm(569); Train = data(a(1:500),:); Test = data(a(501:end),:); %% % 2. 训练数据 P_train = Train(:,3:end); T_train = Train(:,2);

%% % 3. 测试数据 P_test = Test(:,3:end); T_test = Test(:,2); %% III. 创建随机森林分类器 model = classRF_train(P_train,T_train); %% IV. 仿真测试 [T_sim,votes] = classRF_predict(P_test,model); %% V. 结果分析 count_B = length(find(T_train == 1)); count_M = length(find(T_train == 2)); total_B = length(find(data(:,2) == 1)); total_M = length(find(data(:,2) == 2)); number_B = length(find(T_test == 1)); number_M = length(find(T_test == 2));

number_B_sim = length(find(T_sim == 1 & T_test == 1)); number_M_sim = length(find(T_sim == 2 & T_test == 2)); disp(['病例总数:' num2str(569)... ' 良性:' num2str(total_B)... ' 恶性:' num2str(total_M)]); disp(['训练集病例总数:' num2str(500)... ' 良性:' num2str(count_B)... ' 恶性:' num2str(count_M)]); disp(['测试集病例总数:' num2str(69)... ' 良性:' num2str(number_B)... ' 恶性:' num2str(number_M)]); disp(['良性乳腺肿瘤确诊:' num2str(number_B_sim)... ' 误诊:' num2str(number_B - number_B_sim)... ' 确诊率p1=' num2str(number_B_sim/number_B*100) '%']); disp(['恶性乳腺肿瘤确诊:' num2str(number_M_sim)... ' 误诊:' num2str(number_M - number_M_sim)... ' 确诊率p2=' num2str(number_M_sim/number_M*100) '%']); %% VI. 绘图 figure index = find(T_sim ~= T_test);

厉害了,决策树还可以这么画? 导语: 决策树是一种在结构化决策过程中出现复杂分支时所使用的特定决策情况的树形图模型。它的每个内部节点都表示一个属性上的测试,每个分支代表一个属性某个值域上的测试输出,每个叶节点都存放在一种类别。决策树是使用分支方法来说明各种可能性,评判项目风险及可行性。 免费获取决策树软件:https://www.doczj.com/doc/699193274.html,/project/decisiontree/ 决策树符号 决策树通常包括决策节点,事件节点,结束等符号,如下图所示。图中所有的符号都是可以编辑的,用户可以根据自己的不同需求来改变符号的颜色,大小以及尺寸。

决策树的优点与缺点 优点:1.可读性好,具有描述性,易于人工理解与分析。 2. 效率高,一次创建可以反复使用。 3. 通过信息增益轻松处理不相关的属性, 缺点:1. 信息不是特别准确。 2. 决策容易受到法律问题和人为观点的影响。 亿图助你快速绘制决策树 第一步:新建空白页面 运行亿图软件,找到项目管理,通过双击模板页面下的决策树来打开一个空白页面。如果时间有限制的话,用户可以直接在例子页面选择合适的例子进行编辑以节省时间。

第二步:拖放符号 从右边符号库中拖放合适的决策树符号在空白页面上,并根据自己的需要调节符号的大小或颜色。 第三步:添加文本

用户有2种添加文本的方式。第一种是直接双击符号然后输入文本;第二种是ctrl+2打开一个文本框然后输入文本。 第四步:选择主题 导航到页面布局,从内置的主题中选择一个合适的主题让决策树显得更加专业和吸引人。 第五步:保存或导出决策树 回到文件页面,用户可以点击保存将决策树保存为默认的.eddx格式或者为了方便分享点击导出&发送将决策树导出为常见的文件格式。

随机森林模型在生存分析中的应用 【摘要】目的:本文探讨随机森林方法用于高维度、强相关、小样本的生 存资料分析时,可以起到变量筛选的作用。方法:以乳腺癌数据集构建乳腺癌转 移风险评估模型为实例进行实证分析, 使用随机森林模型进行变量选择,然后拟 合cox 回归模型。 结果:随机森林模型通过对变量的选择,有效的解决数据维 度高且强相关的情况,得到了较高的 AUC 值。 一、数据说明 该乳腺癌数据集来自于NCBI ,有77个观测值以及22286个基因变量。通过 筛选选取454个基因变量。将数据随机分为训练集合测试集,其中2/3为训练集, 1/3为测试集。绘制K-M 曲线图: 二、随机森林模型 随机森林由许多的决策树组成,因为这些决策树的形成采用了随机的方法, 因此也叫做随机决策树。随机森林中的树之间是没有关联的。当测试数据进入随 机森林时,其实就是让每一颗决策树进行分类,最后取所有决策树中分类结果最 多的那类为最终的结果。因此随机森林是一个包含多个决策树的分类器, 并且其 输出的类别是由个别树输出的类别的众数而定 使用randomForestSRC 包得到的随机森林模型具有以下性质: Kaplan-Meker estlmaie wHh 95% conndence bounds S ?2 S

Number of deaths: 27 Number of trees: 800 Mini mum term inal node size: 3 Average no. of term inal no des: 14.4275 No. of variables tried at each split: 3 Total no. of variables: 452 Analysis: RSF Family: surv Splitting rule: logrank Error rate: 19.87% 发现直接使用随机森林得到的模型,预测误差很大,达到了19.8%进一步考虑使用随机森林模型进行变量选择,结果如下: > our.rf$rfsrc.refit.obj Sample size: 52 Number of deaths: 19 Number of trees: 500 Minimum terminal node size: 2 Average no. of term inal no des: 11.554 No. of variables tried at each split: 3 Total no. of variables: 9 Analysis: RSF Family: surv Splitting rule: logrank *random* Number of random split points: 10 Error rate: 11.4% > our.rf$topvars [1] "213821_s_at" "219778_at" "204690_at" "220788_s_at" "202202_s_at" [6] "211603_s_at" "213055_at" "219336_s_at" "37892_at" 一共选取了9个变量,同时误差只有11.4% 接下来,使用这些变量做cox回归,剔除模型中不显著(>0.01 )的变量,最终 参与模型建立的变量共有4个。模型结果如下: exp(coef) exp(-coef) lower .95 upper .95 '218150_at' 1.6541 0.6046 0.11086 24.6800 '200914_x_at' 0.9915 1.0086 0.34094 2.8833 '220788_s_at' 0.2649 3.7750 0.05944 1.1805 '201398_s_at' 1.7457 0.5729 0.33109 9.2038 '201719 s at' 2.4708 0.4047 0.93808 6.5081

决策树归纳 关键词:分类,归纳,决策树,信息理论,知识获取,专家系统 摘要:通过实例的归纳推理构建基于知识的系统的技术已经在若干实际应用中成功地证明。本文总结了合成在各种系统中使用的决策树的方法,并且详细描述了一个这样的系统ID3。最近研究的结果显示可以修改该方法以处理嘈杂和/或不完整的信息的方式。讨论了报告的基本算法的缺点,并且比较了克服它的两种手段。本文结束了当前研究方向的插图。 1.介绍 由于人工智能首先在1950年代中期被认可为一门学科,机器学习已成为一个中心研究领域。可以给出这个突出的两个原因。学习的能力是智能行为的标志,所以任何将智力理解为现象的尝试都必须包括对学习的理解。更具体地,学习提供了构建高性能系统的潜在方法。 学习研究由不同的子领域组成。在一个极端,有自适应系统监视自己的性能,并尝试通过调整内部参数来改善它。这种方法,大部分早期学习工作的特点,产生了自我完善的游戏程序(Samuel,1967),平衡杆(Michie,1982),解决问题(Quinlan,1969)和许多其他领域。一个完全不同的方法认为学习是以概念形式获取结构化知识(Hunt,1962; Winston,1975),?歧视网(Feigenbaum和Simon,1963)或生产规则(Buchanan,1978)。 后一种机器学习的实际重要性已经被低估了,由基于知识的专家系统的出现。正如他们的名字所暗示的,这些系统由显式地表示而不是在算法中隐含的知识提供动力。驱动开拓性专家系统所需的知识通过领域专家和知识工程师之间的长期互动来编写。虽然通过该方法的典型的知识解释速率是每人每天的几个规则,但是用于复杂任务的专家系统可能需要数百或甚至数千个这样的规则。很明显,知识获取的面试方法不能跟上对专家系统的迅速增长的需求; Feigen-baum(1981)认为这是“瓶颈问题”。这种观点刺激了机器学习方法作为一种解释知识的手段的研究(Michie,1983)。 本文集中在一个微观的机器学习和一系列的学习系统,已被用来建立一个简单的类型的知识为基础的系统。第2节概述了这个家庭的

一、RF原理解释: 首先,从给定的训练集通过多次随机的可重复的采样得到多个bootstrap 数据集。接着,对每个 bootstrap 数据集构造一棵决策树,构造是通过迭代的将数据点分到左右两个子集中实现的,这个分割过程是一个搜 索分割函数的参数空间以寻求最大信息增量意义下最佳参数的过程。然后,在每个叶节点处通过统计训练 集中达到此叶节点的分类标签的直方图经验的估计此叶节点上的类分布。这样的迭代训练过程一直执行到 用户设定的最大树深度(随机森林提出者Breiman采用的是 ntree=500 )或者直到不能通过继续分割获取更 大的信息增益为止,网上的代码中作者都是对树的最大深度设置了最大值。 二、函数,参数的中文解释 function model = classRF_train(X,Y,ntree,mtry, extra_options) 随机森林中模型的训练 X, 表示输入的数据矩阵 Y 输出 Ntree 设置的树的数目 Mtry 的默认值为 floor(sqrt(size(X,2)) ,表示不超过矩阵X列数的二次开根值的整数。 extra_options 包含很多控制RF的项 取值为 1或0,默认值为1,表示是否做变量替换 表示预先知道的类,函数首先得到一个升序排列的标签然后给先前的类 同样的排序。 只在分类器中使用的一个向量,长度等于类的数目。对类的观察值是取 对cutoff 投票占的的最大比例的一个。 用于分层抽样 样本的长度 表示终端节点的最小值,这个参数设置得越大会使更小的树生长,耗 时更少。 判断是否需要对预测器的importance 进行评估 决定是否对casewise 的重要性度量进行计算 判别是否计算行之间的距离 判断是否计算out-of-bag 如果设定为TRUE,当随机森林运行的时候输出更多冗长的数据。如果 设置为一些整数,输出每个追踪树。 通过树的数目矩阵跟踪每个样本在树上的in-bag 。 norm_votes 统计每一类的投票数 importance 对于分类器来说是一个列数等于类别数加二,第一列计算精度下降值。在ncalss+1列表示所有类平均精度减少值。最后一列表示Gini 指数平均减小值。在随机森林用于回归的应用 中importance 表示的含义又不一样,我们只用到分类的作用,所以对回归的含义不做介绍。importanceSD 标准差 localImp 包含importance 标准化残差测量值的矩阵 ntree 生长的树的数目 mtry 在每一个分裂节点处样本预测器的个数。 Votes 一个矩阵,行表示每一个输入数据点,列表示每一类,记录投票数。 Proximity 如果proximity=TRUE 表示随机森林被调用。

C45决策树工具使用说明 1. 简介: 本文档给出了有关C45决策树方法相关的一些资料,面向对象是研究人员。本文档的内容安排如下: 1. C45决策树方法的使用场合描述; 2. C45决策树如何训练,即C45_VC.exe使用说明; 3. C45决策树训练结果如何在代码中使用,即CAskC45编程说明; 4. C45的外围工具简介; 5. C45的原理说明; 6.联系方式。 2. 适合用C45解决的问题 C45是一种决策树的算法,可以理解为数据挖掘算法的一种。从大规模的数据中挖掘规律,这里的大规模数据一般是用属性来描述,属性本身可以是连续量,如语音数据的基频值;也可以使离散量,如句子中词的个数;还可以使枚举量,如26个词类,声韵母类型等。属性分为输入属性,和结论属性(或称决策属性)。结论属性就是我们希望从输入属性中得到的结果,如希望从输入的词性序列中预测某个位置是不是L3边界,或者根据前后的音调、基频等预测当前的音节应该是哪一类的韵律曲线。结论属性必须是枚举量(当然包括布尔量)。而规律则以决策树的形式来表示,其形式如,在C45_VC.txt或者Screen.txt中可以看到类似的输出结果: Decision Tree: e_lv <= 47.6 : 如果e_lv属性值小于等于47.6的话 | n_lv <= 45.8 : NeiWen (76.0/2.0) 如果n_lv值小于等于45.8,结论属性应该是NewiWen。| n_lv > 45.8 : NeiBuWen (44.0) 如果n_lv值大于45.8,结论属性应该是NewiBuWen。e_lv > 47.6 : 如果e_lv属性值大于47.6的话 | n_lv <= 45.8 : WaiWen (147.0) … | n_lv > 45.8 : WaiBuWen (32.0) … 注:n_lv <= 45.8 : NeiWen (76.0/2.0)中的76.0表示到这个决策分支的有76个例子,其中2.0是错误的例子数目。这里有可能出现小数,这是决策树根据概率计算过程中可能将一个例子划分到多个子分支,每个分支算是(0.几)个事例到此。 这里同时给出关于使用C45决策树方法的一些注意事项: 1) C45是狂揉的,只要你给它输入属性和输出属性,即使输出和输入之间没有任何关系,决策树一样可以给出很不错的决策正确率,尤其是集内测试正确率。 2)要避免上述问题,两个方面重要:(1)集外测试,集内测试不说明问题。集外测试也要有一定的数目,这样才可以得到比较可信的测试结果。(2)输入数据量,理论上训练例子的个数应该是所有属性空间大小的10倍。属性空间大小计算为:每个属性可能的取值的种类数的连乘积。比如输入属性是3个词类,而每个词类可能有32种可能,则理论上需要的训练例子数为:32×32×32=32768个。当然考虑到有些词类组合不可能出现,所需训练例子数可以筹减。 3)理论上,C45能自动排除那些不相关的属性,但是在训练数据稀疏的情况下,决策树一样会利用那些不相关的属性,得到一些结论。所以不能一咕脑儿把所有的属性扔给决策树,还是需要对输入属性与输出属性之间有没有关联进行仔细的分析。 4)决策树的结论属性不宜太多。超过20就是很不好了,因为决策树认为结论属性完全是枚举类型的,结论属性之间的各个可能的取值没有任何关系,如果问题中结论属性有一定的

决策树法(Decision Tree) 决策树(decision tree)一般都是自上而下的来生成的。每个决策或事件(即自然状态)都可能引出两个或多个事件,导致不同的结果,把这种决策分支画成图形很像一棵树的枝干,故称决策树。 决策树就是将决策过程各个阶段之间的结构绘制成一张箭线图,我们可以用下图来表示。 选择分割的方法有好几种,但是目的都是一致的:对目标类尝试进行最佳的分割。 从根到叶子节点都有一条路径,这条路径就是一条“规则”。 决策树可以是二叉的,也可以是多叉的。 对每个节点的衡量: 1) 通过该节点的记录数 2) 如果是叶子节点的话,分类的路径 3) 对叶子节点正确分类的比例 有些规则的效果可以比其他的一些规则要好。 决策树的构成要素[1] 决策树的构成有四个要素:(1)决策结点;(2)方案枝;(3)状态结点;(4)概率枝。如图所示:

总之,决策树一般由方块结点、圆形结点、方案枝、概率枝等组成,方块结点称为决策结点,由结点引出若干条细支,每条细支代表一个方案,称为方案枝;圆形结点称为状态结点,由状态结点引出若干条细支,表示不同的自然状态,称为概率枝。每条概率枝代表一种自然状态。在每条细枝上标明客观状态的内容和其出现概率。在概率枝的最末稍标明该方案在该自然状态下所达到的结果(收益值或损失值)。这样树形图由左向右,由简到繁展开,组成一个树状网络图。 决策树对于常规统计方法的优缺点 优点: 1)可以生成可以理解的规则; 2)计算量相对来说不是很大; 3) 可以处理连续和种类字段; 4) 决策树可以清晰的显示哪些字段比较重要。 缺点: 1) 对连续性的字段比较难预测;

决策树算法: 什么是机器学习? 机器学习(Machine Learning) 是近20 多年兴起的一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。机器学习理论主要是设计和分析一些让计算机可以自动学习的算法。机器学习算法是一类从数据中自动分析获得规律,并利用规律对未知数据进行预测的算法。机器学习在数据挖掘、计算机视觉、自然语言处理、生物特征识别、搜索引擎、医学诊断、检测信用卡欺诈、证券市场分析、DNA 序列测序、语言与手写识别、战略游戏与机器人运用等领域有着十分广泛的应用。它无疑是当前数据分析领域的一个热点内容。 决策树定义: 机器学习中决策树是一个预测模型;他代表的是对象属性与对象值之间的一种映射关系。树中每个节点表示某个对象,而每个分叉路径则代表的某个可能的属性值,而每个叶结点则对应从根节点到该叶节点所经历的路径所表示的对象的值。决策树仅有单一输出,若欲有复数输出,可以建立独立的决策树以处理不同输出。从数据产生决策树的机器学习技术叫做决策树学习, 通俗说就是决策树。 决策树模型 定义2.1(决策树)分类决策树模型是一种描述对实例进行分类的树形结构。决策树由结点(node)和有向边(directed edge)组成。 □——决策点,是对几种可能方案的选择,即最后选择的最佳方案。如果决策属于多级决策,则决策树的中间可以有多个决策点,以决策树根部的决策点为最终决策方案为最终决策方案。○——状态节点,代表备选方案的经济效果(期望值),通过各状态节点的经济效果的对比,按照一定的决策标准就可以选出最佳方案。由状态节点引出的分支称为概率枝, 概率枝的数目表示可能出现的自然状态数目每个分枝上要注明该状态出现的概率。 △——结果节点,将每个方案在各种自然状态下取得的损益值标注于结果节点的右端。

决策树算法的原理与应用 摘要:在机器学习与大数据飞速发展的21世纪,各种不同的算法成为了推动发 展的基石.而作为十大经典算法之一的决策树算法是机器学习中十分重要的一种算法。本文对决策树算法的原理,发展历程以及在现实生活中的基本应用进行介绍,并突出说明了决策树算法所涉及的几种核心技术和几种具有代表性的算法模式。 关键词:机器学习算法决策树 1.决策树算法介绍 1.1算法原理简介 决策树模型是一种用于对数据集进行分类的树形结构。决策树类似于数据结 构中的树型结构,主要是有节点和连接节点的边两种结构组成。节点又分为内部 节点和叶节点。内部节点表示一个特征或属性, 叶节点表示一个类. 决策树(Decision Tree),又称为判定树, 是一种以树结构(包括二叉树和多叉树)形式表达的 预测分析模型,决策树算法被评为十大经典机器学习算法之一[1]。 1.2 发展历程 决策树方法产生于上世纪中旬,到了1975年由J Ross Quinlan提出了ID3算法,作为第一种分类算法模型,在很多数据集上有不错的表现。随着ID3算法的 不断发展,1993年J Ross Quinlan提出C4.5算法,算法对于缺失值补充、树型结 构剪枝等方面作了较大改进,使得算法能够更好的处理分类和回归问题。决策树 算法的发展同时也离不开信息论研究的深入,香农提出的信息熵概念,为ID3算 法的核心,信息增益奠定了基础。1984年,Breiman提出了分类回归树算法,使 用Gini系数代替了信息熵,并且利用数据来对树模型不断进行优化[2]。 2.决策树算法的核心 2.1数据增益 香农在信息论方面的研究,提出了以信息熵来表示事情的不确定性。在数据 均匀分布的情况下,熵越大代表事物的越不确定。在ID3算法中,使用信息熵作 为判断依据,在建树的过程中,选定某个特征对数据集进行分类后,数据集分类 前后信息熵的变化就叫作信息增益,如果使用多个特征对数据集分别进行分类时,信息增益可以衡量特征是否有利于算法对数据集进行分类,从而选择最优的分类 方式建树。 如果一个随机变量X的可以取值为Xi(i=1…n),那么对于变量X来说,它 的熵就是 在得到基尼指数增益之后,选择基尼指数增益最大的特征来作为当前步骤的 分类依据,在之后的分类中重复迭代使用这一方法来实现模型的构造。 3. 决策树算法的优缺点 3.1决策树算法的优点[3] (1)计算速度快,算法简单,分类依据清晰 (2)在处理数据时,有很高的准确度,同时分类结果清晰,步骤明朗。 (3)可以处理连续和种类字段 (4)适合高维数据 3.2决策树算法的缺点 (1)决策树算法可以帮助使用者创建复杂的树,但是在训练的过程中,如

树模型 决策树:从根节点开始一步步走到叶子节点(决策) 所有的数据最终都会落到叶子节点,既可以做分类也可以做回归

树的组成 根节点:第一个选择点 非叶子节点与分支:中间过程叶子节点:最终的决策结果

决策树的训练与测试 训练阶段:从给定的训练集构造出来一棵树(从跟节点开始选择特征,如何进行特征切分) 测试阶段:根据构造出来的树模型从上到下去走一遍就好了 一旦构造好了决策树,那么分类或者预测任务就很简单了,只需要走一遍就可以了,那么难点就在于如何构造出来一颗树,这就没那么容易了,需要考虑的问题还有很多的!

如何切分特征(选择节点) 问题:根节点的选择该用哪个特征呢?接下来呢?如何切分呢? 想象一下:我们的目标应该是根节点就像一个老大似的能更好的切分数据(分类的效果更好),根节点下面的节点自然就是二当家了。 目标:通过一种衡量标准,来计算通过不同特征进行分支选择后的分类情况,找出来最好的那个当成根节点,以此类推。

衡量标准-熵 熵:熵是表示随机变量不确定性的度量 (解释:说白了就是物体内部的混乱程度,比如杂货市场里面什么都有那肯定混乱呀,专卖店里面只卖一个牌子的那就稳定多啦) 公式:H(X)=-∑ pi * logpi, i=1,2, ... , n 一个栗子:A集合[1,1,1,1,1,1,1,1,2,2] B集合[1,2,3,4,5,6,7,8,9,1] 显然A集合的熵值要低,因为A里面只有两种类别,相对稳定一些 而B中类别太多了,熵值就会大很多。(在分类任务中我们希望通过节点分支后数据类别的熵值大还是小呢?)

衡量标准-熵 熵:不确定性越大,得到的熵值也就越大 当p=0或p=1时,H(p)=0,随机变量完全没有不确定性当p=0.5时,H(p)=1,此时随机变量的不确定性最大 如何决策一个节点的选择呢? 信息增益:表示特征X使得类Y的不确定性减少的程度。(分类后的专一性,希望分类后的结果是同类在一起)

项目管理实战利器之八——决策树分析和EMV 作者: 楼政 一、决策者的工具包 “决策就是从多种方案中选择一个行动方针的认知过程。每一个决策过程都会产生一个最终选择。”这是在维基百科所阐述的。但它没有说的是,有些决策必须为未来发生的结果而做出。有数种工具可以用来帮助做出复杂的决策,即决策树分析和预期货币价值。 二、预期货币价值(EMV,Expected Monetary Value) EMV是一种对概率和各种可能情景影响所做的平衡。以下两种方案,哪一种会提供更大的潜在收益呢? 方案1 最好的情景(Best case):盈利$180,000的概率为20%。 BC=20%*$180,000=$3 6,000 最坏的情景(Worst case):损失- $20,000的概率为 15%。 WC= 15%*(- $ 20,000)=-$3,000 最可能的情景(Most likely case):盈利$75,000元 的概率为65%。 MLC= 65%*$75,000 = $48,750 Total EMV = BC+WC+MLC = $36,000+(-$3,000)+$48,750=$81,750 方案2 最好的情景(Best case):盈利$200,000的概率为15%。BC=15%*$200,000=$30,00 最坏的情景(Worst case):盈利$15,000的概率为25%。WC= 25%*$15,000 = $ 3,750 最可能的情景(Most likely case):盈利$45,000元的概 率为60%。 MLC= 60%*$ 45,000 = $ 27,000 Total EMV = BC+WC+MLC = $30,000+$3,750+$27,000=$60,750 你选择哪种方案?当然选方案一,因为它具有更高的EMV为$81,750。 三、决策树分析(Decision Tree Analysis) 在决策树分析中,一个问题被描述为一个图表,这个图表显示了所有可能行动、事件和回报(成果),在一段时期内不同的时间点对上述内容必须作出的选择。 制造业的一个实例

如何画决策树? 导语: 决策树是一种在结构化决策过程中出现复杂分支时所使用的特定决策情况的树形图模型。它的每个内部节点都表示一个属性上的测试,每个分支代表一个属性某个值域上的测试输出,每个叶节点都存放在一种类别。决策树是使用分支方法来说明各种可能性,评判项目风险及可行性。 免费获取决策树软件:https://www.doczj.com/doc/699193274.html,/project/decisiontree/ 决策树符号 决策树通常包括决策节点,事件节点,结束等符号,如下图所示。图中所有的符号都是可以编辑的,用户可以根据自己的不同需求来改变符号的颜色,大小以及尺寸。

决策树的优点与缺点 优点:1.可读性好,具有描述性,易于人工理解与分析。 2. 效率高,一次创建可以反复使用。 3. 通过信息增益轻松处理不相关的属性, 缺点:1. 信息不是特别准确。 2. 决策容易受到法律问题和人为观点的影响。 亿图助你快速绘制决策树 第一步:新建空白页面 运行亿图软件,找到项目管理,通过双击模板页面下的决策树来打开一个空白页面。如果时间有限制的话,用户可以直接在例子页面选择合适的例子进行编辑以节省时间。

第二步:拖放符号 从右边符号库中拖放合适的决策树符号在空白页面上,并根据自己的需要调节符号的大小或颜色。 第三步:添加文本

用户有2种添加文本的方式。第一种是直接双击符号然后输入文本;第二种是ctrl+2打开一个文本框然后输入文本。 第四步:选择主题 导航到页面布局,从内置的主题中选择一个合适的主题让决策树显得更加专业和吸引人。 第五步:保存或导出决策树 回到文件页面,用户可以点击保存将决策树保存为默认的.eddx格式或者为了方便分享点击导出&发送将决策树导出为常见的文件格式。

决策树决策树研发二部

目录 1. 算法介绍 (1) 1.1. 分支节点选取 (1) 1.2. 构建树 (3) 1.3. 剪枝 (10) 2. sk-learn 中的使用 (12) 3. sk-learn中源码分析 (13)

1. 算法介绍 决策树算法是机器学习中的经典算法之一,既可以作为分类算法,也可以作 为回归算法。决策树算法又被发展出很多不同的版本,按照时间上分,目前主要包括,ID3、C4.5和CART版本算法。其中ID3版本的决策树算法是最早出现的,可以用来做分类算法。C4.5是针对ID3的不足出现的优化版本,也用来做分类。CART也是针对 ID3优化出现的,既可以做分类,可以做回归。 决策树算法的本质其实很类似我们的if-elseif-else语句,通过条件作为分支依据,最终的数学模型就是一颗树。不过在决策树算法中我们需要重点考虑选取分支条件的理由,以及谁先判断谁后判断,包括最后对过拟合的处理,也就是剪枝。这是我们之前写if语句时不会考虑的问题。 决策树算法主要分为以下3个步骤: 1. 分支节点选取 2. 构建树 3. 剪枝 1.1. 分支节点选取 分支节点选取,也就是寻找分支节点的最优解。既然要寻找最优,那么必须要有一个衡量标准,也就是需要量化这个优劣性。常用的衡量指标有熵和基尼系数。 熵:熵用来表示信息的混乱程度,值越大表示越混乱,包含的信息量也就越多。比如,A班有10个男生1个女生,B班有5个男生5个女生,那么B班的熵值就比A班大,也就是B班信息越混乱。 Entropy = -V p ” 基尼系数:同上,也可以作为信息混乱程度的衡量指标。 Gini = 1 - p: l-L

项目6 决策树和决策规则 6.1 实验目的 (1)掌握使用决策树进行分类决策的操作方法,并学会对结果进行解释、提取合理的分类规则; (2)理解决策树模型相对于其他预测模型(如神经网络)的优势所在,如它的决策模型可以为自然语言构成的规则或为逻辑陈述; (3)了解较为流行的决策树模型的不同特征,如CHAID和CART; (4)了解决策树模型中的替代规则对于处理缺失值的优势,掌握操作方法; (5)学会使用决策树模型进行变量选择。 6.2 实验原理 数据库内容丰富,蕴藏大量信息,可以用来作出智能的决策。分类和预测是数据分析的两种形式,可以用来提取描述重要数据类的模型或预测未来的数据趋势。分类是预测分类标号,而预测建立连续值函数模型。在本章中,我们将学习利用决策树进行数据分类的技术。 决策树是一个类似于流程图的树结构,其中每个内部节点表示在一个属性上的测试,每个分枝代表一个测试输出,而每个树叶节点代表类或类分布。树的最顶层节点是根节点。有些决策树算法只产生二叉树,而另一些决策树算法可以产生非二叉树。 对于一个需要进行分类的数据,我们可以利用该数据的各个属性的值,在决策树的包括根节点在内的节点上对相应的数据的属性进行测试,这样就形成了一条由顶到底的或从根节点到某个叶子节点的路径。该数据所到达的叶子节点给出了该数据所应归属的类。 决策树容易转换成为分类规则。我们可以根据需要分类的数据在决策树中所经过的所有可能的路径得到一组分类规则,并利用分类规则对数据进行分类。 决策树的构造不需要任何领域知识或参数设置,因此适合于探测式知识发现。决策树可以处理高维数据。获取的知识用树的形式表示是直观的,并且容易理解。 决策树建立时,许多分枝可能反映的是训练数据中的噪声或离群点。树剪枝试图识别并剪去这种分枝,以提高对未知数据分类的准确性。 6.2.1 决策树归纳 目前比较有名的决策树算法大概有上百种,其中,最有影响的当属ID3、C4.5、C5.0,

随机森林与支持向量机分类性能比较 黄衍,查伟雄 (华东交通大学交通运输与经济研究所,南昌 330013) 摘要:随机森林是一种性能优越的分类器。为了使国内学者更深入地了解其性能,通过将其与已在国内得到广泛应用的支持向量机进行数据实验比较,客观地展示其分类性能。实验选取了20个UCI数据集,从泛化能力、噪声鲁棒性和不平衡分类三个主要方面进行,得到的结论可为研究者选择和使用分类器提供有价值的参考。 关键词:随机森林;支持向量机;分类 中图分类号:O235 文献标识码: A Comparison on Classification Performance between Random Forests and Support Vector Machine HUANG Yan, ZHA Weixiong (Institute of Transportation and Economics, East China Jiaotong University, Nanchang 330013, China)【Abstract】Random Forests is an excellent classifier. In order to make Chinese scholars fully understand its performance, this paper compared it with Support Vector Machine widely used in China by means of data experiments to objectively show its classification performance. The experiments, using 20 UCI data sets, were carried out from three main aspects: generalization, noise robustness and imbalanced data classification. Experimental results can provide references for classifiers’ choice and use. 【Key words】Random Forests; Support Vector Machine; classification 0 引言 分类是数据挖掘领域研究的主要问题之一,分类器作为解决问题的工具一直是研究的热点。常用的分类器有决策树、逻辑回归、贝叶斯、神经网络等,这些分类器都有各自的性能特点。本文研究的随机森林[1](Random Forests,RF)是由Breiman提出的一种基于CART 决策树的组合分类器。其优越的性能使其在国外的生物、医学、经济、管理等众多领域到了广泛的应用,而国内对其的研究和应用还比较少[2]。为了使国内学者对该方法有一个更深入的了解,本文将其与分类性能优越的支持向量机[3](Support Vector Machine,SVM)进行数据实验比较,客观地展示其分类性能。本文选取了UCI机器学习数据库[4]的20个数据集作为实验数据,通过大量的数据实验,从泛化能力、噪声鲁棒性和不平衡分类三个主要方面进行比较,为研究者选择和使用分类器提供有价值的参考。 1 分类器介绍 1.1 随机森林 随机森林作为一种组合分类器,其算法由以下三步实现: 1. 采用bootstrap抽样技术从原始数据集中抽取n tree个训练集,每个训练集的大小约为原始数据集的三分之二。 2. 为每一个bootstrap训练集分别建立分类回归树(Classification and Regression Tree,CART),共产生n tree棵决策树构成一片“森林”,这些决策树均不进行剪枝(unpruned)。在作者简介:黄衍(1986-),男,硕士研究生,主要研究方向:数据挖掘与统计分析。 通信联系人:查伟雄,男,博士,教授,主要研究方向:交通运输与经济统计分析。 E-mail: huangyan189@https://www.doczj.com/doc/699193274.html,.