用于图像分类的浅层结构深度学习方法Asma ElAdel?, Ridha Ejbali?, Mourad Zaied?and Chokri Ben Amar?

?REsearch Group in Intelligent Machines, National School of Engineers of sfax, B.P

1173, Sfax, Tunisia

Email: {asma.eladel, ridha ejbali, mourad.zaied and chokri.benamar}@https://www.doczj.com/doc/4c8622888.html,

摘要——本论文介绍了一种新的图像分类方案。该方案提出了一种用于深度学习的卷积神经网络(CNN):利用多分辨率分析法(MRA)计算每一张用于分类的图像在不同的抽象层次中输入层与隐层之间的连接权值。然后,利用Adaboost 算法选择出能代表每一类图像的最佳的特征和对应的权值。这些权值将作为隐层与输入层之间的连接权值,并且在测试阶段用于对所给的图像的分类。所提出的方法在不同的数据集上进行了测试,所获得的结果证明了该方法具有较好的效率和较快的速度。

关键词:多分辨率分析,Adaboost,深度学习,小波,图像分类

一、介绍

图像分类是计算机视角中最具挑战性的问题之一,特别是在类别数量巨大的情况下。有许多解决这个问题的方法,例如小波相关向量机(WRVM)[1],分别应用于不同类别对象上,以形成每个对象独立特征空间的独立主成分分析法[2],全局显著和局部差异相结合的不寻常特征编码法[3],以及用来学习可述性视觉词袋(BOW)表现的正则化矩阵分解法[4]。

另外一种最近提出的方法介绍了旨在学习图像层次表示的深度学习的方法。在这种方法中,为了理解数据的意义,图像可以看作是由一些非线性特征经过多层次的抽象而形成的。高层次的特征是从低层次特征中得到的,并以此形成层次化表示[5] [6] [7]。这类方法的基础是利用了机器学习的不同结构。

这种结构的其中一种是前馈结构,前馈结构中多层神经网络和卷积网络在图像分类[8] [9] [10] [11],目标识别[12],人脸识别[13]和语音识别[14]等分类任务中都取得了良好的效果。这些网络的设计,分类,自动推断和学习能力都引起了人们的注意。但是到目前为止,它们的训练仍然需要大量的计算,同时还要选择适当的方法以防止过拟合现象。另外一个不足是特征变换阶段的次数是随机确定的,也就是说网络层次的数量和大小影响了抽象过程的数量。而且,分类仅仅是在最后的抽象层上对特征进行选择而完成。

此外,我们还要知道每一个抽象层次中更多的重要细节(也即特征),以减少分类阶段的复杂性。

在此背景下,Y.Zou等人[15]通过模拟影像中的固定点提出了一种显著特征的深度学习方法。另外,Weston等人[16]提出一种用于图像分类的非线性半监督的嵌入算法,称为嵌入式卷积神经网(Embed CNN)。以及,Xu[17]创新地提出了一种称为空间金字塔深层神经网络(SPDNN)的半监督分类方法,这是基于一个新的深层结构集成神经网络和空间金字塔模型。

在本文中,我们得到了两个具体的成果:首先,我们提出了一种改进的前馈深层结构。我们称之为基于二元多分辨率分析的改进型前馈卷积神经网络[18] [19] [20]。这种方法在不同的抽象层次中使用快速小波变换(FWT)[21]。这一

成果的优点在于我们可以使用浅层结构(一个隐层)取代多层结构进行深度学习。此外,多分辨率分析法(MRA)可以让我们确切知道深度学习层次的必要数量。同时,由于对图像不同层次的抽象都是通过进行多分辨率分析法进行的,所以我们可以得到对应于各级的图像特征,这可以很好地帮助我们完成分类。第二个成果是利用Adaboost算法从不同层次的抽象中更重要的,能更好代表每一类图像的特征[22]。

所提出的方法能通过简单的结构实现卷积神经网络的优点,同时能减少计算的复杂度。

本文的结构如下:第二部分介绍了我们所提出的图像分类方法的核心思想,其中我们会重点介绍在不同层次抽象中的MRA特征提取法,特征选择和分类方法。第三部分是实验结果和讨论。最后一部分是结论。

二、所提出的方法

所提出的方法是一种用于图像分类的浅层结构深度学习方法。一般的深度学习方法是通过改变神经网络中层的数量和大小得到不同层次的抽象。分类仅仅是在最后一层抽象的特征上完成的。在这种结构中,我们不确定所提取的特征能不能代表图像所有有用的信息。

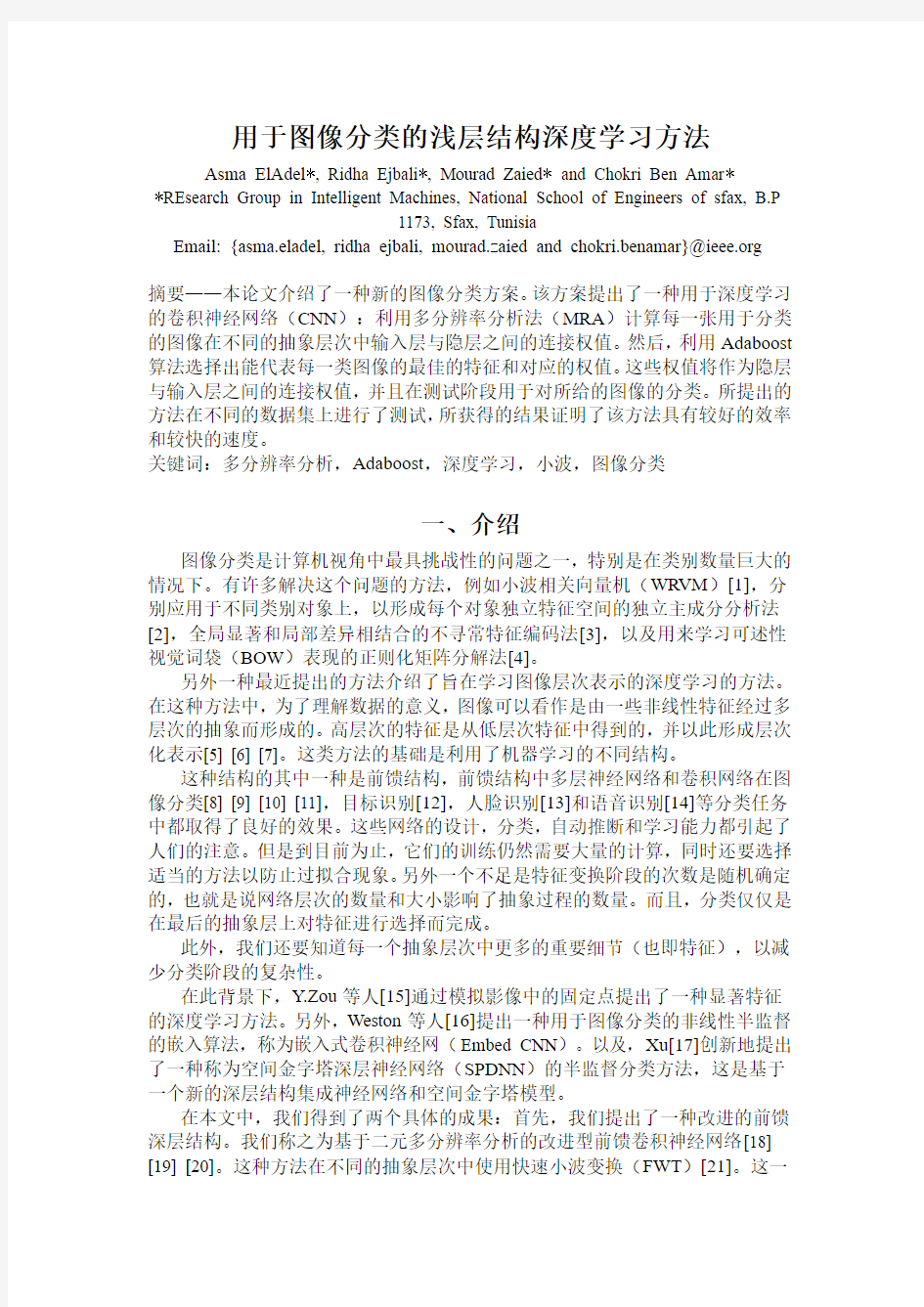

在本次实验中,我们提出了一种基于二元多分辨率分析法改进的前馈卷积神经网络。前馈意味着信息只能向前传递,从输入节点经过隐层节点到达输出节点。

所提出的基于MRA结构的主要优点是:第j层的特征可以转化为第j-1层的特征,或者直接使用j-1次二元小波代换后转化为第一层的特征。过程如图1所示。这种学习和分类的步骤将在A部分和B部分分别介绍。

图1

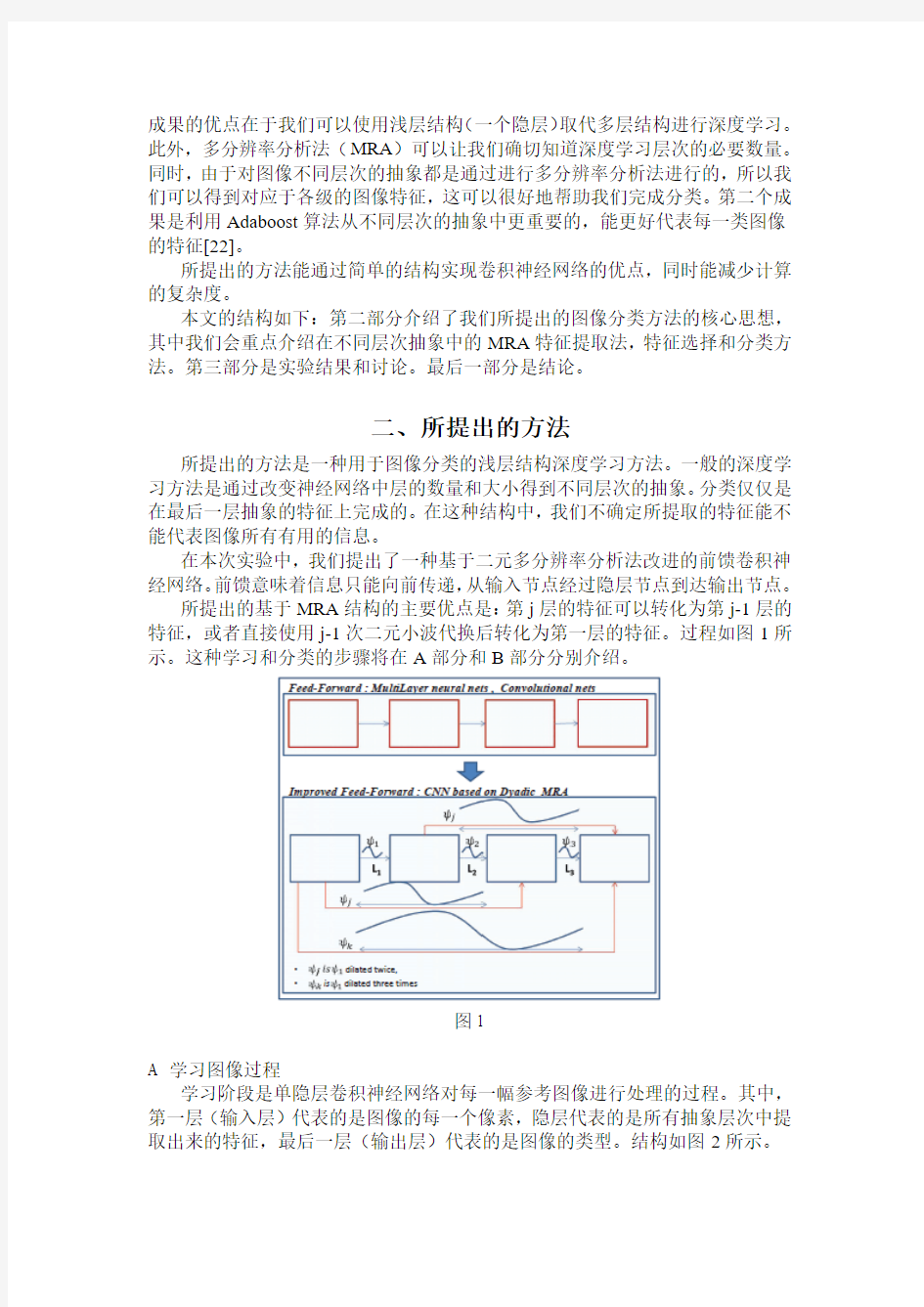

A 学习图像过程

学习阶段是单隐层卷积神经网络对每一幅参考图像进行处理的过程。其中,第一层(输入层)代表的是图像的每一个像素,隐层代表的是所有抽象层次中提取出来的特征,最后一层(输出层)代表的是图像的类型。结构如图2所示。

图2

学习算法步骤如下:

第一步:构建候选小波库

第二步:计算输入层与隐层之间所有的连接权值

第三步:利用二元多分辨率分析法计算不同层次抽象隐层所对应的的输入

a

i 第四步:把sigmoid函数作为激活函数

第五步:利用Adaboost算法选择能描述每一类图像特点的特征

第六步:确定每一类图像所对应的隐层与输出层之间的连接权值

从图3可知,经过多分辨率分析后,每一幅参考图像都被分成了k个层次的抽象特征,可以将其定义为离散小波变换的设计方法。这种方法把信号f(图像)分解为逼近部分(A)和三个细节部分:水平细节(HD)、垂直细节(VD)和对角线细节(DD)。在新的抽象层次中,得到的逼近部分将会被进一步分解为新的逼近部分和细节部分,如此循环直到抽象层次达到分析所要求的最大值。最

a作为输入层与隐层之间的连接权值。后,把从所有层次中提取出来的细节系数

i

为了加快计算出这些系数,我们使用多分辨率分析中的快速小波变换(FWT)。这一算法有效地减少了耗时的训练和分类步骤。

图3

此外,MRA 的优点在于分析的网络层次的数量不是随机的,而是可以直接从图像的尺寸中得到的。因此我们可以通过固定图像的抽象层次控制学习深度。同时,由于MRA 分析是在不同的抽象层次中分析图像,所以它可以提供各层次抽象中相应的能代表图像的特征,这在分类阶段将会十分有用。

一旦我们计算得出所有输入层与隐层的连接权值,也就是隐层的输入i a ,我们就采用取值在[0 1]的sigmoid 函数作为激活函数。下一步就是利用Adaboost 算法,从这些特征i a 中滤选出能描述每一类图像的最佳的特征。(见算法1)

算法1 Adaboost 算法

给定m 组训练数据,(1x ,1y ),……(m x ,m y ),其中

初始化)(1i D =1/m :训练样本i 的权重,这决定了该样本被选择为成分分类器的概率。

当t=1,...,T 时:

分类器i h :X →[-1 1],这将最大限度地减少分布t D 带来的误差:

如果j e <0.5继续,否则停止

选择t β∈R ,其中

,

t ε为分类器t h 的加权错误率

下一个分类器:

其中t Z 为归一化因子。(归一化的目的是使得1 t D 成为一个分布函数) 得到最后的分类器:

经过这个步骤后,我们得到了每一类图像的最佳的特征,即一个由特征(f ),

阈值(b )和一个极性(p )构成的弱分类器,其满足下式:

阈值β将作为隐层与输出层之间的连接权值以用来确定每一类的图像。

B 图像分类

要对用作分类的图像Y 进行分类,必须建立一个神经网络,其中该网络的隐层神经元连接权重是由能表示所有类别图像的所有特征构成的。然后,图像的类别将通过等式2确定。

图像的分类是根据最佳特征进行的,其相应阈值通过以下等式确定的:

H(Y)是图像分类的结果,t 是选择出来的最好的特征数量,h 代表对第k 个特征和阈值t β的训练分类器,其中阈值t β已经在学习阶段计算得到。如果H(Y)

等于1,这意味着用于分类的图像符合当前的类别。否则图像不符合当前类别并立即将其拒接。

所提出结构的优点在于,网络仅仅使用一个隐层就能够模拟所有代表图像类别的特征。

图4表示了具有3个选择特征的图像分类的例子,其中1y ...n y 代表待分类图像像素Y 。1β,25β,70β是经过Adaboost 算法选择出来的特征,在图中以蓝色

表示,它们能较好地表示第一类的图像。2β,68β,1000β是表示第二类图像的特

征,在图中以黄色表示,如此类推。可以看出,某些特征不止是一种类别图像的特征。例如图中1000β就是第二类和第四类的特征。这可以解释为这些类别中存在

相似或相同的部分。

图4

三、结果和讨论

我们利用两个数据库对所提出的方法进行测试,分别是Wang数据库和COIL-100数据库。

哥伦比亚大学目标图像库(COIL-100)数据库:包含了7200张128*128的彩色图像,这些图像被分成了100类目标,每一类目标包含的72张图像分别是对同一目标在360度范围内每隔5度拍摄得到的。

图5是COIL-100图像库所包含的一些目标图像,图6为COIL-100中某个目标类别的图像

图5

图6

Wang数据库:包含了10类共1000张,大小为256*384的不同的彩色图像。10个类别分别是:公共汽车,恐龙,花朵,非洲人,沙滩,建筑物,大象,马,山和食物。

图7

在实验中,我们将分别从这两个图像库中随机选取50%的图像作为训练集,剩下的50%图像作为测试集。因为MRA算法要求图像的大小为2的整数次幂,所以所有Wang图像库的图像将被调整为256*256大小。这就要求分析次数的最大值为6。这就是说并不需要达到最大的分析次数就能有最好的分类效果,因此,有时候一至两层分析就已经足够了,例如在大象,恐龙和马的分类上。但是,当两类图像具有相似的颜色时,系统将会难以判别,例如颜色相似的公交车和花朵,建筑物和沙滩。表1为Wang图像库分类的混淆矩阵。

表1

根据图像的大小和分析次数的多少,使用Adaboost算法能让我们减少特征的数量。对于COIL-100和Wang图像库每一类图像的特征数量分别为30和50。

分类正确率(CR),每一张图像分类时间(CT/QI)和特征数量(NSF)都在表2中列出:

为了衡量我们所提出方法的有效性,我们把该方法与其他方法进行了比较。从结果可以看出,所提出的方法(PA)十分有效,而且效果最好。(见表3)

表3

这个结果可以解释为我们在不同层次的抽象中都使用了MRA算法,这一方法很好地从每一张图像中提取出有用的,能代表图像细节的特征。

四、结论

在本文中,我们提出了一种改良的前馈型深度结构图像分类方法。该方法可总结为以下步骤:首先,我们利用基于多分辨率分析法的快速小波变换在不同层次的抽象中提取出图像的特征,其次,我们利用Adaboost算法选择出最好的特征并以此对相应的图像进行分类。从实验结果来看,分类效果十分理想,并且证明了所提出的基于多分辨率分析和Adaboost算法的简单深度学习神经网络结构的鲁棒性。在今后的工作中,我们将把模糊理论的概念应用到分类阶段当中,以提高分类的灵活性。

五、致谢

作者对突尼斯科学研究总方向(DGRST)中ARUB项目提供资金支持表示感谢。

六、参考文献

[1] A. Tolambiya, S. Venkatraman and P. K. Kalra, Content-based image classification with wavelet relevance vector machines,Soft Computing (Springer), January 2010, vol. 14, no. 2, pp 129-136.

[2] H. B. Kekre, T. K. Sarode and J. K. Save, Classification of Image Database Using Independent Principal Component Analysis,(IJACSA) International Journal of Advanced Computer Science and Applications, vol. 4, no.7, 2013.

[3] S. Chena, W. Shib and XiaoLv, Feature coding for image classification combining global saliency and local difference,Pattern Recognition Letters jornal, vol.51, pp 4449, 2014.

[4] Z. Lu and L. Wang, Learning Descriptive Visual Representation for Image Classification and Annotation, Pattern Recognition journal, vol. 48, no 2, pp 498508, 2015.

[5] J. Schmidhuber, Deep learning in neural networks: An overview, Neural Networks journal, vol. 61, pp. 85117, 2015.

[6] I. Mrazova and M. Kukacka, Can Deep Neural Networks Discover Meaningful Pattern Features?, Procedia Computer Science, vol. 12, pp. 194199, 2012.

[7] Y. LeCun, Deep Learning Tutorial, ICML, Atlanta, 2013.

[8] H. Li, H. Li, Y. Wei, Y. Tang and Q. Wang, Sparse-based Neural Response for Image Classification, Neurocomputing journal, vol. 144, no. 20 , pp. 198207, 2014. [9] A. Krizhevsky, I. Sutskever and G.E. Hinton, ImageNet classification with deep convolutional neural networks, In Advances in Neural Information Processing Systems 25 (NIPS2012), 2012.

[10] M.D. Zeiler and R. Fergus, Visualizing and Understanding Convolutional Neural Networks, arXiv preprint arXiv:1311.2901, 2013.

[11] J. Donahue, Y. Jia, O. Vinyals, J. Hoffman, N. Zhang, E. Tzeng, and T. Darrell, DeCAF: A Deep Convolutional Activation Feature for Generic Visual Recognition, arXiv e-prints, arXiv:1310.1531, 2013.

[12] A. Toshev, C. Szegedy and D. Erhan, Deep Neural Networks for Object Detection, In Advances in Neural Information Processing Systems, 2013.

[13] D. Timoshenko and V. Grishkin, Composite face detection method for automatic moderation of user avatars, Computer Science and Information Technologies (CSIT’

13), 2013.

[14] T. Sainath, B. Kingsbury, A. Mohamed, G. E. Dahl, G. Saon, H. Soltau, T. Beran,

A. Y. Aravkin, and

B.Ramabhadran, Improvements to deep convolutional neural networks for LVCSR, 2013.

[15] W. Y.Zou, S. Zhu, A. Y.Ng and K. Yu, Deep learning of invariant features via simulated fixations in video, In Advances in Neural Information Processing Systems, pp. 3212-3220, 2012.

[16] J. Weston, F. Ratle, H. Mobahi, and R. Collobert, Deep Learning via Semi-supervised Embedding, Neural Networks: Tricks of the Trade, Lecture Notes in Computer Science, vol. 7700, pp. 639-655, 2012.

[17] Q. Xu, S. Jiang, W. Huang, L. Duan and S. Xu, Multi-feature fusion based spatial pyramid deep neural networks image classification, Computer Modelling & New Technologies, vol.17 (5C), pp. 207-212, 2013.

[18] M.Zaied, C. Ben Amar and M. A. Alimi, Award a new wavelet based beta function,International Conference on Signal, System and Design, SSD03, Tunisia, pp. 185-191, 2003.

[19] A. ElAdel, M. Zaied, C. Ben Amar, Learning wavelet networks based on Multiresolution analysis: Application to images copy detection, International Conference on Communications, Computing and Control Applications (CCCA), pp. 1-6, 2011.

[20] M. Zaied, R. Mohamed, C. Ben Amar; A Power Tool for Content-Based Image Retrieval Using Multiresolution Wavelet Network Modelling and Dynamic Histograms, International Review on Computers and Software (I.RE.CO.S.), vol. 7, no. 4, pp. 1435-1444, July 2012.

[21] O. Jemai, M. Zaied, C. Ben Amar and A. M. Alimi, Fast Learning algorithm of wavelet network based on Fast Wavelet Transform, Int. J.Pattern Recognition and Artificial Intelligence, vol. 25, no.8, pp. 1297- 1319, 2011.

[22] M. Zhou, H. Wei, and S. Maybank , Gabor Wavelets and AdaBoost in Feature Selection for Face Verification, Applications of Computer Vision 2006 workshop in conjuction with ECCV 2006, pp. 101-109, Graz, Austria, 12 May 2006.

深度图像的二值化

————————————————————————————————作者: ————————————————————————————————日期:

3.2 深度图像二值化 图像二值化是图像处理中的一项基本技术,也是很多图像处理技术的预处理过程。在颗粒分析、模式识别技术、光学字符识别(OCR)、医学数据可视化中的切片配准等应用中,图像二值化是它们进行数据预处理的重要技术。由于图像二值化过程将会损失原图像的许多有用信息,因此在进行二值化预处理过程中,能否保留原图的主要特征非常关键。在不同的应用中,图像二值化时阈值的选择是不同的。因此,自适应图像阈值的选取方法非常值得研究。研究者对图像二值化方法进行了讨论,在此基础上提出了一个新的图像二值化算法。该算法基于数学形态学理论,较好地保留了图像二值化时原图的边缘特征。本文主要研究二值化及灰度图像二值化方法。 3.2.1.灰度图像与二值图像 数字图像是将连续的模拟图像经过离散化处理后得到的计算机能够辨识的点阵图像。在严格意义上讲,数字图像是经过等距离矩形网格采样,对幅度进行等间隔量化的二维函数。因此,数字图像实际上就是被量化的二维采样数组。一幅数字图像都是由若干个数据点组成的,每个数据点称为像素(pixel)。比如一幅256×400,就是指该图像是由水平方向上256列像素和垂直方向上400行像素组成的矩形图。每一个像素具有自己的属性,如颜色(color)、灰度(grayscale)等,颜色和灰度是决定一幅图像表现里的关键因素。数字图像又可分为彩色图像、灰度图像、二值图像。 3.2.1.1彩色图像 彩色图像是多光谱图像的一种特殊情况,对应于人类视觉的三基色即红(R)、绿(G)、蓝(B)三个波段,是对人眼的光谱量化性质的近似。彩色图像中的每个像素的颜色有R、G、B三个分量决定,而每个分量有255种值可取,这样一个像素点可以有1600多万的颜色的变化范围。而灰度图像是R、G、B三个分量相同的一种特殊的彩色图像,一个像素点的变化范围为255种。图1-1为彩色图像。

基于深度的图像修复实验报告

————————————————————————————————作者:————————————————————————————————日期: 2

基于深度的图像修复 一.实验目的 1、学会单幅图像的修补 2、学会结合彩色图像和深度图像的图像修补 二.实验原理 1图像修补简介----单幅图像修补 图像中常有缺失或者损坏的部分,即空白区域或者有误的区域。图像修补就是根据这些区域周围的信息完成对空白区域的填充,以实现图像的恢复。 基本方法 图像修补的基本方法示例

示例方法2 选取空白点周围的一片区域,对区域内的参考点进行加权求和,其结果用于对空白点的修补。若所选窗口太小,即窗口中无参考点,则将窗口扩大。 2图像修补简介----利用深度图的图像修补 1图像的前景与背景

实际场景中存在前景与背景的区别,前景会遮挡背景,而且前景与背景往往差距比较大。 2深度图 用于表示3D空间中的点与成像平面距离的灰度图。0~255表示,灰度值越大,表示场景距离成像平面越近,反之,灰度值越小,表示场景距离成像平面越远。 前景的灰度值大,背景的灰度值小。 如下左彩色图,右深度图 3普通的图像修补区分不了图像的前景和背景,简单的加权求和填补空白点的方法会导致前景和背景的混杂。引入深度图之后,可以利用深度图区分图像的前景和背景,在对背景进行修补的时候,可以利用深度图滤除那些前景参考点的影响,从而使背景的空白点只由背景点加权求和得到,前景亦然。

三.实验步骤 1读入一个像素点,判断其是否为空白点。 2若不是空白点,则跳过该点,判断下一个点。 3若该点是空白点,则用前面所述的方法进行加权修补。 4对图像中的每一个点都进行如此处理,直至全图处理完毕,则图像修补完成。 四.实验要求 1独立编码完成实验单幅图像修补利用深度图的图像修补。 2 比较实验结果的差别,并分析原因,完成实验报告。 五.用MATLAB编写实验代码 对于单幅图像以及结合深度图像的修补,其实区别就是是否考虑了深度图像的灰度权重(其实就是0和1),虽然效果图区别很小,但是通过深度图还是可以反映出其立体三维空间的。为了能较好的对比,我把两种方法的比较融合在一条件语句中,在下面的深度图像代码中用红色字体标注。同时深度图像变量用绿色字体标注。

用于图像分类的浅层结构深度学习方法Asma ElAdel?, Ridha Ejbali?, Mourad Zaied?and Chokri Ben Amar? ?REsearch Group in Intelligent Machines, National School of Engineers of sfax, B.P 1173, Sfax, Tunisia Email: {asma.eladel, ridha ejbali, mourad.zaied and chokri.benamar}@https://www.doczj.com/doc/4c8622888.html, 摘要——本论文介绍了一种新的图像分类方案。该方案提出了一种用于深度学习的卷积神经网络(CNN):利用多分辨率分析法(MRA)计算每一张用于分类的图像在不同的抽象层次中输入层与隐层之间的连接权值。然后,利用Adaboost 算法选择出能代表每一类图像的最佳的特征和对应的权值。这些权值将作为隐层与输入层之间的连接权值,并且在测试阶段用于对所给的图像的分类。所提出的方法在不同的数据集上进行了测试,所获得的结果证明了该方法具有较好的效率和较快的速度。 关键词:多分辨率分析,Adaboost,深度学习,小波,图像分类 一、介绍 图像分类是计算机视角中最具挑战性的问题之一,特别是在类别数量巨大的情况下。有许多解决这个问题的方法,例如小波相关向量机(WRVM)[1],分别应用于不同类别对象上,以形成每个对象独立特征空间的独立主成分分析法[2],全局显著和局部差异相结合的不寻常特征编码法[3],以及用来学习可述性视觉词袋(BOW)表现的正则化矩阵分解法[4]。 另外一种最近提出的方法介绍了旨在学习图像层次表示的深度学习的方法。在这种方法中,为了理解数据的意义,图像可以看作是由一些非线性特征经过多层次的抽象而形成的。高层次的特征是从低层次特征中得到的,并以此形成层次化表示[5] [6] [7]。这类方法的基础是利用了机器学习的不同结构。 这种结构的其中一种是前馈结构,前馈结构中多层神经网络和卷积网络在图像分类[8] [9] [10] [11],目标识别[12],人脸识别[13]和语音识别[14]等分类任务中都取得了良好的效果。这些网络的设计,分类,自动推断和学习能力都引起了人们的注意。但是到目前为止,它们的训练仍然需要大量的计算,同时还要选择适当的方法以防止过拟合现象。另外一个不足是特征变换阶段的次数是随机确定的,也就是说网络层次的数量和大小影响了抽象过程的数量。而且,分类仅仅是在最后的抽象层上对特征进行选择而完成。 此外,我们还要知道每一个抽象层次中更多的重要细节(也即特征),以减少分类阶段的复杂性。 在此背景下,Y.Zou等人[15]通过模拟影像中的固定点提出了一种显著特征的深度学习方法。另外,Weston等人[16]提出一种用于图像分类的非线性半监督的嵌入算法,称为嵌入式卷积神经网(Embed CNN)。以及,Xu[17]创新地提出了一种称为空间金字塔深层神经网络(SPDNN)的半监督分类方法,这是基于一个新的深层结构集成神经网络和空间金字塔模型。 在本文中,我们得到了两个具体的成果:首先,我们提出了一种改进的前馈深层结构。我们称之为基于二元多分辨率分析的改进型前馈卷积神经网络[18] [19] [20]。这种方法在不同的抽象层次中使用快速小波变换(FWT)[21]。这一

深度图像的平面分割算法 王恒1,赵亮 摘 要: 三维激光扫描系统使用深度图像来重建城市建筑模型,现有激光点云数据处理系统程序直接 进行海量点云数据建模较为困难。因为实际模型往往含有复杂表面几何特征,如果利用深度图像直接进 行拟合,则会造成建筑模型的数学表示和拟合算法处理的难度加大,甚至无法使用数学表达式描述三维 模型。 深度图像拟合或深度图像分割,是将具有相同几何特征的点云数据划分同一个区域并进行曲面拟合。深度图像分割主要有两种方法:一种是基于边缘分割的方法,另一种基于区域生长的方法。由于深度图像获取方式的特点,其点云数据往往不连续含有较多的噪声。使用基于边缘分割算法,仅当所处理点云数据具有连续性并且噪声点比较少的情况下,方能有效实现边界点分割。因此深度图像的分割方法也较多的集中在基于区域的分割方法。利用高斯曲率和平均曲率及方向将点附近的曲面类型分为8种,对数据点进行初步分类,从初步分类的点集中找一个合适的生长点,用二次多项式函数来进行区域生长,实现了深度图像数据的分块与曲面拟合。本文提出的算法利用了建筑物包含大量平面的特点,将分割问题具体到了平面分割,从而避免了低精度估计高斯曲率和复杂的二次曲面拟合,完成了一种高效简洁的算法用来识别深度图像的平面特征。该算法借鉴了数字图像处理方法首先平面拟合邻近n*n区域的点集,计算出邻域点集的协方差矩阵及其特征值和特征向量;如果绝对值最小特征值小于阈值,则可以认为该点的局部平面拟合成功;最小特征值对应的特征向量为局部法向量。接着从左到右沿扫描线遍历深度图像中的每个坐标点,按照聚类分析的原则对该点和其上方、右上方、右方的三个坐标点的法向量按照具有相同方向和同处一个平面的两个相似度准则进行比对,来获得两个局部平面是否同处一个平面。本文提出的算法将深度图像分割成为若干个集合,每个集合的任意点都同处一个平面。本文根据深度图像的数据特征给出了合理高效的数据结构和算法,并以图例说明深度图像平面分割算法的有效性。 关键词:点云数据;深度图像;平面分割

基于深度图像技术的手势识别方法 曹雏清,李瑞峰,赵立军 (哈尔滨工业大学机器人技术与系统国家重点实验室,哈尔滨 150001) 摘 要:针对复杂环境下的手势识别问题,提出一种基于深度图像技术的手势识别方法。利用深度图像信息从复杂环境中提取手势区域,综合手势的表观特征,建立决策树实现手势的识别。对常见的9种手势在复杂背景条件下进行测试,实验结果表明,手势的平均识别率可达到98.4%,速度达到每秒25帧。 关键词:手势识别;深度图像;表观特征;复杂背景;决策树 Hand Posture Recognition Method Based on Depth Image Technoloy CAO Chu-qing, LI Rui-feng, ZHAO Li-jun (State Key Laboratory of Robotics and System, Harbin Institute of Technology, Harbin 150001, China) 【Abstract 】Aiming at the problem of hand posture recognition from complex backgrounds, this paper proposes a hand posture recognition method based on depth image technoloy. The hand posture region is extracted from complex background via depth image. Appearance features are integrated to build the decision tree for hand posture recognition. Nine common postures with complex background are tested. Experimental results demonstrate that recognition rate is 98.4% and speed rate achieves 25 frames per second. 【Key words 】hand posture recognition; depth image; appearance feature; complex background; decision tree DOI: 10.3969/j.issn.1000-3428.2012.08.006 计 算 机 工 程 Computer Engineering 第38卷 第 8期 V ol.38 No.8 2012年4月 April 2012 ·博士论文· 文章编号:1000—3428(2012)08—0016—03文献标识码:A 中图分类号:TP391 1 概述 随着机器人技术的发展,智能服务机器人开始逐步融入人类的生活,人机交互技术的发展是智能服务机器人研究的重要组成部分。人机交互的研究方向主要有表情、声音和手势识别技术。其中,手势是一种自然直观的人机交流模式,在信息表达上比表情更明确、信息量更丰富。 在人机交互中,基于视觉的手势识别是实现新一代人机交互的关键技术。基于视觉的手势识别通过图像信息,让机器人获取人的手势姿态信息,对不同的手势信息进行分类。近年来,学者们对基于视觉的手势识别进行研究,文献[1]提出特征空间匹配法,文献[2]采用提取同类手势的SIFT 特征方法进行手势识别,文献[3]提出手势图解析分类法,文献[4]针对复杂背景采用空间分布特征对手势进行识别。 复杂背景下手势识别的研究[4-5]一般使用肤色模型实现手势区域分割,虽然可以区分肤色和非肤色区域,但是实际应用中图像都包含有肢体和面部肤色区域,它们对手势区域提取有着较大的影响,同时光线也直接影响肤色模型。现有的文献中并没有考虑强光和弱光环境下的手势识别情况,在实际应用中往往伴随光线的变化问题,这些问题都直接影响了人机交互的实际效果。本文提出一种基于深度图像技术的手势识别方法,从深度图像信息中提取手势区域,运用几何方法提取手势表观特征并分类,从而实现复杂环境下基于手势的人机交互。 2 2.1 手势识别系统 基于深度图像信息的手势识别系统框架如图1所示。深度图像的采集采用非接触测量方式,获取的场景中深度信息不受物体自身的颜色、纹理特征以及背景环境光线强弱的影响。本文选用微软公司的Kinect 进行深度图像的采集,获取 深度信息值,转换到灰度值图像,经过手势区域分割、特征提取、手势识别,转换为手势信息,提供人机交互使用。 图1 面向人机交互的手势识别框架 2.2 手势区域分割 2.2.1 深度图像成像原理 深度图像技术在近年来逐步得到广泛的关注,Kinect 采集640×480像素的深度图像速度可以达到30 f/s ,深度的分辨率在5 mm 左右。本文把Kinect 采集到的场景深度值转换到灰度值空间,实际场景的RGB 图像如图2所示。在深度图像中像素点灰度值的大小对应于场景中点的不同深度值,如图3所示,图像中的灰度值越大,表明该区域距离深度摄像头的距离越近。 图2 场景RGB 图像 图3 深度图像 基金项目:国家自然科学基金资助项目(61075081);机器人技术与 系统国家重点实验室课题基金资助项目(SKLRS200802A02) 作者简介:曹雏清(1982-),男,博士研究生,主研方向:模式识 别,人机交互;李瑞峰,教授、博士生导师;赵立军,讲师 收稿日期:2011-07-11 E-mail :caochuqing@https://www.doczj.com/doc/4c8622888.html,

3.2 深度图像二值化 图像二值化是图像处理中的一项基本技术,也是很多图像处理技术的预处理过程。在颗粒分析、模式识别技术、光学字符识别(OCR)、医学数据可视化中的切片配准等应用中,图像二值化是它们进行数据预处理的重要技术。由于图像二值化过程将会损失原图像的许多有用信息,因此在进行二值化预处理过程中,能否保留原图的主要特征非常关键。在不同的应用中,图像二值化时阈值的选择是不同的。因此,自适应图像阈值的选取方法非常值得研究。研究者对图像二值化方法进行了讨论,在此基础上提出了一个新的图像二值化算法。该算法基于数学形态学理论,较好地保留了图像二值化时原图的边缘特征。本文主要研究二值化及灰度图像二值化方法。 3.2.1.灰度图像与二值图像 数字图像是将连续的模拟图像经过离散化处理后得到的计算机能够辨识的点阵 图像。在严格意义上讲,数字图像是经过等距离矩形网格采样,对幅度进行等间隔量化的二维函数。因此,数字图像实际上就是被量化的二维采样数组。一幅数字图像都是由若干个数据点组成的,每个数据点称为像素(pixel)。比如一幅 256×400,就是指该图像是由水平方向上256列像素和垂直方向上400行像素组成的矩形图。每一个像素具有自己的属性,如颜色(color)、灰度(grayscale)等,颜 色和灰度是决定一幅图像表现里的关键因素。数字图像又可分为彩色图像、灰度图像、二值图像。 3.2.1.1彩色图像 彩色图像是多光谱图像的一种特殊情况,对应于人类视觉的三基色即红(R)、绿(G)、蓝(B)三个波段,是对人眼的光谱量化性质的近似。彩色图像中的 每个像素的颜色有R、G、B三个分量决定,而每个分量有255种值可取,这样一个像素点可以有1600多万的颜色的变化范围。而灰度图像是R、G、B三个分量相同的一种特殊的彩色图像,一个像素点的变化范围为255种。图1-1为彩色图像。

龙源期刊网 https://www.doczj.com/doc/4c8622888.html, 基于深度图像技术的手势识别方法 作者:付学娜 来源:《电子技术与软件工程》2015年第04期 所谓手势是指人手或手臂同人手结合而产生的动作或姿势,作为人机交互的一项重要技术,手势识别通过在人手安置相关的硬件设备,并通过硬件设备中的计算模块对人手的位置和速度等信息进行获取,对于识别过程中的定位和跟踪均都具有良好的指导和保障作用。本文通过对手势识别系统与深度图像的成像原理进行阐述,进而结合手势区域分割的相关理论,对基于深度图像技术的手势识别方法展开了深入研究。 【关键词】深度图像技术手势识别圆形轨迹像素值变化点 随着科技的不断发展,基于视觉的手势识别已成为新一代人机交互中的核心技术。在借助相关图像信息的基础上,计算机可以对人手的各种姿态信息以及不同的手势信息尽心准确识别,有效提高了识别的速度与质量。本文以基于深度图像技术的手势识别作为研究对象,通过对手势识别系统及深度图像成像原理进行分析,从手势区域分割以及手势特征提取两方面出发,对深度图像技术下手势识别的方法做出了详细分析。 1 手势识别系统与深度图像成像原理 基于深度图像技术的手势识别系统主要包括了手势、深度图像、手势区域分割、手势特征提取以及手势识别和人机交互等,深度图像以非接触测量的方式对场景中的深度信息进行采集,而所采集的深度信息具有较强的稳定性和可靠性,即不受物体(人手)自身颜色、背景环境和纹理特征等因素的影响。本文以微软的Kinect作为图像采集和获取深度信息的工具,进而对手势识别展开分析。 基于Kinect下的深度图像技术下所采集的640×480深度图像信息的速度可达30f/s,且信息的分辨率维持在5mm左右,在应用方面具有较强的合理性。通过在相关场景采集的场景深度值进行转换,使其转移到灰度值空间,并使深度图像中所有的像素点灰度值大小与实际场景中不同的深度值相对应,进而显示成像。值得注意的是品拍摄区域与深度摄像头之间的距离与图像中的灰度值呈现出明显的负相关关系,即灰度值越大,距离越近。 2 基于深度图像技术的手势识别 2.1 手势区域分割 虽然具有相同深度的像素点,其在深度图像中所具有的灰度值也具有较高的一致性,但由于在每次对人手手势进行拍摄时,人手同深度摄像头间的距离存在差异。因此,无法利用单一的固定阈值对手势区域进行分割,故本文以灰度值直方图作为主要研究方法,进而确定出相关背景及手势区域分割的阈值。由于人手做出相关姿势的区域距离深度摄像头较近,且相对于整

? 25 ? ELECTRONICS WORLD?探索与观察 利用深度学习进行场景分类 浙江省杭州学军中学 赵熠杰【摘要】近些年来,随着社交网络的发展,互联网中的图像数据也越来越多。使用机器学习以及深度学习进行场景分类取得了一系列的进展,同时大量的场景分类的数据集公开出来,为我们提供了非常多的训练样本。本文使用aichallenger竞赛场景分类的数据集,使用迁移学习以及深度学习的方法构建模型,对场景图片进行了比较精确的分类。 【关键词】场景分类;深度学习 1.概述 1.1 研究背景与意义 随着网络的普及以及信息社会的发展,我们在日常生活中接触到的图像数据也越来越多,尤其是最近几年社交网络的普及,像是facebook,微信,微博等社交网络,人们可以随时随地上传自己的图片或者视频,一方面对于图像的存储以及管理带来了很大的困难,另一方面来说如何去挖掘图像中存储的信息也变得越来越重要。这些图像信息不仅可以让我们获得一些人们的想法,还可以快速的提高效率。 场景分类是一个比较基础性的工作,它的应用非常的广泛,不仅可以应用的安防领域,让我们的生活变得更加安全,还可以应用到自动驾驶领域,提高自动驾驶的安全性。同时场景分类在各大社交网络中的应用也非常多,丰富了我们的生活。但是如何让计算机像人类一样对一个场景进行精确的分类也是一项非常具有挑战性的工作。因此,场景分类是一个具有研究前景的领域。 1.2 研究现状 计算机视觉一直以来都是人工智能的研究热点,所以也涌现了非常多的优秀的算法。主要分为两类,一类是传统的根据特征进行建模然后使用机器学习的算法进行分类,常见的特征提取算法包括统计直方图,色彩直方图,LBP以及SIFT特征等。使用的机器学习算法如随机森林,建立多颗决策树,并根据多棵决策树的结果进行多数投票,另外一种是支持向量机,这也是在深度学习大规模应用之前效果最好的一种算法,是一种根据支持向量确定决策边界的方法。 另外一类是基于深度学习的算法,Krizhevsky在2012年提出了基于深度学习的图像分类算法,使用了一个8层的神经网络结构,夺得了ImageNet2012年图像分类的冠军。随后Christian Szegedy提出了GoogleNet,使用了22层的神经网络获得了ImageNet2014年图像分类的冠军。随后Karen Simonyan等人提出了一个19层的VGG网络,在图像分类领域获得了更好的结果。 2.场景分类 2.1 什么是场景分类 场景分类是根据训练数据集中的数据的特征,给每一类确定一种准确地描述方式,由这些特征生成类描述或模型,并运用这种描述方式对新的数据集进行分类。场景分类是指针对原始的图片数据,对数据进行过滤、提取特征等操作,然后根据场景图像特征进行分类。 2.2 数据集介绍 本文中所使用的数据集为aichallenger中场景分类的数据集,比赛从400万张图片中选出了8万张比较好的图片,分别属于80个不同的场景,比如足球场,滑雪场,卧室等。从中选出70%作为训练集,10%作为交叉验证集,20%作为测试集,其中每张图片的大小是不相同的。 2.3 场景分类的步骤 首先是图像的预处理,本步骤主要将图片做一些简单的处理。由于每张图片的大小都是各不相同的,深度学习算法通常需要固定大小的输入,因此我们需要将每张图片的大小处理成固定的大小,如果直接对图像做缩放的话可能会造成比较大的失真,实验验证也是如此的。因此,在图像的处理中本文首先将图像进行小幅度的缩放,然后从缩放后的图片中裁剪出224*224大小的图片。后续将图片存储为numpy支持的数组即可。 第二步是数据增强。在后续的实验中本文发现,现有的数据数量还是比较的少,因此有必要进行进一步的数据增强,在增加数据增强后的网络中,top3的准确率可以提高大约10%。本文所使用的数据增强方法主要包括如下:将输入数据归一化到-1,到1之间;将输入的图片进行一定幅度的旋转,本文中旋转角度为15度;每一张图片的宽度上进行随机的水平平移,本文中平移整张图片的1%;每一张图片在高度上进行随机的水平平移,本文中同样偏移整张图片的1%;对图片以一定的概率进行随机的水平翻转,在竖直方向上不做任何的翻转。 第三步模型构建。此步骤主要是选择或者设计深度学习使用的模型,同时由于本文使用的数据集中图片的数量比较少,只有8万张图片,比较深的网络可能会过拟合。因此,本文使用了迁移学习的方法,使用了部分在ImageNet中训练好的参数初始化网络,部分模型没有使用做对比实验。详细的内容将在第三部分进行介绍。 第四步是使用第三步训练好的网络以及参数进行预测。在这一部分同样需要对数据进行预处理,预处理的过程同训练过程的预处理相同,但是这一步不进行数据的增强。 3.场景分类的方法 在对场景分类模型的构建的时候,本文选择使用ResNet以及InceptionV3的网络结构对场景进行分类,并对部分地方进行改进实验。同时,为了增强模型的泛化能力,避免在小数据上造成过拟合的现象,因此本文使用了迁移学习的方法,使用了在ImageNet中训练好的ResNet以及InceptionV3的参数对网络进行初始化。另外在进

数字图像处理实验报告 实验二灰度变换 实验目的:通过实验掌握灰度变换的基本概念和方法 实验内容: 掌握基本的灰度变换:图像反转、对数变换、幂次变换和二值化1.图像反转、对数变换、幂次变换 I=imread('fengjing.jpg'); J=im2double(I); subplot(2,3,1),imshow(J); title('原图'); K=255-I; subplot(2,3,2),imshow(K); title('图象反转'); L=3.*log(1+J); subplot(2,3,3),imshow(L);title('图象对数,系数为3'); M=10.*log(1+J); subplot(2,3,4),imshow(M);title('图象对数,系数为10'); N=10.*(J.^0.2); subplot(2,3,5),imshow(N);title('图象指数变换,γ=0.2'); P=10.*(J.^2.5); subplot(2,3,6),imshow(P);title('图象指数变换,γ=2.5'); 2.图象二值化 方法一:

I=imread('fengjing.jpg'); % 确定大小subplot(1,2,1),imshow(I);title('原图象'); [m,n]=size(I); for i=1:m for j=1:n if I(i,j)<128 I(i,j)=0; else I(i,j)>=128 & I(i,j)<256 I(i,j)=255; end end end subplot(1,2,2),imshow(I);title('图象二值化');方法二: I=imread('fengjing.jpg'); % 确定大小subplot(1,2,1),imshow(I);title('原图象'); J=find(I<128); I(J)=0; J=find(I>=128); I(J)=255; title('图像二值化(阈值为128)'); subplot(1,2,2),imshow(I);title('图象二值化');

图像深度与颜色类型 2011-09-07 17:06:44| 分类:图像处理| 标签:|举报|字号大中小订阅四.图像深度与颜色类型< XMLNAMESPACE PREFIX ="O" /> 图像深度是指位图中记录每个像素点所占的位数,它决定了彩色图像中可出现的最多颜色数,或者灰度图像中的最大灰度等级数。图像的颜色需用三维空间来表示,如RGB颜色空间,而颜色的空间表示法又不是惟一的,所以每个像素点的图像深度的分配还与图像所用的颜色空间有关。以最常用的RGB颜色空间为例,图像深度与颜色的映射关系主要有真彩色、伪彩色和直接色。 (一)真彩色(true-color):真彩色是指图像中的每个像素值都分成R、G、B三个基色分量,每个基色分量直接决定其基色的强度,这样产生的颜色称为真彩色。例如图像深度为24,用R:G:B=8:8:8来表示颜色,则R、G、B各用8位来表示各自基色分量的强度,每个基色分量的强度等级为28=256种。图像可容纳224=16M 种颜色。这样得到的颜色可以反映原图的真实颜色,故称真彩色。 (二)伪彩色(pseudo-color):伪彩色图像的每个像素值实际上是一个索引值或代码,该代码值作为颜色查找表(CLUT,Color Look-Up Table)中某一项的入口地址,根据该地址可查找出包含实际R、G、B的强度值。这种用查找映射的方法产生的颜色称为伪彩色。用这种方式产生的颜色本身是真的,不过它不一定反映原图的颜色。在VGA显示系统中,调色板就相当于颜色查找表。从16色标准VGA调色板的定义可以看出这种伪彩色的工作方式(表06-03-2)。调色板的代码对应RGB颜色的入口地址,颜色即调色板中RGB混合后对应的颜色。 表06-03-216色标准VGA调色板

基于深度学习的图像深度估计及其应用研究场景深度估计是计算机视觉领域的一项重要课题。利用图像的深度信息,可以重构场景的三维结构信息,对机器人自主导航、物体识别与抓取等任务具有重要意义。 传统的视觉深度估计方法多利用场景的多视信息,通过三角几何对应关系从二维图像中恢复场景深度,计算量大且复杂。近年,随着深度学习的发展,利用卷积神经网络重构场景深度成为研究者关注的热点方向。 卷积神经网络可以利用图像数据及其配套的基准深度数据预先训练学习,在测试阶段可以实现端到端的全分辨率图像深度估计。该方法不仅速度快,实现简单,而且可实现场景的尺度恢复,有益于机器人的空间任务执行。 在此背景下,本文在深入研究近年基于卷积神经网络的深度估计方法基础上,提出创新性的端到端深度学习网络,实验证明所提方法可进一步提升算法性能。本文首先提出了一种端到端的学习方案,用于从稀疏深度图和RGB图像中预测尺度化的稠密深度图。 该方案中,首先利用稀疏采样生成稀疏深度图,然后将彩色图像和稀疏深度图作为网络输入,输出全分辨率深度图像。在训练过程中,稀疏深度图作为深度估计网络的监督信号来恢复场景的真实尺度。 为了更精确的估计场景深度,本文引入“correlation”层,人工模拟标准匹配过程来融合稀疏深度信息和彩色图像信息,即使用颜色信息来帮助提高基于稀疏深度图的预测精度。最后,利用精细化模块以全分辨率输出场景深度图像。 在NYU-Depth-V2和KITTI数据集上的实验结果表明,与前沿算法相比,该模型能够以全分辨率恢复尺度化的场景深度,具有更优的性能。本文提出了并行构

建的深度估计网络和相机位姿估计网络。 相机位姿估计网络以单目视频序列为输入,输出六自由度的相机相对位姿。深度估计网络以单目目标视图为输入,生成稠密的场景深度。 最后基于相机模型,生成合成视图,并把它作为监督信号联合训练两个并行的估计网络。与此同时,稀疏采样生成的稀疏深度图作为深度估计网络的另一个监督信号,帮助恢复其全局尺度。 深度估计网络获得的尺度信息又通过合成视图与目标视图的光度误差耦合传递给位姿估计网络。在测试阶段,深度估计器和位姿估计器可以分别独立的使用。 在KITTI数据集上对本文算法进行了实验评估,所提算法在多个指标上优于前沿算法。

单目视觉图像深度测量方法研究 相机与其它传感器相比,具有能够直观反映客观世界、数据量大、信息丰富等特点,而且通常价格较低、配置方便,是自动化装置和机器人感知环境传感器中的优先选择之一。但由于普通相机在拍摄时获得的是被拍摄场景投影到成像平面上的二维图像,丢失了场景的深度信息,这使得机器无法通过图像直接得到场景中物体的远近、大小和运动速度等信息,因此需要从二维图像中恢复深度信息,即深度测量。深度测量在工业自动化、智能机器人、目标检测和跟踪、智能交通、三维建模和3D视频制作等领域都有广泛的应用。深度测量方法有很多种,其中基于单目视觉的图像深度测量方法具有设备简单、成本低廉、操作方便等特点而成为研究热点,并且单目相机体积小,重量轻,在一些有空间大小或载荷限制的特定场合以及手眼系统等应用中,需要或只能使用基于单目视觉的图像深度测量方法,而目前该测量方法还很不成熟,有必要对其计算原理、技术方法等方面进行研究。 因此本文对基于单目视觉的图像深度测量方法开展研究,主要工作和创新点如下:(1)提出一种基于熵和加权Hu氏不变矩的目标物体绝对深度的测量方法。该方法用普通单目相机拍摄同一场景的两幅图像,拍摄时保持相机的参数不变,将相机沿光轴方向移动,分别在物距间隔为d的前后两处各拍摄一幅图像,然后采用LBF模型的方法分割出图像中的物体,并求出各个目标物体像的面积,再将物体像的熵的相对变化率和加权Hu氏不变矩结合起来实现图像内物体的自动匹配,最后运用本文推导的公式计算出各个目标物体的绝对深度。文中采用真实场景图像对该方法进行了实验验证并与其他方法进行了对比,结果表明了该方法的有效性。(2)提出一种基于SIFT特征的目标物体绝对深度的测量方法,该方法同样需要按照上面的方法获取同一场景的两幅图像,然后分别对这两幅图像进行图像分割和SIFT特征点提取,并进行图像中的目标物体匹配,接着用凸包和几何形状约束从匹配物体中选出一对最佳直线段,最后根据光学成像原理利用直线段长度计算出场景中静态目标物体的绝对深度信息。 由于是通过被测量物体上的两个SIFT特征点所成的直线段长度来计算出物体的绝对深度信息的,所以该方法鲁棒性较好,不受场景中被测量目标物体部分遮挡或缺失的限制,对比实验表明该方法测量精度高于现有其他方法。(3)提出一种基于梯度信息和小波分析的单幅图像相对深度测量方法。该方法首先利用图像

图像二值化算法研究与实现 摘要:图像二值化是图像预处理中的一项重要技术,在模式识别、光学字符识别、医学成像等方面都有重要应用。论文介绍了图像及数字图像处理技术的一些概念和相关知识;对VC++ 软件的发展和软件在图像处理中的应用做了简要介绍;还介绍了图像二值化算法以及利用VC++软件工具进行算法的实现。论文重点实现了图像分割技术中常用灰度图像二值化算法,如Otsu算法、Bernsen算法,并对这些算法运行的实验结果进行分析与比较。 关键词:图像处理;二值化;VC++; 1.引言 1.1 图像与数字图像 图像就是用各种观测系统观测客观世界获得的且可以直接或间接作用与人眼而产生视觉的实体。视觉是人类从大自然中获取信息的最主要的手段。拒统计,在人类获取的信息中,视觉信息约占60%,听觉信息约占20%,其他方式加起来才约占20%。由此可见,视觉信息对人类非常重要。同时,图像又是人类获取视觉信息的主要途径,是人类能体验的最重要、最丰富、信息量最大的信息源。通常,客观事物在空间上都是三维的(3D)的,但是从客观景物获得的图像却是属于二维(2D)平面的。 数字图像:数字图像是将连续的模拟图像经过离散化处理后得到的计算机能够辨识的点阵图像。在严格意义上讲,数字图像是经过等距离矩形网格采样,对幅度进行等间隔量化的二维函数。因此,数字图像实际上就是被量化的二维采样数组。 1.2 数字图像处理技术内容与发展现状 数字图像处理就是采用一定的算法对数字图像进行处理,以获得人眼视觉或者某种接受系统所需要的图像处理过程。图像处理的基础是数字,主要任务是进行各种算法设计和算法实现。 图像处理技术的发展大致经历了初创期、发展期、普及期和实用化期4个阶段。初创期开始与20世纪60年代,当时的图像采用像素型光栅进行少秒显示,大多采用中、大型机对其处理。在这一时期,由于图像存储成本高、处理设备昂贵,其应用面很窄。进入20世纪70年代的发展期,开始大量采用中、小型机进行处理,图像处理也逐渐改用光栅扫描方式,特别是CT和卫星遥感图像的出现,对图像处理技术的发展起到了很好的推动作用。到了20世纪80年代,图像处理技术进入普及期,此时的微机已经能够担当起图形图像处理的任务。超大规模集成电路(Very Large Scale Integration, VLSI)的出现更使处理速度大大提高,设备造价也进一步降低,极大地促进了图形图像系统的普及和应用。20世纪90年代是图像处理技术的实用化时期,图像处理的信息量巨大,对处理速度的要求极高。 1.3 图像二值化原理及意义 图像二值化是指用灰度变换来研究灰度图像的一种常用方法,即设定某一阈值将灰度

目录 摘要 ................................................................. III Abstract............................................................... IV 第一章绪论. (1) 1.1 图像与数字图像 (1) 1.2 数字图像处理技术内容与发展现状 (2) 1.3 灰度图像二值化原理及意义 (4) 第二章软件工具——MATLAB (6) 2.1 MATLAB概述 (6) 2.2 MATLAB的工作环境 (6) 2.3 MATLAB图像处理工具箱 (8) 2.4 工具箱实现的常用功能 (9) 第三章图像二值化方法 (11) 3.1 课题研究对象 (11) 3.2 二值化方法研究动态 (13) 3.3 全局阈值法 (18) 3.4 局部阈值法 (18) 第四章 Otsu方法和Bernsen方法 (20) 4.1 Otsu算法分析 (20) 4.2 Otsu方法流程图 (22) 4.3 Bernsen算法分析 (23) 4.4 Bernsen方法流程图 (23) 第五章 Otsu方法和Bernsen方法实验比较 (25) 5.1 Otsu方法实验结果分析 (25)

5.2 Bernsen方法结果分析 (27) 5.3 0tsu方法和Bernsen方法实验结果比较 (28) 5.4 结论 (29) 结束语 (31) 参考文献 (32) 致谢 (33) 附录:源代码 (34)

摘要 在人类获取的信息中,视觉信息约占60%,听觉约占20%,其它约占20%。由此可见,视觉信息对人类非常重要。同时,图像是人类获取视觉信息的主要途径。图像二值化是图像预处理中的一项重要技术,在模式识别、光学字符识别、医学成像等方面都有重要应用。论文介绍了图像及数字图像处理技术的一些概念和相关知识;对Matlab7.0 软件的发展和软件在图像处理中的应用做了简要介绍;还介绍了灰度图像二值化方法以及利用Matlab7.0软件工具进行算法的实现。课题重点实现了图像分割技术中灰度图像二值化方法,如Otsu算法、Bernsen算法,并对这些算法运行的实验结果进行分析与比较。 关键词:图像处理,二值化,Matlab,Otsu算法,Bernsen算法

2017年11月计算机工程与设计 Nov. 2017 第38 卷第11 期COMPUTER ENGINEERING AND DESIGN Vol. 38 No. 11基于多特征融合和深度学习的商品图像分类 曾志、吴财贵、唐权华、余嘉禾、李雅晴、高健2 (1.江西师范大学软件学院,江西南昌330022; 2.江西财经大学信息管理学院,江西南昌330013) 摘要:针对现有单一特征描述及浅层结构分类算法分类精度不高等问题,提出一种基于图像内容特征的深度置信网络 (D B N)商品图像分类算法。对于从图像中提取到的颜色、纹理和形状等特征进行融合,构建5层D B N分类器对所得的特 征数据进行学习训练和分类。采用京东商城提供的商品图像库,通过训练权重进行测试,测试结果表明,该算法在时效性 和精确度方面优于使用单一特征的分类算法以及其它主流分类算法。 关键词:多特征融合;深度学习;深度置信网络;商品图像分类;图像处理 中图法分类号:TP391 文献标识号:A文章编号:1000-7024 (2017) 11-3093-06 doi:10. 16208/j. is s n l000-7024. 2017. 11. 036 Classification of commodity image based on multi-feature fusion and depth learning Z E N G Z h i1,W U C a i-g u i1,T A N G Q u a n-h u a1,Y U Jia-he1,L I Y a-q i n g1,G A O Jian2 (1. School o f S o ftw a re, Jiangxi N o rm a l U n iv e rs ity, N anchang 330022,C h in a; 2. College o f In fo rm a tio n M anagem ent, Jiangxi U n iv e rs ity o f Finance and Econom ics, N anchang 330013,China) Abstract:T a k in g the single feature and the m ajor classification algorithm s in to consideration, an image classification a lg o rith m based on fusion o f m u lti-fe a tu re fo r deep belief n e tw o rk(D B N) was proposed to classify the product images. T h e m u lti-fe a tu re a lg o rith m was used to fuse the features o f image co lo r, te xtu re and shape. T h e samples were trained and classified using the constructed D B N w ith five levels. T he proposed m ethod was evaluated on the product image data set b y tra in w e ig h t provided by Jingdong M a ll. T h e results show th a t the proposed a lg o rith m is b e tter than single feature a lg o rith m and other m ainstream algo-rith m s in term s o f accuracy and tim eliness. Key words:m u lti-fe a tu re fu s io n;deep le a rn in g;deep belief n e tw o rk;com m odity image classification;image processing 〇引言 一直以来,图像分类的主要难点包括图像特征的选取 和分类器的选取。传统地来说,图像分类算法大致归为两 大种类,一是通过使用人工标记进行分类,二是使用关键 字、文本对图像进行描述并进行分类的算法。这些方法简 单且易于理解,但存在费时费力,且受主观影响,分类不 准确等缺点。后有人提出了基于图像内容的分类方法,避 免了主观影响,实现了智能化管理。现如今,基于底层视 觉特征的图像分类方法是提取图像特征较为普遍的方法之一,作用在对图像进行分类时,该方法无论是在准确度或 是时间复杂度上都展现了它的优越性。然而,其单一特征 描述及浅层结构分类算法分类仍然存在分类精度不高等缺陷。 基于以上问题,本文提出使用多特征融合和深度学习 相结合的图像分类方法,旨在提高分类精度,获得一个更 高效的分类方法。多特征融合算法实际上是先对图像内容 进行特征提取,本文主要提取的是颜色、纹理和形状这3种基本特征,然后将这些特征进行融合;再把融合后的 数据信息输人到深度置信网络中;最后将所得到的特征数 收稿日期:2016-09-13;修订日期:2016-09-15 基金项目:国家自然科学基金项目(61262037);江西省教育科学技术基金项目(GJJ13232) 作者简介:曾志(1992-),女,江西赣州人,硕士研究生,研究方向为数据挖掘、图像信息处理;吴财贵(1991-),男,江西上饶人,硕 士研究生,研究方向为数据挖掘、图像信息处理;唐权华(1976-),男,四川遂宁人,博士,讲师,研究方向为图像信息处理、人工智能 等;余嘉禾(1994-),女,江西宜春人,硕士研究生,研究方向为数据挖掘、图像信息处理;李雅晴(1992-),女,江西上饶人,硕士研 究生,研究方向为数据挖掘;高健(1986 -),男,福建厦门人,硕士研究生,研究方向为信息管理。E-mail: 1034265206@https://www.doczj.com/doc/4c8622888.html,